如何准备数据集以适应LDA主题分析

发布时间: 2024-04-17 05:11:29 阅读量: 122 订阅数: 51

# 1. 数据集准备概述

1.1 确定研究目的

在进行LDA主题分析前,首先要明确研究目的,确定想要通过主题分析达到的效果和目标,这有助于指导后续的数据准备和模型构建过程。

1.2 获取原始数据集

1.2.1 数据源选择

选择适合主题分析的数据源,可以是文本数据、图像数据等。

1.2.2 数据集收集方法

根据研究目的选择合适的渠道收集数据,确保数据质量和完整性。

1.3 数据预处理

1.3.1 数据清洗

对原始数据进行去噪、去重等清洗操作,保证数据的准确性。

1.3.2 数据格式转换

将数据转换成模型可接受的格式,比如将文本数据转换为向量表示。

1.3.3 缺失值处理

处理数据集中可能存在的缺失值,可以填充、删除或插值等方式进行处理。

# 2. 数据探索与分析

2.1 数据可视化分析

2.1.1 直方图分布

数据可视化是了解数据分布的重要手段之一,直方图可以清晰展示变量的分布情况。通过绘制直方图,可以直观地看出数据的集中程度、偏移程度以及异常值情况。

```python

import matplotlib.pyplot as plt

# 绘制直方图

plt.hist(data['column_name'], bins=10, color='skyblue', edgecolor='black')

plt.xlabel('Variable')

plt.ylabel('Frequency')

plt.title('Histogram of Variable Distribution')

plt.show()

```

2.1.2 散点图矩阵

散点图矩阵可以展示多个变量之间的关系,有助于发现变量之间的相关性和趋势。通过观察散点图矩阵,可以快速了解各个变量之间的分布情况。

```python

import seaborn as sns

# 绘制散点图矩阵

sns.pairplot(data)

plt.show()

```

2.1.3 箱线图比较

箱线图是一种有效的比较方法,可以展示不同类别变量之间的差异。通过箱线图比较,可以直观地看出各个类别内数据分布的差异情况。

```python

# 绘制箱线图

sns.boxplot(x='category_column', y='numeric_column', data=data)

plt.xlabel('Category')

plt.ylabel('Numeric Variable')

plt.title('Boxplot Comparison')

plt.show()

```

2.2 数据统计描述

2.2.1 均值、中位数、方差等

均值、中位数和方差是描述数据集中趋势和离散程度的常用统计量。通过计算这些统计量,可以更好地理解数据的分布特征。

```python

# 计算均值

mean_value = data['column_name'].mean()

# 计算中位数

median_value = data['column_name'].median()

# 计算方差

variance_value = data['column_name'].var()

print(f"Mean: {mean_value}, Median: {median_value}, Variance: {variance_value}")

```

2.2.2 相关性分析

相关性分析可以帮助我们揭示变量之间的线性关系强弱,可以利用相关系数来衡量变量之间的相关程度。通过分析相关性,可以帮助我们理解变量之间的相互影响。

```python

# 计算相关系数

correlation_matrix = data.corr()

# 绘制热力图

sns.heatmap(correlation_matrix, annot=True, cmap='coolwarm', fmt='.2f')

plt.title('Correlation Matrix')

plt.show()

```

2.2.3 分类变量分布

对于分类变量,我们可以通过计算各个类别的频数和频率来了解其分布情况。这有助于我们对不同类别进行比较和分析。

```python

# 计算分类变量频数

frequency_table = data['category_column'].value_counts()

# 计算分类变量频率

frequency_percentage = data['category_column'].value_counts(normalize=True) * 100

print(frequency_table)

print(frequency_percentage)

```

通过数据可视化分析和数据统计描述,可以更深入地了解数据的特征分布和变量之间的关系,为特征工程和模型构建提供有力支持。

# 3. 特征工程和选择

3.1 特征抽取

特征抽取是将数据转化为能够被机器学习算法理解的形式的过程。在文本挖掘中,常用的特征抽取方法包括词袋模型(Bag of Words)和词袋模型加权(TF-IDF)。通过将文本进行分词处理,然后统计每个词出现的次数来表示文本数据。在图像处理中,常用的特征抽取方法有颜色直方图、局部二值模式(LBP)等。

```python

# 示例代码:使用TF-IDF对文本进行特征抽取

from sklearn.feature_extraction.text import TfidfVectorizer

# 创建TF-IDF对象

tfidf_vectorizer = TfidfVectorizer()

# 对文本数据进行特征抽取

tfidf_matrix = tfidf_vectorizer.fit_transform(text_data)

```

3.2 数据规范化

数据规范化是将特征进行预处理,以确保特征之间具有相同的重要性。特征缩放是指将特征的范围缩放到一致的范围,常用的方法包括最小-最大缩放和标准化。归一化处理是将特征缩放到0和1之间,而标准化处理是通过减去均值再除以标准差来实现。

```python

# 示例代码:使用MinMaxScaler进行特征缩放

from sklearn.preprocessing import MinMaxScaler

# 创建MinMaxScaler对象

scaler = MinMaxScaler()

# 对数据进行特征缩放

scaled_data = scaler.fit_transform(data)

```

3.3 特征选择

特征选择是从原始特征中选择最具代表性的特征,以提高模型的性能和泛化能力。过滤式选择是通过对特征进行评估来选择特征,如方差选择法。包裹式选择通过训练模型并根据模型性能来选择特征,如递归特征消除法。嵌入式选择则是利用模型的内在属性来选择特征,如LASSO回归。

```python

# 示例代码:使用递归特征消除法进行特征选择

from sklearn.feature_selection import RFE

from sklearn.linear_model import LogisticRegression

# 创建递归特征消除对象

estimator = LogisticRegression()

rfe = RFE(estimator, n_features_to_select=5, step=1)

# 对数据进行特征选择

selected_features = rfe.fit_transform(data, target)

```

通过特征工程的处理,可以有效地提取数据中的有效信息,规范化特征以及选择最具代表性的特征,为后续的模型构建和分析奠定良好的基础。

# 4. 模型构建与应用

4.1 LDA主题模型介绍

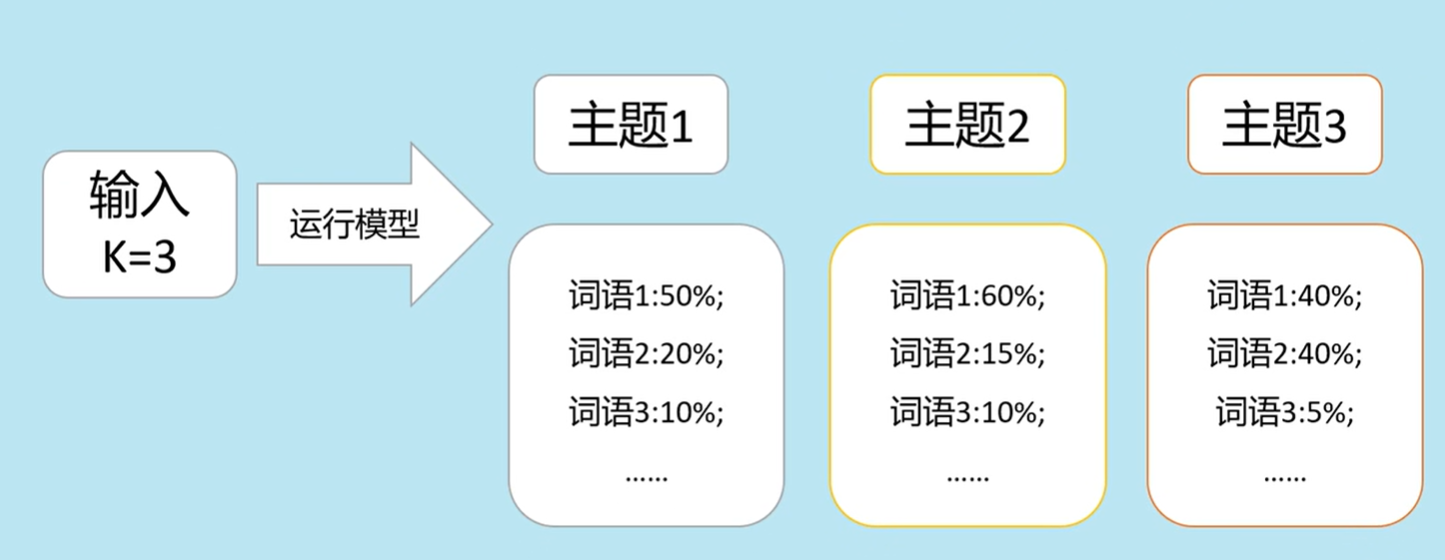

Latent Dirichlet Allocation (LDA) 主题模型是一种文本分析技术,用于发现文本集合中隐藏的主题结构。它基于贝叶斯概率模型,将文本数据转换为主题-词分布和文档-主题分布。通过LDA模型,我们可以探索文本数据中的潜在主题,从而提取出其中隐藏的信息。

4.1.1 模型原理解析

LDA假设每篇文档是由若干个主题混合而成的,而每个主题又是由若干个词语组成的。在推断过程中,LDA试图找到最合适的主题以解释每个词语在文档中的存在概率。通过不断迭代寻找最优主题,最终得到文档-主题和主题-词的分布。

4.1.2 模型参数调优

在实际应用中,我们需要对LDA模型进行参数调优以获取更好的主题结果。常见的参数包括主题数、迭代次数和α、β两个超参数。通过调整这些参数,可以影响到LDA模型的表现和结果。

```python

# 示例:LDA模型参数调优

from gensim import models

num_topics = 5

passes = 10

lda_model = models.LdaModel(corpus, num_topics=num_topics, id2word=dictionary, passes=passes)

```

4.2 模型训练

在模型训练阶段,我们需要将数据集拆分为训练集和测试集,并搭建LDA模型进行训练。训练过程中,LDA模型会不断优化主题分布,直到收敛于最优解。

4.2.1 数据集拆分

为了避免过拟合,我们通常将数据集按照一定的比例分为训练集和测试集,其中训练集用于模型参数学习,测试集用于模型评估。

```python

# 示例:数据集拆分

from sklearn.model_selection import train_test_split

X_train, X_test = train_test_split(data, test_size=0.2, random_state=42)

```

4.2.2 模型搭建

在搭建LDA模型时,需要先将文本数据转换为词袋模型,再通过LDA算法构建模型。最终我们可以得到每篇文档的主题分布。

```python

# 示例:LDA模型搭建

from gensim import corpora

dictionary = corpora.Dictionary(text_data)

corpus = [dictionary.doc2bow(text) for text in text_data]

```

4.2.3 模型训练

完成数据集拆分和模型搭建后,我们可以开始训练LDA模型。模型会根据训练集中的文本数据学习主题-词分布和文档-主题分布。

```python

# 示例:LDA模型训练

lda_model = models.LdaModel(corpus, num_topics=5, id2word=dictionary, passes=10)

```

4.3 模型评估与优化

在模型训练完成后,我们需要对模型的效果进行评估和优化。主要包括选择合适的主题数量、解释主题词以及调参方法等方面。

4.3.1 主题数量选择

主题数量是LDA模型中一个重要的超参数,选择合适的主题数量能够更好地描述文本数据的结构。通常需要通过模型评估指标或主观判断来确定合适的主题数量。

4.3.2 主题词解释

在得到主题分布后,需要解释每个主题所代表的含义。通过分析每个主题中词语的重要性和相关性,可以给主题赋予一个直观的标签或主题词汇。

4.3.3 模型调参方法

除了主题数量外,LDA模型还有其他一些超参数需要调优,如α和β参数。通过调整这些参数,可以优化LDA模型的表现和结果。

流程图示例:

```mermaid

graph LR

A[数据集准备] --> B(数据清洗)

B --> C(数据格式转换)

C --> D(缺失值处理)

D --> E[数据探索与分析]

E --> F(数据可视化分析)

F --> G(数据统计描述)

G --> H(特征工程和选择)

H --> I(模型构建与应用)

```

通过上述步骤,我们可以完成LDA主题模型的构建和应用,从而揭示文本数据背后的潜在主题结构,为进一步分析和应用提供基础支持。

# 5. 总结与展望

在本文中,我们详细介绍了如何准备数据集以适应LDA主题分析的过程。通过数据集的准备、探索、特征工程和模型构建,我们为读者提供了一套完整的实践指南。接下来,我们对本文的主要内容进行总结,并展望未来的研究方向和发展趋势。

1. **总结本文主要内容:**

- 我们首先确定了研究目的,即通过LDA主题分析来揭示文本数据的潜在主题结构。

- 接着详细介绍了数据集准备的流程,包括数据源选择、数据收集方法以及数据预处理的各个步骤。

- 在数据探索与分析部分,我们运用了数据可视化和统计描述的方法,深入分析了数据的特征和分布。

- 特征工程和选择部分则介绍了特征抽取、数据规范化和特征选择的相关技术和方法。

- 最后,我们构建了LDA主题模型,并对模型进行了训练、评估与优化,为读者展示了完整的建模过程。

2. **展望未来研究方向:**

- **深入探索文本数据的特征工程:** 在特征抽取方面,可以进一步尝试使用深度学习模型提取更高级别的特征表示。

- **模型优化与迁移学习:** 可以通过调整LDA模型的参数,优化主题数量选择,进一步提升模型表现。同时,将迁移学习应用到LDA主题模型中,实现在不同领域的知识迁移。

- **结合多模态数据进行主题分析:** 随着多模态数据处理技术的不断发展,可以尝试将文本、图像、视频等多模态数据结合,进行跨模态的主题分析研究。

3. **结语:**

通过本文的学习,读者应当对如何准备数据集、进行数据探索与分析、进行特征工程和模型构建有了更深入的理解。未来,随着技术的不断进步和数据科学领域的发展,LDA主题分析和相关技术将在自然语言处理、信息检索等领域发挥越来越重要的作用。希望本文所提供的知识能够帮助读者更好地应用于实际项目中,同时也期待读者能够在相关领域的研究中取得更多的成果。

4. **参考文献:**

- Blei, D. M., Ng, A. Y., & Jordan, M. I. (2003). Latent Dirichlet Allocation. Journal of Machine Learning Research, 3, 993-1022.

- Zhao, W. X., & Li, S. (2017). Introduction to Topic Modeling Methods and Tools. Beijing: Science Press.

以上是本文的总结与展望部分内容,希望读者从中获得启发和指导。如果您有任何问题或想法,请随时与我们交流,我们期待与您共同探讨更多关于数据科学和机器学习的话题。感谢您的阅读!

---

通过本文的总结与展望,读者能够更全面地了解LDA主题分析的实践过程以及未来的发展趋势。展望未来,结合深度学习、迁移学习以及多模态数据处理技术,可以进一步推动主题分析方法的发展,并将其应用到更广泛的领域中。希望本文能够为读者在数据科学领域的学习和实践提供帮助,促进相关研究的深入与发展。

0

0