决策树算法的集成学习精华:揭秘提升预测准确度的秘密

发布时间: 2024-09-03 17:39:06 阅读量: 100 订阅数: 51

果壳处理器研究小组(Topic基于RISCV64果核处理器的卷积神经网络加速器研究)详细文档+全部资料+优秀项目+源码.zip

# 1. 集成学习与决策树算法概述

集成学习与决策树算法是数据科学领域的基石,它们在机器学习任务中扮演着至关重要的角色。集成学习通过结合多个学习器来提高整体模型的预测性能,而决策树则是构建这些集成模型的基础组件。本章将为读者概述集成学习和决策树算法的基本概念和它们之间的关系。

## 1.1 集成学习与决策树算法的相互作用

集成学习依赖于决策树算法,通过构建多个决策树并将它们的预测结果进行汇总,以达到增强模型稳定性和准确性的作用。这个过程涉及到算法的选择、模型的组合以及预测结果的集成等步骤。

## 1.2 从单棵决策树到集成模型的进阶

在机器学习的实际应用中,单个决策树易受到数据变化的影响,这使得它们在复杂任务中的表现往往不尽如人意。集成学习的引入通过结合多个决策树,能够有效提升模型的泛化能力,从而在多种场景下都能提供更为可靠的预测结果。

## 1.3 决策树与集成学习在行业中的应用案例

决策树和集成学习的方法在多个行业都得到了广泛应用,从金融市场分析到医疗诊断,再到推荐系统,它们的实用性得到了广泛验证。通过具体案例分析,我们可以更好地理解这些技术的实际应用价值和效果。

# 2. 决策树算法的理论基础

## 2.1 决策树算法的核心概念

### 2.1.1 决策树的定义和构建原理

决策树是一种基本的分类与回归方法,它的模型形式类似于一棵树,其中每个内部节点代表了一个属性上的判断,每个分支代表了一个判断结果的输出,而每个叶节点代表了一个类别或一个数值。

构建决策树时,算法需要根据数据集的特点,选择一个特征,按照这个特征的不同取值将数据集分割成几个子集,使得同质性最高的数据子集在同一个分支下,不同分支下的子集同质性最低。

**构建过程的关键在于如何选择最佳分割属性**,常见的算法有ID3、C4.5、CART等。以下是一个简化的决策树构建流程:

1. 开始于一个节点,包含全部的训练数据。

2. 使用某种策略选择最优特征作为节点的分裂标准。

3. 根据选定的特征对数据集进行分割。

4. 对分割后的每个子集递归执行上述步骤,直到满足停止条件(如节点内所有实例属于同一类别,或没有任何剩余特征等)。

5. 生成叶节点,将其标记为所属类别的决策结果。

6. 清理树结构(例如剪枝),以提高模型的泛化能力。

### 2.1.2 信息增益和基尼不纯度

信息增益和基尼不纯度是决策树构建中常用的度量标准。

- **信息增益**是基于信息论中的熵的概念,用于度量通过学习特征使得样本的纯度增加的程度。

熵是一个衡量数据集混乱程度的指标,在决策树中,熵越大表示数据集分类越混乱。信息增益是当前熵与分割后各子集熵的期望值的差,即增加了多少信息量。

- **基尼不纯度**是另一种衡量数据纯度的方法,用于度量从数据集中随机选取两个样本,其类别标签不一致的概率。

基尼不纯度越小,表示数据集中的数据越趋向于相同,纯度越高。构建决策树时,我们通常会选取使基尼不纯度降低最大的属性作为分裂点。

```mermaid

graph TD;

A[开始构建决策树] --> B[选择最优分割属性];

B --> C[分割数据集];

C --> D[递归构建子树];

D --> E[判断是否满足停止条件];

E --> |是| F[生成叶节点];

E --> |否| B;

F --> G[剪枝优化];

```

## 2.2 决策树的类型和特点

### 2.2.1 CART算法

CART(Classification and Regression Tree)算法是一种二叉树算法,可以用于分类也可以用于回归任务。它的核心思想是通过递归的方式对特征空间进行二分,将数据集分割为若干个子集,直至每个子集仅包含一个类别或满足预设的停止条件。

在CART算法中,构建决策树的关键步骤包括:

- 选择一个特征进行分割,确定分割点。

- 该特征可以是连续的或离散的。

- 分割时会对每个特征进行考虑,选择最佳的分割点。

CART算法使用的分割标准是基尼不纯度。

### 2.2.2 ID3和C4.5算法

ID3算法只能用于分类任务,它使用信息增益作为衡量标准来选择特征,但是它只能处理离散特征。C4.5是ID3的改进版本,它不仅可以处理离散特征,还可以处理连续特征,并且使用信息增益比率来克服ID3倾向于选择具有更多值的特征的问题。

ID3和C4.5算法使用信息增益及信息增益比率:

- **信息增益**:基于熵的概念,通过度量分割前后数据集信息的减少程度来选择最佳特征。

- **信息增益比率**:信息增益和特征熵的比值,解决了特征取值多导致信息增益偏高的问题。

### 2.2.3 随机森林和Bagging方法

随机森林是一种集成学习方法,通过构建多棵决策树并进行投票来获得最终的分类结果。每棵树都是在不同的训练集上独立训练出来的,通常这些训练集是通过自助采样(bootstrap sampling)得到的,即从原始数据集中有放回地抽取样本来训练每棵树。

**Bagging方法**是随机森林的基础,通过减少模型方差来提高预测准确性和稳定性。它是一个通用的集成技术,可以用于任何可以进行自助采样的算法。在决策树的上下文中,Bagging主要用在CART算法上。

随机森林之所以有效,是因为它引入了两个重要的随机性:

- 随机选择特征:在分裂节点时随机选取一部分特征,而不是选择最优特征。

- 随机选择数据:为每棵树使用不同的训练数据集。

## 2.3 决策树算法的局限性与优化

### 2.3.1 过拟合问题及解决策略

决策树由于其模型的灵活性,很容易在训练数据上过度学习,导致过拟合。过拟合指的是模型对于训练数据过于敏感,捕捉到的数据的噪声而非其潜在的规律,这使得模型在未见过的数据上的表现大打折扣。

解决过拟合的策略主要有:

- **限制树的复杂度**:例如限制树的深度,或者限制节点的最小样本数。

- **预剪枝**(Pre-pruning):在树的构建过程中提前停止树的继续生长。

- **后剪枝**(Post-pruning):构建完整的树后,再对分支进行裁剪。

### 2.3.2 剪枝技术的原理与应用

剪枝技术是决策树中避免过拟合的常用方法。剪枝分为预剪枝和后剪枝。预剪枝是在决策树生成过程中,当满足一定条件时就停止树的增长。后剪枝则是在决策树构建完成后,删除一些对训练数据分类作用不大的分支。

**后剪枝的原理**如下:

1. 完全构建一棵决策树。

2. 对树中的每一个非叶节点评估剪枝后对模型的影响。

3. 选择影响最小的分支进行剪枝,将该分支替换为叶节点。

4. 重复第2和第3步,直到不能再剪枝或者达到预设的停止标准。

后剪枝方法因其能够在保持决策树结构的同时减少过拟合风险而被广泛使用。

```python

from sklearn.datasets import load_iris

from sklearn.tree import DecisionTreeClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

from sklearn.tree import export_graphviz

from graphviz import Source

# 加载数据集

iris = load_iris()

X = iris.data

y = iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=1)

# 构建决策树模型

clf = DecisionTreeClassifier(criterion='entropy', max_depth=3, random_state=1)

clf.fit(X_train, y_train)

# 进行预测

y_pred = clf.predict(X_test)

# 计算准确率

accuracy = accuracy_score(y_test, y_pred)

print("模型准确率:", accuracy)

# 可视化决策树

dot_data = export_graphviz(clf, out_file=None,

feature_names=iris.feature_names,

class_names=iris.target_names,

filled=True)

graph = Source(dot_data)

graph.render("decision_tree", format="png")

```

在上述Python代码中,我们使用了`sklearn`库来训练一个决策树模型,并通过`export_graphviz`函数将其可视化。需要注意的是,可视化出来的决策树深度被限制在3,这是为了简化树的复杂度并减少过拟合的风险。

本章节介绍了决策树的理论基础,包括决策树的核心概念、构建原理、常用的类型及其特点,以及面对过拟合问题时的优化策略。通过详细的解释和代码示例,我们了解了决策树在不同情境下的应用和如何对其优化。在下一章节中,我们将深入探讨集成学习的原理与实践。

# 3. 集成学习的理论与实践

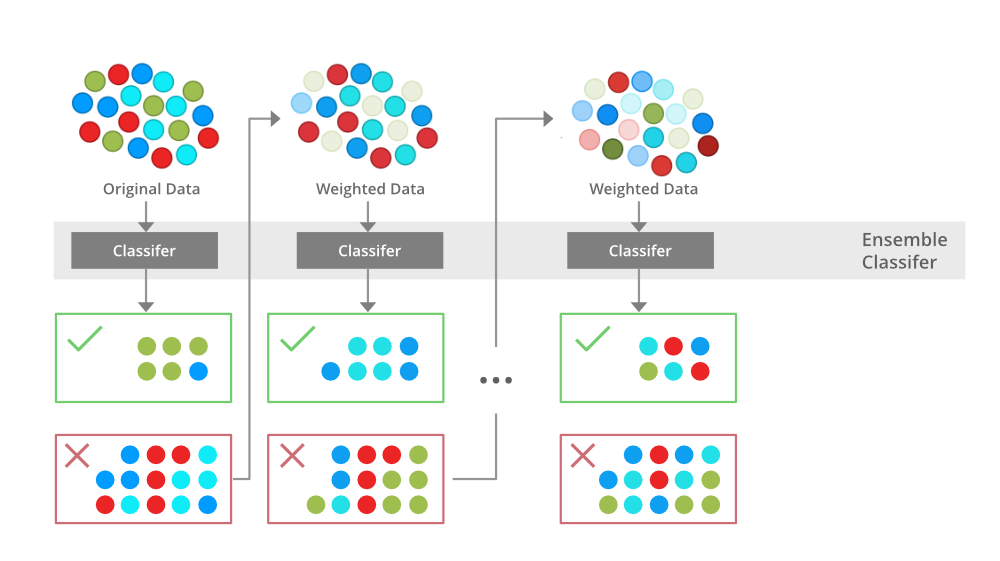

集成学习是一种通过构建并结合多个学习器来提高预测性能的机器学习方法。其核心思想在于“众人拾柴火焰高”,即通过组合多个模型来降低预测错误,提高模型的泛化能力。集成学习已广泛应用于各种机器学习任务,如分类、回归和推荐系统中,表现出色。

## 3.1 集成学习的原理

集成学习涉及构建一组个体模型(弱学习器)并将它们的预测结果进行适当的组合,以得到最终的预测结果。集成学习的关键在于如何选择弱学习器,如何训练这些弱学习器,以及如何集成这些弱学习器以得到一个强学习器。

### 3.1.1 弱学习器与强学习器

在集成学习中,弱学习器通常指的是性能略优于随机猜测的单个学习器。这些学习器在特定类型的数据或问题上可能表现出一定的偏差,但它们能够捕捉数据的某些规律。相反,强学习器则是指在相同条件下性能显著高于随机猜测的单个学习器。

0

0