NLP中的精确率挑战:8大策略应对自然语言处理的难题

1. 自然语言处理的精确率挑战概述

自然语言处理(NLP)领域中,精确率是指模型对任务的正确回答比例,它是衡量NLP系统性能的关键指标之一。精确率的提升直接关联到用户体验和模型的实际应用价值。然而,由于语言的多样性和复杂性,确保模型在不同语境和领域都能保持高精确率,是一个持续的挑战。

精确率的提升常常受限于模型对语言的深层理解,包括但不限于语法、语义、句法等语言层面。传统机器学习方法在处理这些问题时往往面临数据标注的高成本以及特征工程的复杂性。随着深度学习的兴起,模型通过自动提取特征,已经在这个领域取得了显著的进步。

然而,深度学习模型在处理长尾效应、同义词消歧、语言的细微变化等方面依然面临困难。尤其是在特定行业或专业领域中,缺乏充足的训练数据和复杂的领域术语进一步加剧了精确率提升的难度。下一章节将深入探讨深度学习模型如何应对这些挑战,以及它们在NLP中的应用和优化策略。

2. 深度学习模型在NLP中的应用

2.1 理解深度学习模型

2.1.1 模型架构概览

在自然语言处理(NLP)领域,深度学习模型已成为了主流方法。理解这些模型的架构对构建有效的NLP系统至关重要。深度学习模型主要分为前馈神经网络、循环神经网络(RNN)、长短时记忆网络(LSTM)、门控循环单元(GRU)和Transformer等。

- **前馈神经网络(FNN)**是最基础的神经网络类型,它不包含反馈连接,因此信息从输入层流向输出层,适用于NLP中的分类和回归任务。

- **循环神经网络(RNN)**引入了循环连接,这使得网络能够处理序列数据。在理论上,RNN能够利用之前的输入信息,但实践中容易出现梯度消失或爆炸问题,因此在长序列上的表现不佳。

- **长短时记忆网络(LSTM)和门控循环单元(GRU)**是为了解决传统RNN的缺点而提出的变体。这两种网络通过引入门控机制,有效地解决了长期依赖问题。

- Transformer模型,通过自注意力机制处理序列数据,不依赖于循环结构,可以并行化处理,显著提升了模型训练的效率,并且能更好地捕捉长距离依赖。

2.1.2 模型训练过程

深度学习模型训练通常包含以下几个步骤:

- 数据准备:收集并预处理数据,通常需要进行分词、向量化等步骤。

- 模型定义:根据任务需求选择合适的模型架构,并定义损失函数和优化器。

- 前向传播:输入数据通过模型计算得到输出。

- 损失计算:输出与真实标签的差异通过损失函数计算损失值。

- 反向传播:损失值反向传播通过网络,计算出每个权重对损失的贡献。

- 权重更新:根据优化算法(如SGD、Adam等)更新网络中的权重。

- 迭代训练:重复前向传播、损失计算、反向传播和权重更新步骤,直到模型收敛。

2.1.3 实践中的模型选择

在实际应用中,选择合适的模型架构是提高NLP精确率的关键。对于任务如情感分析、文本分类,简单的前馈网络或RNN可能足以完成任务。而对于更复杂的任务,如机器翻译、问答系统,Transformer及其衍生模型(如BERT、GPT等)表现更佳。

对于处理不同类型的NLP任务,我们可以根据任务的复杂度、数据集大小及训练时间等因素,结合实验结果选择模型。一般来说,随着模型复杂度的增加,所需的计算资源也会增加,训练时间会更长,但模型性能往往随之提高。

2.2 深度学习模型的优化策略

2.2.1 权重初始化和正则化技术

在训练深度学习模型时,合适的权重初始化和正则化技术可以有效防止过拟合和加快模型收敛速度。

- 权重初始化:合适初始化权重对于训练深度模型非常重要。如Xavier初始化、He初始化等方法可以在训练初期平衡梯度,防止权重过大或过小。

- 正则化技术:L1和L2正则化可以添加到损失函数中,用来限制模型复杂度和防止过拟合。Dropout技术通过在训练过程中随机“关闭”部分神经元来实现类似效果。

2.2.2 梯度消失与爆炸的解决方法

在训练深度神经网络时,梯度消失和梯度爆炸是常见的问题。以下是一些常见的解决策略:

- 使用ReLU及其变种作为激活函数:ReLU(Rectified Linear Unit)及其变种如Leaky ReLU和ELU(Exponential Linear Unit)可以在一定程度上缓解梯度消失的问题。

- 批量归一化(Batch Normalization):通过标准化层的输入,可以加快训练速度并解决梯度消失或爆炸问题。

- 梯度裁剪(Gradient Clipping):通过限制梯度的最大值来避免梯度爆炸。

- 残差网络(Residual Networks):引入跳跃连接,使得即使在深层网络中梯度也能够顺利流动。

2.3 模型评估与精确率提升

2.3.1 评估指标的选择与应用

为了评估深度学习模型在NLP任务中的性能,通常会用到精确度、召回率、F1分数、ROC曲线和AUC值等指标。

- 精确度(Precision):预测为正例中实际为正例的比例。

- 召回率(Recall):实际为正例中预测为正例的比例。

- F1分数:精确度和召回率的调和平均数,当两者都很重要时使用。

- ROC曲线:展示模型分类能力的曲线,横轴是假正率(FPR),纵轴是真正率(TPR)。

- AUC值:ROC曲线下的面积,AUC值越大,模型性能越好。

2.3.2 精确率提升的实践经验

在实践中提升模型精确率可以通过多种方式:

- 数据增强:对于NLP任务,可以通过同义词替换、回译等方法扩展训练数据集。

- 集成学习:结合多个模型的预测结果,通过投票或平均等方式得到最终预测,可以有效提升精确率。

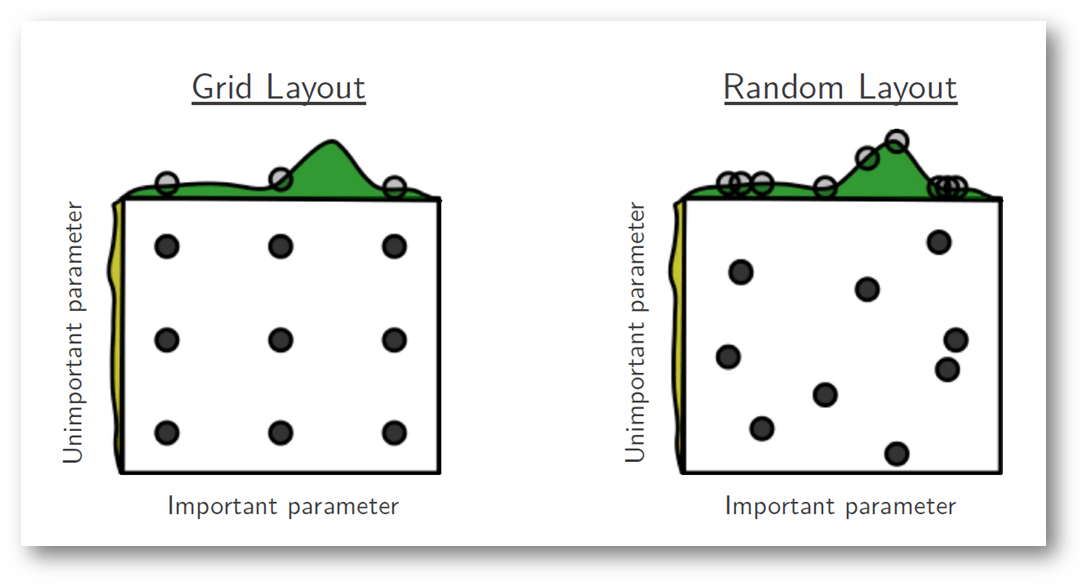

- 参数调优:通过细致的网格搜索、随机搜索或贝叶斯优化等方法寻找最优的超参数组合。

- 模型微调:使用在大规模数据集上预训练的模型,对其进行微调,以适应特定任务,尤其在小数据集上效果显著。

对于提升精确率,一个有效的策略是逐步迭代,结合上述多种方法,不断实验并根据模型在验证集上的表现进行调整。通过持续的实践,我们可以找到适合特定NLP任务的最优解。

3. ```

第三章:精确率提升的统计与机器学习方法

3.1 特征工程与数据预处理

3.1.1 文本特征提取技术

在自然语言处理(NLP)任务中,从文本数据中提取特征是提高模型精确率的关键步骤。传统的文本特征提取技术主要包括词袋模型(Bag of Words, BoW)、TF-IDF(Term Frequency-Inverse Document Frequency)和Word Embeddings(如Word2Vec和GloVe)。BoW模型忽略了单词的顺序,仅考虑单词出现的频率,而TF-IDF在此基础上进一步考虑了单词在整个语料库中的分布。Word Embeddings则将单词表示为稠密的向量,使得语义上相似的单词在向量空间中也有相近的表示。

在上述代码中,我们使用TfidfVectorizer类来提取文本数据集中的TF-IDF特征,并将结果转换为数组形式。通过打印tfidf_matrix,我们能够看到每个文本样本的TF-IDF特征向量。而feature_names包含了所有文本特征的名称,这有助于我们理解每个维度代表的特征含义。

3.1.2 数据清洗和增强

数据清洗是确保模型学习到有效模式的前提。在NLP中,数据清洗包括去除停用词、标点符号、数字等,以及进行词干提取(Stemming)和词形还原(Lemmatization)。数据增强则是通过一系列技术增加训练数据的多样性,以提升模型的泛化能力。常见的方法包括回译(Back-Translation)、同义词替换(Synonym Replacement)和随机插入(Random Insertion)等。

- import nltk

- from nltk.corpus import stopwords