【数据驱动设计的PyTorch实践】:掌握数据结构与图表的深层关系

发布时间: 2024-12-11 21:38:18 阅读量: 18 订阅数: 15

数据驱动智能:在PyTorch中掌握数据加载与预处理

# 1. PyTorch基础与数据结构概述

PyTorch作为深度学习领域的热门框架,为研究者和工程师提供了一套高效、灵活的数据结构和操作接口。本章将详细介绍PyTorch的基本概念,包括其核心组件、数据结构,以及如何利用这些结构进行深度学习研究。

## 1.1 PyTorch核心概念

PyTorch的核心概念包括张量(Tensor)、自动微分(Autograd)、神经网络模块(Neural Network Modules)。张量类似于NumPy中的多维数组,但可以利用GPU进行加速计算。自动微分系统让定义和计算梯度变得简单,而神经网络模块则提供了构建深度学习模型的工具。

## 1.2 张量(Tensor)操作

在PyTorch中,张量操作是构建模型的基础。张量可以进行算术运算、矩阵运算和线性代数运算等,这些操作保证了数据在模型中的流动性和处理效率。张量操作还支持广播机制,使得不同形状的张量在运算时能够自动扩展到相同形状。

## 1.3 动态计算图

PyTorch使用的动态计算图机制使得模型的定义和修改更加灵活。不同于静态图,动态图可以在运行时根据数据的变化而改变,使得条件和循环等控制流操作变得简洁明了。这对于实验和快速原型设计尤其有帮助。

本章内容为后续章节中数据加载、预处理、模型构建等高级话题打下坚实的基础。通过理解和掌握PyTorch的基础与数据结构,可以更高效地进行深度学习项目的开发。

# 2. PyTorch数据加载与预处理

## 2.1 数据加载的机制与技术

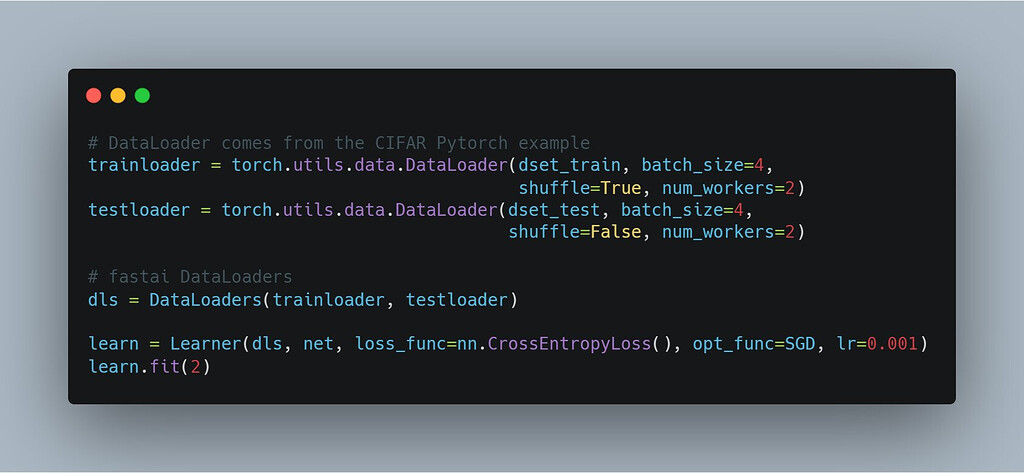

### 2.1.1 PyTorch数据加载器的创建与使用

在构建深度学习模型时,数据加载是至关重要的一步。PyTorch提供了强大的数据加载器(DataLoader),该加载器能够以多线程方式加载数据,并能够对数据进行批处理、打乱(shuffle)和单个或多GPU支持。

首先,我们需要定义一个数据集(DataSet),这通常涉及到继承`torch.utils.data.Dataset`类并重写`__init__`, `__getitem__`以及`__len__`方法。例如,如果我们要加载一个简单的图片数据集,可以创建一个简单的数据集类:

```python

import os

from torchvision import transforms

from torch.utils.data import Dataset, DataLoader

from PIL import Image

class SimpleImageDataset(Dataset):

def __init__(self, image_dir, transform=None):

self.image_dir = image_dir

self.transform = transform

self.image_files = [os.path.join(image_dir, file) for file in os.listdir(image_dir)]

def __getitem__(self, index):

image_path = self.image_files[index]

image = Image.open(image_path).convert('RGB')

if self.transform:

image = self.transform(image)

return image

def __len__(self):

return len(self.image_files)

# 数据转换操作

data_transforms = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

])

# 实例化数据集

dataset = SimpleImageDataset('path/to/images', transform=data_transforms)

# 实例化数据加载器

data_loader = DataLoader(dataset, batch_size=32, shuffle=True)

```

在上述代码中,我们创建了一个简单的图像数据集,并通过`DataLoader`进行高效加载。`DataLoader`的`batch_size`参数定义了每个批次的样本数量,`shuffle=True`参数确保了数据的随机性,有助于模型的泛化能力。

### 2.1.2 高效数据预处理流程

在深度学习项目中,数据预处理是优化模型性能不可或缺的一环。高效的数据预处理流程不仅包括数据加载,还涉及到对数据进行归一化、标准化、增强等操作,以保证模型训练的有效性和效率。

以下是一个高效数据预处理流程的代码示例:

```python

from torchvision import transforms

# 数据增强和转换操作

data_transforms = transforms.Compose([

transforms.RandomResizedCrop(224), # 随机裁剪并调整大小

transforms.RandomHorizontalFlip(), # 随机水平翻转

transforms.ToTensor(), # 转换为Tensor

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]), # 归一化

])

# 在数据集初始化时应用transform

dataset = SimpleImageDataset('path/to/images', transform=data_transforms)

# 使用DataLoader来批量加载数据

data_loader = DataLoader(dataset, batch_size=32, shuffle=True)

```

上述代码示例展示了如何使用PyTorch中的`transforms`模块对图像数据进行一系列的预处理操作。其中`RandomResizedCrop`和`RandomHorizontalFlip`对图像进行了随机裁剪和水平翻转以增加数据多样性,`ToTensor`将图像转换为Tensor类型,而`Normalize`则对图像进行了归一化处理,这有助于模型更快的收敛。

### 2.2 数据增强技术

#### 2.2.1 图像数据增强方法

数据增强技术可以人为地扩大数据集规模和增加数据多样性,从而提高模型的泛化能力。在图像处理领域,常见的数据增强方法包括随机旋转、缩放、裁剪、颜色抖动等。

这里展示了一个自定义的图像数据增强类示例:

```python

import random

from torchvision import transforms

class RandomAugmentation:

def __init__(self, magnitude):

self.magnitude = magnitude

def __call__(self, image):

# 随机旋转

degrees = random.uniform(-self.magnitude, self.magnitude)

image = transforms.functional.rotate(image, degrees)

# 随机缩放

scale = random.uniform(1 - self.magnitude, 1 + self.magnitude)

image = transforms.functional.resize(image, [int(224 * scale), int(224 * scale)])

return image

```

在上述代码中,`RandomAugmentation`类允许在图像数据加载和预处理阶段实现自定义增强方法。通过调整`magnitude`参数的值,可以控制增强的强度,以适应不同的数据集和任务需求。

#### 2.2.2 文本数据增强策略

对于文本数据,数据增强可能包含同义词替换、随机删除或插入单词、句式变换等策略。PyTorch没有像图像那样内置的文本数据增强库,但可以通过定义函数来实现。

```python

import random

import nltk

from nltk.corpus import wordnet

def synonym_replacement(words, n=1):

new_sentence = words.copy()

random挑选两个不同的单词

synonym_words = get_synonyms(new_sentence[i]) # 假设这个函数返回同义词列表

synonym_word = random.choice(synonym_words)

new_sentence[i] = synonym_word

return new_sentence

# 这里需要下载nltk所需数据集

nltk.download('wordnet')

```

该函数`synonym_replacement`接受一个单词列表(句子)和一个整数n,表示需要替换的单词数量。函数内部通过选择不同的同义词来替换句子中的单词,以此来增强数据集。

### 2.3 自定义数据集与采样策略

#### 2.3.1 继承Dataset类创建自定义数据集

为了处理复杂的数据结构,我们可以通过继承`torch.utils.data.Dataset`类来自定义自己的数据集。自定义数据集允许我们定义数据加载的具体逻辑,并且可以轻松地与`DataLoader`集成。

```python

from torch.utils.data import Dataset

class CustomDataset(Dataset):

def __init__(self, data_source):

self.data_source = data_source

def __getitem__(self, index):

return self.data_source[index]

def __len__(self):

return len(self.data_source)

```

在此示例中,`CustomDataset`类的构造函数接受一个`data_source`参数,该参数代表数据源,例如一个Numpy数组或Pandas DataFrame。`__getitem__`方法定义了如何根据索引获取数据项,而`__len__`方法返回数据集的大小。

#### 2.3.2 采样策略的设计与实现

在某些情况下,我们可能需要实现特定的采样策略,比如在不平衡数据集上进行训练时。PyTorch允许我们通过自定义采样器来实现复杂的采样逻辑。

```python

from torch.utils.data import Sampler

class CustomSampler(Sampler):

def __init__(self, data_source, shuffle=False):

self.data_source = data_source

self.shuffle = shuffle

def __iter__(self):

if self.shuffle:

# 打乱数据集

indices = list(range(len(self.data_source)))

random.shuffle(indices)

else:

indices = list(range(len(self.data_source)))

return iter(indices)

def __len__(self):

return len(self.data_source)

```

在这里,`CustomSampler`类允许我们控制数据的采样方式。如果`shuffle`参数为`True`,则在每次迭代时随机打乱数据顺序。

在PyTorch中,可以通过`DataLoader`的`sampler`参数将自定义采样器与数据加载器结合使用,从而实现更细粒度的数据控制。例如:

```python

sampler = CustomSampler(dataset, shuffle=True)

data_loader = Data

```

0

0