模型验证技术:自助法与重采样在数据挖掘中的应用

发布时间: 2024-09-08 04:17:03 阅读量: 37 订阅数: 47

Java源码springboot的智能家居系统-毕业设计论文-期末大作业.zip

# 1. 模型验证技术概述

## 模型验证的重要性

在数据科学中,模型验证是确保我们构建的统计模型或机器学习算法能够准确反映现实世界过程的关键步骤。未经验证的模型可能会导致误导性的结论和决策失误。模型验证技术涉及一系列方法论,这些方法论旨在通过各种测试来评估模型的预测能力和泛化性能。

## 模型验证的基本步骤

模型验证通常包括以下几个基本步骤:

1. **数据准备**:收集和清洗数据,将数据分为训练集和测试集。

2. **模型训练**:使用训练集来训练模型的参数。

3. **交叉验证**:运用交叉验证技术对模型性能进行内部评估。

4. **性能指标**:选取适当的指标来衡量模型表现,如均方误差(MSE)、精确度等。

5. **泛化测试**:用测试集评估模型在未见过的数据上的表现。

通过这些步骤,我们可以从不同角度对模型的稳健性和有效性进行综合评价,从而在实际应用中获得更好的性能。接下来的章节将详细介绍自助法和重采样技术,它们是模型验证领域中两种重要的技术手段。

# 2. 自助法的理论与实践

## 2.1 自助法的基本概念

### 2.1.1 自助法的定义和起源

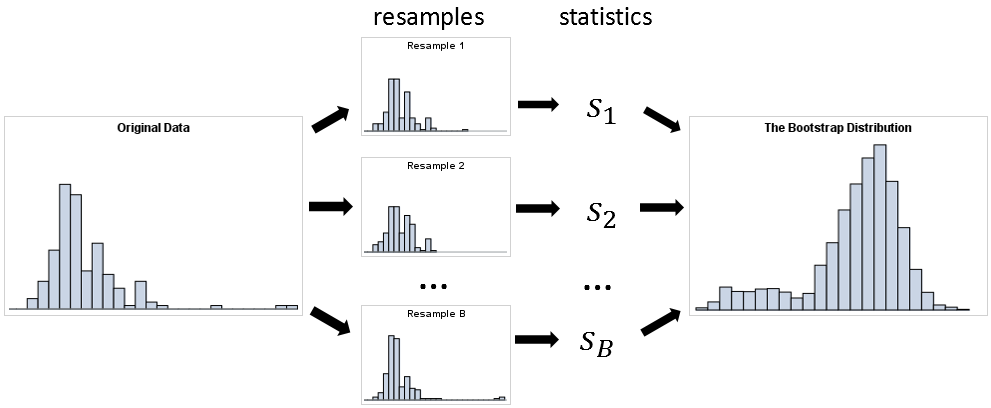

自助法(Bootstrap Method)是一种强大的统计方法,用于估计抽样分布,即通过从原始数据中多次有放回地随机抽样,创建所谓的"自助样本",从而估计出统计量的分布。自助法由Bradley Efron于1979年提出,它克服了传统抽样理论中对大样本量的依赖,并且在小样本的情况下也能进行有效推断。

### 2.1.2 自助法的统计原理

自助法的核心思想是"用数据自身来估计其分布"。在统计学中,假定总体分布是未知的,我们通常通过从样本中进行抽样来估计总体分布的某些特征,如均值、方差等。自助法允许我们评估这些估计量的稳定性和可靠性。具体操作时,从原始样本数据集中随机抽取一个样本,记录下这个样本,然后将这个样本放回原始数据集中。这个过程重复进行多次,形成多个自助样本,最后对这些自助样本上的统计量进行分析,以获得对原始统计量分布的近似。

## 2.2 自助法在数据挖掘中的应用

### 2.2.1 自助法的实现步骤

在数据挖掘中,自助法可以用于估计模型参数或性能指标。下面是自助法的基本实现步骤:

1. **准备原始数据集**:这是包含所有可用数据的集合。

2. **生成自助样本**:多次从原始数据集中随机抽取样本来创建自助样本。每个自助样本与原始数据集大小相同,且同一个数据点可以被重复抽取。

3. **建立统计量**:针对每个自助样本建立感兴趣的统计量,如均值、方差、回归系数等。

4. **分析统计量分布**:分析所有自助样本上统计量的分布,估计其均值、标准差、置信区间等,这有助于了解该统计量的稳定性和可靠性。

### 2.2.2 自助法在分类和回归中的案例分析

考虑一个分类问题,我们可以使用自助法来估计分类器的准确率。以下是具体步骤:

1. **从数据集中抽取一个自助样本**。

2. **使用这个自助样本训练分类器**。

3. **使用剩余的未抽取样本(称为“袋外样本”)测试分类器的性能**。

4. **记录准确率**。

5. **重复上述过程多次(比如1000次),每次使用不同的自助样本**。

6. **最后,统计所有准确率的分布,可以得到准确率的一个置信区间**。

自助法不仅限于估计准确率,它还可以用来评估回归问题中模型参数的可靠性,或者预测值的不确定性等。

## 2.3 自助法的优缺点及改进方法

### 2.3.1 自助法的常见问题与挑战

自助法虽然强大,但也存在一些问题和挑战:

1. **计算成本高**:大量的自助样本需要重复计算,对于计算密集型任务可能效率低下。

2. **对初始样本集敏感**:自助法假设样本集能够代表总体,如果样本集有偏,则可能得到有偏的结果。

3. **无法处理相关数据**:对于时间序列等存在依赖关系的数据,使用自助法可能导致统计量的方差被低估。

### 2.3.2 改进自助法的策略和实践

为了克服自助法的这些局限,研究人员和实践者提出了一些改进策略:

1. **并行计算**:利用现代计算机的多核处理器能力,可以并行处理多个自助样本的计算,从而减少总体时间消耗。

2. **自适应抽样**:当初始样本集存在偏差时,可以调整抽样概率,以保证自助样本更好地代表总体。

3. **自助法变体**:如分层自助法等,可以处理有依赖关系的数据,并给出更准确的估计。

通过结合各种策略,自助法的效率和准确性可以得到显著提高,使其在实际应用中更加有用。

# 3. 重采样技术的理论与实践

重采样技术是数据挖掘和统计建模中的关键组成部分,尤其是当原始数据集不足以产生有效的模型性能估计时。本章节将详细介绍重采样技术的基础原理、在数据挖掘中的应用,以及如何优化重采样过程以提高模型性能。

## 3.1 重采样的基本原理

### 3.1.1 重采样的定义和分类

重采样指的是通过从原始数据集中抽取样本来创建新的数据集的过程。它可以是上采样(oversampling),即增加少数类的样本数量,或是下采样(undersampling),即减少多数类的样本数量。重采样技术在处理不平衡数据集时尤其有用,其目的是创建一个平衡的数据集,以便能够更准确地评估模型性能。

重采样分为两种主要类型:

- **有放回重采样(Bootstrap Resampling)**:每次抽取一个样本后,它会被放回数据集,这意味着它可以被重复抽取。这种方法常用于自助法,已在第二章详细讨论。

- **无放回重采样(Non-Bootstrap Resampling)**:在无放回重采样中,一旦样本被抽取,它就不会被放回,直到下一次抽取。这种方法常常用于划分数据集为训练集和测试集。

### 3.1.2 重采样的统计背景

统计学上,重采样可以视作一种重复测量方法,其中数据集的子样本被视为重复实验。每一轮的抽取和模型评估都提供了一个性能估计,而重复此过程可以构建出性能估计的分布,从而得到更稳定的统计推断。重采样还允许我们评估模型对数据随机波动的敏感性,进而更好地理解模型的泛化能力。

## 3.2 重采样技术在数据挖掘中的应用

### 3.2.1 抽样方法的介绍

在数据挖掘中,抽样方法是用来从大型数据集中获取有代表性的样本,以减少计算资源的消耗和提高效率。常见的抽样方法包括简单随机抽样、分层抽样和聚类抽样等。

- **简单随机抽样**是最基本的抽样方法,它保证每个样本被选中的概率是相等的。它适用于数据分布均匀且没有显著子群体的情况。

- **分层抽样**则是在抽样前将总体分成不同的子群体(称为“层”),然后从每一层中独立地抽取样本。这种方法可以确保样本在某些重要特征上的分布与总体一致。

- **聚类抽样**涉及将数据分成不同的群组,然后只从这些群组中随机选择一部分群组进行采样。这种抽样方法适用于数据分布不均,且具有自然聚类属性的情况。

### 3.2.2 重采样在模型评估中的实例

在模型评估阶段,重采样技术常常被用于交叉验证(Cross-Validation)和自助法评估(Bootstrapping)中。交叉验证是一种将数据集分成多个小的子集,然后通过轮流使用其中的一个子集作为测

0

0