【模型验证避坑指南】:六大陷阱及对策,确保验证准确无误

发布时间: 2024-09-08 03:25:47 阅读量: 58 订阅数: 39

# 1. 模型验证的基本原则和重要性

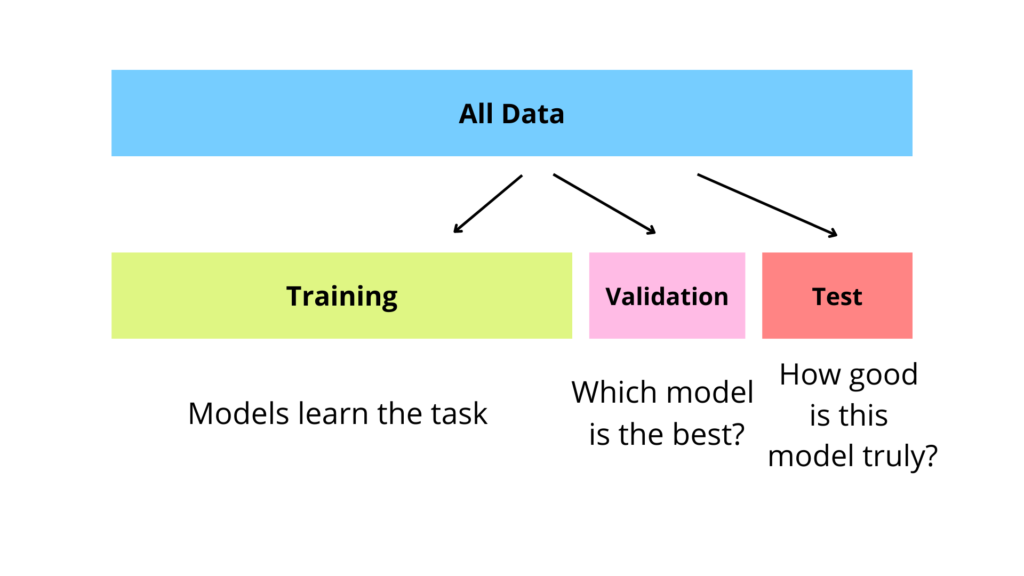

模型验证是机器学习和数据科学项目中不可或缺的一步,它确保了模型在新的、未见过的数据上也能表现出预期的性能。验证过程涉及到一系列原则,它们指导我们正确评估模型的有效性。在这一章中,我们将深入探讨这些原则并强调模型验证的重要性。

## 模型验证的基本原则

- **独立性**:验证集应与训练集保持独立,以准确反映模型在现实世界数据上的表现。

- **代表性**:验证数据应具有与目标环境相同的数据分布特性。

- **客观性**:验证过程需要尽量减少主观因素的干扰,保证结果的公正性。

## 模型验证的重要性

- **预测准确性**:通过验证,可以确保模型在新数据上的准确性,减少过度拟合的风险。

- **鲁棒性评估**:模型的鲁棒性可以通过验证集上的性能来评估,即在不同情况下模型的一致性。

- **改进和调整**:验证过程可以帮助识别模型中的不足,为模型改进提供方向。

模型验证不仅关乎模型的预测准确性,更是整个数据科学工作流程中不可或缺的一部分,它对于任何追求高准确率和高可靠性的项目来说至关重要。下一章,我们将探讨在进行模型验证时,经常遇到的陷阱和挑战。

# 2. 识别模型验证中的常见陷阱

## 2.1 数据集相关的陷阱

模型验证的过程依赖于数据的质量和代表性。在数据集的使用过程中,我们经常会遇到一些陷阱,这些陷阱往往会导致模型的泛化能力下降,从而影响模型的实际应用效果。

### 2.1.1 数据过拟合

数据过拟合是机器学习领域中一个常见问题,指的是模型在训练数据上表现极好,但在新的、未见过的数据上性能却大幅下降。这主要是因为模型学习到了训练数据中的一些噪音和非本质特征,而非学习数据的内在规律。

```python

from sklearn.datasets import make_classification

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 创建过拟合数据集

X, y = make_classification(n_samples=100, n_features=20, n_informative=2, n_redundant=10, random_state=42)

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.5, random_state=42)

# 训练模型

model = LogisticRegression()

model.fit(X_train, y_train)

# 在训练集和测试集上评估模型性能

train_predictions = model.predict(X_train)

test_predictions = model.predict(X_test)

train_accuracy = accuracy_score(y_train, train_predictions)

test_accuracy = accuracy_score(y_test, test_predictions)

print("训练集准确率:", train_accuracy)

print("测试集准确率:", test_accuracy)

```

在上述代码中,我们首先创建了一个过拟合的数据集,并将数据集分为训练集和测试集。通过训练一个逻辑回归模型,我们可以观察到在训练集上的准确率很高,但在测试集上的准确率则大幅下降,这正是过拟合的表现。

### 2.1.2 数据不平衡问题

数据不平衡是指分类任务中各类别数据样本量相差较大。在现实世界数据中,不平衡是一个常见现象,而数据不平衡可能导致模型对少数类的识别效果差。

```python

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from imblearn.over_sampling import SMOTE

from sklearn.ensemble import RandomForestClassifier

from sklearn.metrics import classification_report

# 创建不平衡数据集

X, y = make_classification(n_samples=1000, n_features=20, n_informative=2, weights=[0.99], flip_y=0, random_state=42)

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.5, random_state=42)

# 使用SMOTE技术进行过采样

smote = SMOTE(random_state=42)

X_train_smote, y_train_smote = smote.fit_resample(X_train, y_train)

# 训练随机森林模型

model = RandomForestClassifier(random_state=42)

model.fit(X_train_smote, y_train_smote)

# 在测试集上评估模型性能

predictions = model.predict(X_test)

print(classification_report(y_test, predictions))

```

在上述代码中,我们使用 `imblearn` 库中的 `SMOTE` 类对训练数据进行了过采样,以解决数据不平衡的问题。在应用模型后,我们通过 `classification_report` 评估了模型的性能,可以看到对少数类的识别效果得到提升。

### 2.1.3 数据污染的影响

数据污染指的是数据集中存在错误的标签或异常值,这会对模型的训练产生负面影响。

```python

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

# 创建带有噪声的数据集

X, y = make_classification(n_samples=500, n_features=20, n_informative=2, n_redundant=10, flip_y=0.1, random_state=42)

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.5, random_state=42)

# 训练逻辑回归模型

model = LogisticRegression()

model.

```

0

0