机器学习模型评估指南:数学建模C题中的准确度、召回率和F1分数应用

《机器学习评估:Python混淆矩阵实战》-涵盖模型评估、分类算法,助力精准度与召回率分析,适用于数据科学和人工智能领域

摘要

本文系统地探讨了机器学习模型评估的基础知识、关键指标及其在实际问题中的应用和数学原理。首先介绍了评估指标如准确度、召回率和F1分数的基本概念、计算方法及其优缺点。然后,文章深入分析了在模型选择、优化过程中的实际应用,并结合数据集划分策略来进一步阐述评估指标在解决具体问题时的作用。文章还详细探讨了评估指标的数学基础、统计学解释以及优化方法。最后,探讨了评估指标在泛化能力评估、多类分类问题中的应用,并展望了当前评估方法在大数据时代的挑战和未来发展趋势。本文旨在为读者提供全面理解评估指标及其在机器学习模型中应用的深入分析。

关键字

机器学习;模型评估;准确度;召回率;F1分数;泛化能力

参考资源链接:2023高教社数学建模C题 - 蔬菜类商品的自动定价与补货决策【数据处理详细代码】

1. 机器学习模型评估基础

机器学习模型评估是理解模型性能的关键环节,通过对模型进行评估,我们可以定量地了解模型在未见数据上的表现,以及它解决特定问题的能力。评估过程涉及到数据集的准备、模型的训练和验证,以及最终的性能指标计算。为了深入理解评估,我们将从准确度、召回率和F1分数等基础指标开始探索,为后续章节中对这些指标的应用和优化打下坚实的基础。在机器学习的众多评估指标中,准确度是最直观的一种,它反映了模型预测正确的样本比例。然而,准确度并不总是最有效的评估标准,特别是在数据分布不平衡的情况下。准确度的计算公式简单明了,但我们需要理解其适用条件以及在某些情况下可能导致的误导。接下来,我们将对准确度进行详细的介绍,并探讨它的计算方法、应用场景、以及优缺点。

2. 模型评估指标——准确度、召回率、F1分数

2.1 准确度的理解与计算

2.1.1 准确度的定义和应用场景

准确度(Accuracy)是模型评估中最直观的指标之一,它反映了分类模型对测试样本正确分类的比例。在二分类问题中,准确度可以通过以下公式计算:

[ \text{Accuracy} = \frac{\text{True Positive (TP)} + \text{True Negative (TN)}}{\text{Total Samples (TP + TN + False Positive (FP) + False Negative (FN))}} ]

准确度的应用场景非常广泛,特别是在样本类别分布相对均衡的情况下,它能很好地反映模型的整体表现。例如,在医疗诊断中,准确度可以用来评估模型预测病人是否有某疾病的能力。

2.1.2 准确度的优缺点分析

尽管准确度是一个直观的性能指标,但它也有局限性。在不平衡数据集上,准确度可能会产生误导。例如,在疾病检测中,如果99%的人没有疾病,即使模型总是预测“无疾病”,准确度也会高达99%。这种情况下,准确度就不能很好地反映模型对少数类别的预测能力。

另一个缺点是准确度没有考虑预测的置信度或者预测的顺序,它仅仅是一个总体的正确率。

2.2 召回率的理解与计算

2.2.1 召回率的定义和应用场景

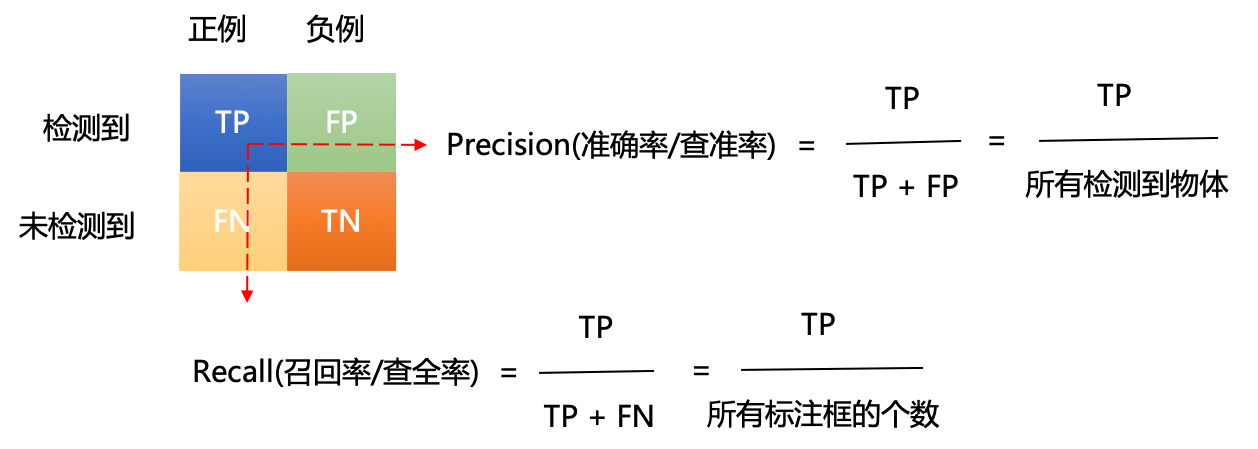

召回率(Recall),又称为敏感性,它衡量的是模型正确识别正类样本的能力。召回率的计算公式如下:

[ \text{Recall} = \frac{\text{True Positive (TP)}}{\text{True Positive (TP) + False Negative (FN)}} ]

召回率特别适用于关注“漏报”会带来严重后果的场景。比如,在垃圾邮件过滤系统中,漏掉一封垃圾邮件可能导致用户体验下降。

2.2.2 召回率的优缺点分析

召回率的提高通常会伴随着精确度的降低,因为模型可能会预测更多的正类样本,从而增加假正类的数量。这表明召回率和精确度之间存在一定的权衡关系。在实际应用中,需要根据问题的性质来平衡这两个指标。

2.3 F1分数的理解与计算

2.3.1 F1分数的定义和应用场景

F1分数是准确度和召回率的调和平均,它提供了单一指标来平衡准确度和召回率。F1分数的计算公式如下:

[ \text{F1 Score} = 2 \times \frac{\text{Precision} \times \text{Recall}}{\text{Precision} + \text{Recall}} ]

F1分数对于那些需要在精确度和召回率之间进行权衡的场景特别有用。例如,在推荐系统中,我们既不想错过推荐好内容的机会(高召回率),也不想推荐用户不喜欢的内容(高精确度)。

2.3.2 F1分数与准确度、召回率的关系

F1分数是准确度和召回率的综合考量,它在两者都为重要的情况下具有特别的意义。当精确度和召回率都低时,F1分数也会低;而当精确度和召回率都高时,F1分数也相应地高。F1分数能够在单一指标中反映出模型的综合性能,但它不会反映真实世界应用中的所有方面,因此在特定情况下仍需要单独考虑准确度和召回率。

以上是一个简化的流程图,展示了如何通过计算TP, TN, FP, FN来得到准确度、召回率和F1分数,并以此进行模型的性能评估和优化。

- | 指标 | 定义 | 应用场景 |

- | --- | --- | --- |

- | 准确度 | (TP + TN) / 总样本数 | 样本均衡的数据集 |

- | 召回率 | TP / (TP + FN) | 避免漏报的情况 |

- | F1分数 | 2 * (精确度 * 召回率) / (精确度 + 召回率) | 精确度和召回率都重要的情况 |

表格展示了三种评估指标的定义和它们适用的场景。

- # Python代码示例:计算准确度、召回率、F1分数

- from sklearn.metrics import accuracy_score, recall_score, f1_score

- # 假设y_true是真实的标签,y_pred是模型预测的标签

- y_true = [1, 0, 1, 1, 0, 1, 0, 0]

- y_pred = [1, 0, 1, 0, 0, 1, 0, 1]

- # 计算准确度

- accuracy = accuracy_score(y_true, y_pred)

- print(f"准