非参数化模型优化:贝叶斯优化进阶课题实战演练

发布时间: 2024-11-23 21:54:56 阅读量: 26 订阅数: 27

超参数优化:贝叶斯优化.zip

# 1. 非参数化模型优化概述

在当今的数据驱动时代,模型优化是提升算法性能的关键。非参数化模型优化,尤其是贝叶斯优化,因其独特的优势在众多优化技术中脱颖而出。它允许我们在面对高维空间、噪声数据和计算成本高昂的场景下,高效地寻找全局最优解。与传统的参数化模型优化不同,非参数化模型无需假设一个固定的参数数量,这意味着它在处理非线性和复杂问题时更加灵活。

## 1.1 非参数化模型的定义

非参数化模型是一类不假设数据生成分布具有特定形式的模型。与之相对的是参数化模型,后者假设数据遵循特定分布,并通过调整有限的参数来进行学习。非参数化模型在预测性能和灵活性方面具有优势,但也面临计算复杂度高、过拟合风险等问题。

## 1.2 非参数化模型的特点

非参数化模型的主要特点包括:

- **灵活性**:能够适应数据的复杂性,无需事先设定参数的个数或形式。

- **泛化能力**:往往在未知分布的数据上表现良好,尤其是在样本量足够大时。

- **过拟合风险**:因为模型结构随数据而定,所以在有限样本下可能过拟合。

非参数化模型优化,特别是在贝叶斯优化领域,通过引入先验知识和代理模型,有效缓解了上述问题,提升了搜索全局最优解的效率。接下来,我们将深入探讨贝叶斯优化的理论基础及其在实际应用中的实现过程。

# 2. 贝叶斯优化基础理论

## 2.1 非参数化模型简介

### 2.1.1 非参数化模型的定义

非参数化模型是相对于参数化模型而言的统计模型。在参数化模型中,模型的结构和参数的数量是固定的,这些模型需要事先定义参数的数量和结构。非参数化模型则没有固定参数的数量,能够根据数据自动调节模型的复杂度。这种灵活性让非参数化模型特别适合处理复杂的数据结构,因为它们不需要预先设定模型形式,也能够更好地适应数据的内在结构。

非参数化模型的显著特点包括:

- **灵活性:** 能够拟合各种形状的数据分布。

- **无假设限制:** 不需要对数据分布做出强假设。

- **数据驱动:** 模型复杂度随着数据量的增加而增加。

### 2.1.2 非参数化模型的特点

非参数化模型的灵活性是它们的一个显著优势,但是它们也有局限性。在处理大规模数据集时,非参数化模型可能会变得计算上非常昂贵,因为模型复杂度的增加直接导致计算负担的加重。

例如,非参数化模型通常需要较大的内存来存储整个数据集的结构信息。另外,对于一些特定类型的问题,例如时间序列预测,非参数化模型可能不是最有效的选择。然而,在需要高度适应性的场合,非参数化模型能够提供非常有效的解决方案。

### 2.1.3 贝叶斯优化与非参数化模型

贝叶斯优化通常被视作一种非参数化优化算法,其核心在于使用概率模型来指导搜索过程,以寻找全局最优解。与传统的梯度下降等方法不同,贝叶斯优化不需要计算导数,能够适应不连续或噪声较大的目标函数。

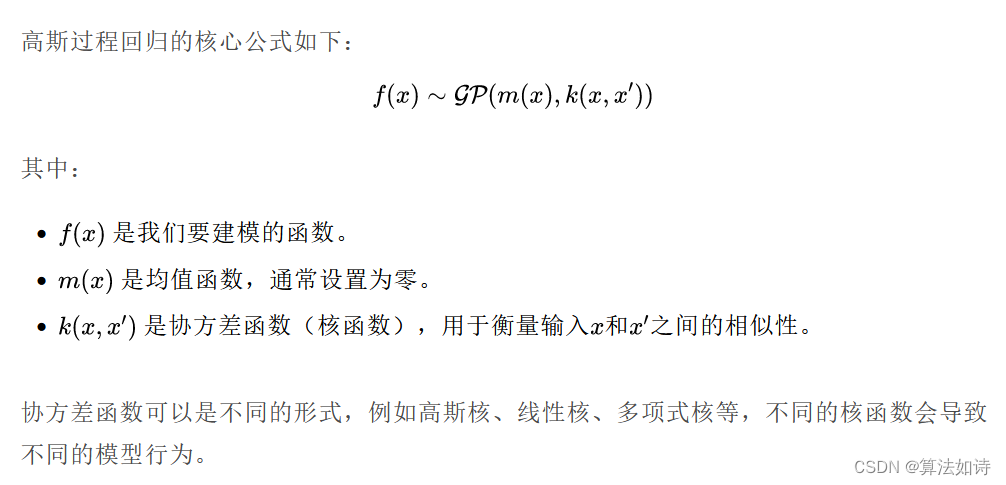

贝叶斯优化是一种基于代理模型的全局优化方法,它的核心思想是构建一个目标函数的代理模型(也称作“surrogate model”),通常是高斯过程(Gaussian Process),然后选择一个获取函数(Acquisition Function),在每次迭代中选择最有可能改进当前最优解的候选点进行评估。

## 2.2 贝叶斯优化原理

### 2.2.1 贝叶斯优化的数学基础

贝叶斯优化建立在贝叶斯统计的基础上,它通过考虑先验知识(prior knowledge)和观测数据来更新对目标函数的信念。贝叶斯公式是更新信念的核心机制,公式如下:

\[ P(H|E) = \frac{P(E|H) \cdot P(H)}{P(E)} \]

其中,\( P(H|E) \) 表示在观测到证据 \( E \) 的条件下假设 \( H \) 成立的概率,\( P(E|H) \) 是在假设 \( H \) 为真的条件下观测到 \( E \) 的概率,\( P(H) \) 是假设 \( H \) 为真的先验概率,而 \( P(E) \) 是观测到 \( E \) 的边缘概率。

在贝叶斯优化的上下文中,\( H \) 对应于潜在的目标函数,\( E \) 对应于通过目标函数获得的观测数据,\( P(H|E) \) 对应于在给定数据的条件下对目标函数的更新信念。

### 2.2.2 代理模型与获取函数

贝叶斯优化使用代理模型来近似目标函数,常用的代理模型包括高斯过程(Gaussian Process,GP)、随机森林(Random Forest)等。代理模型不仅提供了目标函数的预测,还提供了预测的不确定性度量。

获取函数是在代理模型的基础上,指导下一步搜索方向的决策规则。它衡量了探索(exploration)和利用(exploitation)之间的权衡。获取函数的典型例子包括期望改进(Expected Improvement,EI)、概率改进(Probability of Improvement,PI)和上限置信区间(Upper Confidence Bound,UCB)。

期望改进(EI)是一种常用且效果良好的获取函数,它定义了对当前已知最优解的改进预期值。具体来说,如果当前最优解是 \( y^* \),那么在新候选点 \( x \) 的期望改进是:

\[ EI(x) = \int_{-\infty}^{+\infty} \max(0, y - y^*) \cdot p(y|x) \, dy \]

其中,\( y \) 是目标函数在 \( x \) 的预测值,而 \( p(y|x) \) 是在给定点 \( x \) 的预测分布。

## 2.3 贝叶斯优化的实现过程

### 2.3.1 算法流程详解

贝叶斯优化的实现过程可以概括为以下步骤:

1. 初始化:选择一个随机点集作为初始训练集,并建立一个代理模型。

2. 预测:使用代理模型对所有尚未评估的点进行预测,并计算这些点的获取函数值。

3. 选择:选择具有最高获取函数值的点作为下一个评估的候选点。

4. 更新:在目标函数上评估该候选点,并更新代理模型和获取函数。

5. 终止条件:检查是否满足终止条件,如迭代次数、计算资源或性能指标达到预期水平。如果满足则停止,否则回到步骤2继续迭代。

### 2.3.2 关键步骤的实际意义

在贝叶斯优化中,每一个步骤都有其重要的实际意义。初始化步骤确定了优化的起点,选择一个具有代表性的初始点集可以提供更多的信息,有助于代理模型更好地拟合目标函数。预测步骤则决定了下一步的搜索方向,获取函数的高低直接关系到搜索效率。选择步骤是优化过程中的关键决策点,它直接关系到新点的选取是否能有效提升目标函数值。更新步骤保证了代理模型随着新信息的加入持续进化,而终止条件的设置则是优化过程中的实际约束,保证了优化工作的可行性和经济性。

在实际应用中,贝叶斯优化已经展示了其优越的性能,特别是在调参和设计实验等场景中,相比传统的网格搜索或随机搜索,贝叶斯优化能够以更少的评估次数找到更优的解。

```python

# 以下是使用Python实现贝叶斯优化的一个简单示例

from bayes_opt import BayesianOptimization

def objective_function(x):

# 这里是一个示例目标函数

return -x[0] ** 2 - (x[1] - 2) ** 2

# 定义优化的参数范围

pbounds = {'x': (1, 4), 'y': (1, 4)}

# 初始化优化器

optimizer = BayesianOptimization(

f=objective_function,

pbounds=pbounds,

random_state=1,

)

# 开始优化过程

optimizer.maximize(

init_points=2,

n_iter=10,

)

print(optimizer.max)

```

以上代码展示了如何使用`bayes_opt`库进行贝叶斯优化。代码中,`objective_function`是需要优化的目标函数,`pbounds`定义了两个参数的搜索范围,`BayesianOptimization`是核心优化类,通过`maximize`方法指定初始化点数和迭代次数进行优化。最后,打印出找到的最佳解。此代码段的逻辑分析及参数说明已在注释中给出。

该示例虽然简单,但充分展现了贝叶斯优化从初始化、预测到选择和更新代理模型的整个过程。在复杂问题中,目标函数和参数范围会更加复杂,但核心思想保持一致,通过迭代搜索获得最优解。

通过以上章节的探讨,我们对贝叶斯优化的基础理论有了较为全面的理解。接下来的章节,我们将深入探讨如何在实践中运用贝叶斯优化来解决实际问题,并通过工具和案例分析来进一步加深对贝叶斯优化应用的认识。

# 3. 贝叶斯优化工具与实践

贝叶斯优化的实践应用是将理论转化为实际问题解决方案的关键步骤。它涉及到一系列的工具选择、参数调优、案例分析等环节。本章将深入探讨如何选择合适的贝叶斯优化库,如何在实际中应用贝叶斯优化技术,以及如何对案例进行分析,以便更好地理解并利用这一技术。

## 3.1 选择贝叶斯优化库

在实践中,使用合适的贝叶斯优化库可以大大提高开发效率和优化效果。Python语言因其强大的数据分析生态系统,拥有多个成熟的贝叶斯优化库。

### 3.1.1 Python中常用贝叶斯优化库比较

Python中流行的贝叶斯优化库包括但不限于`hyperopt`、`bayes_opt`和`optuna`。这些库各有特色,适用于不同的优化需求。

- **Hyperopt**: 通过定义一个搜索空间,Hyperopt使用`fmin`函数来最小化目标函数。它支持树形结构的搜索空间和并行执行。

- **BayesOpt**: 相对轻量级,易于安装,提供了一个简单的接口来处理连续和离散的参数空间。

- **Optuna**: 新兴的库,集成了贝叶斯优化,并支持多种其他优化算法。它在定义搜索空间和并行化方面具有优势。

每个库都有其使用场景,选择合适的库将取决于项目需求、优化问题的复杂度以及开发者对库的熟悉程度。

### 3.1.2 库的安装与环境配置

安装相应的优化库是开始实践的第一步。以`hyperopt`为例,安装过程相对简单,可以通过`pip`进行安装:

```bash

pip install hyperopt

```

在安装过程中,可以使用虚拟环境,如`conda`或`virtualenv`来隔离依赖关系,保证开发环境的整洁。

```bash

# 使用conda创建虚拟环境

conda create -n bayesopt python=3.8

# 激活环境

conda activate bayesopt

```

环境配置完成后,可以开始编写代码,进行实际的优化操作。

## 3.2 贝叶斯优化的实战应用

### 3.2.1 优化目标函数定义

定义一个优化问题的目标函数是实施贝叶斯优化的第一步。目标函数应能计算并返回需要最小化的损失值。

```python

from hyperopt import fmin, tpe, hp, STATUS_OK, Trials

# 示例目标函数定义

def objective_function(params):

x = params['x']

y = params['y']

loss = x**2 + y**2 # 示例损失函数

return {'loss': loss, 'status': STATUS_O

```

0

0