Transformer模型在问答系统中的幕后推手:智能问答的秘密武器,解决你的疑难杂症

发布时间: 2024-07-19 23:20:33 阅读量: 92 订阅数: 52

# 1. Transformer模型的基本原理

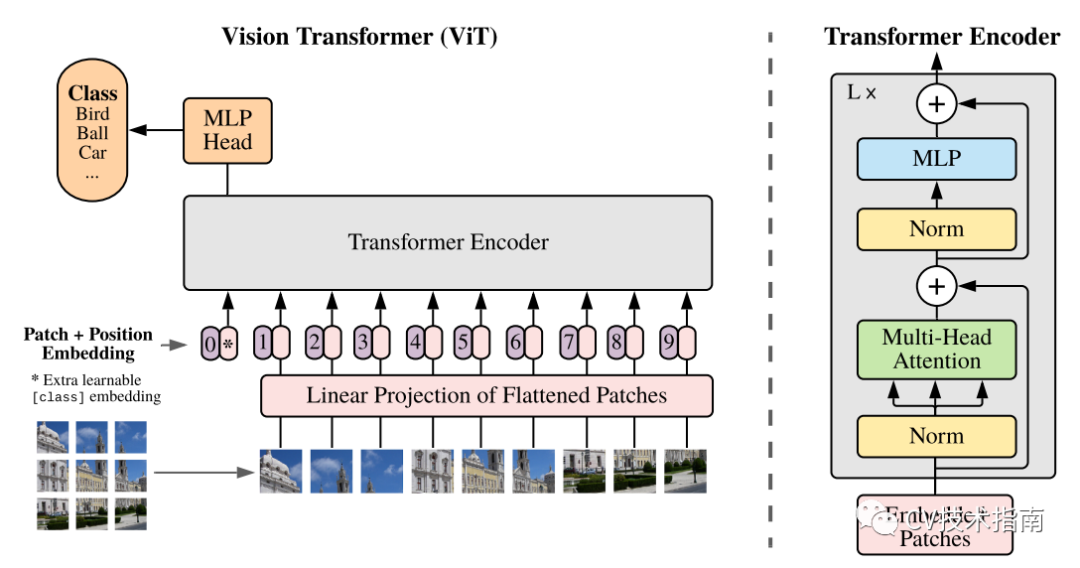

Transformer模型是一种基于注意力机制的神经网络架构,它在自然语言处理(NLP)任务中取得了突破性的进展。Transformer模型的基本原理如下:

- **自注意力机制:**Transformer模型利用自注意力机制来计算输入序列中每个元素与其他所有元素之间的关系,从而捕获序列中的长期依赖关系。

- **前馈网络:**自注意力机制之后,Transformer模型使用前馈网络来处理序列中的信息,提取更高层次的特征。

- **编码器-解码器架构:**Transformer模型通常采用编码器-解码器架构,其中编码器将输入序列转换为一个固定长度的向量,而解码器将该向量解码为输出序列。

# 2. Transformer模型在问答系统中的应用

Transformer模型在问答系统中发挥着至关重要的作用,它能够有效地处理文本数据,并生成高质量的答案。本章节将深入探讨Transformer模型在问答系统中的应用,包括其编码器和解码器架构、训练和调优策略。

### 2.1 Transformer模型的编码器和解码器

Transformer模型由编码器和解码器两个主要组件组成。编码器负责将输入文本序列转换为一个固定长度的向量表示,而解码器则利用该向量表示生成答案。

#### 2.1.1 自注意力机制

自注意力机制是Transformer模型的核心,它允许模型关注输入序列中的不同部分,并计算它们之间的关系。自注意力机制通过以下步骤计算:

```python

def self_attention(query, key, value):

"""

计算自注意力机制。

参数:

query: 查询向量。

key: 键向量。

value: 值向量。

返回:

注意力加权后的值向量的加和。

"""

# 计算查询和键之间的点积。

scores = torch.matmul(query, key.transpose(-1, -2))

# 将点积结果除以根号d_k进行缩放。

scores = scores / math.sqrt(query.size(-1))

# 应用softmax函数计算注意力权重。

weights = torch.softmax(scores, dim=-1)

# 将注意力权重与值向量相乘。

output = torch.matmul(weights, value)

return output

```

#### 2.1.2 前馈网络

前馈网络是Transformer模型中另一个重要的组件,它负责将编码器或解码器的输出向量转换为新的向量表示。前馈网络通常由两层全连接层组成,每层后面都跟着一个激活函数。

```python

def feed_forward(x):

"""

前馈网络。

参数:

x: 输入向量。

返回:

前馈网络的输出向量。

"""

# 第一层全连接层。

x = torch.nn.Linear(x.size(-1), d_ff)(x)

x = torch.nn.ReLU()(x)

# 第二层全连接层。

x = torch.nn.Linear(d_ff, x.size(-1))(x)

```

0

0