Transformer模型原理:深入剖析架构和机制,解锁模型核心秘密

发布时间: 2024-07-19 23:02:13 阅读量: 58 订阅数: 38

解码Transformer:深入探究模型的计算复杂度

# 1. Transformer模型概述

Transformer模型是一种革命性的神经网络架构,它在自然语言处理和计算机视觉等领域取得了突破性的进展。Transformer模型的核心思想是使用自注意力机制来捕获序列数据中的长距离依赖关系,从而克服了传统RNN和CNN模型的局限性。

Transformer模型由编码器和解码器组成。编码器将输入序列转换为一个固定长度的向量,而解码器使用该向量生成输出序列。自注意力机制允许模型在编码器和解码器中对序列中的每个元素进行加权,从而捕获序列中元素之间的重要关系。

Transformer模型具有以下优点:

* **并行化处理:**Transformer模型可以并行处理输入序列中的所有元素,这大大提高了训练和推理效率。

* **长距离依赖关系建模:**自注意力机制使Transformer模型能够捕获序列中元素之间的长距离依赖关系,这对于处理自然语言和计算机视觉等任务至关重要。

* **鲁棒性和泛化能力:**Transformer模型对输入序列的长度和顺序不敏感,这使其具有很强的鲁棒性和泛化能力。

# 2. Transformer架构

Transformer模型的核心架构由两个主要组件组成:自注意力机制和编码器-解码器结构。本章将深入剖析这些组件的原理和应用。

### 2.1 自注意力机制

自注意力机制是Transformer模型的关键创新,它允许模型专注于输入序列中的特定部分,并捕捉它们之间的关系。

#### 2.1.1 自注意力机制的原理

自注意力机制通过计算输入序列中每个元素与其他所有元素之间的相似度来工作。它使用三个矩阵:查询矩阵(Q)、键矩阵(K)和值矩阵(V)。

* **查询矩阵(Q):**将输入序列转换为查询向量,表示模型感兴趣的特征。

* **键矩阵(K):**将输入序列转换为键向量,表示输入序列中元素的特征。

* **值矩阵(V):**将输入序列转换为值向量,包含模型希望关注的信息。

自注意力机制计算过程如下:

1. **计算注意力权重:**将查询矩阵与键矩阵转置相乘,得到注意力权重矩阵。每个元素表示一个查询向量与一个键向量的相似度。

2. **归一化注意力权重:**对注意力权重矩阵进行softmax归一化,确保权重总和为 1。这将生成一个概率分布,表示查询向量对输入序列中每个元素的注意力。

3. **加权求和:**将注意力权重矩阵与值矩阵相乘,得到一个输出向量。该输出向量包含查询向量感兴趣的输入序列中元素的加权和。

#### 2.1.2 自注意力机制的应用

自注意力机制广泛应用于各种NLP任务,包括:

* **文本分类:**识别文本的主题或类别。

* **文本生成:**生成连贯、有意义的文本。

* **机器翻译:**将一种语言翻译成另一种语言。

### 2.2 编码器-解码器结构

Transformer模型采用编码器-解码器结构,用于处理序列到序列的任务。

#### 2.2.1 编码器模块

编码器模块负责将输入序列编码成一个固定长度的向量,称为上下文向量。它由多个自注意力层和前馈层组成。

* **自注意力层:**捕捉输入序列中元素之间的关系,生成一个表示输入序列中每个元素上下文的向量。

* **前馈层:**对自注意力层的输出进行非线性变换,进一步提取特征。

编码器模块通常堆叠多个层,以增强模型的表示能力。

#### 2.2.2 解码器模块

解码器模块负责将编码器生成的上下文向量解码成输出序列。它也由多个自注意力层和前馈层组成。

* **自注意力层:**捕捉输出序列中元素之间的关系,以及输出序列与上下文向量之间的关系。

* **前馈层:**对自注意力层的输出进行非线性变换,生成输出序列中的下一个元素。

解码器模块通常使用掩码自注意力层,以防止模型在解码过程中看到未来的元素。

**代码示例:**

```python

import torch

import torch.nn as nn

class TransformerEncoder(nn.Module):

def __init__(self, d_model, nhead, num_layers):

super().__init__()

self.encoder_layers = nn.ModuleList([nn.TransformerEncoderLayer(d_model, nhead) for _ in range(num_layers)])

def forward(self, src):

output = src

for layer in self.encoder_layers:

output = layer(output)

return output

class TransformerDecoder(nn.Module):

def __init__(self, d_model, nhead, num_layers):

super().__init__()

self.decoder_layers = nn.ModuleList([nn.TransformerDecoderLayer(d_model, nhead) for _ in range(num_layers)])

def forward(self, tgt, memory):

output = tgt

for layer in self.decoder_layers:

output = layer(output, memory)

return output

```

**逻辑分析:**

* `TransformerEncoder`类实现了编码器模块,其中包含多个`TransformerEncoderLayer`层。

* `TransformerDecoder`类实现了解码器模块,其中包含多个`TransformerDecoderLayer`层。

* `forward`方法执行编码或解码过程,并返回输出向量。

# 3. Transformer机制

Transformer模型的核心机制包括位置编码、残差连接和层归一化。这些机制对于Transformer模型的成功至关重要,它们共同作用,增强了模型的性能和稳定性。

#### 3.1 位置编码

**3.1.1 位置编码的原理**

位置编码是一个附加到输入序列中的向量,它为每个元素提供了其在序列中的相对位置信息。这对于Transformer模型来说至关重要,因为Transformer模型是基于位置无关的自注意力机制,该机制无法直接从输入序列中获取位置信息。

位置编码的公式如下:

```

PE(pos, 2i) = sin(pos / 10000^(2i/d_model))

PE(pos, 2i+1) = cos(pos / 10000^(2i/d_model))

```

其中:

* `pos` 是元素在序列中的位置

* `i` 是位置编码的维度

* `d_model` 是模型的维度

**3.1.2 位置编码的实现**

位置编码通常通过正弦和余弦函数来实现,如下所示:

```python

import math

def positional_encoding(pos, d_model):

"""

计算位置编码

参数:

pos: 元素在序列中的位置

d_model: 模型的维度

返回:

位置编码向量

"""

pe = np.zeros((pos, d_model))

for i in range(d_model):

if i % 2 == 0:

pe[:, i] = np.sin(pos / 10000^(2i/d_model))

else:

pe[:, i] = np.cos(pos / 10000^(2i/d_model))

return pe

```

#### 3.2 残差连接

**3.2.1 残差连接的原理**

残差连接是一种神经网络层,它将输入直接添加到层的输出中。这有助于解决深度神经网络中的梯度消失问题,梯度消失问题会阻止模型学习长距离依赖关系。

残差连接的公式如下:

```

output = layer(input) + input

```

其中:

* `layer` 是一个神经网络层

* `input` 是层的输入

* `output` 是层的输出

**3.2.2 残差连接的应用**

在Transformer模型中,残差连接被应用于编码器和解码器的每个子层中。这有助于模型学习长距离依赖关系,并提高模型的性能。

#### 3.3 层归一化

**3.3.1 层归一化的原理**

层归一化是一种归一化技术,它将神经网络层的输出归一化为均值为 0、方差为 1 的分布。这有助于稳定训练过程,并防止模型过拟合。

层归一化的公式如下:

```

output = (output - mean) / std

```

其中:

* `output` 是层的输出

* `mean` 是层的输出的均值

* `std` 是层的输出的标准差

**3.3.2 层归一化的应用**

在Transformer模型中,层归一化被应用于编码器和解码器的每个子层中。这有助于稳定训练过程,并提高模型的性能。

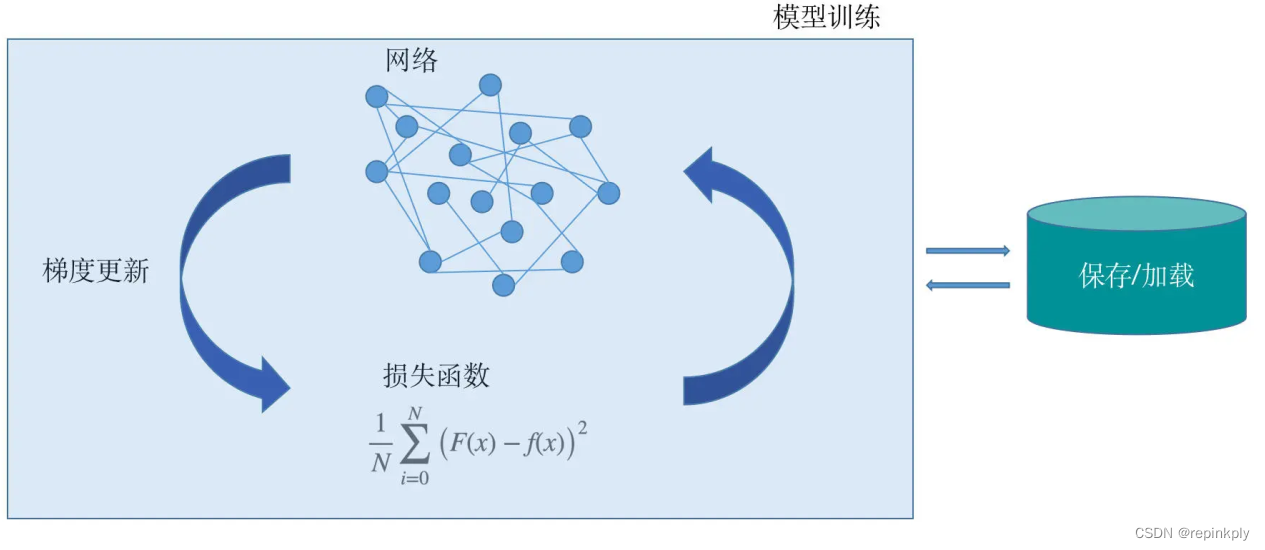

# 4. Transformer训练

### 4.1 训练目标

Transformer模型的训练目标因其应用场景而异。在自然语言处理任务中,常见的训练目标包括:

- **语言模型训练目标:**以预测序列中下一个单词为目标,训练模型学习语言的统计规律。

- **机器翻译训练目标:**以翻译源语言句子为目标语言句子为目标,训练模型学习语言之间的转换规则。

### 4.2 训练技巧

为了提高Transformer模型的训练效率和效果,研究人员提出了多种训练技巧:

- **梯度裁剪:**对梯度进行裁剪,防止梯度爆炸,保持模型稳定。

- **标签平滑:**在训练过程中,对标签进行平滑处理,降低模型对错误预测的惩罚,提高模型泛化能力。

### 4.3 训练过程

Transformer模型的训练过程一般分为以下步骤:

1. **数据预处理:**将原始数据转换为适合模型训练的格式,包括分词、词嵌入等。

2. **模型初始化:**初始化模型参数,通常使用正态分布或均匀分布。

3. **前向传播:**将输入数据输入模型,计算模型输出。

4. **计算损失:**计算模型输出与真实标签之间的损失,常见的损失函数包括交叉熵损失、平均平方误差等。

5. **反向传播:**根据损失函数计算模型参数的梯度。

6. **优化器更新:**使用优化器(如Adam、SGD)更新模型参数,减小损失。

7. **重复步骤3-6:**重复前向传播、计算损失、反向传播和优化器更新的过程,直到达到训练目标或达到最大训练轮数。

**代码块:**

```python

import torch

import torch.nn as nn

import torch.optim as optim

# 定义Transformer模型

model = TransformerModel()

# 定义损失函数

loss_function = nn.CrossEntropyLoss()

# 定义优化器

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 训练过程

for epoch in range(100):

for batch in train_data:

# 前向传播

output = model(batch)

# 计算损失

loss = loss_function(output, batch['label'])

# 反向传播

loss.backward()

# 优化器更新

optimizer.step()

```

**代码逻辑逐行解读:**

1. 导入必要的PyTorch库。

2. 定义Transformer模型。

3. 定义损失函数,此处使用交叉熵损失。

4. 定义优化器,此处使用Adam优化器。

5. 进入训练循环,共训练100个epoch。

6. 遍历训练数据中的每个批次。

7. 进行前向传播,计算模型输出。

8. 计算模型输出与真实标签之间的损失。

9. 进行反向传播,计算模型参数的梯度。

10. 使用优化器更新模型参数,减小损失。

**参数说明:**

- `model`:Transformer模型。

- `loss_function`:损失函数。

- `optimizer`:优化器。

- `epoch`:训练epoch数。

- `batch`:训练数据中的一个批次。

# 5. Transformer应用

Transformer模型在自然语言处理和计算机视觉领域取得了广泛的应用,其强大的表征能力和高效的计算性能使其成为解决各种复杂任务的理想选择。

### 5.1 自然语言处理

Transformer在自然语言处理领域表现出色,尤其是在文本分类和文本生成任务中。

#### 5.1.1 文本分类

文本分类是将文本片段分配到预定义类别中的任务。Transformer模型通过学习文本中的单词之间的关系,可以有效地提取文本特征并进行分类。

**代码示例:**

```python

import torch

from transformers import BertTokenizer, BertForSequenceClassification

# 加载预训练的BERT模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

# 对文本进行分词和编码

text = "这是文本分类的示例。"

input_ids = tokenizer.encode(text, return_tensors="pt")

# 将编码后的文本输入模型进行分类

outputs = model(input_ids)

logits = outputs.logits

# 获取分类结果

predicted_class = torch.argmax(logits, dim=-1)

```

**逻辑分析:**

* 使用预训练的BERT模型和分词器对文本进行分词和编码。

* 将编码后的文本输入到模型中进行分类。

* 获取模型输出的logits,并根据logits计算预测的类别。

#### 5.1.2 文本生成

文本生成是根据给定的提示或上下文生成新文本的任务。Transformer模型通过学习文本中单词之间的关系,可以生成连贯且语义合理的文本。

**代码示例:**

```python

import torch

from transformers import GPT2Tokenizer, GPT2LMHeadModel

# 加载预训练的GPT-2模型和分词器

tokenizer = GPT2Tokenizer.from_pretrained('gpt2')

model = GPT2LMHeadModel.from_pretrained('gpt2')

# 对提示进行分词和编码

prompt = "这是文本生成的示例。"

input_ids = tokenizer.encode(prompt, return_tensors="pt")

# 使用模型生成文本

outputs = model.generate(input_ids, max_length=100)

generated_text = tokenizer.decode(outputs[0], skip_special_tokens=True)

```

**逻辑分析:**

* 使用预训练的GPT-2模型和分词器对提示进行分词和编码。

* 将编码后的提示输入到模型中生成文本。

* 获取模型生成的文本,并对其进行解码以获得可读文本。

### 5.2 计算机视觉

Transformer模型在计算机视觉领域也取得了进展,尤其是在图像分类和目标检测任务中。

#### 5.2.1 图像分类

图像分类是将图像分配到预定义类别中的任务。Transformer模型通过学习图像中像素之间的关系,可以有效地提取图像特征并进行分类。

**代码示例:**

```python

import torch

from transformers import ViTModel, ViTForImageClassification

# 加载预训练的ViT模型和分词器

model = ViTModel.from_pretrained('vit-base-patch16-224')

classifier = ViTForImageClassification.from_pretrained('vit-base-patch16-224')

# 加载图像并将其转换为张量

image = Image.open("image.jpg")

image_tensor = torch.from_numpy(np.array(image)).permute(2, 0, 1).unsqueeze(0)

# 将图像张量输入模型进行分类

outputs = classifier(image_tensor)

logits = outputs.logits

# 获取分类结果

predicted_class = torch.argmax(logits, dim=-1)

```

**逻辑分析:**

* 使用预训练的ViT模型和分词器将图像转换为张量。

* 将图像张量输入到模型中进行分类。

* 获取模型输出的logits,并根据logits计算预测的类别。

#### 5.2.2 目标检测

目标检测是检测图像中目标并确定其位置的任务。Transformer模型通过学习图像中像素之间的关系,可以有效地定位和识别目标。

**代码示例:**

```python

import torch

from transformers import DETRModel, DETRForObjectDetection

# 加载预训练的DETR模型和分词器

model = DETRModel.from_pretrained('detr-resnet-50')

detector = DETRForObjectDetection.from_pretrained('detr-resnet-50')

# 加载图像并将其转换为张量

image = Image.open("image.jpg")

image_tensor = torch.from_numpy(np.array(image)).permute(2, 0, 1).unsqueeze(0)

# 将图像张量输入模型进行目标检测

outputs = detector(image_tensor)

boxes = outputs.pred_boxes

scores = outputs.pred_logits

# 获取目标检测结果

for box, score in zip(boxes, scores):

if score > 0.5:

# 绘制目标检测框

draw_bounding_box(image, box)

```

**逻辑分析:**

* 使用预训练的DETR模型和分词器将图像转换为张量。

* 将图像张量输入到模型中进行目标检测。

* 获取模型输出的预测边界框和预测分数。

* 根据预测分数筛选出置信度较高的目标检测结果,并绘制目标检测框。

# 6. Transformer发展趋势**

Transformer模型自提出以来,不断发展和创新,涌现出各种新的趋势和架构。

**6.1 大规模Transformer模型**

随着计算能力的提升和数据集的不断扩大,大规模Transformer模型成为研究热点。这些模型拥有数十亿甚至上千亿的参数,能够处理海量文本数据,展现出强大的语言理解和生成能力。

**6.1.1 GPT-3**

GPT-3(Generative Pre-trained Transformer 3)是OpenAI开发的大规模语言模型,拥有1750亿个参数。它在各种自然语言处理任务上表现出色,包括文本生成、翻译、问答和对话生成。

**6.1.2 Switch Transformer**

Switch Transformer是微软开发的大规模Transformer模型,拥有1.6万亿个参数。它采用了一种新的架构,将注意力机制与稀疏矩阵乘法相结合,提高了模型的训练效率和推理速度。

**6.2 Transformer的创新架构**

除了大规模模型之外,研究人员还提出了各种创新性的Transformer架构,以解决特定任务的挑战。

**6.2.1 Longformer**

Longformer是一种专门为处理长序列文本设计的Transformer架构。它通过引入局部注意力机制和滑动窗口机制,能够有效处理数千甚至数万个单词的文本序列。

**6.2.2 Reformer**

Reformer是一种基于注意力机制和局部敏感哈希(LSH)的Transformer架构。它通过将注意力机制与LSH相结合,降低了计算复杂度,提高了模型的训练速度和推理效率。

0

0