【R语言中文分词与文本分析】:chinesemisc包的高级技巧与案例剖析

发布时间: 2024-11-06 21:34:57 阅读量: 29 订阅数: 25

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 1. R语言中文分词与文本分析概述

## 1.1 R语言在文本分析中的角色

R语言作为一种优秀的统计分析工具,它在文本分析领域也拥有独特的优势。R语言不仅提供了丰富的文本处理库,还支持复杂的数据分析和可视化,使研究者能够高效地执行从预处理到结果展示的完整流程。在处理中文数据时,利用R语言能够完成诸如分词、词性标注、文本挖掘等任务。

## 1.2 中文分词的重要性

中文文本处理的一个关键步骤是分词,即将连续的文本切分成单独的词或词汇单元。由于中文与英文的差异,中文分词不像英文那样有空格天然分隔,因此需要借助特定的算法和词库。中文分词对于后续的文本分析和数据挖掘至关重要,是进行精确文本分析的基础。

## 1.3 文本分析的应用场景

文本分析在多个行业领域都有广泛应用,例如舆情监控、情感分析、市场调研、推荐系统等。通过分析文本中的关键词汇、主题趋势、用户情感等信息,可以为决策提供数据支持,发现潜在的机会或风险。文本分析技术的进步正逐步深化其在商业智能和数据科学中的作用。

# 2. chinesemisc包基础

在现代数据分析中,处理中文文本数据是不可或缺的一环。R语言作为一门强大的统计计算和图形展现语言,在文本分析领域同样有其用武之地。本章,我们将深入探讨chinesemisc包在R语言中的应用,引导读者一步步建立中文分词和文本分析的基础。

## 2.1 安装与配置chinesemisc包

### 2.1.1 R语言环境的搭建

在开始之前,确保您的系统已经安装了R语言和相应的开发环境。根据操作系统的不同,R语言的安装方式也有所不同。在Windows上,可以从R语言官方网站下载安装程序;在Mac和Linux系统中,可以通过包管理器(如Homebrew或apt-get)安装。

安装R语言后,您还需要安装RStudio或者其他支持的IDE(集成开发环境),这样可以更方便地编写、运行和调试R代码。完成这些之后,打开RStudio或您的IDE,开始构建您的项目。

### 2.1.2 chinesemisc包的安装与加载

在R环境中,包是可复用的代码单元,用于扩展R的功能。chinesemisc包是专为中文文本处理而设计的R包,涵盖了分词、词性标注、命名实体识别等功能。安装chinesemisc包前,需要确保已经安装了Rtools和Java JDK,因为部分功能依赖于Java。

在R控制台输入以下命令来安装chinesemisc包:

```r

install.packages("chinesemisc")

```

安装完成后,通过以下命令加载该包:

```r

library(chinesemisc)

```

加载chinesemisc包后,您可以查看包提供的帮助文档来了解各个函数的使用方法:

```r

?chinesemisc

```

接下来,让我们深入了解chinesemisc包的基本用法,从中文分词开始。

## 2.2 chinesemisc包的基本用法

### 2.2.1 分词的实现方式

在中文文本处理中,分词是至关重要的一步。由于中文没有空格作为词的分隔,需要通过算法将连续的句子分割成有意义的词序列。chinesemisc包提供了多种分词算法供用户选择。

最简单的分词实现方法是使用`segment`函数:

```r

text <- "欢迎来到R语言的世界"

result <- segment(text, method = "HanLP")

print(result)

```

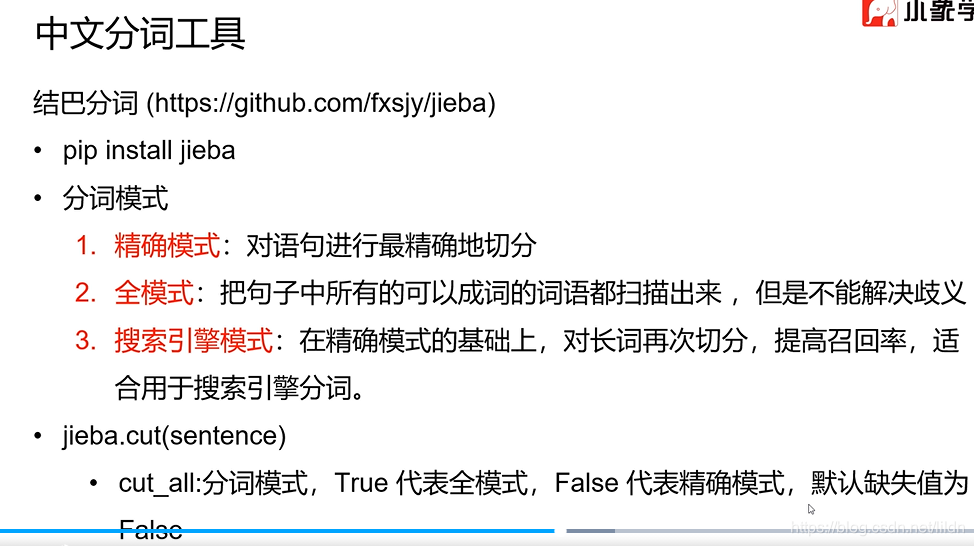

上述代码将使用HanLP算法对给定的中文字符串进行分词。`segment`函数具有多种参数,例如`method`参数用于指定分词算法。目前chinesemisc支持的分词算法包括但不限于`jieba`、`THULAC`、`HanLP`等。

### 2.2.2 基本文本处理函数介绍

除了分词,chinesemisc包还提供了一系列文本处理函数,如词频统计、词性标注、文本清洗等。这些功能对于深入分析文本内容至关重要。

例如,我们可以通过以下代码进行词频统计:

```r

text <- "R语言是一种编程语言,它专注于统计分析和图形表示。"

# 分词

seg_list <- segment(text, method = "HanLP")

# 统计词频

word_freq <- table(seg_list)

print(word_freq)

```

以上代码首先使用`segment`函数对一段中文文本进行分词,然后通过`table`函数统计每个词的出现频率。输出的`word_freq`是一个表格,显示了各词出现的次数。

这仅为chinesemisc包功能的一个简单演示,该包还包含其他多种函数,可用来处理更复杂的中文文本分析任务。下面,我们将深入探讨chinesemisc包的高级应用。

# 3. chinesemisc包深度应用

## 3.1 中文分词高级技巧

### 3.1.1 自定义词典的使用

在中文文本处理领域,自定义词典的使用是提升分词准确性的关键步骤之一。chinesemisc包提供了灵活的自定义词典支持,允许用户根据具体应用场景引入专业术语或特定词汇。通过这种方式,可以有效处理专业文本中的固有名词、行业术语等,从而提高分词质量。

自定义词典的使用通常包括以下几个步骤:

1. 准备自定义词典文件:首先,需要创建一个包含自定义词汇的文本文件,每个词汇占据一行。

2. 加载自定义词典:在R环境中,使用chinesemisc包提供的相关函数加载自定义词典文件。

3. 进行分词处理:加载自定义词典后,使用分词函数对文本数据进行分词处理,chinesemisc包会结合内置词典和自定义词典进行分词。

下面是一个简单的代码示例:

```r

# 加载chinesemisc包

library(chinesemisc)

# 自定义词典路径设置

custom_dict_path <- "path/to/custom_dict.txt"

# 加载自定义词典

load_custom_dict(custom_dict_path)

# 示例文本

text <- "华为是全球领先的信息与通信技术解决方案供应商。"

# 使用分词函数

tokens <- segment_text(text)

# 输出分词结果

print(tokens)

```

### 3.1.2 词性标注与命名实体识别

词性标注(Part-of-Speech Tagging, POS Tagging)是指在分词的基础上,标注每个词的词性,如名词、动词等。命名实体识别(Named Entity Recognition, NER)是识别文本中具有特定意义的实体,如人名、地名、机构名等。这两项技术在深度文本分析中占有重要地位。

chinesemisc包中集成了词性标注和命名实体识别的功能,可以通过相关函数直接调用。使用这些功能不仅可以提高文本分析的深度,还可以在情感分析、文本摘要、问答系统等自然语言处理任务中发挥重要作用。

下面是一个词性标注和命名实体识别的代码示例:

```r

# 加载chinesemisc包

library(chinesemisc)

# 示例文本

text <- "华为创始人任正非表示,公司业务将保持增长。"

# 词性标注

pos_tags <- pos_tagging(text)

# 命名实体识别

ner_results <- named_entity_recognition(text)

# 输出结果

print(pos_tags)

print(ner_results)

```

词性标注和命名实体识别的参数和返回值,用户可以详细查阅相关文档,了解各参数的具体含义和使用方法。

## 3.2 文本分析的进阶方法

### 3.2.1 文本相似度计算

文本相似度计算是衡量两个或多个文本之间相似程度的技术,对于文本分类、摘要、推荐系统等应用非常重要。在chinesemisc包中,可以使用余弦相似度、Jaccard相似度等多种算法进行文本相似度的计算。

文本相似度计算的步骤通常包括:

1. 文本预处理:包括分词、去除停用词、词干提取等。

2. 构建向量表示:将文本转换为向量空间模型中的向量。

3. 计算相似度:应用相似度计算方法得到文本间的相似度分数。

以下是一个计算两段文本相似度的示例代码:

```r

# 加载chinesemisc包

library(chinesemisc)

# 示例文本

text1 <- "华为是全球领先的信息与通信技术解决方案供应商。"

text2 <- "华为公司致力于为全球客户提供先进的信息通信技术服务。"

# 文本分词和预处理

processed_text1 <- segment_text(text1)

processed_text2 <- segment_text(text2)

# 文本向量化

vector1 <- text_to_vector(processed_text1)

vector2 <- text_to_vector(processed_text2)

# 计算余弦相似度

cosine_similarity <- cosine_similarity(vector1, vector2)

# 输出相似度分数

print(cosine_similarity)

```

### 3.2.2 主题模型与词云生成

主题模型(Topic Modeling)是一种通过文本数据挖掘发现其隐含主题的技术。主题模型能够从文本集合中发现隐含的语义结构,从而理解文本中包含的主题。chinesemisc包提供了LDA(Latent Dirichlet Allocation)主题模型实现。

同时,主题模型的结果常常通过词云图进行可视化展示。词云图是一种将文本中高频词汇以视觉上显著的形式展现出来的图形表示方法,它可以帮助用户快速识别文本中的核心主题。

以下是一个使用LDA主题模型和生成词云

0

0