MATLAB深度学习进阶宝典:构建复杂深度学习模型,探索AI前沿

发布时间: 2024-06-09 10:26:02 阅读量: 95 订阅数: 39

# 1. MATLAB深度学习基础**

MATLAB是一种强大的技术计算语言,它提供了广泛的深度学习功能。本章将介绍MATLAB深度学习的基础知识,包括:

- MATLAB深度学习工具箱概述

- MATLAB深度学习工作流

- 创建和训练深度学习模型的步骤

# 2. 深度学习模型构建

### 2.1 卷积神经网络(CNN)

#### 2.1.1 CNN的架构和原理

卷积神经网络(CNN)是一种深度神经网络,专门用于处理网格状数据,如图像和视频。CNN的架构由一系列卷积层、池化层和全连接层组成。

卷积层应用卷积运算符在输入数据上滑动,提取特征。卷积运算符由一个可学习的内核组成,它与输入数据中的局部区域进行卷积。卷积操作的结果是一个特征图,其中每个元素表示输入数据中相应区域的特征。

池化层通过对特征图中的相邻元素进行聚合,减少特征图的大小。池化操作可以是最大池化或平均池化。最大池化选择特征图中最大值,而平均池化计算特征图中元素的平均值。

全连接层将卷积层和池化层提取的特征连接起来,并使用全连接操作符对这些特征进行分类或回归。

#### 2.1.2 CNN的层类型和参数

CNN由各种层类型组成,每种层类型都有特定的参数:

- **卷积层:**

- 内核大小:内核在输入数据上的大小。

- 步长:内核在输入数据上滑动的步长。

- 填充:在输入数据周围填充零值的数量。

- 激活函数:应用于卷积运算结果的非线性函数。

- **池化层:**

- 池化大小:池化操作的窗口大小。

- 步长:池化操作的步长。

- 池化类型:最大池化或平均池化。

- **全连接层:**

- 节点数:全连接层中神经元的数量。

- 激活函数:应用于全连接运算结果的非线性函数。

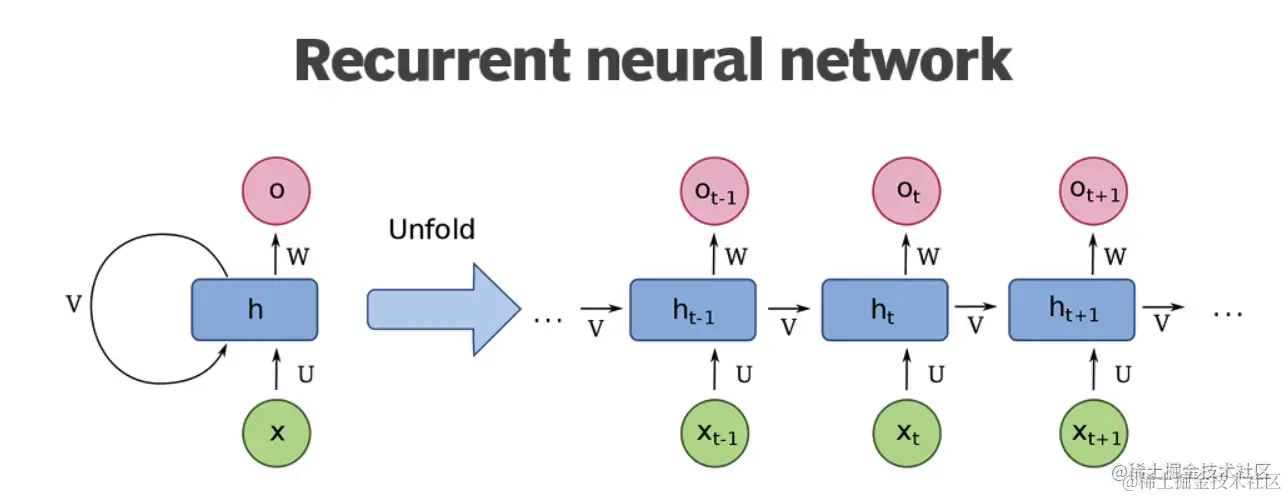

### 2.2 循环神经网络(RNN)

#### 2.2.1 RNN的架构和原理

循环神经网络(RNN)是一种深度神经网络,专门用于处理序列数据,如文本和时间序列。RNN的架构由一系列循环层组成,每个循环层都包含一个循环单元。

循环单元接收来自前一个循环单元的隐藏状态和当前输入,并更新其隐藏状态。隐藏状态包含了序列中到目前为止处理过的信息的摘要。

RNN可以处理可变长度的序列,并且能够学习序列中的长期依赖关系。

#### 2.2.2 RNN的变体:LSTM和GRU

LSTM(长短期记忆网络)和GRU(门控循环单元)是RNN的变体,它们通过引入门控机制来解决RNN中的梯度消失和梯度爆炸问题。

- **LSTM:** LSTM使用三个门控机制:输入门、忘记门和输出门。输入门控制新信息进入细胞状态,忘记门控制细胞状态中现有信息的遗忘,输出门控制细胞状态中信息的输出。

- **GRU:** GRU使用两个门控机制:更新门和重置门。更新门控制细胞状态的更新,重置门控制细胞状态中现有信息的遗忘。

### 2.3 Transformer神经网络

#### 2.3.1 Transformer的架构和原理

Transformer神经网络是一种深度神经网络,专门用于处理序列数据,如文本和代码。Transformer的架构由编码器和解码器组成。

编码器将输入序列转换为一组向量,称为键值对。解码器使用这些键值对生成输出序列。

Transformer使用注意力机制,它允许模型专注于输入序列中与当前输出位置相关的部分。

#### 2.3.2 Transformer的注意力机制

注意力机制是一种计算输入序列中每个元素对输出序列中每个元素重要性的方法。Transformer使用两种类型的注意力机制:

- **自注意力:** 计算输入序列中每个元素与自身重要性的注意力。

- **编码器-解码器注意力:** 计算编码器输出序列中每个元素与解码器输入序列中每个元素重要性的注意力。

# 3. 深度学习模型训练**

### 3.1 训练数据集和数据预处理

深度学习模型的性能高度依赖于训练数据集的质量和多样性。训练数据集应包含大量标记良好的数据,以涵盖模型将遇到的真实世界情况。数据预处理是训练过程中的一个关键步骤,它涉及对数据进行转换和清理,以使其适合模型训练。常见的预处理技术包括:

- **数据标准化和归一化:** 将数据缩放或转换到特定范围,以改善模型收敛性。

0

0