【教育领域中的pygments.lexer应用】:开发代码教学工具的策略

发布时间: 2024-10-17 20:54:06 阅读量: 26 订阅数: 28

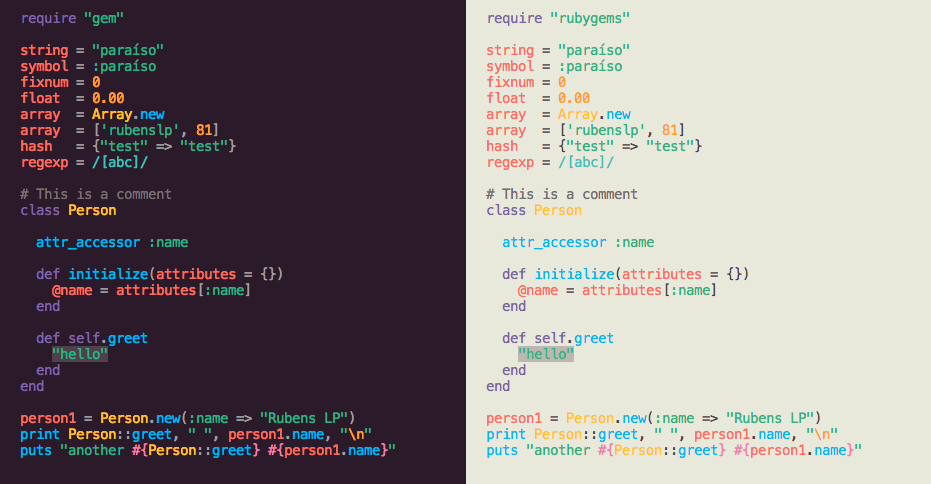

pygments.rb:for Pygments语法荧光笔的Ruby包装器

# 1. Pygments.lexer在代码教学中的重要性

在现代的代码教学中,Pygments.lexer扮演了一个重要的角色,它不仅能够帮助教师更好地展示和讲解代码,还能显著提升学生的学习体验。通过高亮显示和语法解析功能,Pygments.lexer能够将代码结构清晰地展示给学生,使他们更容易理解复杂的代码逻辑和语法。此外,Pygments.lexer的定制化功能使得教师可以根据教学需要调整和优化代码的展示方式,提供更加个性化和适应性的教学内容。总之,Pygments.lexer是代码教学中不可或缺的工具,它在提升教学质量和效率方面具有显著的作用。

## 2.1 Pygments.lexer的定义和作用

### 2.1.1 解析器的分类和选择

Pygments库通过一系列的解析器(Lexers),也被称为词法分析器,将文本识别为不同类型的标记。这些标记通常包括关键字、标识符、字面量、运算符和其他符号。选择合适的解析器对于正确地展示代码至关重要。例如,在教学Python代码时,选择Python解析器可以保证正确的语法高亮和代码结构解析。开发者应根据需要展示的编程语言选择相应的解析器,以确保代码的正确理解和展示。

# 2. Pygments.lexer的基础理论知识

## 2.1 Pygments.lexer的定义和作用

### 2.1.1 解析器的分类和选择

解析器是编程语言处理的关键组件,负责将源代码分解成一系列的标记(tokens),这些标记随后将被用于代码的不同处理阶段。在Pygments库中,解析器主要分为两类:内置解析器和自定义解析器。内置解析器由Pygments自带,覆盖了常见的编程语言,如Python、C、Java等;自定义解析器则是通过继承内置解析器类来创建,以支持新的或未被内置支持的编程语言。

选择合适的解析器对于代码高亮和语法分析至关重要。内置解析器通常能满足大多数需求,但在面对特殊或新兴语言时,开发自定义解析器就显得十分必要。开发者需要根据实际需要进行选择:

- **内置解析器**:选择标准库中已经提供的解析器。它们通常经过优化,执行效率较高,且维护成本低。

- **自定义解析器**:当内置解析器无法满足特定需求时,可以通过继承`lexers.Lexer`类,实现自定义的解析逻辑。

### 2.1.2 Pygments.lexer的安装和配置

为了使用Pygments.lexer,首先需要确保Pygments库已经安装在你的系统中。可以通过pip进行安装:

```bash

pip install pygments

```

接下来,你可以通过Python的交互式解释器来测试安装是否成功:

```python

from pygments import lexers, highlight, formatters

from pygments.lexers import PythonLexer

from pygments.formatters import TerminalTrueColorFormatter

# 获取一段Python代码

code = 'print("Hello, Pygments!")'

# 对代码进行高亮处理

result = highlight(code, PythonLexer(), TerminalTrueColorFormatter())

# 打印高亮后的结果

print(result)

```

如果一切正常,你应该看到在终端中打印出了带有语法高亮的“Hello, Pygments!”。

在配置Pygments时,一个常见的需求是使用不同的输出格式。Pygments支持多种输出格式,包括HTML、LaTeX和ANSI颜色。这可以通过选择不同的`formatters`来实现:

```python

# HTML格式输出

html_result = highlight(code, PythonLexer(), formatters.HtmlFormatter(full=True))

print(html_result)

```

### 2.2 Pygments.lexer的基本语法和规则

#### 2.2.1 词法分析的工作原理

词法分析是编译过程中的第一步,它的任务是读入源程序的字符序列,将它们组织成有意义的词素序列。在Pygments中,这一过程由`Lexer`类完成。一个`Lexer`实例将源代码字符串分解为一个个的`Token`对象。每个`Token`对象包含了词素的类型信息以及词素的文本内容。例如,在解析Python代码时,`def`关键字将被识别为一个`Keyword`类型的`Token`。

词法分析器通常包含以下步骤:

1. **去除空白和注释**:源代码中的空格、制表符、换行符等空白字符通常在词法分析阶段被忽略。注释也会被去除,除非它们对词法分析有特殊含义。

2. **识别词素**:通过匹配词法规则,词法分析器将源代码的字符序列分解成词素,每个词素都对应一个`Token`。

3. **分类标记**:每个`Token`都属于一个类别,比如关键字、标识符、字符串等。

#### 2.2.2 关键字、标识符和运算符的解析

- **关键字(Keywords)**:编程语言预定义的保留字,例如Python中的`def`、`if`、`else`等。Pygments通过预定义的关键词列表对它们进行匹配。

- **标识符(Identifiers)**:程序员自定义的变量名、函数名等。Pygments通过标识符的命名规则进行匹配。

- **运算符(Operators)**:编程语言中定义的运算符,如`+`、`-`、`=`等。Pygments通常有专门的规则来匹配这些字符序列。

以下是一个简单的词法分析器的伪代码,用于解析一个假设的简单语言中的标识符、关键字和运算符:

```python

# 假设的简单语言词法规则

rules = {

'keywords': ['if', 'else', 'while', 'for'],

'operators': ['+', '-', '*', '/'],

'identifiers': '[a-zA-Z_][a-zA-Z0-9_]*'

}

# 伪代码实现

def tokenize(code):

tokens = []

words = code.split()

for word in words:

if word in rules['keywords']:

tokens.append(Token('Keyword', word))

elif word in rules['operators']:

tokens.append(Token('Operator', word))

elif re.match(rules['identifiers'], word):

tokens.append(Token('Identifier', word))

return tokens

# Token类定义

class Token:

def __init__(self, type, value):

self.type = type

self.value = value

# 示例代码字符串

code = "if x < 10 and y > 5: x = x + 1"

# 调用tokenize函数

tokens = tokenize(code)

for token in tokens:

print(token)

```

#### 2.2.3 文法规则和扩展方法

词法分析器的文法规则定义了如何将源代码文本分割成一系列标记。这些规则通常表达为正则表达式,使词法分析器能够准确地识别不同类型的标记。Pygments通过定义`Lexers`类中的`get_tokens_unprocessed()`方法,允许用户通过正则表达式来匹配和定义特定类型的标记。

除了内置规则之外,Pygments还支持用户自定义文法规则,以扩展和修改现有的词法分析行为。这通常是通过继承一个现有的`Lexer`类,并重写其`get_tokens_unprocessed()`方法来实现的。在自定义规则中,用户可以:

- 使用正则表达式匹配特定的模式。

- 利用捕获组捕获模式的部分或全部,并将其作为`Token`返回。

- 处理复杂的词法分析情景,例如多行字符串或注释块。

```python

from pygments.lexers._mapping import LEXERS

from pygments.lexers.python import PythonLexer

# 继承现有PythonLexer并重写get_tokens_unprocessed方法

class ExtendedPythonLexer(PythonLexer):

def get_tokens_unprocessed(self, text):

# 针对自定义文法规则进行处理

for value, lexeme, typ in super().get_tokens_unprocessed(text):

# 例如,改变数字的类型为自定义类型Number

if typ == 'Number':

yield value, lexeme, 'Number'

else:

yield value, lexeme, typ

# 注册新的lexer

LEXERS['ExtendedPython'] = ExtendedPythonLexer

# 使用新的lexer进行高亮处理

lexer = lexers.get_lexer_by_name('ExtendedPython')

re

```

0

0