【数据分析中的代码高亮】:pygments.lexer与数据可视化的结合

发布时间: 2024-10-17 20:35:59 阅读量: 14 订阅数: 17

# 1. Pygments.lexer在数据分析中的应用基础

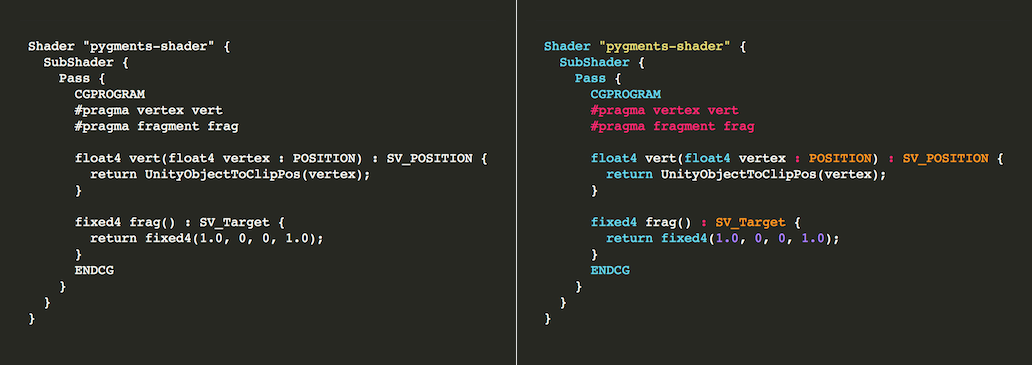

## 1.1 数据分析中代码展示的需求

在数据分析过程中,代码展示对于信息共享和结果复现至关重要。正确地展示代码不仅可以提升数据报告的清晰度,还能便于同行审查与协作。Pygments.lexer提供了一种优雅的代码高亮解决方案,它通过词法分析将代码文本转化为易于阅读的格式,增强数据报告的可读性和专业性。

## 1.2 Pygments.lexer简介

Pygments是一个广泛使用的Python代码高亮库,其核心是lexer,它负责对源代码进行词法分析,将不同类型的代码元素用不同的颜色或样式进行区分。Pygments支持多种编程语言,并允许用户自定义词法分析规则,使其在数据分析和可视化的应用中具备极大的灵活性和适用性。

## 1.3 使用Pygments.lexer的基本步骤

要开始使用Pygments.lexer,首先需要安装Pygments库。在Python环境中,可以通过pip安装Pygments:

```python

pip install pygments

```

然后,可以使用Pygments提供的API来获取高亮后的代码片段。以下是一个简单的示例,展示如何对Python代码进行高亮:

```python

from pygments import highlight

from pygments.lexers import PythonLexer

from pygments.formatters import HtmlFormatter

code = "print('Hello, Pygments!')"

formatted_code = highlight(code, PythonLexer(), HtmlFormatter(full=True))

print(formatted_code)

```

在这段代码中,`PythonLexer()`指定了使用的语言解析器,`HtmlFormatter()`定义了输出格式。通过这种方式,我们可以轻松地在数据分析结果中展示格式化的代码片段,提高报告的专业性和可读性。

# 2. Pygments.lexer深入解析

## 2.1 Pygments.lexer的词法分析原理

### 2.1.1 词法分析的基本概念

词法分析是编译过程的第一阶段,它将源代码文本拆分成一系列的记号(tokens)。记号可以是关键字、标识符、字面量、运算符等等。在编程语言处理中,Pygments.lexer扮演着重要的角色,通过将源代码字符串转换为一系列的记号来实现代码的词法分析。

Pygments库是Python中最流行的源代码高亮库,它由多个基于Python的组件组成,其中包括一个强大的词法分析器。Pygments.lexer模块使用一系列的正则表达式规则来匹配源代码中的模式,生成相应的记号。

### 2.1.2 词法分析器的构建和工作流程

构建一个词法分析器通常涉及以下几个步骤:

1. **定义记号类型**:为每种记号定义一个唯一的类型,例如关键字、注释、字符串字面量等。

2. **编写正则表达式规则**:为每种记号类型编写匹配源代码的正则表达式规则。

3. **构建状态机**:根据规则构建一个有限状态自动机(DFA或NFA),用于遍历源代码并匹配不同的记号。

4. **生成记号流**:遍历代码文本并使用状态机匹配规则,生成记号流。

Pygments.lexer在处理源代码时,会根据预定义的规则集进行扫描,识别记号,并将这些记号以有序的方式输出。最终,记号流可以被进一步用于语法分析或直接用于代码高亮显示。

### 2.1.3 Pygments.lexer中的高级特性

Pygments.lexer不仅提供了标准的词法分析功能,它还包含了一些高级特性,如:

- **自定义和扩展**:开发者可以根据需要添加新的记号类型或修改现有规则。

- **多种语言支持**:它内置支持多种编程语言,并允许用户为新语言编写或导入词法分析器。

- **灵活的输出格式**:除了生成记号流,Pygments.lexer还支持输出为多种格式,如HTML、LaTeX、ANSI等,用于不同的展示需求。

- **性能优化**:对于性能要求较高的应用,Pygments.lexer可以进行性能优化,以提高处理速度。

## 2.2 Pygments.lexer的定制化使用

### 2.2.1 定制词法分析器的方法

定制化词法分析器是Pygments的一个重要特性。要定制一个词法分析器,开发者需要:

1. **继承BaseLexer**:从Pygments的基类BaseLexer继承一个新类。

2. **定义规则集**:在新类中定义一组规则,这些规则包含正则表达式,用于匹配特定的记号类型。

3. **修改构造函数**:如果需要,可以在构造函数中添加额外的初始化代码。

4. **实现方法**:实现或重写如`get_tokens_unprocessed`等方法,以自定义处理逻辑。

### 2.2.2 词法分析器的优化策略

词法分析器的性能优化策略包括:

- **减少正则表达式的复杂性**:避免使用过于复杂的正则表达式,以减少匹配所需的时间。

- **使用预编译的正则表达式**:在词法分析器加载时预先编译正则表达式。

- **利用内置优化**:Pygments为常见模式提供了优化,如单词边界匹配、忽略空白等。

- **定制匹配规则**:针对应用的特定需求,优化或简化匹配规则集。

### 2.2.3 自定义词法规则的案例分析

考虑一个简单的Python词法分析器,我们想要新增一个记号类型来高亮显示自定义的注释。我们可以创建如下的词法分析器:

```python

from pygments.lexer import RegexLexer, bygroups, include

from pygments.token import Comment, Name, String

class CustomLexer(RegexLexer):

name = 'CustomLexer'

aliases = ['custom']

filenames = ['*.custom']

tokens = {

'root': [

(r'#.*', Comment.Single),

(r'(\s*)(\w+)(\s*)', bygroups(Text.Whitespace, Name.Variable, Text.Whitespace)),

(r'".*?"', String),

# 更多规则...

]

}

```

上面的代码定义了一个新的`CustomLexer`类,它识别自定义的注释、变量名和字符串。通过`bygroups`方法,我们可以将多个规则组合起来,同时应用到匹配的记号上。

## 2.3 Pygments.lexer与数据分析工具的集成

### 2.3.1 集成到数据分析环境的准备工作

集成Pygments.lexer到数据分析环境通常需要以下几个步骤:

1. **环境准备**:安装Pygments库以及所需的语言定义文件。

2. **确定集成点**:分析数据分析工具的工作流程,确定集成Pygments的最佳位置。

3. **编写适配代码**:根据工具的架构编写适配代码,以将Pygments.lexer集成到流程中。

### 2.3.2 Pygments.lexer在数据分析工具中的应用

将Pygments.lexer集成到数据分析工具中,可能涉及到以下应用方式:

- **代码展示**:在报告或分析结果中展示源代码及其高亮显示。

- **数据输入**:在输入阶段通过Pygments.lexer对用户输入的代码进行快速检查和验证。

- **脚本执行**:使用Pygments.lexer高亮执行脚本的输出,以提高输出的可读性。

### 2.3.3 实际案例:Pygments.lexer在Jupyter Notebook中的应用

Jupyter Notebook是一个流行的交互式计算环境,适用于数据分析、机器学习等领域。要在Jupyter Notebook中应用Pygm

0

0