模型优化的量化革命:PyTorch量化方法全面解析与实践

发布时间: 2024-12-11 21:48:00 阅读量: 26 订阅数: 17

实现SAR回波的BAQ压缩功能

# 1. 模型优化的量化革命概述

## 概述

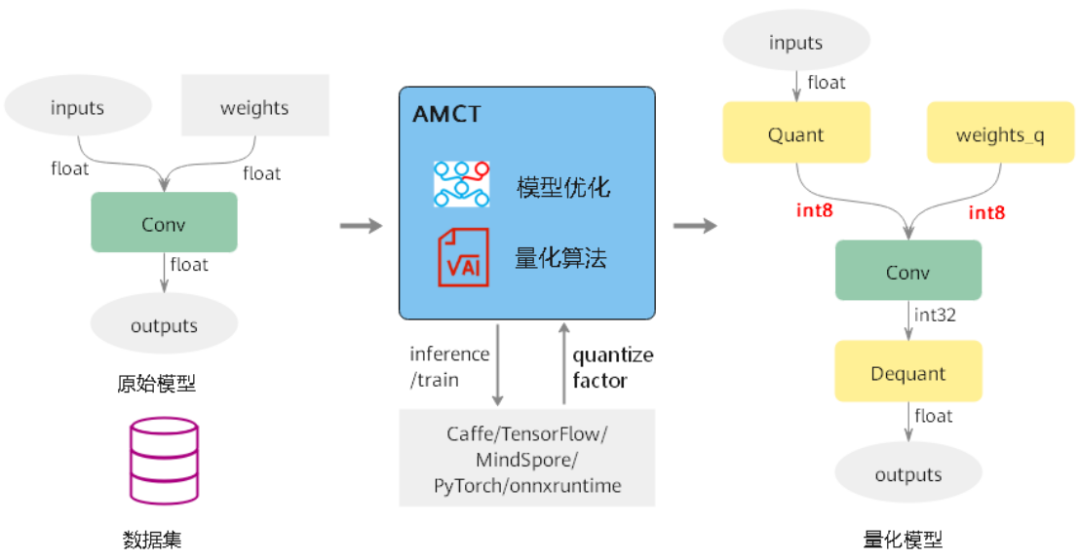

在人工智能领域,深度学习模型通常需要大量的计算资源和内存消耗,这在许多应用场景中显得过于昂贵和不切实际。随着技术的发展,量化技术应运而生,它以牺牲一定的精度为代价,大幅减少模型大小,并提升运行速度和能效。这一技术革新被称为模型优化的量化革命。

## 量化技术的定义

量化技术是一种将模型权重和激活从浮点数转换为整数的方法,通过减少数据精度来降低计算复杂度和内存占用。这种转换需要精确控制,以保持模型的性能在可接受的范围内。

## 量化与模型性能的关系

虽然量化可能造成精度损失,但经过优化的量化方法可以最小化这些损失。更重要的是,量化带来了模型压缩、速度提升和能耗降低等显著优势,对于部署到边缘设备或移动平台的模型尤其重要。

## 量化技术的应用前景

随着硬件和软件技术的进步,量化技术将更加广泛地应用于各种AI场景,成为提高深度学习模型实用性和普及性的关键技术。量化不仅对性能优化至关重要,而且对于推动AI技术在工业界的落地实施起着不可或缺的作用。

# 2. PyTorch量化基础

### 2.1 量化的核心概念与背景

#### 2.1.1 量化技术的定义和分类

在深入探讨PyTorch的量化技术之前,首先需要明确量化技术的定义和分类。量化技术是一种减少深度学习模型参数和计算需求的方法,通过将浮点数精度的数值转换为更低位宽的整数来实现。这种技术可以显著减少模型大小和提高计算效率,对于部署在资源受限的平台(如移动设备和边缘计算设备)尤其有价值。

量化技术可以分为两类:后训练量化(Post-Training Quantization, PTQ)和量化感知训练(Quantization-Aware Training, QAT)。PTQ是在模型训练完成后对模型进行量化处理,而QAT则是在训练过程中模拟量化效果,以降低量化对模型精度的影响。

#### 2.1.2 量化与模型性能的关系

量化与模型性能之间的关系可以通过模型精度和推理时间的权衡来理解。理论上,随着量化位宽的减小,模型精度会有所下降,但模型大小和计算效率会相应提升。在某些应用场景中,这种精度上的微小损失是可以接受的,尤其是在对实时性要求较高且资源受限的环境中。因此,量化为模型部署提供了一种性能优化的手段。

### 2.2 PyTorch中的量化工具和API

#### 2.2.1 量化流程概览

PyTorch提供了完整的量化工具集,使得用户可以在模型中轻松集成量化流程。量化流程通常包括以下几个步骤:

1. 准备模型:确保模型结构兼容量化操作。

2. 量化模拟:使用PyTorch的量化API进行模拟量化,观察和分析模型在量化条件下的表现。

3. 量化校准:选择合适的数据集进行校准,以获得最佳量化精度。

4. 量化模型转换:将模型转换为量化模型,准备部署。

#### 2.2.2 量化工具的使用方法

PyTorch中的量化工具主要包括`torch.quantization`模块。以下是使用PyTorch进行量化的一个基本示例:

```python

import torch

from torchvision import models

from torch.quantization import QuantStub, DeQuantStub, fuse_modules, prepare, convert

# 加载预训练模型

model = models.resnet18(pretrained=True)

# 准备量化:为模型添加量化和反量化stub

model.quant = QuantStub()

model.dequant = DeQuantStub()

# 将模型中的某些模块进行融合,以优化量化效果

fuse_modules(model, [['conv1', 'bn1', 'relu']], inplace=True)

# 准备量化模型

prepare(model, inplace=True)

# 校准模型

# 这里需要提供校准数据集,以及设置校准过程的一些参数

# ...

# 转换模型

convert(model, inplace=True)

# 使用量化模型进行推理

model.cpu()

input_tensor = torch.randn(1, 3, 224, 224)

output = model(input_tensor)

```

在这个示例中,我们首先加载了一个预训练的ResNet18模型,并为其添加了量化和反量化stub。然后,我们通过融合模型中的某些模块来优化量化效果。接着,我们使用`prepare`和`convert`方法来准备和转换模型,使其成为量化模型。最后,使用该量化模型进行推理。

### 2.3 离线量化与感知量化对比

#### 2.3.1 离线量化机制与应用

离线量化通常指的是模型训练完成后应用的量化方法,它独立于训练过程,因此也被称为训练后量化。在离线量化中,模型权重和激活值通过量化函数转换为低位宽的表示。PyTorch中,离线量化主要通过`torch.quantization`模块中的`prepare`和`convert`函数实现。

离线量化的优势在于简单易行,不需要修改训练过程,可以直接应用于任何训练完成的模型。但是,它可能会导致较大的精度损失,尤其是对于深度或者复杂的模型。

```mermaid

graph LR

A[模型训练完成] --> B[选择量化配置]

B --> C[校准模型]

C --> D[应用离线量化]

D --> E[部署模型]

```

#### 2.3.2 感知量化机制与优势

与离线量化不同,感知量化在训练过程中就引入了量化效果的模拟,模型在训练时就适应了低位宽的表示,这有助于减少量化后的精度损失。通过在训练过程中插入伪量化节点,模型在每次迭代时都能感知到量化的影响,从而调整模型参数以适应量化。

感知量化的优点在于能够更好地保持量化前后的模型性能,尤其是在模型复杂度较高时。但其缺点是引入了额外的训练开销,并且需要修改原有的训练流程。

```mermaid

graph LR

A[模型训练开始] --> B[插入感知量化层]

B --> C[训练过程中的量化模拟]

C --> D[模型参数优化]

D --> E[完成训练]

E --> F[部署量化模型]

```

在下一章节中,我们将深入了解PyTorch量化实践技巧,通过具体的案例来展示如何在实际项目中应用这些量化技术。

# 3. PyTorch量化实践技巧

在深度学习领域,模型的优化不仅仅依赖于算法的创新,还包括模型压缩和加速的实践操作。其中量化技术,作为一种有效的模型压缩手段,已经成为推动模型在硬件上更高效运行的关键技术。本章将深入探讨PyTorch框架下量化实践的关键技巧,展示如何利用动态量化、静态量化和量化感知训练来优化深度学习模型,同时针对量化的挑战提出相应的解决方案。

## 3.1 动态量化与静态量化

### 3.1.1 动态量化的原理与实践步骤

动态量化,是一种在运行时进行量化的方法,与静态量化不同,它不需要预先知道数据分布,而是在模型执行过程中动态地计算量化参数。动态量化的优势在于其简单易用,并且不需要额外的校准数据集。但其劣势在于量化误差较大,尤其是当模型中存在大量不同的操作时。

在PyTorch中,动态量化可以通过`torch.quantization`模块实现。下面的代码展示了如何将一个简单的模型进行动态量化:

```python

import torch

import torch.nn as nn

from torch.quantization import QuantStub, DeQuantStub, fuse_modules, convert

# 定义一个简单的模型

class SimpleModel(nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.qua

```

0

0