揭秘数据结构复杂度分析:时间和空间的奥秘

发布时间: 2024-08-25 05:27:55 阅读量: 19 订阅数: 28

探索Ruby中的元组:数据结构的奥秘

# 1. 数据结构复杂度分析概述**

数据结构复杂度分析是评估算法和数据结构性能的关键技术。它衡量算法在不同输入规模下的时间和空间开销,从而帮助我们了解其效率和可扩展性。复杂度分析通常使用渐进表示法,它描述了算法的运行时间或空间使用量如何随着输入规模的增加而增长。通过理解复杂度分析,我们可以比较不同的算法,优化现有算法,并预测算法在实际应用中的性能。

# 2. 时间复杂度分析

时间复杂度分析是评估算法执行时间效率的一种方法。它描述了算法执行时间与输入规模之间的关系。

### 2.1 渐进复杂度分析

渐进复杂度分析是一种简化分析,它忽略了算法执行中的常数因子和低阶项。它关注算法在输入规模趋于无穷大时的渐进行为。

#### 2.1.1 大O表示法

大O表示法是一种表示渐进复杂度的数学符号。它表示算法在最坏情况下执行所需的时间,随着输入规模趋于无穷大。

`O(f(n))` 表示算法执行时间至多为 `f(n)`,其中 `n` 是输入规模。例如:

- `O(1)`:常数时间复杂度,算法执行时间与输入规模无关。

- `O(n)`:线性时间复杂度,算法执行时间与输入规模成正比。

- `O(n^2)`:平方时间复杂度,算法执行时间与输入规模的平方成正比。

#### 2.1.2 常见复杂度类别

常见的时间复杂度类别包括:

| 类别 | 符号 | 算法示例 |

|---|---|---|

| 常数 | O(1) | 查找数组中的元素 |

| 线性 | O(n) | 遍历数组 |

| 平方 | O(n^2) | 冒泡排序 |

| 立方 | O(n^3) | 快速排序 |

| 指数 | O(2^n) | 递归斐波那契数列 |

### 2.2 平均和最坏情况分析

平均情况分析考虑算法在所有可能的输入上的平均执行时间。最坏情况分析考虑算法在最不利输入上的执行时间。

#### 2.2.1 平均情况分析

平均情况分析计算算法在所有可能的输入上的平均执行时间。它可以提供算法的典型性能。例如,快速排序的平均时间复杂度为 `O(n log n)`,这意味着它在大多数情况下都能高效执行。

#### 2.2.2 最坏情况分析

最坏情况分析计算算法在最不利输入上的执行时间。它提供算法在最差情况下可能表现的保证。例如,快速排序的最坏情况时间复杂度为 `O(n^2)`,这意味着在某些输入情况下,它可能表现得非常慢。

### 2.3 经验复杂度分析

经验复杂度分析是一种通过测量算法在不同输入规模上的实际执行时间来估计算法复杂度的技术。

#### 2.3.1 测量和建模

经验复杂度分析涉及测量算法在不同输入规模上的执行时间,并使用数学模型来拟合这些测量结果。例如,可以使用线性回归模型来拟合执行时间与输入规模之间的关系。

#### 2.3.2 经验复杂度曲线

经验复杂度曲线显示了算法执行时间与输入规模之间的关系。它可以提供算法在不同输入规模下的实际性能。例如,一个算法的经验复杂度曲线可能显示它在小输入规模上表现为线性复杂度,在大输入规模上表现为平方复杂度。

# 3.1 静态空间复杂度

**3.1.1 变量和数据结构的空间占用**

静态空间复杂度是指算法在执行过程中所需的最少内存空间,它与算法中使用的变量和数据结构的类型和数量直接相关。

* **变量的空间占用:**

不同类型的变量占用不同的内存空间。例如,在 C++ 中:

```cpp

int a; // 4 字节

double b; // 8 字节

char c; // 1 字节

```

* **数据结构的空间占用:**

数据结构的内存占用取决于其元素的数量和每个元素的类型。例如:

* 数组:`int arr[100]` 占用 100 * 4 = 400 字节

* 链表:每个节点占用指针和数据域的空间,链表长度为 n 时,占用 n * (指针大小 + 数据域大小) 字节

* 树:每个节点占用指针和数据域的空间,树的高度为 h,节点数为 n 时,占用 n * (指针大小 + 数据域大小) * h 字节

**3.1.2 递归函数的空间消耗**

递归函数在执行过程中会不断创建新的函数调用栈帧,每个栈帧都会占用一定的空间。因此,递归函数的静态空间复杂度与递归的深度直接相关。

例如,以下递归函数计算斐波那契数:

```cpp

int fib(int n) {

if (n <= 1) {

return 1;

} else {

return fib(n - 1) + fib(n - 2);

}

}

```

当 n = 5 时,递归深度为 5,栈帧占用 5 * (指针大小 + 整型大小) 字节的空间。

# 4. 复杂度分析的实践应用

### 4.1 算法比较和选择

在实际应用中,经常需要比较和选择不同的算法来解决特定问题。复杂度分析提供了量化的指标,帮助我们做出明智的决策。

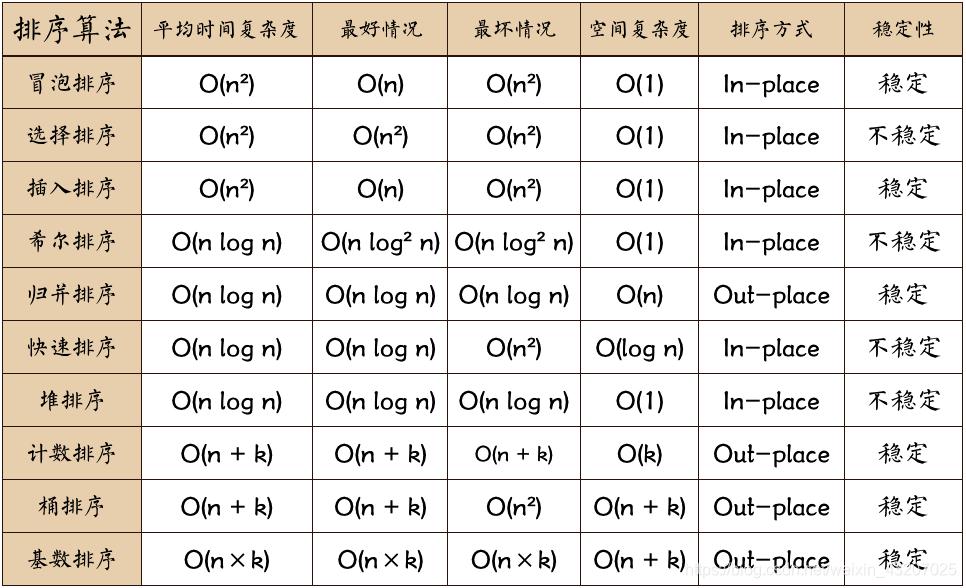

#### 4.1.1 不同算法的时间和空间复杂度比较

为了比较不同算法的性能,需要分析它们的时间和空间复杂度。以下表格总结了常见算法的复杂度:

| 算法 | 时间复杂度 | 空间复杂度 |

|---|---|---|

| 冒泡排序 | O(n^2) | O(1) |

| 快速排序 | O(n log n) | O(log n) |

| 归并排序 | O(n log n) | O(n) |

| 哈希表查找 | O(1) | O(n) |

| 二叉树搜索 | O(log n) | O(n) |

从表格中可以看出,冒泡排序的时间复杂度最高,而哈希表查找的时间复杂度最低。对于空间复杂度,冒泡排序占用最少空间,而哈希表和二叉树搜索占用较多空间。

#### 4.1.2 根据需求选择最优算法

根据具体问题的需求,可以根据复杂度分析选择最优算法。例如:

* 如果数据量较小,冒泡排序可以满足需求,因为它占用空间少。

* 如果数据量较大,需要快速查找,哈希表查找是最佳选择。

* 如果需要对数据进行排序,快速排序或归并排序都是不错的选择,它们的时间复杂度较低。

### 4.2 算法优化

复杂度分析还可以指导算法的优化。通过分析算法的瓶颈,可以采取措施降低其复杂度。

#### 4.2.1 算法改进策略

常见的算法优化策略包括:

* **减少循环次数:**通过改进算法的逻辑,减少不必要的循环次数。

* **使用更快的算法:**替换复杂度较高的算法为复杂度较低的算法。

* **优化数据结构:**选择更适合问题的合适数据结构,可以显著提高算法效率。

* **并行化:**对于支持并行化的算法,通过并行执行任务可以提升性能。

#### 4.2.2 优化后的复杂度分析

经过优化后,算法的复杂度可能会发生变化。需要重新进行复杂度分析,以评估优化后的算法性能。例如:

```python

def optimized_bubble_sort(arr):

"""优化后的冒泡排序算法"""

n = len(arr)

for i in range(n):

swapped = False

for j in range(n - i - 1):

if arr[j] > arr[j + 1]:

arr[j], arr[j + 1] = arr[j + 1], arr[j]

swapped = True

if not swapped:

break

return arr

```

优化后的冒泡排序算法在发现没有元素交换时提前终止,减少了不必要的循环次数。其时间复杂度从 O(n^2) 优化为 O(n)。

# 5. 复杂度分析的局限性

### 5.1 算法的实际性能受多因素影响

复杂度分析虽然提供了算法效率的理论依据,但算法的实际性能还受以下因素影响:

- **硬件和软件环境:**算法在不同的硬件平台和操作系统上执行,其性能可能会有差异。例如,CPU速度、内存大小和操作系统调度策略都会影响算法的执行时间。

- **数据规模和分布:**算法处理的数据规模和分布也会影响其性能。对于相同复杂度的算法,处理大规模或分布不均匀的数据时,执行时间可能更长。

### 5.2 复杂度分析不能完全预测算法性能

复杂度分析基于渐进分析,只考虑算法在输入规模趋于无穷大时的效率。然而,在实际应用中,算法往往处理有限规模的数据。因此,复杂度分析不能完全预测算法在特定输入规模下的性能。

此外,复杂度分析忽略了以下因素:

- **常数因子:**复杂度表示法中的大O符号只表示算法的渐进增长率,忽略了算法中的常数因子。这些常数因子在实际应用中可能对性能产生显著影响。

- **经验复杂度分析的误差:**经验复杂度分析依赖于测量和建模,可能存在误差。这些误差会影响算法的实际性能预测。

0

0