图像生成任务中的CNN模型设计与训练方法

发布时间: 2024-05-02 19:38:11 阅读量: 98 订阅数: 42

一个基于CNN的模型构建与应用的实例

# 2.1 卷积神经网络(CNN)的结构和原理

### 2.1.1 CNN的层级结构和功能

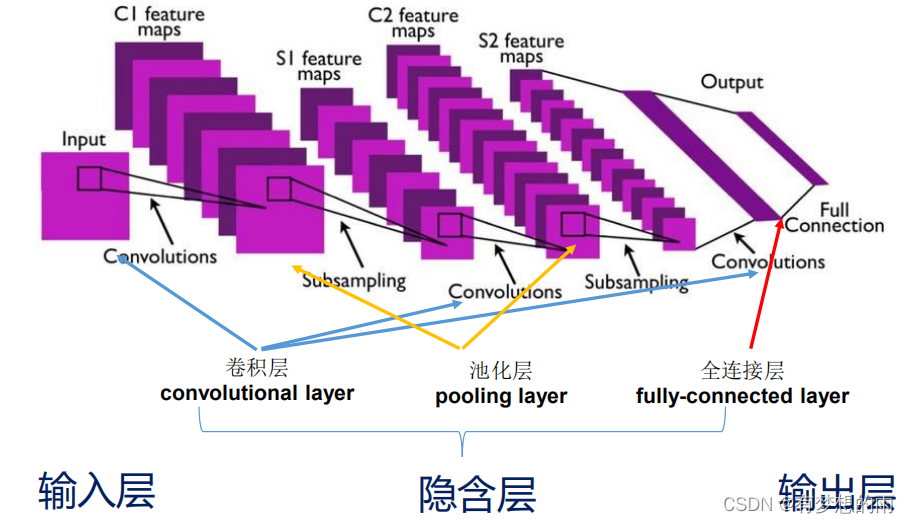

卷积神经网络(CNN)是一种深度神经网络,其结构由以下层级组成:

- **卷积层:**卷积层是CNN的核心,它通过卷积运算提取图像特征。卷积运算使用一个称为滤波器的可学习内核,在图像上滑动,生成一个特征图。

- **池化层:**池化层通过对特征图进行降采样来减少计算量和特征维度。常用的池化操作包括最大池化和平均池化。

- **激活函数:**激活函数引入非线性到CNN中,使网络能够学习复杂的关系。常用的激活函数包括ReLU和sigmoid。

- **全连接层:**全连接层将卷积层提取的特征转换为最终输出,例如图像分类或回归。

### 2.1.2 卷积、池化和激活函数

**卷积:**卷积运算在输入图像上滑动滤波器,计算每个位置的加权和。滤波器的大小和步长决定了提取特征的范围和分辨率。

**池化:**池化操作通过将特征图中相邻元素组合成一个值来减少特征维度。最大池化选择最大值,而平均池化计算平均值。

**激活函数:**激活函数对卷积和池化的输出进行非线性变换。ReLU函数将负值置零,而sigmoid函数将输出限制在0到1之间。

# 2. CNN模型理论基础

### 2.1 卷积神经网络(CNN)的结构和原理

#### 2.1.1 CNN的层级结构和功能

CNN是一种深度学习模型,其结构由多个层级组成,每层执行特定的功能。典型的CNN层级结构包括:

- **卷积层:**卷积层是CNN的核心,它使用卷积核在输入数据上滑动,提取特征。卷积核是一个小型的权重矩阵,它与输入数据的局部区域进行卷积运算,产生一个特征图。

- **池化层:**池化层通过对卷积层的输出进行下采样,减少特征图的大小。池化操作可以是最大池化或平均池化,它可以降低计算量并提高模型的鲁棒性。

- **激活函数:**激活函数是非线性函数,它将卷积层或池化层的输出映射到一个新的值域。激活函数引入非线性,使CNN能够学习复杂的关系。常用的激活函数包括ReLU、sigmoid和tanh。

#### 2.1.2 卷积、池化和激活函数

**卷积:**卷积操作是CNN的基本运算。它通过在输入数据上滑动卷积核,计算卷积核与输入数据局部区域的点积。卷积核的大小和步长决定了提取特征的范围和密度。

**池化:**池化操作通过对卷积层的输出进行下采样,减少特征图的大小。最大池化选择卷积核覆盖区域内的最大值,而平均池化则计算卷积核覆盖区域内的平均值。池化操作可以降低计算量并提高模型的鲁棒性。

**激活函数:**激活函数引入非线性,使CNN能够学习复杂的关系。ReLU函数是最常用的激活函数,它将输入值映射到非负值域。sigmoid函数将输入值映射到[0, 1]区间,而tanh函数将输入值映射到[-1, 1]区间。

### 2.2 CNN模型的训练和优化

#### 2.2.1 损失函数和优化算法

**损失函数:**损失函数衡量模型预测与真实值之间的差异。常见的损失函数包括均方误差(MSE)、交叉熵损失和Huber损失。

**优化算法:**优化算法用于最小化损失函数,调整模型的权重。常用的优化算法包括梯度下降法、动量法和RMSprop。

#### 2.2.2 正则化技术和超参数调整

**正则化技术:**正则化技术可以防止模型过拟合,提高泛化能力。常见的正则化技术包括L1正则化、L2正则化和Dropout。

**超参数调整:**超参数是模型训练过程中的参数,例如学习率、批次大小和正则化系数。超参数调整可以通过网格搜索或贝叶斯优化等方法进行。

# 3.1 生成对抗网络(GAN)

#### 3.1.1 GAN的原理和架构

生成对抗网络(GAN)是一种无监督学习模型,用于生成逼真的数据。它由两个神经网络组成:生成器(G)和判别器(D)。生成器负责生成假数据,而判别器负责区分假数据和真实数据。

GAN的训练过程是一个对抗过程,其中生成器和判别器不断竞争。生成器试图生成与真实数据难以区分的假数据,而判别器试图准确区分假数据和真实数据。通过这种竞争,生成器逐渐学习生成更逼真的数据,而判别器逐渐提高区分能力。

#### 3.1.2 GAN的训练技巧和稳定性

GAN的训练具有挑战性,因为它可能出现不稳定或收敛到局部最优值的情况。为了提高GAN的稳定性,研究人员提出了各种训练技巧,例如:

- **梯度惩罚(Gradient Penalty):**添加一个惩罚项,以防止生成器生成与真实数据分布相差太大的数据。

- **谱归一化(Spectral Normalization):**对判别器的权重进行谱归一化,以稳定训练过程。

- **历史平均(Historical Averaging):**对生成器的权重进行历史平均,以平滑训练过程。

此外,GAN的架构也影响其稳定性。一些常见的GAN架构包括:

- **DCGAN(深度卷积GAN):**使用卷积神经网络作为生成器和判别器。

- **WGAN(Wasserstein GAN):**使用Wasserstein距离作为损失函数,以提高训练稳定性。

- **StyleGAN(风格GAN):**使用自适应实例归一化和风格混合,以生成高质量和多样化的图像。

#### 代码示例:

```python

import torch

import torch.nn as nn

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

```

0

0