性能优化秘籍:大规模数据清洗的10大技巧

发布时间: 2024-11-19 21:03:12 阅读量: 30 订阅数: 43

大规模并发数据处理.pdf

# 1. 大规模数据清洗概述

在信息技术高速发展的当下,数据已经成为了企业最重要的资产之一。然而,这些资产往往被大量的噪声和不一致污染,影响了数据的质量和价值。因此,大规模数据清洗应运而生,它旨在通过一系列的数据处理方法,去除数据中的错误和不一致性,以提高数据质量。

## 1.1 数据清洗的必要性

在分析或应用数据之前,数据清洗是不可或缺的步骤。数据清洗能够纠正错误,填补缺失值,去除异常值,以及统一数据格式,保证了数据在分析过程中的准确性和有效性。对于数据分析结果的可靠性有着决定性的影响。

## 1.2 数据清洗的目标和挑战

数据清洗的主要目标是确保数据的质量,以便于后续的分析和应用。常见的目标包括但不限于提高数据准确性,保持数据一致性,以及标准化数据格式。然而,在大规模数据环境下,面对不同来源和格式的数据,数据清洗也面临着前所未有的挑战,比如数据量大、异构性高等问题。

在接下来的章节中,我们将深入探讨如何通过理论和实践相结合的方式,应对这些挑战,提升大规模数据清洗的效率和效果。

# 2. 理论基础与准备

## 2.1 数据清洗的重要性

### 2.1.1 数据质量对分析的影响

在数据驱动的决策过程中,数据质量是决定最终分析结果可靠性的基石。低质量的数据会导致分析结果出现偏差,从而影响决策的正确性。例如,在金融市场分析中,数据的微小错误可能会被放大,导致投资策略的失误。在医疗领域,不准确的患者数据可能会导致错误的诊断或治疗方案。因此,确保数据质量对于任何数据分析工作都至关重要。

数据清洗的首要目标是提高数据质量,确保数据准确、完整、一致和及时。在数据质量提升后,分析结果的可信度增加,能够为业务决策提供更为坚实的支持。

### 2.1.2 数据清洗的目标和原则

数据清洗的目标是通过识别和修正或删除数据集中错误的、不完整的、不一致的、不相关的和重复的数据,以提高数据的可用性和准确性。在进行数据清洗时,需要遵循以下原则:

- **最小化数据丢失**:在删除错误或不完整数据时,应尽量减少对数据集的破坏。

- **确保数据一致性**:清洗过程中应保持数据的逻辑一致性,确保同一数据在不同上下文中保持一致。

- **优化数据结构**:清洗数据时应考虑数据的结构,使其更适合后续的分析任务。

- **提高数据可靠性**:通过清洗,确保数据对于分析和决策过程的可靠性。

## 2.2 数据清洗的理论框架

### 2.2.1 数据清洗流程

数据清洗流程通常包含以下步骤:

1. **数据探索**:分析数据集,识别数据问题。

2. **数据预处理**:针对识别出的问题,进行初步的数据处理,如编码缺失值、转换数据类型等。

3. **数据清洗**:处理数据异常、删除重复记录、修正错误等。

4. **数据验证**:检验数据清洗的效果,确保清洗步骤没有引入新的错误。

5. **数据标准化**:统一数据格式,确保数据符合组织的标准。

### 2.2.2 数据清洗的常见问题

在数据清洗过程中,可能会遇到以下问题:

- **缺失值**:数据集中缺少某些信息,可能导致分析偏差。

- **异常值**:数据集中存在不符合整体分布的值,可能是错误或特殊情况。

- **数据不一致**:同一概念的数据在不同地方表示不同,导致分析困难。

- **重复记录**:数据集中存在多条相同或相似的记录,影响数据分析的准确性。

## 2.3 环境和工具准备

### 2.3.1 选择合适的数据清洗工具

选择合适的数据清洗工具对于提高数据清洗效率和质量至关重要。以下是一些流行的数据清洗工具:

- **Pandas**:Python的一个数据处理库,提供了数据清洗的丰富功能。

- **OpenRefine**:一个强大的工具,特别适合于处理和转换大型数据集。

- **Talend**:一个开源的ETL工具,支持数据清洗、转换和集成。

- **Data Quality**:特定于数据质量管理的工具,例如 IBM 的 Infosphere QualityStage。

### 2.3.2 环境配置和依赖管理

为了支持数据清洗工作,需要配置一个合适的开发环境。例如,如果你选择使用 Python 作为数据清洗工具,你需要安装以下环境和依赖:

- **Python 版本**:确保安装了最新稳定版的 Python。

- **Pandas**:用于数据处理和清洗。

- **NumPy**:处理数值型数据。

- **Matplotlib/Seaborn**:数据可视化。

- **Jupyter Notebook**:开发和执行数据清洗脚本。

配置好环境后,推荐使用 `pip` 进行依赖管理,创建一个 `requirements.txt` 文件记录所有依赖项,确保环境的可复现性。

```bash

pip freeze > requirements.txt

```

在新的环境安装时,可以使用以下命令快速安装所有依赖:

```bash

pip install -r requirements.txt

```

以上就是第二章的内容,接下来我们将深入探讨如何在实践中应用高效的数据清洗技巧,并介绍相关工具和技术的使用方法。

# 3. ```markdown

# 第三章:高效数据清洗实践

数据清洗是数据预处理的重要步骤,它对数据集进行转换和整理,保证数据质量和准确性,为数据分析和挖掘提供坚实基础。在实际工作中,高效的数据清洗实践通常涉及对数据进行预处理、转换和标准化,以及数据的集成和关联操作。本章将详细介绍这些方面的实践技巧和技术。

## 3.1 数据预处理技巧

### 3.1.1 缺失值处理方法

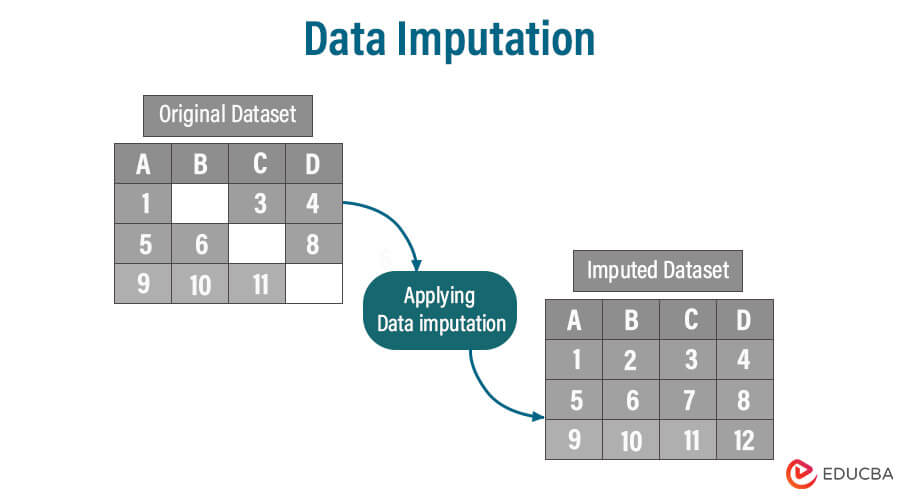

在现实世界的数据库中,数据往往不完整,存在缺失值,这将直接影响数据分析的质量和结果的准确性。因此,缺失值的处理是数据清洗过程中的一个关键步骤。常见的处理方法有:

- **删除含有缺失值的记录**:如果数据集很大,且缺失值较少,可以考虑删除这些记录。但是,如果缺失值较多,那么这种方法可能会导致信息的大量丢失。

- **填充缺失值**:对于一些特定的列,可以根据其他非缺失值的统计特性(如均值、中位数、众数等)来填充缺失值。

- **使用预测模型**:利用数据挖掘算法构建一个预测模型来估算缺失值。

例如,假设我们有一个名为 `data.csv` 的CSV文件,我们需要填充其某个属性的缺失值。

```python

import pandas as pd

# 读取数据

df = pd.read_csv('data.csv')

# 查看数据中的缺失值

print(df.isnull().sum())

# 使用均值填充特定属性的缺失值

df['attribute'] = df['attribute'].fillna(df['attribute'].mean())

# 再次查看数据中的缺失值

print(df.isnull().sum())

```

在上面的代码中,我们首先导入了`pandas`库,然后读取了一个CSV文件到`df`中。通过`isnull()`函数检测数据中的缺失值,并用`fillna()`函数填充了缺失值。

### 3.1.2 异常值检测与处理

异常值是指那些不符合数据集一般模式或行为的值。它们可能是由于错误、异常情况或真实的变异引起的。异常值的检测和处理对于数据质量控制至关重要。

- **统计方法**:利用标准差和均值等统计量识别异常值。

- **基于箱形图**:箱形图通过绘制数据分布的四分位数来帮助识别异常值。

- **基于距离**:识别与大部分数据点远离的点作为异常值。

以统计方法为例,下面的代码演示了如何使用标准差识别异常值,并将其替换为均值。

```python

# 计算均值和标准差

mean = df['attribute'].mean()

std_dev = df['attribute'

0

0