数据清洗:为什么它是数据科学的“基石”?专家揭秘

发布时间: 2024-11-19 20:16:14 阅读量: 39 订阅数: 43

数据预处理:数据科学旅程的基石.zip

# 1. 数据清洗概述

在当今数字化时代,数据成为了企业、研究机构甚至个人用户价值创造的基石。但原始数据往往包含错误、不一致、缺失或重复的信息,数据清洗应运而生,作为数据预处理的关键环节,它确保了数据质量,为数据分析提供了坚实的基础。

## 1.1 数据清洗的基本概念

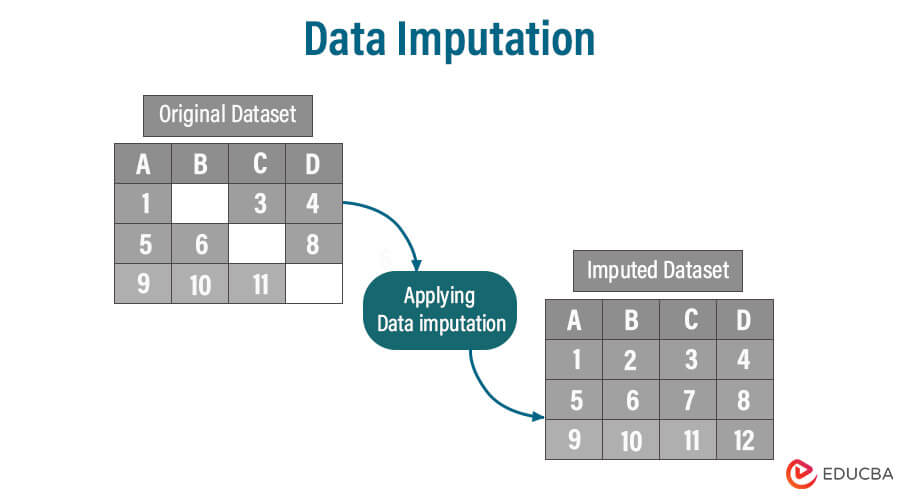

数据清洗是识别并修正数据集中错误和不一致的过程,它涉及一系列的步骤,如缺失值处理、异常值识别、数据格式化、重复记录的合并等。通过有效的数据清洗,数据可以转变为一种更为规范和可靠的形式,以满足分析和建模的需要。

## 1.2 数据清洗的目标和挑战

清洗数据的目标通常是为了提高数据的整体质量,使其更准确地反映现实世界的状态。这个过程中的挑战包括处理大量的数据集、发现数据中的复杂模式、处理不完整数据以及解决各种隐私和安全问题。理解这些挑战有助于我们制定出更有效的数据清洗策略。

```markdown

- 提高数据质量

- 确保数据准确性

- 解决数据完整性问题

```

在下一章节,我们将深入探讨数据清洗的重要性,并了解其在数据科学中的作用。

# 2. ```

# 第二章:数据清洗的理论基础

## 2.1 数据清洗的重要性

### 2.1.1 数据质量与数据科学的关系

在数据科学的生态系统中,数据质量是构建准确模型和生成有价值见解的基石。高质量的数据可以提高数据科学项目的成功率,确保分析结果的准确性和可靠性。这直接影响到数据科学的两个主要目标:预测性能和洞察力的发现。例如,在机器学习中,如果输入数据存在质量问题,那么模型的预测能力会大大降低,最终影响决策制定的准确性。

### 2.1.2 数据清洗对模型准确性的影响

数据清洗的过程直接关系到模型的准确性。通过对数据进行清洗,可以移除或修正错误的、不一致的、重复的或不完整的数据记录,从而减少模型训练中的噪声。一个经过充分清洗的数据集可以提高模型学习的有效性,因为模型不再需要处理杂乱无章的数据。这在实践中意味着更准确的预测、更好的业务决策和最终更高的投资回报率。

## 2.2 数据清洗的理论流程

### 2.2.1 数据清洗步骤介绍

数据清洗是一个多步骤的过程,包括识别和解决数据集中的问题,具体步骤如下:

1. 数据探索:初步检查数据集,了解数据的结构和内容。

2. 缺失值处理:决定如何处理数据集中的缺失值,例如通过删除、填充或插值。

3. 异常值检测与处理:识别出异常值,并决定是删除、调整还是保留这些值。

4. 数据格式化:确保数据符合统一的格式标准,如日期、货币、文本大小写等。

5. 数据转换:将数据转换成适合分析的格式,如归一化、标准化等。

6. 数据集成:如果有多个数据源,需要将它们整合到一个数据集中。

### 2.2.2 数据清洗与数据预处理的区别

数据清洗和数据预处理虽然是密切相关的概念,但它们之间存在细微差别。数据清洗主要是识别和修复数据集中的错误,包括处理缺失值、异常值和重复记录等问题。数据预处理则涵盖了数据清洗的所有步骤,并且还包括其他步骤,如数据规范化、特征选择和特征构造等,目的是将原始数据转换为更适合分析和建模的格式。

## 2.3 数据清洗的策略与方法

### 2.3.1 常见的数据清洗问题

数据清洗面临的问题可以分成几个类别,例如数据一致性问题、数据格式问题和数据完整性问题等。在处理这些问题时,需要仔细考虑每个问题对后续分析的影响,并选择合适的方法进行处理。

### 2.3.2 数据清洗策略的制定

制定数据清洗策略需要从数据问题的类型、数据集的重要性以及所要达到的业务目标出发。策略应该包括以下内容:

- 确定哪些问题是优先解决的。

- 决定使用哪些技术或工具来解决问题。

- 规划数据清洗活动的时间表和资源分配。

一个有效的数据清洗策略应该具有明确的目标,能够快速识别并解决问题,并能适应不断变化的数据环境。

```

# 3. 数据清洗的实战技巧

数据清洗是数据预处理的重要环节,在这一章节中,我们将深入探讨实际操作中使用的数据清洗技巧,以及如何在具体环境中应用这些技巧来提高数据质量。本章将分为三个主要部分,分别是数据清理和转换、数据集成与数据融合、数据验证与质量控制。

## 3.1 数据清理和转换

### 3.1.1 缺失值的处理

在实际数据处理过程中,数据集中的缺失值是常见的问题。缺失值可以是全部缺失(空值),也可以是部分缺失(如某字段中的NaN值)。处理缺失值的策略通常包括删除记录、填充缺失值和预测缺失值等。

下面的示例使用Python中的Pandas库来处理缺失值:

```python

import pandas as pd

# 假设有一个名为data.csv的数据文件,我们使用Pandas读取它

df = pd.read_csv('data.csv')

# 查看缺失值统计情况

print(df.isnull().sum())

# 删除含有缺失值的记录

df_cleaned = df.dropna()

# 用均值填充数值型列的缺失值

df_filled = df.fillna(df.mean())

# 用特定值填充分类型列的缺失值

df_filled_category = df.fillna(value={'category_column': 'Unknown'})

```

在处理缺失值时,需要根据具体情况做出决策。例如,如果数据集非常大且缺失值较少,删除含有缺失值的记录可能是简单有效的方法。如果数据集较小,那么用统计方法(如均值、中位数、众数等)或预测模型填充缺失值可能更合适。

### 3.1.2 异常值的检测与处理

异常值是指与整体数据分布不符的观测值,它可能是由错误、噪声或其他未知因素造成的。异常值检测和处理对于提高数据质量至关重要。

异常值检测的常用方法包括基于统计的方法(如Z-score、IQR)、基于距离的方法(如K-means聚类)和基于密度的方法。

使用Python的Scikit-learn库可以实现基于距离的异常值检测:

```python

from sklearn.cluster import KMeans

import numpy as np

# 对数据集df进行异常值检测

kmeans = KMeans(n_clusters=3)

df['cluster'] = kmeans.fit_predict(df)

# 计算每个数据点到其聚类中心的距离

df['distance'] = kmeans.transform(df)

# 设定阈值,并找出异常值

threshold = np.percentile(df['distance'], 95)

outliers = df[df['distance'] > threshold]

```

处理异常值通常有删除、修正或保留等方法。选择哪

0

0