Gel-PRO ANALYZER数据分析中的统计方法与错误检查

发布时间: 2024-12-16 18:38:56 阅读量: 2 订阅数: 5

条带分析(Gel-Pro_analyzer).rar

参考资源链接:[Gel-PRO ANALYZER软件:凝胶定量分析完全指南](https://wenku.csdn.net/doc/15xjsnno5m?spm=1055.2635.3001.10343)

# 1. Gel-PRO ANALYZER数据处理概述

Gel-PRO ANALYZER是一个专业级的软件工具,旨在帮助研究人员处理和分析各种实验数据,尤其是那些来自凝胶电泳实验的结果。本章节将简要概述Gel-PRO ANALYZER的功能和它在数据处理中的地位,以及它如何帮助用户快速获得精确和可靠的分析结果。

数据处理是科学研究中不可或缺的一环,而Gel-PRO ANALYZER通过集成各种强大的算法和可视化工具,使得数据分析变得更加高效和直观。此软件不仅仅提供基础的数据统计,还涵盖了高级的数据分析技术,从简单的描述性统计到复杂的时间序列分析和生存分析等。

本章的目的是帮助读者建立起对Gel-PRO ANALYZER数据处理工作的整体认识,为深入理解后续章节的详细分析方法奠定基础。

# 2. Gel-PRO ANALYZER的基础统计方法

## 2.1 数据的导入与整理

### 2.1.1 支持的文件格式和导入步骤

Gel-PRO ANALYZER 支持多种文件格式,以满足不同来源数据的处理需求。常见的支持格式包括 CSV、Excel 和文本文件等。为了确保数据导入的准确性和完整性,Gel-PRO 提供了详细的导入向导来指导用户完成数据导入过程。

导入步骤通常包括:

1. 选择文件类型和路径。

2. 指定文件中的数据分隔符。

3. 确定数据的第一行是否包含列名。

4. 选择需要导入的数据列。

通过这些步骤,用户可以将外部数据文件高效地导入到Gel-PRO ANALYZER 中进行后续分析。

### 2.1.2 数据清洗和标准化过程

导入数据后,数据清洗和标准化是确保数据质量的关键步骤。Gel-PRO ANALYZER 提供了多种数据清洗功能,包括:

- **缺失值处理**:提供删除、填充或估算缺失数据的方法。

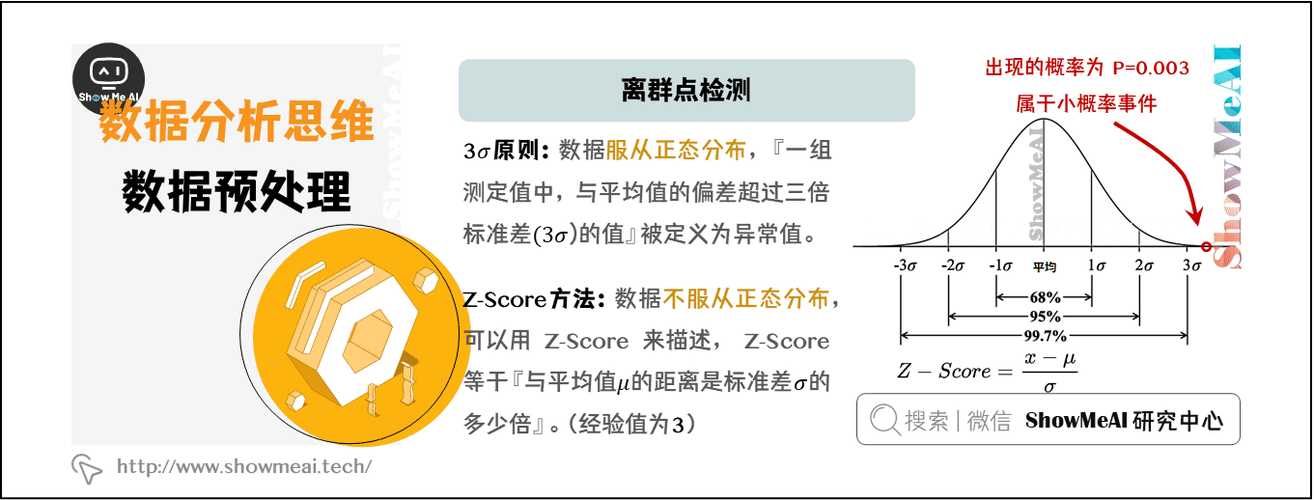

- **异常值检测**:根据统计规则识别异常值。

- **数据转换**:对数据进行对数转换、标准化处理或归一化等操作。

数据标准化通常采用 Z-score 方法,该方法将数据集中的每个值减去平均值后除以标准差,从而转换成标准正态分布。

```python

import pandas as pd

from sklearn.preprocessing import StandardScaler

# 加载数据

data = pd.read_csv('data.csv')

# 创建标准化对象

scaler = StandardScaler()

# 执行标准化

data_standardized = scaler.fit_transform(data)

# 将标准化后的数据集转换回 DataFrame 格式

data_standardized_df = pd.DataFrame(data_standardized, columns=data.columns)

```

在上述代码中,我们首先加载了数据集 `data.csv`,然后创建了一个标准化对象 `scaler`。使用 `fit_transform` 方法对数据进行标准化处理,并将结果转换回 DataFrame 格式。

## 2.2 基本统计分析

### 2.2.1 描述性统计的实现与应用

描述性统计是对数据集中趋势的初步评估。它提供了关于数据集中心位置、分散程度和分布形态的统计度量。Gel-PRO ANALYZER 中提供了丰富的描述性统计功能,如:

- 平均数、中位数、众数等集中趋势度量。

- 方差、标准差、四分位数范围等离散程度度量。

- 偏度和峰度分析数据分布的形状。

```mermaid

graph LR

A[开始分析] --> B[选择数据集]

B --> C[应用描述性统计]

C --> D[生成统计报告]

D --> E[解读结果]

```

### 2.2.2 常见统计检验的原理和操作

统计检验是用于确定数据集中的某些统计结果是否具有统计显著性的方法。Gel-PRO ANALYZER 支持包括 T检验、ANOVA、卡方检验等在内的常见统计检验方法。这些检验方法帮助研究人员在面对数据集时做出假设检验决策。

例如,T检验通常用于比较两个独立样本组的均值是否存在显著差异。在Gel-PRO中,用户可以设定检验的显著性水平,并获取包括 p值在内的检验结果。

## 2.3 多变量统计分析

### 2.3.1 相关性和回归分析的使用

多变量分析涉及两个或更多变量之间的关系。相关性分析用于评估两个变量之间是否存在统计意义上的关联。而回归分析则用于预测或估计一个变量对另一个变量的影响。

在Gel-PRO ANALYZER中,用户可以通过界面或脚本进行这些分析。以下是一个简单的线性回归分析示例:

```python

import statsmodels.api as sm

# 假设 X 是自变量,y 是因变量

X = ... # 自变量数据

y = ... # 因变量数据

# 构建模型并添加常数项

X = sm.add_constant(X)

# 创建线性回归模型并拟合数据

model = sm.OLS(y, X).fit()

# 输出结果

print(model.summary())

```

在此代码块中,我们使用 `statsmodels` 库创建了一个线性回归模型,并拟合了自变量 `X` 和因变量 `y`。输出结果将包括回归系数、p值、R平方值等重要统计量。

### 2.3.2 主成分分析(PCA)的步骤和意义

主成分分析(PCA)是一种用于数据降维的技术,它通过转换原始数据为一组线性无关的成分,来简化数据集的结构。在Gel-PRO ANALYZER中,PCA 常用于可视化和数据探索。

PCA 的步骤通常包括:

1. 数据标准化处理。

2. 计算数据的协方差矩阵。

3. 计算协方差矩阵的特征值和特征向量。

4. 选择主成分(基于特征值大小)。

5. 构建主成分得分。

下面是一个实现PCA的简单代码示例:

```python

from sklearn.decomposition import PCA

import numpy as np

# 假设 data 是已经标准化的多维数据集

data = ...

# 创建 PCA 对象,这里假定减少到2维以便可视化

pca = PCA(n_components=2)

# 拟合数据并转换

principal_components = pca.fit_transform(data)

# principal_components 可用于进一步分析或可视化

```

在这段代码中,我们使用 `sklearn` 库中的 `PCA` 类,指定了主成分的数量为2,并拟合了已经标准化的数据集。通过 `fit_transform` 方法,我们获得了降维后的主成分得分,这些得分可用于后续的数据分析或可视

0

0