HDFS表目录结构设计:数据上传与管理的最佳实践

发布时间: 2024-10-30 10:03:03 阅读量: 28 订阅数: 21

数据湖+安全与合格性技术教程

# 1. HDFS表目录结构设计概览

数据存储在Hadoop分布式文件系统(HDFS)中具有特定的层次结构和命名约定。设计有效的表目录结构是至关重要的,因为它影响数据访问效率、存储利用率和集群的管理维护。本章将概览HDFS的表目录结构设计,为后续深入理解其理论基础、实践操作和策略提供基础。

接下来,我们将按照层次化结构来组织数据,以便为数据查询和处理提供清晰的路径,从而实现快速的数据检索。同时,我们会对HDFS的命名空间管理进行讨论,以便更好地理解权限控制、安全性和数据隔离,这对于任何数据敏感的企业来说都至关重要。

在接下来的章节中,我们将深入探讨HDFS表目录结构设计的各个方面,旨在通过优化的策略和最佳实践来提升数据处理效率和存储策略。

# 2. HDFS表目录结构的理论基础

## 2.1 HDFS的基本概念

### 2.1.1 HDFS的架构和组件

Hadoop Distributed File System(HDFS)是Hadoop的核心组件之一,它是为存储大量数据和提供高吞吐量访问而设计的。HDFS具有高容错性的特点,并且是针对运行在廉价硬件上的分布式存储系统而优化的。架构上,HDFS由以下主要组件构成:

- **NameNode**:管理文件系统的命名空间,记录文件中各个块所在的DataNode节点。它不存储实际数据,只存储文件系统的元数据。

- **DataNode**:在本地文件系统存储文件数据块。DataNode负责处理文件系统客户端的读写请求,并在NameNode的调度下进行数据块的创建、删除和复制。

- **Secondary NameNode**:辅助NameNode,定期合并编辑日志与文件系统镜像,以防止编辑日志过大导致NameNode重启缓慢。

### 2.1.2 HDFS数据存储的原理

HDFS通过将大文件分割成固定大小的块(block)来存储。每个块的默认大小是128MB(在较新的Hadoop版本中,这个值可以更大,默认通常是256MB)。每个块在多个DataNode上进行复制,以实现冗余和容错。HDFS数据存储的关键特性包括:

- **数据复制**:默认情况下,HDFS对每个块复制三份,一份在本地节点上,另外两份分别位于其他不同的物理机器上。

- **数据本地化**:数据的读写尽可能在数据所在的物理节点上完成,这样可以减少网络传输,提高效率。

- **一致性模型**:HDFS提供的是写一次、多次读取的文件访问模型,文件一旦写入完成,不能修改,只能追加数据。

## 2.2 HDFS表目录结构的重要性

### 2.2.1 数据组织和分类的重要性

组织和分类是数据管理中的核心概念,它们有助于优化存储利用率和检索效率。在HDFS中,合理的表目录结构能够:

- **提高数据访问效率**:通过合理的目录结构,可以快速定位到存储数据的位置,加快查询速度。

- **优化存储空间**:利用层级结构,可实现数据的合理归类,避免文件系统的碎片化,节约存储空间。

### 2.2.2 设计高效表目录结构的考量因素

设计高效表目录结构需要考虑以下因素:

- **数据访问模式**:了解数据的读写频率和模式,对于性能优化至关重要。

- **数据生命周期**:不同的数据有不同的生命周期,合理的设计要考虑数据保留策略。

- **安全和权限管理**:在组织数据时,需要保证数据安全,合理划分权限。

- **扩展性**:目录结构设计应考虑未来可能的数据增长,保证在不迁移数据的情况下能平滑扩展。

## 2.3 HDFS命名空间的管理

### 2.3.1 命名空间的层次结构

HDFS的命名空间由目录、文件和块组成。它模拟了传统的文件系统,使用树形结构,以路径的形式组织数据。路径可以有子目录,并且每个路径代表一个唯一的命名空间。命名空间层次结构的关键点包括:

- **目录层次**:在HDFS中,可以创建多层次的目录来组织数据。

- **命名规范**:为了避免命名冲突,需要有一个清晰的命名规则。

### 2.3.2 目录权限和安全模型

HDFS的安全模型建立在Kerberos认证和基于角色的权限控制之上。每个目录和文件都有访问控制列表(ACL),可以为不同的用户和用户组设置权限。目录权限和安全模型的要点有:

- **权限检查**:用户对目录或文件的操作必须得到相应的权限。

- **Kerberos认证**:HDFS使用Kerberos作为认证方式,保证了通信的安全性。

- **审计日志**:HDFS记录所有对文件系统的访问操作,便于后续的安全审计。

以上内容涵盖了HDFS表目录结构的理论基础,为后续章节关于数据上传、管理实践和优化建议提供了扎实的知识基础。在本章节中,我们重点介绍了HDFS的基本架构和重要性,为读者在设计和管理HDFS系统时提供了理论支持。

# 3. 数据上传与管理实践

## 3.1 HDFS数据上传的策略

### 3.1.1 使用命令行工具上传数据

HDFS的命令行工具 `hadoop fs` 是一个功能强大的接口,用于操作文件系统中的数据。对于数据上传,常用的命令包括 `put` 和 `copyFromLocal`。尽管在功能上相似,它们在执行数据上传任务时表现出略有不同的特点。

`put` 命令是 `copyFromLocal` 的别名,并且它能够同时从本地文件系统和标准输入读取数据。使用此命令,用户可以直接将文件上传到HDFS中:

```sh

hadoop fs -put localfile /path/in/hdfs

```

此命令将本地系统中的 `localfile` 上传到HDFS的指定路径 `/path/in/hdfs`。如果目标路径已经存在同名文件,它将被新上传的文件覆盖。

另一方面,`copyFromLocal` 命令专注于从本地文件系统上传数据,该命令包括了更明确的来源指定:

```sh

hadoop fs -copyFromLocal localfile /path/in/hdfs

```

使用 `copyFromLocal` 时,对上传到HDFS的文件的元数据处理可能更为精确,使得在某些情况下,对数据的控制更为精细。

### 3.1.2 利用程序接口实现数据上传

除了命令行工具,Hadoop提供了一组丰富的API,允许开发者在应用程序中实现数据上传操作。无论是Java, Python还是其他支持的语言,通过相应的客户端库都能实现与HDFS的交互。

对于Java开发者来说,`org.apache.hadoop.fs.FileSystem` 类提供了上传文件的方法:

```java

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path src = new Path("localfile");

Path dst = new Path("/path/in/hdfs");

// 文件上传

fs.copyFromLocalFile(src, dst);

```

在这个Java代码段中,`FileSystem.get` 方法通过配置对象初始化了 `FileSystem` 类的实例,用于执行文件上传操作。`copyFromLocalFile` 方法将本地文件系统中的 `src` 路径下的文件复制到HDFS中 `dst` 路径。

### 3.1.3 数据上传的最佳实践和优化技巧

上传大量小文件是HDFS所不推荐的,因为这会增加NameNode的内存消耗和管理开销。在实际操作中,使用SequenceFile、MapFile或其他Hadoop支持的二进制格式存储小文件可以提高存储效率。

对于大文件上传,推荐使用 `distcp` 工具进行数据分布式复制,特别是在多集群环境间进行数据同步时。此外,合理使用压缩可以减少数据的网络传输量,提升上传效率。

```sh

hadoop distcp hdfs://namenode1/path/to/hugefile hdfs://namenode2/path/to/destination

```

上述命令使用 `distcp` 在两个不同的HDFS集群间复制大文件。

另外,监控资源使用情况和调整文件系统参数(如 `dfs.replication`)也能进一步优化数据上传性能。合理设置参数可以平衡数据冗余度与存储成本。

## 3.2 数据管理的基本操作

### 3.2.1 文件和目录的创建、删除与修改

HDFS不仅提供了数据上传功能,还支持创建、删除和修改文件和目录的操作。这些操作对于数据的日常管理至关重要。

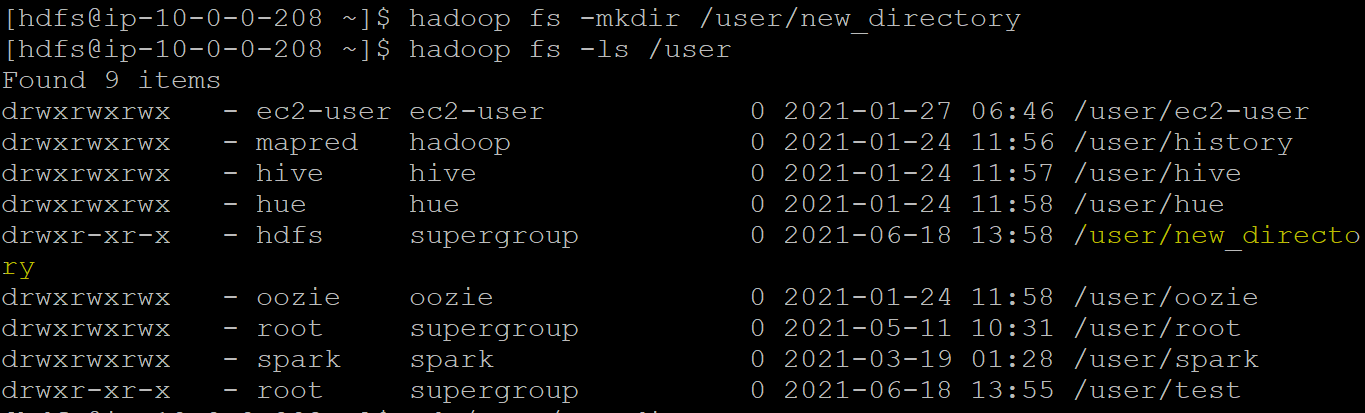

创建目录:

```sh

hadoop fs -mkdir /new/directory/path

```

此命令会创建一个新的目录在HDFS中。

删除文件:

``

0

0