Hadoop文件系统深度剖析:表目录数据上传机制的全面解析

发布时间: 2024-10-30 09:55:46 阅读量: 17 订阅数: 15

# 1. Hadoop文件系统概览

在大数据处理和存储的世界中,Hadoop文件系统(HDFS)扮演着至关重要的角色。它是Hadoop项目的核心组件之一,专为存储大量数据而设计。随着对大数据处理需求的增长,HDFS已经成为许多企业和研究机构的选择。

在本章中,我们将对Hadoop文件系统进行初步的探讨,概述其背景、设计目标、以及核心概念。本章的内容旨在为读者提供对HDFS的基本理解,为深入学习其架构和数据上传机制打下基础。

## 1.1 HDFS的设计目标与特点

HDFS的设计主要针对大规模数据集的存储和处理需求。它被设计为能够运行在廉价硬件之上,并具有高容错性。HDFS通过将数据切分成块(blocks),并分布存储在多个节点上来实现存储扩展。此外,它支持“一次写入,多次读取”模式,这使得它非常适合于数据分析和批处理任务。

## 1.2 HDFS的核心组件解析

HDFS架构的核心组件包括命名节点(NameNode)、数据节点(DataNode),以及客户端(Client)。命名节点负责管理文件系统的命名空间和客户端对文件的访问。数据节点负责存储实际的数据块。客户端通过与命名节点交互,完成文件的创建、删除、打开、关闭以及读写等操作。

通过上述基础概念的理解,接下来的章节将会逐步深入HDFS架构的细节和数据上传的具体操作,为读者提供完整的大数据存储和处理知识体系。

# 2. HDFS的架构与核心组件

## 2.1 Hadoop分布式文件系统概述

### 2.1.1 HDFS的设计目标与特点

Hadoop分布式文件系统(HDFS)是为了解决大数据存储问题而设计的,它具备高容错性、高吞吐量的特点,特别适合用于大规模数据集的应用。HDFS的设计目标是实现海量数据的存储与处理,支持流式数据访问模式,同时兼容各种硬件平台,尤其是低廉的标准硬件。

HDFS具有以下显著特点:

1. **扩展性**:HDFS能够轻松扩展到成百上千的节点,以存储PB级别的数据。

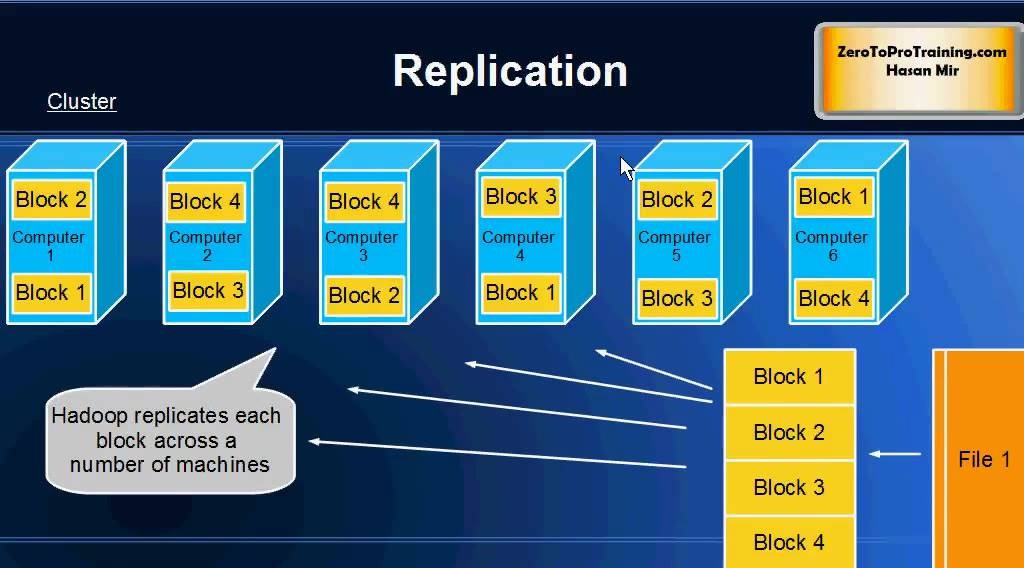

2. **高容错性**:HDFS通过数据副本机制来提供高容错性,即使部分节点发生故障,数据也不会丢失。

3. **流式数据访问**:HDFS优化了对大文件的读写,适合批处理而非低延迟的数据访问。

4. **简单的一致性模型**:HDFS对文件命名空间采用一次写入多次读取的模式,保证了数据最终一致性。

### 2.1.2 HDFS的核心组件解析

HDFS的核心组件包括:

- **NameNode**:管理文件系统的命名空间,记录文件系统树和整个文件系统的元数据。在HDFS中,每个文件或目录都被视为一个“元数据”节点。

- **DataNode**:在集群的每个节点上存储实际数据,负责数据的读写操作。

- **Secondary NameNode**:辅助NameNode,定期合并文件系统命名空间镜像和编辑日志,防止编辑日志过大。

## 2.2 HDFS的数据块机制

### 2.2.1 数据块的概念与作用

数据块是HDFS存储数据的基本单位。HDFS将文件分成一系列块进行存储,每个块的默认大小为128MB。由于数据块的大小远大于传统文件系统的块大小,HDFS可以减少寻址开销,从而提升吞吐量。

数据块的概念在HDFS中有以下几个作用:

1. **提高吞吐量**:大块尺寸意味着读写操作更少,减少磁盘寻道时间,提高吞吐量。

2. **简化存储管理**:由于块的大小是固定的,管理文件的元数据比管理多个小文件简单。

3. **便于数据复制**:大块尺寸允许系统在不同的节点上存储数据副本来提供冗余,确保数据的可靠性和容错性。

### 2.2.2 数据块的存储与管理

HDFS通过数据块的复制机制来保证数据的可靠性。当数据被写入HDFS时,它会被分割成一系列块,这些块会被复制到集群的多个节点上。默认情况下,每个块会有三个副本,分别存储在不同的节点上。

数据块的存储与管理涉及以下几个方面:

1. **数据备份**:通过复制机制,即使某些节点发生故障,数据依然可以得到恢复。

2. **数据均衡**:HDFS定期进行数据均衡,确保数据副本均匀分布在集群中。

3. **块管理**:NameNode负责管理所有数据块的位置信息,而DataNode负责实际的数据存储。

## 2.3 HDFS的命名节点和数据节点

### 2.3.1 命名节点的职责与操作

命名节点(NameNode)在HDFS中扮演着非常重要的角色,主要职责包括:

- **维护文件系统树及整个文件系统的元数据**:包括文件和目录信息、每个文件的块列表和块位置信息等。

- **处理客户端请求**:对客户端提供文件系统的命名空间访问服务。

- **管理数据块映射**:维护所有数据块的存储位置。

在操作方面,命名节点需要执行以下任务:

- **命名空间的加载与保存**:在系统启动时加载命名空间,并在关闭时保存。

- **命名空间的修改**:响应客户端请求,创建、删除文件或目录,修改文件属性等。

### 2.3.2 数据节点的角色与交互

数据节点(DataNode)是HDFS中实际存储数据块的节点。每个集群节点上运行一个DataNode实例,负责存储和检索数据块。

数据节点的角色和交互包括:

- **数据存储**:负责处理文件系统客户端的读写请求。

- **块报告**:定期向命名节点发送自己持有的块列表报告。

- **块复制**:根据命名节点的指示,创建或删除数据块。

一个简单的HDFS架构示意图如下所示:

```mermaid

graph LR

A[Client] -->|Read/Write| B(NameNode)

B -->|Request| C[DataNode1]

B -->|Request| D[DataNode2]

B -->|Request| E[DataNode3]

C -->|Data| F[Block1, Block2, ...]

D -->|Data| G[Block3, Block4, ...]

E -->|Data| H[Block5, Block6, ...]

```

HDFS的架构和组件在实践中需要通过一系列的配置和管理,才能确保其稳定和高效地运行。在下一节中,我们将详细探讨如何上传数据到HDFS,以及相关的配置和管理技巧。

# 3. 表目录数据上传前的准备工作

## 3.1 数据准备与预处理

### 3.1.1 数据的收集和整理

在HDFS系统中存储数据之前,数据的收集和整理是重要的一步。数据通常来自于多种渠道,包括但不限于日志文件、数据库、实时数据流等。为了将这些数据上传到Hadoop集群,首先需要进行数据的收集工作。这一过程可能涉及数据的抓取、聚合或迁移。

收集完毕后,需要对数据进行整理,以便于数据上传和后续处理。整理工作包括但不限于:

- **数据清洗**:移除重复项、空白数据或纠正错误。

- **数据格式化**:统一数据格式,如将日志文件中的时间戳统一转换为标准格式。

### 3.1.2 数据的格式转换与清洗

在数据整理阶段,数据的格式转换和清洗尤为关键。合理的数据格式不仅能加速Hadoop的处理速度,还能提高数据查询的效率。数据格式化工具如Apache Avro、Parquet和ORC广泛用于提高存储效率和查询速度。例如,Parquet是一个列式存储格式,它为数据仓库型的查询工作负载进行了优化。

数据清洗时,常使用工具如Hive、Sqoop或直接在Hadoop集群上运行MapReduce作业进行。清洗数据主要包含以下步骤:

- **数据去重**:防止数据重复导致的存储浪费和计算错误。

- **空值处理**:将空值替换为默认值或通

0

0