【奇异值分解(SVD)揭秘】:徐树方课后答案,深入探索SVD的多面性

发布时间: 2025-01-06 08:36:28 阅读量: 8 订阅数: 20

# 摘要

奇异值分解(SVD)是一种强大的数学工具,广泛应用于数据压缩、推荐系统和机器学习等领域。本文详细探讨了SVD的理论基础及其在不同领域的应用。首先,分析了SVD在数据压缩中的原理和效果评估,包括图像和音频的压缩案例。其次,阐述了SVD在推荐系统构建中的角色、矩阵分解技术中的重要性以及具体实施步骤。此外,本文还讨论了SVD作为特征提取工具和降维算法的关系,以及在实际机器学习项目中的应用。最后,探讨了高阶SVD方法、数值稳定性和大数据环境下SVD算法的优化,为未来的研究方向提供了视野。

# 关键字

奇异值分解;数据压缩;推荐系统;机器学习;特征提取;数值稳定性

参考资源链接:[数值线性代数课后习题解答与算法解析](https://wenku.csdn.net/doc/6401abc8cce7214c316e97dc?spm=1055.2635.3001.10343)

# 1. 奇异值分解(SVD)的理论基础

奇异值分解(SVD)是一种强大的矩阵分解技术,它在诸多领域,包括但不限于数据压缩、图像处理、音频处理、推荐系统、机器学习等领域,都有广泛的应用。SVD通过将原始矩阵分解为三个矩阵的乘积,可以揭示数据的内在结构和特性。

## 矩阵分解与特征值

首先,我们需要理解矩阵分解的概念。矩阵分解是将一个矩阵拆解成几个更简单的矩阵乘积的形式。SVD是其中一种特殊的分解方式,它将一个矩阵M分解为UΣV^T的形式。这里,U和V是正交矩阵,Σ是对角矩阵,对角线上的元素是奇异值,它们按照从大到小的顺序排列。

## SVD的数学表达

数学上,奇异值分解可以表达为:

\[ M = U \Sigma V^T \]

其中,M是原始矩阵,U和V是包含左奇异向量和右奇异向量的正交矩阵,而Σ是一个对角矩阵,对角线上的元素是奇异值。奇异值越大,它对应的奇异向量对矩阵M的特征描述就越重要。

SVD不仅可以用于分析矩阵的结构,还能在许多情况下作为算法优化的工具。通过这种分解,可以将矩阵压缩、降维,甚至重构,以便于理解和处理复杂的数据集。在接下来的章节中,我们将详细探讨SVD在不同领域的具体应用和优化。

# 2. SVD在数据压缩中的应用

### 2.1 SVD的数据压缩原理

奇异值分解(SVD)在数据压缩中扮演着重要的角色,其主要原理是通过矩阵分解的方式来简化数据的表示。数据压缩的数学模型通常涉及将原始数据矩阵表示为三个矩阵的乘积,分别代表行空间、奇异值和列空间。具体来说,给定一个m×n的矩阵M,我们可以将其分解为:

M ≈ UΣV<sup>T</sup>

其中,U是一个m×k的矩阵,其列向量是标准正交的;Σ是一个k×k的对角矩阵,其对角线上的元素是奇异值,并且按照从大到小排列;V<sup>T</sup>是一个k×n的矩阵,其列向量也是标准正交的。通过选择合适的k值(即保留的奇异值数量),我们可以通过U、Σ和V<sup>T</sup>来近似原始矩阵M。

#### 2.1.2 SVD压缩效果的评估标准

SVD压缩效果的评估标准通常依赖于所希望达到的精确度。可以通过比较原始矩阵M和近似矩阵M<sub>k</sub>之间的差异来衡量压缩效果。差异可以使用范数来衡量,例如:

||M - M<sub>k</sub>||<sub>F</sub> = √∑<sub>i,j</sub>(M<sub>ij</sub> - M<sub>k,ij</sub>)<sup>2</sup>

这里,||·||<sub>F</sub>表示Frobenius范数,它衡量的是两个矩阵对应元素差的平方和的平方根。通过调整k的大小,我们可以控制压缩率和保持数据精度之间的平衡。

### 2.2 SVD在图像压缩的应用

#### 2.2.1 图像压缩的案例分析

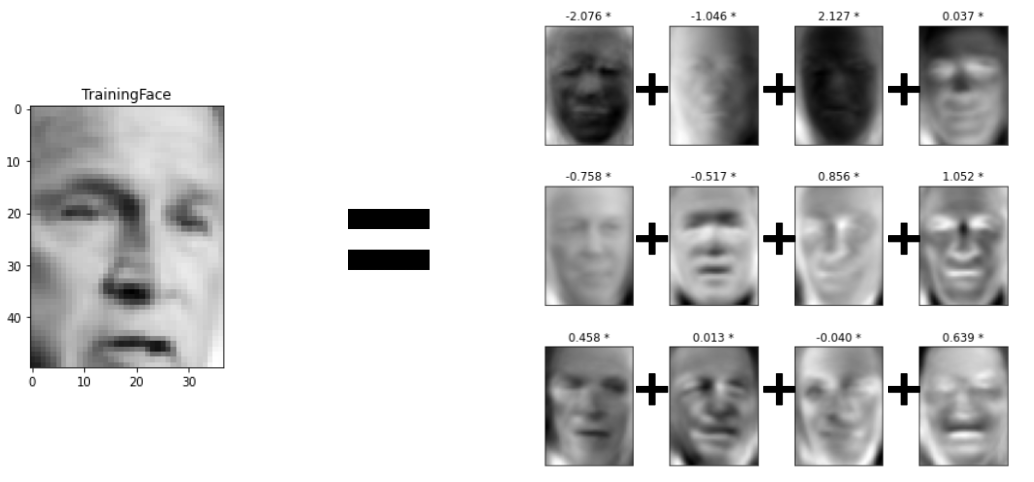

图像压缩的一个经典案例是使用SVD来减少图像存储空间的需要,同时尽可能保留图像的视觉质量。以一张灰度图像为例,该图像可以表示为一个矩阵,其中每个元素对应图像的一个像素值。通过SVD,我们可以将这个矩阵分解为三个矩阵的乘积,然后通过舍去最小的奇异值和对应的U和V<sup>T</sup>矩阵中的列,来实现压缩。

代码块示例:

```python

import numpy as np

# 假设M是图像矩阵

U, S, Vt = np.linalg.svd(M, full_matrices=False)

# 保留前k个奇异值

k = 10

Sk = np.diag(S[:k])

Uk = U[:, :k]

Vk = Vt[:k, :]

# 近似矩阵

M_approx = Uk @ Sk @ Vk

```

在上述Python代码中,通过`np.linalg.svd`函数实现了对矩阵M的奇异值分解。然后通过选择前k个奇异值和相应的U、V矩阵列,构造了压缩后的近似矩阵M_approx。

#### 2.2.2 压缩后的图像质量对比

评估压缩后图像的质量,通常会涉及到视觉比较以及客观指标的对比。主观视觉质量可以通过与原始图像的对比来评估,而客观指标可以使用如信噪比(SNR)、峰值信噪比(PSNR)等。

### 2.3 SVD在音频压缩的应用

#### 2.3.1 音频信号的SVD处理方法

音频信号也可以通过SVD进行压缩处理。音频信号的每个样本点可以被看作是一个点在高维空间中的表示,而一个音频文件则可以看作是一个高维矩阵。SVD的处理方法和图像类似,但是在音频压缩中,我们需要特别注意人类听觉系统的特性。

音频压缩中,保持音质是最重要的考量之一。由于人耳对不同频率的声音敏感度不同,因此在选择保留哪些奇异值时,可以考虑人类听觉的掩蔽效应。

#### 2.3.2 音频压缩后的听感质量评估

音频压缩后的听感质量评估通常需要通过实际的听音测试来进行。在这些测试中,受试者会评价压缩后的音频与原始音频在音质、音量等方面的一致性。除了主观测试,也有客观的算法评估标准,例如用互相关函数来衡量两个音频之间的相似度。

接下来的章节将继续深入探讨SVD在推荐系统和机器学习领域的应用。

# 3. SVD在推荐系统中的应用

在第三章中,我们将深入探讨奇异值分解(SVD)技术在构建推荐系统中的应用。推荐系统作为数据科学中的一项重要应用,其核心目标是为用户推荐他们可能感兴趣的商

0

0