打造高质量关联规则挖掘基础:数据预处理与arules包指南

发布时间: 2024-11-04 14:47:03 阅读量: 4 订阅数: 12

# 1. 关联规则挖掘简介

关联规则挖掘是数据挖掘领域的一个重要分支,它旨在发现大型数据库中变量间的有趣关系,尤其是那些能够提供价值洞察的规则。这项技术广泛应用于零售业、生物信息学、网络安全等多个领域。简单来说,关联规则挖掘通过分析大量的数据,帮助我们识别项集之间的依赖性,其核心在于识别频繁出现的模式,这些模式可以用来预测某些行为或趋势。

## 1.1 关联规则挖掘的目的

关联规则挖掘的目的在于揭示数据集中不同项之间的关联性,发现其中的规律性模式。例如,在超市购物篮分析中,通过挖掘交易数据,可以发现顾客购买商品的关联性,如“购买面包的顾客往往也会购买牛奶”。这种信息可以帮助商家进行货架摆放、促销活动设计等。

## 1.2 关联规则挖掘的关键概念

关联规则挖掘涉及几个关键概念:支持度(Support)、置信度(Confidence)和提升度(Lift)。支持度表示规则中所有项集在所有交易中出现的频率;置信度衡量规则前项与后项同时出现的概率;提升度则表示了规则的前项和后项之间的关联程度,高于1表示正相关,等于1表示无关,低于1则表示负相关。

通过理解这些概念,数据分析师可以更好地构建和评估关联规则,进而指导实际业务决策。在下一章中,我们将深入了解数据预处理的基础知识,这是进行有效关联规则挖掘不可或缺的前期准备工作。

# 2. 数据预处理基础

数据预处理是数据挖掘过程中的关键步骤,它直接影响到最终挖掘结果的质量。本章将深入探讨数据预处理的各种技术,从数据清洗过程开始,到数据转换和离散化方法,确保我们能够得到干净、整洁且适合挖掘的数据集。

### 2.1 数据清洗过程

在处理任何类型的数据集之前,确保数据的质量是非常重要的。数据清洗过程的目的是消除数据中的错误和不一致性,提高数据的准确性和可靠性。

#### 2.1.1 缺失值处理

缺失值是数据集中常见的问题之一。它们可能是由于数据收集时的遗漏、数据录入错误或信息的不完整性所造成的。处理缺失值的方法有多种,如删除含缺失值的记录、填充缺失值、或使用模型预测缺失值。

- 删除法:如果数据集很大,并且缺失值较少,可以考虑删除含有缺失值的记录。

- 填充法:可以使用统计方法(如均值、中位数或众数)或使用机器学习算法来预测并填充缺失值。

- 预测法:对于一些特殊的数据集,可以通过建立预测模型来预测缺失值。

#### 2.1.2 异常值检测与处理

异常值是指那些与数据集中的其他数据点显著不同的数据点。它们可能是由于错误的数据录入、测量错误或实际的异常事件造成的。异常值的处理方法包括:

- 统计检验:通过Z分数、IQR(四分位距)等统计指标检测异常值。

- 基于模型的方法:使用聚类分析等模型识别异常点。

- 删除或修正:对于确定的异常值,可以将其从数据集中删除,或尝试根据数据的分布对异常值进行修正。

### 2.2 数据转换技术

为了使数据更适合进行关联规则挖掘,我们需要对数据进行转换,使其落入一个特定的范围,或者将非数值数据转换为可以进行数值计算的格式。

#### 2.2.1 数据标准化和归一化

数据标准化和归一化是将数据按比例缩放,使之落入一个小的特定区间,如[0,1]或[-1,1]。这些方法有助于消除不同量纲的影响,使得挖掘算法更好地工作。

- 标准化(Z-score Normalization):将数据转换为均值为0,标准差为1的分布。

- 归一化(Min-Max Normalization):将数据线性变换到一个指定的范围,例如[0,1]。

#### 2.2.2 数据编码和变量转换

数据编码是将非数值型数据转换为数值型数据的过程。分类数据通常需要转换为可以进行数学运算的形式。

- 独热编码(One-Hot Encoding):为每个类别创建一个新的二进制列。

- 标签编码(Label Encoding):将分类变量转换为数值型标签。

### 2.3 数据离散化方法

数据离散化是将连续属性的数据转化为离散形式的过程,这有助于处理非均匀分布的数据,以及提高挖掘效率。

#### 2.3.1 等频和等距离散化

等频和等距离散化是两种常用的数据离散化方法。

- 等频离散化:将数据划分成等数量的区间,每个区间中的样本数相同。

- 等距离散化:将数据的值域等分成n个区间,每个区间覆盖相同的数据范围。

#### 2.3.2 自动离散化技术

自动离散化技术可以根据数据的分布和挖掘算法的需求自动确定离散化的区间。

- 基于统计的方法:使用统计测试(如卡方测试)来确定最佳的区间边界。

- 基于熵的方法:利用信息增益的概念来确定数据的离散区间。

以上对数据预处理的各个步骤进行了详细的探讨。在下一章节中,我们将关注如何使用`arules`包进行关联规则挖掘,并探讨事务数据的处理以及规则的提取与评估方法。

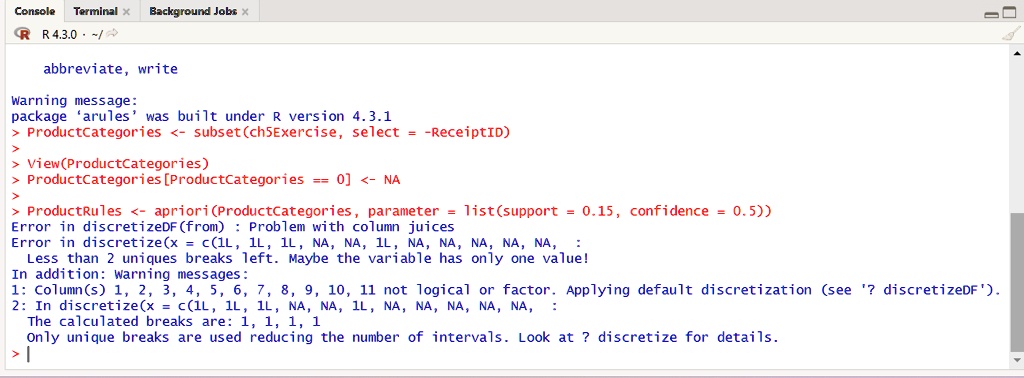

# 3. 使用arules包进行关联规则挖掘

## 3.1 arules包概述

### 3.1.1 arules包的功能和结构

在探索关联规则挖掘的世界中,R语言的arules包是其中的佼佼者,它提供了一系列强大而灵活的函数,用于发现数据中的频繁项集和关联规则。arules包的主要功能包括:

- 数据结构的支持:它支持多种类型的数据结构,最常用的是事务数据集(transactions),其中包含了一系列的交易记录。

- 频繁项集的生成:借助于Apriori算法等,arules包能够有效地生成频繁项集。

- 关联规则的挖掘:可以从频繁项集中生成关联规则,并提供了一系列评估指标来评估这些规则的有效性和有趣度。

- 规则的可视化:arules包还支持将规则以图形的形式直观展示出来,帮助用户更好地理解数据和规则。

arules包的结构非常直观,从数据处理到规则生成,再到结果的分析和可视化,都有一系列配套的函数和类支持。这使得即使是初学者也能通过学习相关函数的使用快速上手关联规则挖掘。

### 3.1.2 安装与加载arules包

在R环境中使用arules包,首先需要进行安装和加载的操作。安装arules包可以通过以下R指令实现:

```R

install.packages("arules")

```

安装完成后,使用以下命令将arules包加载到当前R会话中:

```R

library(arules)

```

加载arules包后,就可以开始进行关联规则挖掘的旅程了。接下来的章节中,我们将深入探索如何使用arules包处理事务数据集,生成频繁项集,以及从频繁项集中挖掘关联规则。

## 3.2 事务数据处理

### 3.2.1 构建事务数据集

在开始关联规则挖掘之前,构建一个合适的数据集是至关重要的一步。在arules包中,事务数据集是核心的数据结构。事务数据集是由一系列交易记录组成的数据集,每条交易记录包含了一个或多个项(item)。

事务数据集的构建可以利用arules包中的`transactions`函数。例如,假设我们有一个商品购买记录的简单数据框(data frame),它包含三列:交易ID(TransactionID)、客户ID(CustomerID)和商品名称(ItemName)。

```R

# 假设的数据集

data <- data.frame(

TransactionID = c(1, 1, 2, 2, 3, 3, 4, 4),

CustomerID = c(1, 1, 2, 2, 3, 3, 4, 4),

ItemName = c("Milk", "Bread", "Milk", "Diapers", "Bread", "Beer", "Milk", "Beer")

)

# 将数据框转换为事务数据集

trans <- transactions(data, items = "ItemName", format = "basket")

```

转换后的`trans`对象就是一个事务数据集,可以用于后续的频繁项集和关联规则挖掘。这个过程不只限于简单的数据框,arules包也支持从CSV、数据库等多种来源直接读取数据并转换为事务数据集。

### 3.2.2 事务数据的格式转换

在将数据集转换为

0

0