序列到序列模型:PyTorch时间序列预测的新篇章

发布时间: 2024-12-12 03:18:57 阅读量: 5 订阅数: 11

基于pytorch代码实现时间序列预测模型.rar

# 1. 序列到序列模型简介

序列到序列(Seq2Seq)模型是一种强大的机器学习架构,主要用于处理序列数据,比如文本翻译、语音识别、时间序列预测等问题。它们通过将输入序列编码成一个固定大小的内部表示,再将其解码成另一个序列来工作,这一过程展示了模型在理解和生成序列信息方面的灵活性。

在本章中,我们会初步接触Seq2Seq模型的核心理念,概述其应用和对行业的影响。随后,将分章深入探讨这些模型背后的理论基础、实践应用以及未来的发展方向。

我们将会看到,序列到序列模型并非单一技术,而是一类模型的统称,涵盖了从基础的循环神经网络(RNN)到更为先进的Transformer架构。这些模型被广泛应用于多种任务中,显示了它们强大的泛化能力和适应性。接下来,让我们开始详细探究它们的工作原理以及如何在实际中应用。

# 2. 序列到序列模型的理论基础

### 2.1 序列模型的基本概念

#### 2.1.1 序列模型的定义和应用场景

序列模型是处理序列数据的机器学习模型,可以捕捉数据点之间的时序关系。它们被广泛应用于语音识别、自然语言处理、时间序列分析等领域。序列模型能够处理不同长度的输入序列,并输出相同或不同长度的序列,使得它们在需要按时间顺序处理信息的任务中具有巨大的优势。

#### 2.1.2 序列到序列模型的关键特性

序列到序列(Seq2Seq)模型通常包含两个主要的组件:编码器(Encoder)和解码器(Decoder)。编码器负责将输入序列编码成一个固定长度的上下文表示,而解码器则基于这个上下文来生成输出序列。这种架构的关键特性之一是能够处理可变长度的输入和输出序列,这对于需要映射一个序列到另一个序列的任务,如机器翻译和文本摘要,至关重要。

### 2.2 循环神经网络(RNN)及其变种

#### 2.2.1 常规RNN的局限性

常规的循环神经网络(RNN)在处理长序列时容易遇到梯度消失或梯度爆炸的问题,这会严重影响模型对长距离依赖的学习能力。此外,传统RNN在并行化计算方面也有局限,因为它们需要按时间步顺序处理序列。

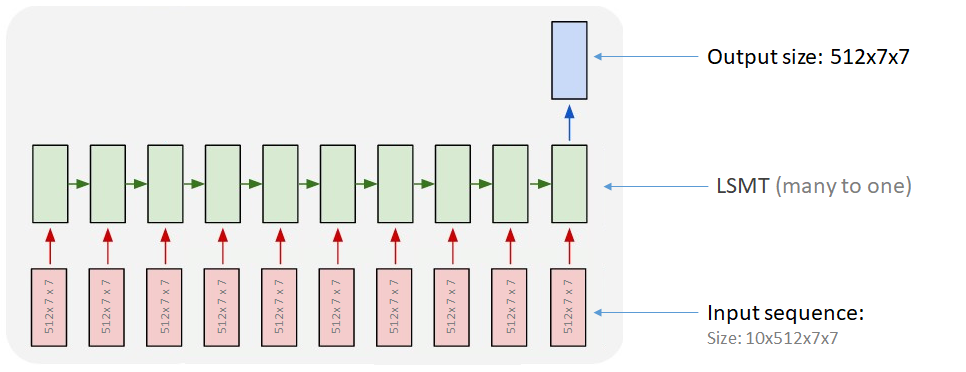

#### 2.2.2 LSTM和GRU的结构与工作原理

为了解决常规RNN的这些限制,长短期记忆网络(LSTM)和门控循环单元(GRU)被提出来增强序列数据的处理能力。LSTM通过引入“门”机制来调节信息流动,有效地解决了长距离依赖问题。GRU作为LSTM的一个简化版本,通过减少参数数量来提升模型的计算效率,同时保持了处理长序列的能力。

### 2.3 Transformer模型的兴起

#### 2.3.1 自注意力机制的原理

自注意力机制是Transformer模型的核心,它允许模型在处理序列的每个元素时,直接关注序列中的所有其他元素。这种机制有效地捕获了序列内各部分之间的关系,无论这些部分相隔多远。自注意力的引入大幅提高了模型处理序列数据的能力,尤其是在捕捉长距离依赖方面。

#### 2.3.2 Transformer模型的结构概述

Transformer模型的核心是基于自注意力机制的编码器和解码器堆叠。编码器由多个相同的层组成,每一层都包含一个自注意力机制和一个简单的前馈神经网络。解码器同样由多层组成,不同之处在于它在自注意力机制后还包含一个额外的注意力机制,用于关注输入序列的信息。通过这种方式,Transformer模型能够高效地处理并生成序列数据,成为了自然语言处理领域的主流模型。

# 3. PyTorch序列到序列模型实践

## 3.1 PyTorch框架入门

### 3.1.1 安装PyTorch环境

在开始使用PyTorch框架之前,首先需要在你的系统中安装它。PyTorch可以通过多种方式安装,包括使用conda、pip,或通过Docker镜像。这里我们介绍通过conda安装PyTorch的方法,这是最简单也是最推荐的方式。

首先,你需要访问PyTorch官方网站获取安装指令。根据你的系统配置和需求选择合适的安装命令,例如在Linux系统上,Python 3.7版本,CUDA 10.2的环境下,你可以使用如下命令:

```bash

conda install pytorch torchvision torchaudio cudatoolkit=10.2 -c pytorch

```

通过`conda`安装PyTorch的好处是它能够处理大部分依赖关系,并且在安装GPU版本的PyTorch时会自动下载对应的CUDA工具包。

安装完成后,你可以在Python中导入PyTorch并验证其版本以确保安装成功:

```python

import torch

print(torch.__version__)

```

如果系统没有报错,并且能够打印出PyTorch版本号,那么说明你已经成功安装了PyTorch。

### 3.1.2 PyTorch基础操作和数据结构

PyTorch 是一个面向科学计算的库,它的核心是用于实现张量运算的`Tensor`类,以及提供自动求导功能的`autograd`模块。下面介绍一些PyTorch的基础操作和数据结构。

**张量(Tensor)** 是PyTorch中的基本数据结构,它与NumPy中的多维数组非常类似,但是可以使用GPU进行加速。我们可以使用`torch.tensor`方法创建一个张量:

```python

import torch

# 创建一个2x3的随机张量

rand_tensor = torch.rand(2, 3)

print(rand_tensor)

```

**自动求导(Autograd)** 是PyTorch的另一个核心功能,它可以帮助我们自动计算梯度,这对于深度学习的训练过程至关重要。PyTorch通过`torch.autograd`模块提供此功能。

```python

# 假设有一个可微的张量和一个操作

x = torch.tensor([1., 2., 3.], requires_grad=True)

y = x + 2

# 现在 y 关于 x 的梯度可以通过 backprop 计算得到

y.backward()

print(x.grad)

```

除了张量和自动求导,PyTorch还提供了诸如`torch.nn`(神经网络模块)、`torch.optim`(优化算法)、`torch.utils.data`(数据加载和预处理工具)等模块,这些都是构建深度学习模型不可或缺的组成部分。

PyTorch还提供了一个非常灵活和强大的方式去构建深度学习模型,即通过`nn.Module`类。下面是一个非常简单的线性模型例子:

```python

import torch

import torch.nn as nn

# 定义一个简单的线性模型

class SimpleLinearModel(nn.Module):

def __init__(self):

super(SimpleLinearModel, self).__init__()

self.linear = nn.Linear(in_features=3, out_features=1)

def forward(self, x):

return self.linear(x)

model = SimpleLinearModel()

print(model)

```

模型定义后,你可以通过传入输入张量进行前向传播,观察模型输出:

```python

input_tensor = torch.rand(1, 3)

output = model(input_tensor)

print(output)

```

**代码逻辑的逐行解读分析**:

- 第一行,导入了PyTorch模块,是操作PyTorch的必需步骤。

- 接下来,展示了如何创建一个随机张量,张量是在PyTorch中表示多维数组的数据结构。

- 之后,演示了使用`torch.rand`方法生成一个张量,并打印它的内容。

- 为了演示自动求导,我们创建了一个包含三个元素的张量`x`,并设置`requires_grad=True`,使得PyTorch在操作该张量时能够记录梯度信息。

- 接着,我们对`x`进行一个简单的加法操作`y = x + 2`,然后使用`backward`方法计算`y`相对于`x`的梯度,最后打印出`x`的梯度。

- 之后,介绍了如何使用PyTorch中的`nn.Module`类来定义一个自定义的简单线性模型,并通过`forward`方法指定模型的前向传播逻辑。

- 最后,创建了一个`SimpleLinearModel`的实例,并展示了如何通过传入输入张量来获取模型的输出。

通过以上示例代码和解释,我们可以了解到PyTorch框架的基本操作流程以及如何用它来定义一个简单的模型,这为后续构建序列到序列模型打下了基础。

## 3.2 构建序列到序列模型

### 3.2.1 编码器和解码器的基本构建

在序列到序列(seq2seq)模型中,编码器(Encoder)和解码器(Decoder)是两个主要的组成部分。编码器负责将输入序列编码成一个固定大小的上下文向量,而解码器则以这个上下文向量为基础生成输出序列。在神经网络的实现中,这两种结构通常是深度学习模型,如循环神经网络(RNN),长短期记忆网络(LSTM)或门控循环单元(GRU)。

下面是一个使用PyTorch构建LSTM编码器和解码器的例子:

```python

import torch

import torch.nn as nn

class EncoderLSTM(nn.Module):

def __init__(self, input_size, hidden_size, num_layers):

super(EncoderLSTM, self).__init__()

self.hidden_size = hidden_size

self.num_layers = num_layers

self.lstm = nn.LSTM(input_size, hidden_size, num_layers)

def forward(self, input_seq, hidden_state):

output, hidden_state = self.lstm(input_seq, hidden_state)

return output, hidden_state

class DecoderLSTM(nn.Module):

def __init__(self, hidden_size, output_size, num_layers):

super(DecoderLSTM, self).__init__()

self.hidden_size = hidden_size

self.num_layers = num_

```

0

0