PyTorch深度解码:掌握RNN进行时间序列预测的终极秘技

发布时间: 2024-12-12 01:56:58 阅读量: 5 订阅数: 11

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 1. RNN与时间序列预测基础

## 1.1 RNN简介

循环神经网络(Recurrent Neural Network, RNN)是一种专门处理序列数据的神经网络。其核心特点是具有“记忆”能力,可以利用之前的信息来影响后续的输出,这使得RNN非常适合处理如时间序列数据、自然语言等序列化的信息。

## 1.2 时间序列预测的RNN应用

在时间序列预测任务中,RNN能够捕捉到序列中的时间依赖关系,这是由于其结构允许信息在序列中反向传播,从而在每个时间步骤中保留先前步骤的信息。

## 1.3 RNN的数学表达与原理

RNN单元的基本操作可表示为 \( h_t = f(h_{t-1}, x_t) \),其中 \( h_t \) 是在时间步 \( t \) 的隐藏状态,\( x_t \) 是当前输入,\( f \) 是激活函数。这样的结构使得RNN能够在序列的不同位置捕捉长期依赖关系。

本章我们从RNN的基本概念入手,了解其在时间序列预测中的应用背景,以及数学层面的原理解析,为后续深入到PyTorch框架下的RNN模型构建打下坚实基础。

# 2. PyTorch框架下的RNN模型构建

## 2.1 PyTorch简介及其在RNN中的应用

### 2.1.1 PyTorch核心概念回顾

PyTorch是Facebook研发的一个开源机器学习库,它被广泛用于计算机视觉和自然语言处理等领域。它基于Python语言,支持动态计算图,这使得它在构建复杂的神经网络结构时具有很高的灵活性。PyTorch的核心概念包括Tensors、Variables和Autograd。

Tensors是PyTorch中的基础数据结构,用于存储多维数组的数据,类似于Numpy的ndarrays,但可以在GPU上加速运算。Variables是对Tensors的一个封装,提供了自动求导功能,这是实现反向传播算法的关键。Autograd是一个自动微分引擎,可以计算和存储Tensors的梯度。

```python

import torch

# 创建一个Tensor

x = torch.tensor([1.0, 2.0, 3.0], requires_grad=True)

# 对Tensor进行操作

y = x + 2

z = y * y * 3

out = z.mean()

# 计算梯度

out.backward()

# 输出梯度

print(x.grad)

```

### 2.1.2 PyTorch框架对RNN的支持

在RNN模型构建中,PyTorch提供了`torch.nn.RNN`模块,它是一个基本的循环神经网络模型。PyTorch的RNN模块封装了多种类型的循环网络层,包括标准RNN、LSTM和GRU。这些层可以处理序列数据,并且支持在GPU上进行训练,大幅度提升了训练效率。

```python

import torch.nn as nn

# 创建一个RNN模型

rnn = nn.RNN(input_size=10, hidden_size=20, num_layers=2)

# 输入序列数据

input = torch.randn(5, 3, 10) # seq_len, batch_size, input_size

h0 = torch.randn(2, 3, 20) # num_layers * num_directions, batch_size, hidden_size

# 前向传播

output, hn = rnn(input, h0)

```

通过上述代码,我们可以看到如何创建一个简单的RNN模型,并进行前向传播计算。`input_size`参数定义了输入数据的特征数量,`hidden_size`定义了隐藏层的大小,`num_layers`定义了堆叠的层数。输入数据`input`是一个三维Tensor,其中包含了序列长度、批次大小和输入特征数。

## 2.2 构建基础的RNN模型

### 2.2.1 RNN层的基本结构与参数

RNN层是构建循环神经网络的基本组件,其结构与参数决定了网络的性能。PyTorch中RNN层的基本参数包括输入大小、隐藏层大小、层数、非线性函数类型等。

- `input_size`:输入特征的维度。

- `hidden_size`:隐藏状态的维度。

- `num_layers`:堆叠的RNN层的数量。

- `nonlinearity`:非线性激活函数,默认为`tanh`。

RNN层可以处理序列数据,并维持内部状态(隐藏状态),这些隐藏状态会在序列的不同时间步之间传递。

### 2.2.2 序列到序列的映射流程

序列到序列(seq2seq)模型通常用于处理序列数据的任务,如机器翻译、语音识别等。在RNN中,序列到序列的映射流程涉及到编码器和解码器的设计。

编码器将输入序列编码成一个固定大小的上下文向量,该向量代表了整个输入序列的信息。解码器则根据这个上下文向量生成输出序列。在RNN中,编码器和解码器通常由多层RNN层堆叠构成。

```python

class Seq2Seq(nn.Module):

def __init__(self, input_size, hidden_size, output_size, num_layers):

super(Seq2Seq, self).__init__()

self.encoder = nn.RNN(input_size, hidden_size, num_layers)

self.decoder = nn.RNN(hidden_size, output_size, num_layers)

def forward(self, src, trg):

outputs, hidden = self.encoder(src)

outputs = self.decoder(trg, hidden)

return outputs

```

## 2.3 RNN模型的训练与评估

### 2.3.1 损失函数与优化器的选择

训练RNN模型时,选择合适的损失函数和优化器对于模型性能至关重要。在处理回归问题时,通常采用均方误差(MSE)作为损失函数;对于分类问题,则更多地使用交叉熵损失函数(Cross-Entropy Loss)。

优化器则用于更新模型参数以最小化损失函数,常用的优化器包括随机梯度下降(SGD)、Adam、RMSprop等。Adam优化器结合了RMSprop和SGD的优点,适合于各种不同的问题,因此在实践中被广泛使用。

```python

criterion = nn.MSELoss() # 选择损失函数

optimizer = torch.optim.Adam(model.parameters()) # 选择优化器

```

### 2.3.2 训练过程中的超参数调整

在训练RNN模型时,超参数的调整对于最终的模型性能有着显著影响。一些重要的超参数包括学习率、批次大小(batch size)、序列长度等。学习率决定了梯度下降的步长大小,批次大小影响了内存使用和模型的泛化能力,序列长度则直接影响模型能够处理的序列的最大长度。

使用验证集来调整超参数是一种常见的做法,通过监控验证集的性能,可以寻找到最优的超参数组合。

```python

# 训练循环

for epoch in range(num_epochs):

for i, data in enumerate(train_loader, 0):

inputs, targets = data

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, targets)

loss.backward()

optimizer.step()

# 在验证集上评估模型

model.eval()

# ...评估代码...

model.train()

# ...训练代码...

```

在上述代码段中,我们设置了训练循环,并在每个epoch结束后在验证集上评估模型性能,以便进行超参数调整。这样的训练循环有助于找到最佳的学习率和其他超参数,从而提升模型的泛化能力。

本章节介绍了PyTorch框架下构建RNN模型的基础知识,包括PyTorch的核心概念、RNN层的结构与参数、序列到序列的映射流程,以及模型训练和评估中的关键步骤。通过上述内容,我们可以建立起RNN模型构建的初步框架,并为进一步深入学习和实践打下坚实的基础。接下来的章节将深入探讨RNN的高级特性和优化技巧,帮助我们更好地理解和应用RNN模型。

# 3. RNN高级特性与优化

## 3.1 LSTM与GRU的原理与应用

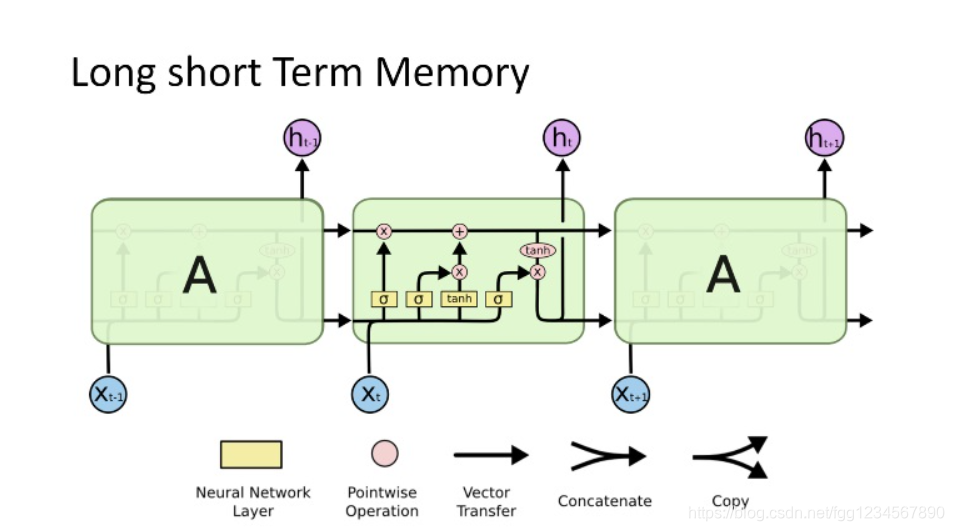

### 3.1.1 长短时记忆网络(LSTM)

长短时记忆网络(Long Short-Term Memory, LSTM)是一种特殊的RNN架构,设计用于解决标准RNN在处理长序列时出现的梯度消失和梯度爆炸问题。LSTM通过引入门控机制来控制信息的流动,主要包括输入门、遗忘门和输出门。

LSTM的单元状态(cell state)和隐藏状态(hidden state)共同决定了网络的记忆能力。遗忘门控制哪些信息需要从单元状态中丢弃,输入门决定哪些新信息需要更新到单元状态中,输出门则控制最终需要输出的信息。

代码块展示一个简单的LSTM单元的实现:

```python

import torch

import torch.nn as nn

class LSTMCell(nn.Module):

def __init__(self, input_size, hidden_size):

super(LSTMCell, self).__init__()

self.input_size = input_size

self.hidden_size = hidden_size

self遗忘门 = nn.Linear(input_size + hidden_size, hidden_size)

self输入门 = nn.Linear(input_size + hidden_size, hidden_size)

self输出门 = nn.Linear(input_size + hidden_size, hidden_size)

def forward(self, input, state):

state = state if state is not None else torch.zeros(self.hidden_size)

combined = torch.cat([input, state], dim=1)

f = torch.sigmoid(self.遗忘门(combined))

i = torch.sigmoid(self.输入门(combined))

o = torch.sigmoid(self.输出门(combined))

c = f * state + i * torch.tanh(input)

h = o * torch.tanh(c)

return h, c

# LSTMCell实例化及参数说明

lstm_cell = LSTMCell(input_size=10, hidden_size=20)

# 输入和初始状态

input_tensor = torch.randn(1, 10)

initial_hidden_state = torch.randn(1, 20)

initial_cell_state = torch.randn(1, 20)

# 前向传播获取输出状态和新细胞状态

output, new_state = lstm_cell(input_tensor, (initial_hidden_state, initial_cell_state))

```

### 3.1.2 门控循环单元(GRU)

门控循环单元(Gated Recurrent Unit, GRU)是一种较LSTM更为简化的RNN变体,其核心思想是将隐藏状态分解为更新门(update gate)和重置门(reset gate)来控制信息流。

更新门决定保留多少历史信息,重置门则控制新的输入信息中哪些是重要的。GRU通过减少门的数量来简化结构和计算,同时也减少了模型参数的数量。

以下是GRU的一个基本实现:

```python

class GRUCell(nn.Module):

def __init__(self, input_size, hidden_size):

super(GRUCell, self).__init__()

self.input_size = input_size

self.hidden_size = hidden_size

self.重置门 = nn.Linear(input_size + hidden_size, hidden_size)

self.更新门 = nn.Linear(input_size + hidden_size, hidden_size)

self.候选隐藏状态 = nn.Linear(input_size + hidden_size, hidden_size)

def forward(self, input, hidden):

combined = torch.cat([input, hidden], dim=1)

r = torch.sigmoid(self.重置门(combined))

z = torch.sigmoid(self.更新门(combined))

n = torch.tanh(self.候选隐藏状态(torch.cat([input, r * hidden], dim=1)))

h = (1 - z) * n + z * hidden

return h

# GRUCell实例化及参数说明

gru_cell = GRUCell(input_size=10, hidden_size=20)

# 输入和初始状态

input_tensor = torch.randn(1, 10)

initial_hidden_state = torch.randn(1, 20)

# 前向传播获取输出状态

output = gru_cell(input_tensor, initial_hidden_state)

```

### 3.2 RNN变种在时间序列中的应用

#### 3.2.1 双向RNN与注意力机制

双向RNN(Bidirectional RNN)能够捕捉序列的双向上下文信息。在时间序列预测中,这意味着模型可以从过去和未来的信息中同时学习,以提供更为准确的预测。

注意力机制(Attention Mechanism)允许模型在处理序列数据时,动态地关注到序列中某些特定的部分,这对于处理长序列尤其有效。

以下是双向RNN与注意力机制结合的代码示例:

```python

class Attention(nn.Module):

def __init__(self):

super(Attention, self).__init__()

self.attention_score = nn.Linear(20, 1)

def forward(self, hidden_states):

# 这里简化表示,隐藏状态的维度应和线性层输出一致

score = torch.softmax(self.attention_score(hidden_states), dim=0)

attended = score * hidden_states

return attended.sum(0)

class BiGRU(nn.Module):

def __init__(self, input_size, hidden_size):

super(BiGRU, self).__init__()

self.gru = nn.GRU(input_size, hidden_size, batch_first=True, bidirectional=True)

self.attention = Attention()

def forward(self, input_tensor):

gru_output, _ = self.gru(input_tensor)

attention_output = self.attention(gru_output)

return attention_output

# 实例化双向GRU模型

bigru = BiGRU(input_size=10, hidden_size=20)

# 假设有一序列数据用于前向传播

input_sequence = torch.randn(1, 5, 10)

output = bigru(input_sequence)

```

#### 3.2.2 时序预测中的深度学习融合技术

在时间序列预测中,深度学习模型之间可以相互融合以增强预测能力。例如,卷积神经网络(CNN)可以处理局部特征提取,而RNN则擅长处理序列数据,两者结合可相互补充。

以下是一个简单的CNN和RNN融合模型示例:

```python

class CNNRNN(nn.Module):

def __init__(self, input_channels, hidden_size):

super(CNNRNN, self).__init__()

self.cnn = nn.Conv1d(in_channels=input_channels, out_channels=hidden_size, kernel_size=3, padding=1)

self.rnn = nn.GRU(hidden_size, hidden_size, batch_first=True)

def forward(self, input_tensor):

# 假设input_tensor形状为(batch_size, seq_length, input_channels)

x = input_tensor.transpose(1, 2) # 转换为适合CNN处理的形状(batch_size, input_channels, seq_length)

cnn_out = self.cnn(x)

rnn_out, _ = self.rnn(cnn_out.transpose(1, 2)) # 还原形状并送入RNN

return rnn_out

# 实例化CNN和RNN的融合模型

cnn_rnn = CNNRNN(input_channels=10, hidden_size=20)

input_tensor = torch.randn(1, 5, 10) # 假设有一个长度为5的序列数据

output = cnn_rnn(input_tensor)

```

### 3.3 模型优化技巧

#### 3.3.1 正则化与Dropout策略

为了防止模型过拟合,正则化技术如L1和L2正则化在训练过程中非常关键。此外,Dropout技术通过在训练中随机丢弃一部分神经元,迫使网络学习更为鲁棒的特征表示。

代码示例:

```python

class DropoutRNN(nn.Module):

def __init__(self, input_size, hidden_size):

super(DropoutRNN, self).__init__()

self.rnn = nn.GRU(input_size, hidden_size, batch_first=True)

self.dropout = nn.Dropout(0.5)

def forward(self, input_tensor):

rnn_out, _ = self.rnn(input_tensor)

dropped = self.dropout(rnn_out)

return dropped

# 实例化带有Dropout的RNN模型

dropout_rnn = DropoutRNN(input_size=10, hidden_size=20)

output = dropout_rnn(input_tensor)

```

#### 3.3.2 梯度消失与爆炸的应对措施

梯度消失和梯度爆炸是训练深度神经网络时经常遇到的问题。梯度消失可以通过使用权重初始化策略和增加非线性激活函数来缓解。而梯度爆炸可以通过梯度裁剪(Gradient Clipping)或使用特定的优化器如RMSprop或Adam来处理。

逻辑分析:

- 权重初始化策略如Xavier初始化,通过选择合适的初始化方法,让数据流经网络时,每一层的方差保持在合理范围内,帮助缓解梯度消失问题。

- 梯度裁剪通过限制梯度的最大值来防止梯度爆炸。

- 优化器的选择应根据实际问题和数据特性来决定,例如Adam优化器结合了RMSprop和Momentum的特性,适应性较强。

具体操作:

- 使用`torch.nn.init.xavier_uniform_`或`torch.nn.init.xavier_normal_`对权重进行初始化。

- 在反向传播过程中使用`torch.nn.utils.clip_grad_norm_`来裁剪梯度。

- 选择适当的优化器进行参数更新,例如`torch.optim.Adam`。

参数说明:

- `xavier_uniform_`函数的`gain`参数控制初始化的比例,常用的值为`nn.init.calculate_gain('relu')`。

- `clip_grad_norm_`函数中的`max_norm`参数定义了梯度裁剪的最大值,通常设置为1.0或5.0等。

# 4. RNN在时间序列预测中的实战应用

## 4.1 数据预处理与特征工程

### 4.1.1 数据清洗与规范化

在开始进行时间序列预测之前,必须首先对数据进行清洗和规范化,以确保模型训练的准确性和效率。数据清洗涉及移除噪声、填补缺失值、去除异常值以及转换数据格式等步骤。规范化则是将数据调整到一个统一的尺度,这在使用梯度下降方法时尤其重要。

对于时间序列数据,常见的预处理手段包括对数转换、差分、季节性调整等。例如,对数转换可以减少数据的波动性,而差分可以帮助平稳化时间序列数据。季节性调整通常用于去除季节性波动,以获得数据的趋势成分。

#### 示例代码块

```python

import pandas as pd

from sklearn.preprocessing import MinMaxScaler

# 加载数据集

data = pd.read_csv('timeseries_data.csv')

# 填补缺失值

data.fillna(method='ffill', inplace=True)

# 对数转换以稳定方差

data['log_value'] = np.log(data['value'])

# 规范化数据到[0, 1]区间

scaler = MinMaxScaler()

data['scaled_value'] = scaler.fit_transform(data[['log_value']])

# 输出处理后的数据

print(data[['scaled_value']])

```

在上述代码中,我们首先读取了一个名为`timeseries_data.csv`的数据集,填补了其中的缺失值,并对目标值进行了对数转换,以减少方差。之后,我们使用`MinMaxScaler`将数据规范化到[0, 1]区间。规范化是建立时间序列模型前的一个重要步骤,因为它可以加快模型收敛速度并提高预测性能。

### 4.1.2 特征选择与特征构造

在时间序列分析中,选择合适的特征对于模型的性能至关重要。特征选择通常涉及识别和排除对预测任务贡献最小的特征,以简化模型。特征构造则是基于现有数据创建新的特征,以捕捉时间序列中的趋势和季节性等模式。

在实践中,常用的方法包括滞后特征(lag features)、滚动统计量(rolling statistics)、移动平均(moving averages)以及周期性特征(cyclical features)。例如,滞后特征可以通过查看目标变量在前几个时间点的值来增加信息量。

#### 示例代码块

```python

# 创建滞后特征

for i in range(1, 4):

data[f'lag_{i}'] = data['scaled_value'].shift(i)

# 计算滚动平均

data['rolling_mean'] = data['scaled_value'].rolling(window=3).mean()

# 构造周期性特征

data['day_of_week'] = data['date'].dt.dayofweek

data['day_of_year'] = data['date'].dt.dayofyear

# 输出处理后的数据

print(data.head(10))

```

在上面的代码中,我们通过`shift`函数创建了几个滞后特征,这可以帮助模型学习时间序列中的动态特征。我们还计算了滚动平均来平滑短期波动,这有助于捕捉长期趋势。最后,我们创建了基于日期的周期性特征,这些特征可以用来捕捉如季节性变化等周期性模式。通过特征构造,我们可以显著提高时间序列预测模型的性能。

# 5. RNN的时间序列预测案例研究

## 5.1 金融市场的预测实例

### 5.1.1 股票价格走势预测

股票市场的价格走势预测是一个典型的非线性时间序列预测问题,其中股票价格的波动不仅受到市场因素的影响,还包括了投资者情绪、公司业绩、宏观经济指标等多个方面的综合作用。RNN因其在处理序列数据方面的独特优势,成为了预测股票价格走势的有效工具。

在这个案例中,我们首先需要从历史数据中提取出股票价格的时间序列数据,并进行必要的预处理。预处理过程包括但不限于数据清洗、去除缺失值、归一化处理等。然后,我们将使用PyTorch框架构建RNN模型来学习股票价格的历史走势,并基于此预测未来的股票价格。

```python

import torch

import torch.nn as nn

class RNNModel(nn.Module):

def __init__(self, input_size, hidden_size, num_layers, output_size):

super(RNNModel, self).__init__()

self.hidden_size = hidden_size

self.num_layers = num_layers

self.rnn = nn.RNN(input_size, hidden_size, num_layers, batch_first=True)

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, x):

h0 = torch.zeros(self.num_layers, x.size(0), self.hidden_size).to(x.device)

out, _ = self.rnn(x, h0)

out = self.fc(out[:, -1, :])

return out

```

在上述代码中,`RNNModel`类定义了一个简单的RNN模型。模型的输入是股票价格的时间序列数据,模型通过RNN层学习时间序列中的特征,并在最后通过全连接层输出预测结果。在这里,我们假设输入的时间序列数据是一个包含多个时间点的股票价格,而`output_size`则表示我们预测的未来时间点的数量。

### 5.1.2 经济指标的预测分析

除了股票价格走势,经济指标也是金融市场预测中的一个重要方面。例如,国内生产总值(GDP)、消费者价格指数(CPI)、失业率等指标都是投资者和政策制定者关注的焦点。这些指标的走势不仅反映了经济状况,也对金融市场有着深远的影响。

与股票价格走势预测类似,预测经济指标同样需要对历史时间序列数据进行分析。在构建模型时,我们同样采用RNN模型来处理这些序列数据。经济指标的预测分析面临的挑战在于指标之间的相互关系以及外部因素的影响。因此,在模型中加入多维输入和外部变量可能有助于提高预测的准确性。

```python

import pandas as pd

# 加载数据集

data = pd.read_csv('economic_data.csv')

# 预处理数据,例如进行数据归一化

data_normalized = (data - data.mean()) / data.std()

# 转换为时间序列格式

timeseries = data_normalized.values

# 划分数据集为训练集和测试集

train_data = timeseries[:int(0.8 * len(timeseries))]

test_data = timeseries[int(0.8 * len(timeseries)):]

# 假设我们只预测下一个时间点的指标值

# 因此输入为一个时间点的数据,输出也为一个时间点的数据

def create_dataset(data, time_step=1):

X, Y = [], []

for i in range(len(data) - time_step - 1):

a = data[i:(i + time_step), :]

X.append(a)

Y.append(data[i + time_step, :])

return np.array(X), np.array(Y)

X_train, Y_train = create_dataset(train_data)

X_test, Y_test = create_dataset(test_data)

# 定义模型

model = RNNModel(input_size=features, hidden_size=hidden_size, num_layers=num_layers, output_size=features)

# 训练模型...

```

在上述伪代码中,我们首先加载了经济指标的数据集,并进行了归一化处理。接着,我们划分数据集为训练集和测试集,并定义了用于数据预处理的`create_dataset`函数。最后,我们定义了一个RNN模型来预测经济指标,并准备进行训练。

通过这些案例,我们可以看到RNN在金融市场预测中的应用是多方面的,其灵活性和强大的时间序列处理能力使得它成为处理此类问题的有力工具。同时,随着模型结构和参数调优的深入,模型的预测能力可以得到进一步的提升。

## 5.2 自然语言处理中的应用

### 5.2.1 文本生成模型

文本生成是自然语言处理(NLP)领域的一个热门研究方向,其目标是利用计算机自动产生连贯、有意义的文本内容。文本生成的任务可以应用在许多实际场景中,如自动撰写新闻报道、创作诗歌和小说、聊天机器人等。

RNN由于其在处理序列数据上的优势,尤其适合于这类任务。其内部的循环连接使得模型能够记忆序列中的信息,并基于这些记忆生成新的序列数据。一个典型的文本生成模型可以分为编码器和解码器两部分。编码器负责理解输入文本的语义信息,而解码器则负责生成新的文本序列。

```python

class TextGenerationRNN(nn.Module):

def __init__(self, vocab_size, embed_dim, hidden_dim):

super(TextGenerationRNN, self).__init__()

self.embedding = nn.Embedding(vocab_size, embed_dim)

self.rnn = nn.RNN(embed_dim, hidden_dim, batch_first=True)

self.fc = nn.Linear(hidden_dim, vocab_size)

def forward(self, input_seq, hidden):

embedded = self.embedding(input_seq)

output, hidden = self.rnn(embedded, hidden)

output = self.fc(output)

return output, hidden

def init_hidden(self, batch_size):

# 初始化隐藏层状态

return torch.zeros(1, batch_size, self.rnn.hidden_size)

```

在这个例子中,我们定义了一个简单的文本生成RNN模型。模型由嵌入层、RNN层和全连接层组成。嵌入层将输入的单词索引映射到稠密的向量表示中,RNN层负责捕捉文本的时序特征,最后全连接层用于生成下一个单词的概率分布。

### 5.2.2 语言模型的构建与应用

语言模型是NLP的另一个重要任务,其目标是为自然语言的序列数据建立概率模型。语言模型可以帮助我们评估一个句子的概率,或者在给定前几个单词的情况下预测下一个最可能出现的单词。语言模型在许多NLP任务中都有广泛的应用,如机器翻译、语音识别、拼写检查等。

RNN在构建语言模型时,通过隐藏层的循环连接来学习序列数据的依赖关系,并为单词序列生成概率分布。这种模型通常被训练在一个大规模的语料库上,以学会语言的统计特性。

```python

# 假设我们有一个训练好的RNN模型用于语言模型的构建

model = TextGenerationRNN(vocab_size, embed_dim, hidden_dim)

# 使用训练好的模型计算句子的对数概率

def compute_log_probability(model, input_seq):

# 初始化隐藏层状态

hidden = model.init_hidden(1)

log_probs = torch.zeros(input_seq.size(1))

input_seq = input_seq.t()

for t in range(input_seq.size(0)):

output, hidden = model(input_seq[t], hidden)

log_probs += nn.functional.log_softmax(output[-1], dim=1)

return log_probs.sum()

# 计算一个句子的对数概率

input_seq = torch.tensor([[1, 2, 3, 4, 5]], dtype=torch.long) # 假设这是句子的单词索引

log_prob = compute_log_probability(model, input_seq)

```

在上述代码中,我们定义了一个函数`compute_log_probability`来计算给定单词序列的对数概率。这个函数接受模型和输入序列作为参数,并通过遍历序列中的每个单词,计算整体的对数概率。

RNN在语言模型的构建中,不仅可以捕捉到词汇之间的顺序关系,还可以通过长距离依赖关系学习到复杂的语义信息。随着深度学习的发展,RNN在语言模型中的表现也得到了显著的提升,特别是在与注意力机制和Transformer架构结合后。

通过上述案例研究,我们展示了RNN在时间序列预测和自然语言处理中的应用。从金融市场的走势预测到经济指标的预测分析,再到文本生成模型和语言模型的构建,RNN都展现出了其独特的优势和潜力。随着深度学习技术的不断进步,我们可以预见RNN及其变种将继续在各类预测和生成任务中发挥重要作用。

# 6. 未来趋势与展望

随着深度学习的不断进步,RNN以及时间序列预测领域同样面临着新的发展趋势与挑战。本章节将展望未来RNN技术与时间序列预测的发展方向,并探讨这些趋势将如何影响研究与实际应用。

## 6.1 RNN与新兴技术的结合

### 6.1.1 RNN与其他深度学习模型的结合应用

RNN与深度学习中的其他模型,比如卷积神经网络(CNN)和Transformer,可以实现跨领域的功能互补。例如,CNN擅长捕捉局部特征,而RNN则能够处理时间序列数据的时序依赖性。通过将RNN与CNN结合,可以构建更加强大的混合模型,这种模型在处理视频数据、语音识别等领域表现尤为出色。

在实际应用中,我们可以将RNN与CNN结合起来处理时空数据,如交通流量预测。RNN处理时间序列的时序依赖,CNN则可以从空间上提取局部相关性。

```python

from torch.nn import RNN, Conv2d

# 创建RNN模型参数

rnn_hidden_size = 128

rnn_num_layers = 2

# 创建RNN层

rnn_layer = RNN(input_size=10, hidden_size=rnn_hidden_size, num_layers=rnn_num_layers)

# 创建CNN模型参数

conv_kernel_size = (3, 3)

conv_out_channels = 32

# 创建CNN层

conv_layer = Conv2d(in_channels=1, out_channels=conv_out_channels, kernel_size=conv_kernel_size)

# 将数据流经过CNN层,再传递给RNN层

def combined_cnn_rnn(input_data):

# 假设input_data是形如[batch_size, seq_len, channels, height, width]的5D张量

conv_out = conv_layer(input_data)

# 将5D张量转换为适合RNN处理的3D张量

batch_size, seq_len, channels, height, width = input_data.size()

conv_out = conv_out.view(batch_size, seq_len, channels * height * width)

rnn_out, _ = rnn_layer(conv_out)

return rnn_out

# 示例输入数据

batch_size = 10

seq_len = 5

channels = 1

height = 64

width = 64

input_data = torch.randn(batch_size, seq_len, channels, height, width)

# 前向传播

output = combined_cnn_rnn(input_data)

```

### 6.1.2 RNN在边缘计算中的潜在角色

边缘计算要求数据在本地设备(如IoT设备)上进行实时处理,这要求模型既轻量又高效。RNN因其在序列数据处理上的优势,可以被用于设计轻量级的边缘计算模型。例如,针对智能监控系统进行实时事件检测和预测。

利用RNN的轻量级变种,如LSTM和GRU,可以在保持模型性能的同时,减少计算资源的消耗。在边缘设备上,这些模型可以处理实时数据流,并将结果快速上传至云端或直接作出响应,这对于延迟敏感的应用来说至关重要。

## 6.2 时间序列预测的研究方向

### 6.2.1 无监督学习与半监督学习在时间序列中的应用

目前,时间序列预测多依赖于监督学习方法,这需要大量的标注数据。然而,在很多实际场景中,标注数据成本高昂且难以获得。因此,无监督学习和半监督学习成为研究热点。无监督学习可以揭示数据的内在结构和模式,半监督学习可以在有限的标签下提高预测的准确度。

例如,无监督学习中的自编码器和变分自编码器(VAE)可以用于时间序列数据的降噪和特征提取,而半监督学习可以通过标签传播算法将少量标注数据的效果推广至整个数据集。

### 6.2.2 模型可解释性与可信度的提升

时间序列预测的模型可解释性在某些关键领域(如医疗和金融)尤为重要。提升模型的可解释性意味着我们可以更好地理解模型的预测决策,进而增强对模型预测结果的信任。

为实现可解释性,研究人员通常会结合领域知识构建预测模型,或者在现有模型的基础上增加可解释性模块。例如,注意力机制可以揭示RNN在预测过程中关注的数据点,这有助于提高模型的透明度和可解释性。

在这一领域中,我们期望看到更多创新的研究成果,比如利用因果推断理论来理解时间序列数据中的因果关系,或通过可视化技术来呈现模型如何做出特定预测。

通过不断的技术迭代和模型创新,RNN将在未来继续在时间序列预测中发挥其独特的价值。同时,随着人工智能的不断进展,新的算法和研究方向将不断涌现,为RNN技术的发展注入新的活力。

0

0