【日志分析】:Landmark & Wellplan 日志信息深度挖掘术

发布时间: 2024-12-13 22:45:29 阅读量: 3 订阅数: 10

landmark&wellplan教程.pdf

参考资源链接:[Landmark & Wellplan教程:钻井深度与水力参数设计](https://wenku.csdn.net/doc/216ebc28f5?spm=1055.2635.3001.10343)

# 1. 日志分析的基础知识

在开始深入探讨Landmark日志与Wellplan日志之前,我们必须首先建立日志分析的基础知识。本章节将简要介绍日志分析的重要性以及它在IT行业中的普遍应用。我们将讨论日志数据的基本概念,包括日志文件的类型和它们在系统监控、安全监控以及业务分析中的作用。此外,本章还将介绍日志分析的基本流程和分析日志时常用的技术,为后续章节中更高级主题的讨论打下坚实的基础。

## 1.1 日志数据的重要性

日志数据记录了系统运行状态、用户行为以及安全事件等关键信息。在进行故障排查、安全审计或性能优化时,能够提供关键线索。日志的重要性随着系统复杂度的增加而提升,它有助于保持系统的稳定性和安全性。

## 1.2 日志的类型

日志文件的类型多种多样,常见的包括系统日志、应用程序日志、安全日志和网络日志等。了解不同日志类型的特点和使用场景对于进行有效的日志分析至关重要。

## 1.3 日志分析的基本流程

从收集日志数据开始,到日志存储、处理、分析,直至生成报告和警报,日志分析流程涉及多个环节。本节将概览这些环节,并介绍自动化日志分析工具的作用,为读者理解后续章节中复杂的日志处理技术奠定基础。

# 2. Landmark日志的理论基础与实践技巧

## 2.1 Landmark日志数据结构解析

### 2.1.1 日志数据的格式和组成

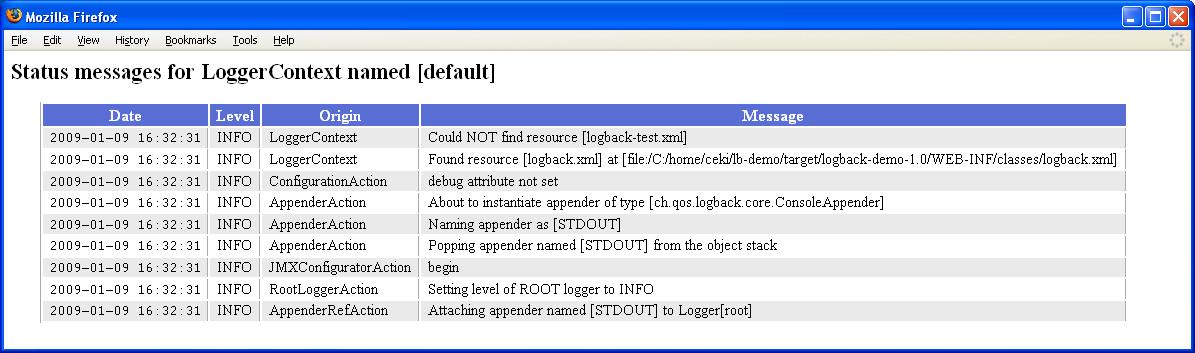

Landmark日志是IT系统中用于记录各种运行事件和状态的文本文件。这些日志对于故障诊断、性能监控和审计等场景至关重要。一个典型的Landmark日志条目通常包括以下几个关键部分:

- 时间戳:记录日志事件发生的确切时间。

- 严重性级别:表明事件的紧急程度,例如INFO、WARN、ERROR等。

- 源标识:标识产生日志的组件或模块。

- 消息内容:具体描述事件的文本信息,可能包括变量和上下文数据。

日志数据的格式在不同的系统和工具中可能有所差异,但通常遵循某种标准化的结构,如JSON或XML,以方便解析和处理。

### 2.1.2 关键字段和信息提取方法

为了从Landmark日志中提取有用的信息,首先需要了解如何从日志文本中识别关键字段。这通常涉及正则表达式匹配和文本解析技术。

一个简单的例子,假设我们有以下日志条目:

```

2023-04-01T12:01:01Z INFO module_name[1234]: User 'JohnDoe' logged in from IP 192.168.1.10

```

我们可以使用以下Python代码提取关键字段:

```python

import re

log_entry = "2023-04-01T12:01:01Z INFO module_name[1234]: User 'JohnDoe' logged in from IP 192.168.1.10"

pattern = re.compile(r"(\d{4}-\d{2}-\d{2}T\d{2}:\d{2}:\d{2}Z) (INFO|WARN|ERROR) (\w+)\[(\d+)\]: (.*)")

match = pattern.match(log_entry)

if match:

timestamp, severity, module, pid, message = match.groups()

print(f"Timestamp: {timestamp}")

print(f"Severity: {severity}")

print(f"Module: {module}")

print(f"Process ID: {pid}")

print(f"Message: {message}")

```

以上代码块中的正则表达式定义了日志条目的各个组成部分,包括时间戳、严重性级别、模块名称、进程ID和消息内容。每个部分都被捕获并打印出来。

### 2.2 Landmark日志的深度分析技术

#### 2.2.1 日志模式识别与分类

深度分析技术之一是自动识别和分类日志模式。这通常通过模式识别和机器学习算法实现,能够从大量日志数据中提取有用信息。例如,一个简单的分类系统可以基于日志消息内容,区分出是正常事件还是异常事件。

使用Python和scikit-learn库,我们可以训练一个简单的文本分类器:

```python

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.naive_bayes import MultinomialNB

from sklearn.pipeline import make_pipeline

# 假设我们有以下日志样本

log_samples = [

"2023-04-01T12:01:01Z INFO module_name[1234]: User 'JohnDoe' logged in from IP 192.168.1.10",

"2023-04-01T12:01:02Z ERROR module_name[1235]: Database connection failed",

"2023-04-01T12:01:03Z WARN module_name[1236]: Low disk space on server",

# ... 更多日志样本 ...

]

# 将日志样本标记为正常或异常

labels = ['normal', 'error', 'warning', ...]

# 创建一个管道,包含向量化器和分类器

log_classifier = make_pipeline(CountVectorizer(), MultinomialNB())

# 训练模型

log_classifier.fit(log_samples, labels)

# 使用训练好的模型进行预测

predicted_labels = log_classifier.predict(log_samples)

```

通过训练和预测,这个分类器能够学习识别不同的日志模式,并对新的日志条目进行分类。

#### 2.2.2 大数据环境下的日志处理流程

在大数据环境下,日志处理流程涉及从数据源收集日志,将其传输到处理系统中,然后进行解析、存储、分析和可视化。Apache Kafka和Apache Flume是两个广泛使用的大数据日志收集工具,能够高效地处理大量日志数据。

处理流程的一般步骤如下:

1. **日志收集**:使用日志收集工具将日志数据从源头传输到中央处理系统。

2. **数据转换**:通过数据格式化工具,如Apache Avro或Apache Parquet,转换数据格式,以提高存储效率。

3. **日志解析**:解析工具将日志数据分解为结构化的形式,便于后续处理。

4. **数据分析**:利用大数据分析工具,如Apache Spark或Apache Flink,进行日志数据的深度分析。

5. **数据存储**:将处理好的数据存储在大数据存储系统中,例如HDFS或NoSQL数据库。

6. **可视化和报告**:最后,使用可视化工具展示分析结果,并生成报告供进一步决策。

## 2.3 Landmark日志的分析工具和应用案例

### 2.3.1 日志分析工具的选择与使用

选择合适的日志分析工具对于有效管理和利用日志数据至关重要。市面上有众多的日志分析工具,包括开源和商业产品。下面是一些广泛使用的日志分析工具:

- **ELK Stack** (Elasticsearch, Logstash, Kibana)

- **Splunk**

- **Graylog**

- **LogDNA**

- **Syslog-ng**

这些工具各有特点,但通常都包括数据收集、索引、搜索、可视化和报警等功能。以ELK Stack为例,Logstash用于收集和解析日志数据,Elasticsearch作为搜索引擎对日志数据进行索引和存储,而Kibana用于日志数据的可视化和交互式分析。

一个典型的ELK Stack部署流程可能包括以下步骤:

1. **安装和配置**:在服务器上安装ELK Stack的各个组件,并进行适当的配置。

2. **数据输入**:通过Logstash配置文件定义数据来源和解析规则。

3. **数据存储**:设置Elasticsearch集群,确定索引模式和分片策略。

4. **数据查询和可视化**:在Kibana中创建仪表板,进行数据查询和可视化。

### 2.3.2 成功案例分析

假设有一个中型电子商务公司,它部署了一个分布式系统,该系统每天产生数TB的日志数据。为了更好地管理和分析这些日志数据,公司决定使用ELK Stack。

部署之后,公司能够:

- **实时监控**:通过Kibana的实时监控功能,管理员可以快速查看系统运行状态。

- **故障诊断**:利用Logstash收集的日志数据,通过Elasticsearch强大的查询能力,快速定位故障源。

- **业务分析**:结合业务数据,使用Kibana创建图表和仪表板,分析用户行为和系统性能。

通过ELK Stack的部署,公司提高了日志数据管理的效率,降低了运营成本,并提升了客户服务质量。

### 2.3.3 实际操作步骤

下面是一个简化的操作流程,展示如何使用ELK Stack进行日志分析:

1. **安装Elasticsearch**:根据官方文档,在集群服务器上安装和配置Elasticsearch。

2. **安装Kibana**:在服务器上安装Kibana,并配置与Elasticsearch的通信。

3. **安装和配置Logstash**:安装Logstash,并创建管道配置文件以收集和解析日志。

4. **日志数据导入**:将日志数据输入Logstash,进行清洗和转换。

5. **使用Kibana进行分析**:通过Kibana的仪表板功能,创建查询和可视化图表。

通过这些步骤,用户可以实现对大量日志数据的有效管理和分析。ELK Stack的灵活性和可扩展性使其成为日志分析领域的强大工具。

# 3. Wellplan日志的理论基础与实践技巧

## 3.1 Wellplan日志数据结构解析

### 3.1.1 日志数据的格式和组成

Wellplan日志通常遵循特定的格式和结构,以便于快速解析和分析。日志数据通常由时间戳、日志级别、消息以及可能的上下文信息组成。时间戳标识了事件发生的具体时间,日志级别提供事件的紧急程度或重要性,消息则详细描述了事件内容。在Wellplan日志中,还可能包括诸如源文件名、源代码行号、线程ID等上下文信息,有助于追踪问题来源。

一个典型的Wellplan日志格式可能如下所示:

```plaintext

2023-03-29 12:34:56.789 [DEBUG] application.py:123 - DEBUG: Some debug information

```

在这里,`DEBUG` 是日志级别,`application.py:123` 指明了消息的来源,而 `-` 后面的内容是日志消息本身。

### 3.1.2 关键字段和信息提取方法

在Wellplan日志中,关键字段包括时间戳、日志级别、消息等。信息提取是指利用这些字段中的信息进行有效分析的过程。例如,通过识别特定的时间戳,可以对系统进行时间序列分析,而通过日志级别的分布可以评估系统健康状态。

信息提取可以通过编写正则表达式或者使用日志解析工具实现。以下是一个简单的Python脚本,演示如何从一段日志中提取关键信息:

```python

import re

log_entry = "2023-03-29 12:34:56.789 [DEBUG] application.py:123 - DEBUG: Some debug information"

# 正则表达式来匹配日志格式

match = re.match(r'(\d{4}-\d{2}-\d{

```

0

0