联邦学习:打破数据孤岛,实现协作式云服务,云计算的未来

发布时间: 2024-08-23 04:10:59 阅读量: 94 订阅数: 28

1. 联邦学习概览

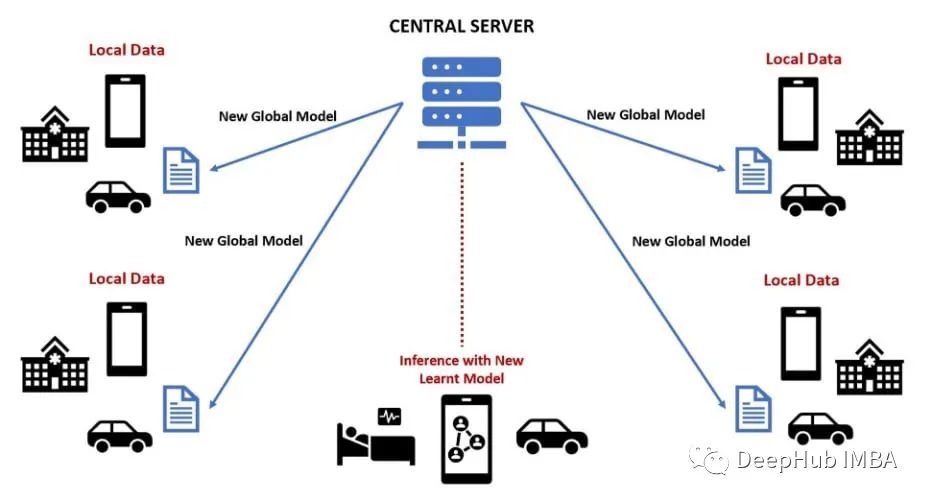

联邦学习是一种分布式机器学习范式,允许在不共享原始数据的情况下,从多个参与方联合训练机器学习模型。它旨在解决数据隐私和安全问题,同时利用来自不同来源的数据丰富模型。

联邦学习的独特之处在于,它允许参与方在本地训练模型,并仅共享模型更新,而不是原始数据。通过这种方式,数据隐私得到保护,同时仍能利用集体数据的力量来训练更准确和鲁棒的模型。

联邦学习的应用广泛,从医疗保健到金融再到自动驾驶,它为解决传统机器学习方法无法解决的现实世界问题提供了新的可能性。

2. 联邦学习的理论基础

2.1 联邦学习的起源和发展

联邦学习(Federated Learning,FL)起源于分布式机器学习,是一种分布式机器学习框架,它使多个参与者可以在不共享原始数据的情况下共同训练机器学习模型。FL 最初是由谷歌在 2016 年提出的,旨在解决移动设备上训练机器学习模型的挑战,同时保护用户隐私。

FL 的发展经历了以下几个阶段:

- **2016 年:**谷歌提出 FL 概念,并发布了第一个 FL 框架 TensorFlow Federated。

- **2017-2018 年:**学术界和工业界对 FL 的研究和应用迅速增长,提出了各种 FL 算法和系统。

- **2019 年至今:**FL 进入快速发展阶段,在医疗、金融、制造等多个领域得到广泛应用,并成为云计算平台的重要服务。

2.2 联邦学习的隐私保护机制

FL 的核心是隐私保护,它采用以下机制来保护参与者的数据隐私:

- **数据本地化:**参与者在本地训练模型,不共享原始数据。

- **加密技术:**数据在传输和存储过程中进行加密,防止未经授权的访问。

- **差分隐私:**在模型训练过程中添加噪声,以降低对个体数据的敏感性。

- **联邦平均:**将参与者本地训练的模型参数进行加权平均,生成全局模型,而不会暴露原始数据。

2.3 联邦学习的算法设计

FL 的算法设计面临以下挑战:

- **异构性:**参与者拥有不同的数据分布、计算能力和网络连接。

- **通信效率:**模型训练需要在参与者之间进行多次通信,通信成本成为瓶颈。

- **隐私保护:**算法必须在保护隐私的同时,保证模型的准确性。

FL 算法的设计主要集中在以下方面:

- **模型压缩:**减少模型大小,降低通信成本。

- **局部更新:**只更新模型的一部分参数,减少通信量。

- **联邦平均算法:**高效地聚合参与者本地训练的模型参数。

代码块 1:联邦平均算法

代码逻辑分析:

该代码块实现了联邦平均算法。它遍历参与者本地训练的模型,并对每个模型的每一层进行加权平均。权重是参与者本地模型权重和全局模型权重的平均值。

参数说明:

local_models:参与者本地训练的模型列表。global_model:全局模型。

3.1 联邦学习在医疗领域的应用

联邦学习在医疗领域具有广阔的应用前景,它可以解决医疗数据隐私保护和医疗模型联合训练的难题。

3.1.1 医疗数据的隐私保护

医疗数据包含大量敏感信息,如患者病历、基因信息等。传统的数据共享方式存在隐私泄露的风险。联邦学习通过在不共享原始数据的情况下进行模型训练,有效保护了医疗数据的隐私。

具体操作步骤:

- 每个参与方(医院、研究机构等)将自己的医疗数据本地加密。

- 参与方将加密后的数据上传到联邦服务器。

- 联邦服务器使用联邦学习算法在加密数据上进行模型训练。

- 训练完成后,联邦服务器将训练好的模型返回给参与方。

- 参与方使用自己的密钥解密模型,并应用于本地数据进行预测。

代码块:

- import numpy as np

- import tensorflow as tf

- # 医疗数据加密函数

- def encrypt(data):

- return np.random.rand(*data.shape)

- # 联邦学习模型训练函数

- def train_model(encrypted_data):

- model = tf.keras.Sequential()

- model.add(tf.keras.layers.Dense(10, activation='relu'))

- model.add(tf.keras.layers.Dense(1, activation='sigmoid'))

- model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['acc

0

0