联邦学习:隐私保护的艺术,在数据共享中保障安全

发布时间: 2024-08-23 03:41:51 阅读量: 24 订阅数: 38

# 1. 联邦学习概述**

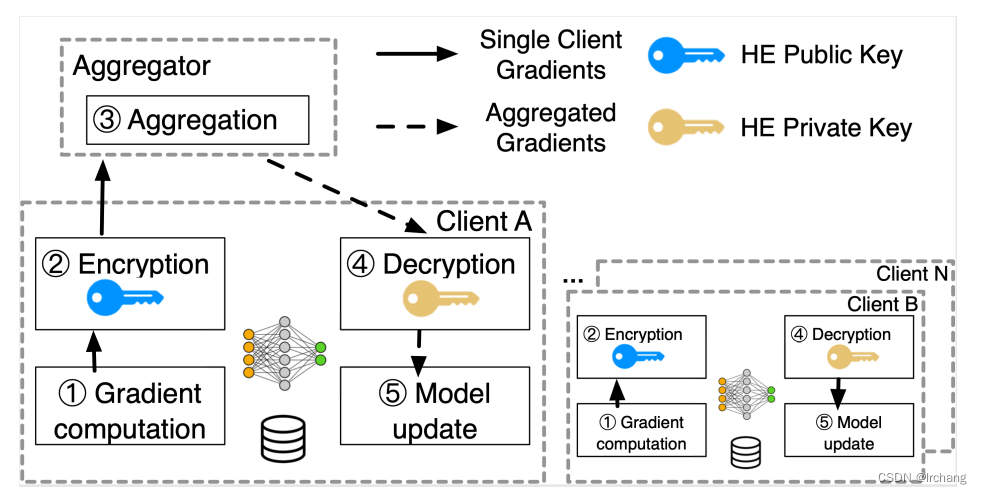

联邦学习是一种分布式机器学习技术,它允许多个参与者在不共享原始数据的情况下共同训练一个模型。这种方法解决了数据隐私和安全问题,使参与者能够协作开发模型,同时保护其敏感数据。

联邦学习的运作原理是,每个参与者在本地训练模型,然后将更新的模型参数共享给中央服务器。中央服务器聚合这些更新,并使用它们来更新全局模型。这个过程重复进行,直到全局模型收敛。

联邦学习提供了一种在数据共享和隐私保护之间取得平衡的方法。它使参与者能够利用集体数据来训练强大的模型,同时最大限度地减少数据泄露的风险。

# 2. 联邦学习理论基础

### 2.1 隐私保护机制

联邦学习的核心在于在不共享原始数据的情况下协作训练模型。为了保护数据隐私,联邦学习采用了多种隐私保护机制:

**2.1.1 差分隐私**

差分隐私是一种数学技术,它通过添加噪声来扰乱数据,从而保护个人隐私。它确保即使攻击者可以访问整个数据集,也无法确定任何个体的数据。

**代码块:**

```python

import numpy as np

def add_noise(data, epsilon):

"""

向数据添加差分隐私噪声。

参数:

data:原始数据。

epsilon:隐私预算。

返回:

添加噪声后的数据。

"""

noise = np.random.laplace(scale=1 / epsilon, size=data.shape)

return data + noise

```

**逻辑分析:**

此代码块使用 NumPy 的 `laplace()` 函数向数据添加拉普拉斯噪声。拉普拉斯噪声是一种差分隐私噪声,它可以保护个人隐私,同时仍然允许聚合数据分析。`epsilon` 参数控制隐私预算,值越小,隐私保护越强。

**2.1.2 联邦传输学习**

联邦传输学习是一种将多个模型在不同设备上训练,然后将训练后的模型聚合在一起的技术。它通过减少数据传输量来保护隐私,因为每个设备只传输模型更新,而不是原始数据。

**代码块:**

```python

import tensorflow as tf

def federated_averaging(models):

"""

联邦平均聚合多个模型。

参数:

models:要聚合的模型列表。

返回:

聚合后的模型。

"""

weights = [model.get_weights() for model in models]

avg_weights = np.mean(weights, axis=0)

return tf.keras.Model.from_config(models[0].get_config(), avg_weights)

```

**逻辑分析:**

此代码块使用 TensorFlow 的 `federated_averaging()` 函数来聚合多个模型。它首先获取每个模型的权重,然后计算权重的平均值。最后,它创建一个新的模型,使用平均权重作为其权重。这种方法可以保护隐私,因为每个设备只传输模型更新,而不是原始数据。

### 2.2 联邦学习算法

联邦学习算法旨在在不共享原始数据的情况下训练模型。这些算法包括:

**2.2.1 梯度下降法**

梯度下降法是一种优化算法,它通过迭代更新模型权重来最小化损失函数。在联邦学习中,梯度下降法用于在每个设备上更新本地模型。

**代码块:**

```python

import tensorflow as tf

def local_update(model, data, epochs):

"""

在本地数据集上训练模型。

参数:

model:要训练的模型。

data:本地数据集。

epochs:训练轮数。

返回:

训练后的模型。

"""

optimizer = tf.keras.optimizers.SGD(learning_rate=0.01)

for epoch in range(epochs):

for batch in data:

with tf.GradientTape() as tape:

loss = model(batch)

gradients = tape.gradient(loss, model.trainable_weights)

optimizer.apply_gradients(zip(gradients, model.trainable_weights))

return model

```

**逻辑分析:**

此代码块使用 TensorFlow 的 `local_update()` 函数在本地数据集上训练模型。它使用随机梯度下降 (SGD) 优化器来更新模型权重。`epochs` 参数指定训练轮数,`data` 参数指定本地数据集。

**2.2.2 随机梯度下降法**

随机梯度下降法 (SGD) 是一种梯度下降法的变体,它每次只使用一个数据样本来更新模型权重。这可以减少计算成本,并使联邦学习在资源受限的设备上成为可能。

**代码块:**

```python

import tensorflow as tf

def st

```

0

0