【数据集成策略全解析】:工厂管理系统不同数据源整合之道

发布时间: 2024-12-28 23:10:05 阅读量: 5 订阅数: 7

数据集成管理系统源码+数据库

# 摘要

数据集成是将多个数据源合并为一个统一视图的过程,对于实现数据共享和增强决策支持至关重要。本文首先概述了数据集成的定义、模型及其必要性,继而深入探讨了理论基础,包括数据异构性、数据一致性与质量控制等关键问题。接着,文章详细介绍了数据集成的技术与工具,比较了实时与批量集成技术,并对开源与商业集成工具进行了分析。在实际应用案例分析中,本文探讨了工厂管理系统中数据集成的需求与解决方案,并分享了成功案例与经验。最后,文章展望了数据集成领域的未来趋势,讨论了大数据、云计算及人工智能等新兴技术的影响,以及数据隐私、安全挑战和市场发展机遇。

# 关键字

数据集成;数据异构性;数据一致性;ETL过程;数据仓库;数据湖

参考资源链接:[工厂管理系统设计:数据库课程实践](https://wenku.csdn.net/doc/648821bc619bb054bf59a117?spm=1055.2635.3001.10343)

# 1. 数据集成概述与必要性

## 1.1 数据集成定义

数据集成是一个将不同来源、格式和结构的数据统一的过程,目的是为了实现信息共享和跨系统协作。它是现代数据驱动企业不可或缺的一部分,涉及到数据的采集、清洗、转换、融合和传输。

## 1.2 数据集成必要性

随着企业业务的扩展和IT系统的增加,数据量和数据源呈爆炸性增长。数据集成的需求变得尤为迫切,它有助于企业获得统一的数据视图,支持决策制定,提升业务流程效率,同时为数据分析和人工智能提供必要的数据基础。

## 1.3 数据集成的应用价值

数据集成不仅仅是技术问题,它还直接影响企业的业务运营和战略决策。正确的数据集成策略能减少数据孤岛,提高数据的可用性,强化数据驱动文化的构建,增强企业对市场变化的快速反应能力。

本章提供了数据集成的初步认识,为后续深入探讨其理论、技术和实践应用打下基础。

# 2. ```

# 第二章:数据集成的理论基础

数据集成是将不同来源、格式、特征的数据通过一定的处理,转化为有用信息的过程。这一过程不仅涉及技术层面的挑战,更包含一系列理论基础的支撑。理解这些理论对于优化数据集成方案,提高数据集成的效率和质量至关重要。

## 2.1 数据集成的定义和模型

### 2.1.1 数据集成的概念框架

数据集成的概念框架强调了数据在组织内部流动的各个阶段。这些阶段通常包括数据源的识别、数据的抽取、数据的转换、数据的加载以及最终数据的管理。在这一框架中,数据从源系统出发,经过清洗、合并等一系列处理后,被整合到目标系统中,以满足业务需求。

为了深入理解数据集成,我们必须首先明确几个核心概念:

- **数据源(Data Source)**:数据产生的原始位置,可以是关系型数据库、文件、API等。

- **数据抽取(Data Extraction)**:将数据从数据源中提取出来的过程。

- **数据转换(Data Transformation)**:对抽取出来的数据进行清洗、格式化、转换等操作的过程。

- **数据加载(Data Loading)**:将转换后的数据导入目标系统的过程。

- **数据管理(Data Management)**:在数据集成的整个生命周期内,对数据进行监控、维护和优化的活动。

### 2.1.2 不同数据集成模型的比较分析

不同的数据集成模型适应于不同场景的需求。在实际应用中,常见的数据集成模型包括:

- **点对点集成(Point-to-Point Integration)**

- **数据仓库集成(Data Warehouse Integration)**

- **数据湖集成(Data Lake Integration)**

- **服务导向架构(Service-Oriented Architecture, SOA)**

每种模型都有其独特的特点和适用条件。例如,点对点集成模型适用于数据源数量较少的情况,因其简单直接而受到青睐。而数据仓库集成模型则更适合复杂的数据分析需求,因为它能够在高度组织化和优化的方式下整合数据。

在进行模型选择时,组织需要综合考虑数据的复杂性、业务需求、预算以及维护成本等因素。

## 2.2 数据集成中的关键问题

### 2.2.1 数据异构性问题

数据异构性指的是数据在数据源中存在着不同的格式、标准和结构。解决数据异构性是数据集成中的一个核心问题。处理异构性的方法包括:

- **数据映射**:将不同数据源的结构和格式转换为统一的表示。

- **元数据管理**:创建和维护数据字典,以标准化数据的定义和属性。

### 2.2.2 数据一致性与质量控制

数据一致性涉及保证数据在集成过程中的准确性和完整性。高质量的数据对于做出准确的业务决策至关重要。实现数据一致性的方法可能包括:

- **数据校验**:在数据转换过程中检查数据的准确性和一致性。

- **数据清洗**:通过删除重复项、纠正错误等方式提高数据质量。

## 2.3 数据集成策略的理论支撑

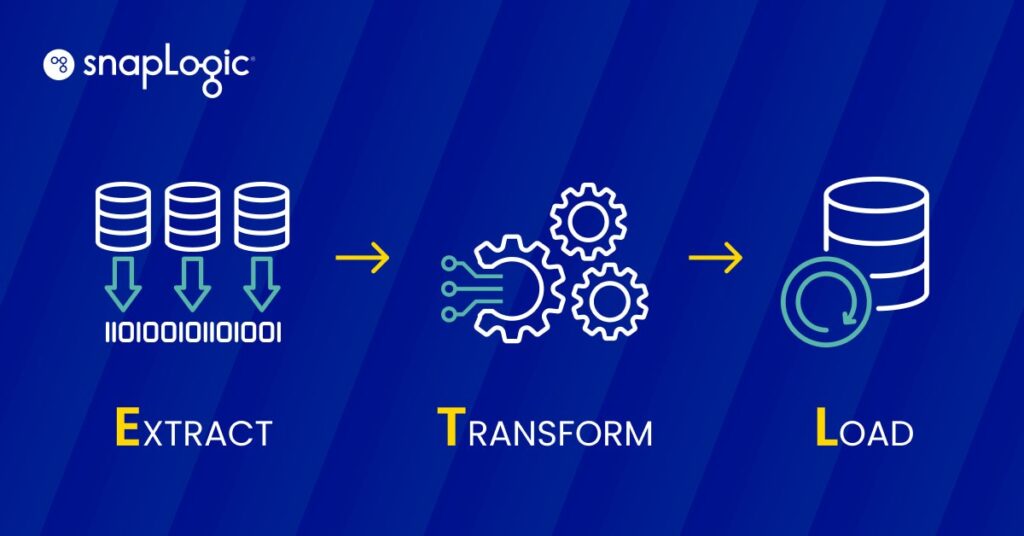

### 2.3.1 ETL过程的理论基础

ETL(Extract, Transform, Load)是数据集成中最为常见的处理模式。ETL过程涉及到数据的抽取、转换和加载三个步骤,下面是一个简化的ETL流程图:

```mermaid

graph LR

A[数据源] -->|抽取| B[数据清洗]

B -->|转换| C[数据整合]

C -->|加载| D[目标系统]

```

每个步骤都有特定的任务和挑战,需要仔细规划和实施。

### 2.3.2 数据仓库与数据湖的理论对比

数据仓库和数据湖是两种不同的数据存储模型,它们为数据集成提供了不同的理论基础和应用场景。

- **数据仓库(Data Warehouse)**:专门用于数据分析和报告的中央仓库,它通过ETL过程将数据从操作型数据库中抽取出来,并对数据进行汇总和优化。

- **数据湖(Data Lake)**:一个存储原始数据的存储库,它可以存储任意类型的数据,不必在存储时就确定如何使用这些数据。

一个典型的对比表格如下:

| 特性 | 数据仓库 | 数据湖 |

| --- | --- | --- |

| 数据类型 | 结构化数据 | 结构化、半结构化、非结构化数据 |

| 数据处理 | 高度优化、预处理 | 原始数据存储,处理在加载后进行 |

| 目的 | 支持决策制定 | 支持各种分析用途,包括探索性分析 |

| 用

```

0

0