【平滑数据迁移秘笈】:工厂管理系统旧到新系统的无缝对接

发布时间: 2024-12-28 22:56:02 阅读量: 4 订阅数: 7

数据快速迁移工具:EnhancedScroller v2.37.1

# 摘要

数据迁移是信息系统升级、云迁移或系统整合中的关键步骤,涉及复杂的理论与实践挑战。本文首先介绍了平滑数据迁移的理论基础,然后详细探讨了迁移前的准备工作,包括理解旧新系统的架构差异、数据评估与清洗、迁移需求和风险评估。接下来,本文阐述了实施数据迁移的策略和工具选择,以及执行监控过程中的要点。文章还探讨了数据迁移后的验证、系统优化和用户培训等重要环节。最后,通过具体案例研究,分析了成功数据迁移的实践经验和业务影响。本文旨在为从事数据迁移的技术人员提供理论与实践的指导,确保数据迁移的顺利进行并最大化其业务价值。

# 关键字

数据迁移;系统架构;数据清洗;风险评估;迁移工具;性能调优

参考资源链接:[工厂管理系统设计:数据库课程实践](https://wenku.csdn.net/doc/648821bc619bb054bf59a117?spm=1055.2635.3001.10343)

# 1. 平滑数据迁移的理论基础

数据迁移是一个复杂且充满挑战的项目,通常涉及将数据从一个存储位置或数据库转移到另一个位置,可能是不同的数据库系统、不同的存储平台,甚至是云环境。平滑的数据迁移不仅仅是数据的复制过程,更是一个完整的技术和业务流程,它要求在迁移的过程中保证数据的完整性、一致性和可用性。

## 1.1 数据迁移的重要性

在技术迅速发展的今天,企业为了升级系统、整合资源、提升性能或是切换到云平台等目的,都需要进行数据迁移。数据迁移的平滑性直接影响到业务连续性和用户满意度。因此,了解平滑数据迁移的理论基础对于成功实施迁移至关重要。

## 1.2 数据迁移的挑战

数据迁移过程中,可能会面临以下挑战:

- 数据一致性问题:在迁移过程中,保证数据的一致性和完整性是至关重要的。

- 系统兼容性问题:不同数据库平台或应用之间可能存在格式、协议或接口的差异。

- 性能问题:迁移可能会对现有系统的性能产生影响,特别是在高峰期。

- 数据安全问题:在迁移过程中,数据的安全性和隐私保护也需要特别关注。

理解这些挑战并提前准备相应的解决方案,是确保数据迁移平滑进行的关键步骤。接下来的章节中,我们将深入探讨数据迁移前的准备工作以及实施策略。

# 2. 数据迁移前的准备工作

### 理解旧系统和新系统架构

#### 分析旧系统的数据结构

旧系统往往积累了多年的数据,这些数据在格式、类型、用途和访问模式上可能相当复杂。在迁移前,必须对旧系统的数据结构进行全面的分析。以下是分析的几个关键步骤:

1. **数据分类**:将旧系统中的数据按照类型进行分类,如文本、数字、日期等,并识别哪些数据是必须迁移的。

2. **依赖关系映射**:绘制数据项之间的依赖关系,这有助于在迁移过程中维持数据的完整性。

3. **数据格式和编码**:识别数据使用的存储格式和编码方式,如CSV, JSON, XML, Unicode等。

4. **数据访问路径**:确定数据被访问的路径和频率,这有助于规划迁移时间窗口和优化迁移效率。

代码示例:使用Python来获取数据库中的数据表和字段信息。

```python

import sqlite3

# 连接到SQLite数据库

# 数据库文件是test.db,如果文件不存在,会自动在当前目录创建:

conn = sqlite3.connect('test.db')

cursor = conn.cursor()

# 执行查询操作

cursor.execute("SELECT name FROM sqlite_master WHERE type='table';")

tables = cursor.fetchall()

# 输出表名

print("表名:")

for t in tables:

print(t[0])

# 继续其他数据结构分析...

# 关闭Cursor和Connection:

cursor.close()

conn.close()

```

这个简单的脚本展示了如何使用Python和SQLite的库来获取数据库中所有表的名称。在实际迁移过程中,数据结构的分析会更加复杂,并可能涉及多个数据库系统。

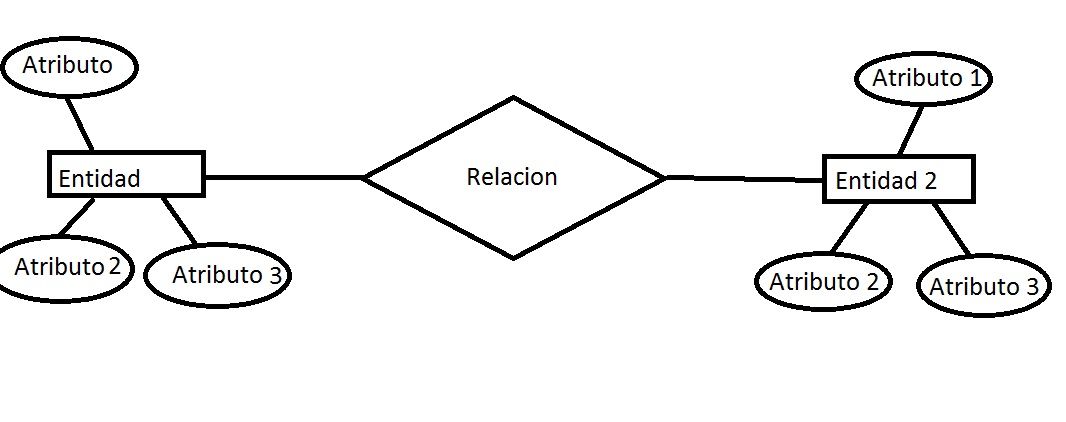

#### 设计新系统的数据模型

新系统的设计要满足当前和未来业务发展的需要。设计新系统的数据模型时,需要考虑以下几个关键因素:

1. **业务需求**:确保新模型能充分支持业务流程和数据查询的需求。

2. **规范化**:数据模型应该尽可能地规范化,以减少冗余和提高数据一致性。

3. **扩展性**:模型应具备良好的扩展性,以适应未来可能的变化。

4. **性能考虑**:数据模型需要优化以满足性能要求,特别是对于大型数据集和高频率的查询操作。

代码示例:使用SQL创建新表时,考虑数据库规范化原则。

```sql

CREATE TABLE Customer (

CustomerID INT PRIMARY KEY,

FirstName VARCHAR(50),

LastName VARCHAR(50),

Email VARCHAR(100)

);

CREATE TABLE Order (

OrderID INT PRIMARY KEY,

CustomerID INT,

OrderDate DATE,

TotalAmount DECIMAL(10, 2),

FOREIGN KEY (CustomerID) REFERENCES Customer(CustomerID)

);

```

在这个示例中,我们创建了两个表:`Customer` 和 `Order`。它们之间通过外键建立关系,这有助于维护数据关系的完整性,并为未来数据查询提供了高效的数据模型结构。

### 数据评估与清洗

#### 数据质量评估标准

数据质量是数据迁移成功的关键。在迁移前,必须定义评估数据质量的标准。这些标准可能包括:

1. **完整性**:数据是否完整,没有遗漏。

2. **准确性**:数据值是否正确,无误差。

3. **一致性**:数据在各个系统或表中是否保持一致。

4. **时效性**:数据是否是最新的。

为了评估这些标准,可以使用如下指标:

- **记录数**:数据表中的记录数是否符合预期。

- **字段检查**:字段值是否符合预期的数据类型和范围。

- **重复检查**:是否存在重复的记录,应消除重复数据。

- **空值检查**:确定哪些字段允许空值,并检查空值的数量是否合理。

#### 数据清洗策略和工具

数据清洗是确保数据质量的关键步骤。实施有效的清洗策略前,需考虑以下因素:

1. **清洗工具的选择**:选择合适的工具来自动执行一些清洗任务。

2. **数据清洗的优先级**:确定哪些数据是关键数据,需要优先清洗。

3. **数据清洗策略**:设计并实施特定的数据清洗策略。

代码示例:使用Python的Pandas库进行数据清洗。

```python

import pandas as pd

# 读取数据

df = pd.read_csv('dirty_data.csv')

# 数据清洗操作

df_cleaned = df.dropna() # 删除空值

df_cleaned = df.drop_duplicates() # 删除重复数据

df_cleaned = df[df['Amount'] > 0] # 删除不合理数据

# 将清洗后的数据保存为新文件

df_cleaned.to_csv('cleaned_data.csv', index=False)

```

在该示例中,我们首先读取了包含脏数据的CSV文件,然后执行了删除空值、重复记录以及不合理数据的清洗操作,最后将清洗后的数据保存到新的CSV文件中。

### 迁移需求和风险评估

#### 功能对应和数据映射

在开始数据迁移之前,必须确定旧系统与新系统之间功能的对应关系,以及数据如何映射到新系统。这个过程通常涉及以下步骤:

1. **功能映射**:建立旧系统和新系统功能之间的对应关系。

2. **数据映射**:根据功能映射,制定数据迁移的详细规则。

实施此过程时,可以制作功能和数据映射表,以确保每个字段都被正确迁移。

#### 风险评估与应对措施

任何数据迁移计划都涉及到风险。有效的风险评估可以帮助你预测和减轻潜在问题。风险评估通常包括以下几个方面:

1. **数据丢失风险**:评估在迁移过程中数据丢失的可能性,并制定备份计划。

2. **迁移失败风险**:可能需要回滚到旧系统,因此制定回滚策略是必要的。

3. **数据一致性风险**:数据在迁移后可能不一致,需要定期校验数据的一致性。

制定风险应对措施时,可以创建一个风险响应矩阵,

0

0