Transformer模型中Positional Encoding的作用及实现

发布时间: 2024-05-01 23:34:56 阅读量: 88 订阅数: 60

# 1. Transformer模型概述

Transformer模型是一种神经网络架构,它以其在自然语言处理(NLP)任务中的卓越表现而闻名。与传统的循环神经网络(RNN)和卷积神经网络(CNN)不同,Transformer模型完全基于注意力机制,这使得它能够捕获序列数据中的长距离依赖关系。

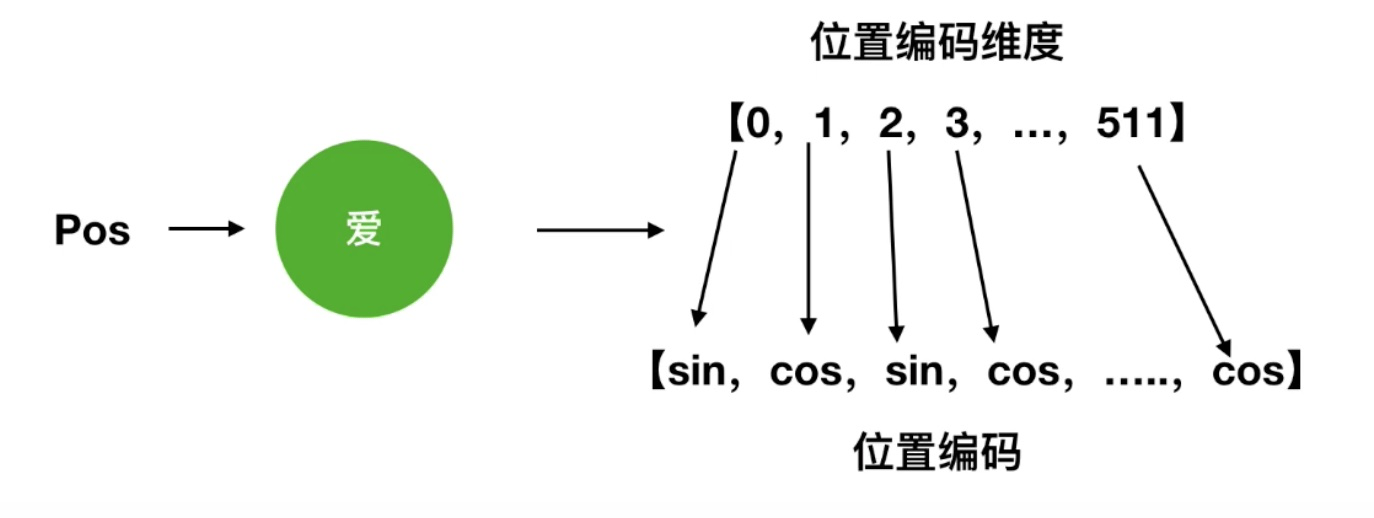

Transformer模型的核心组件之一是位置编码(Positional Encoding)。位置编码是一种附加到输入序列中的特殊向量,它提供有关序列中每个元素相对位置的信息。通过这样做,Transformer模型能够区分序列中不同位置的元素,即使它们具有相同的词嵌入。

# 2. Positional Encoding的理论基础

### 2.1 位置信息的编码方式

在自然语言处理中,单词的顺序至关重要,但传统的神经网络模型无法直接处理这种顺序信息。Positional Encoding是一种技术,用于将单词的位置信息编码成向量,以便神经网络模型能够学习和利用这些信息。

#### 2.1.1 绝对位置编码

绝对位置编码为每个单词分配一个唯一的向量,该向量表示单词在序列中的绝对位置。例如,对于长度为5的序列,单词的绝对位置编码可以表示为:

```

[1, 2, 3, 4, 5]

```

这种编码方式简单且易于实现,但它存在一个缺点:它无法处理序列长度的变化。如果序列的长度发生变化,则绝对位置编码也需要相应地进行调整。

#### 2.1.2 相对位置编码

相对位置编码为单词对分配一个向量,该向量表示单词对之间的相对位置。例如,对于长度为5的序列,单词对之间的相对位置编码可以表示为:

```

[0, 1, 2, 3, 4]

[0, 1, 2, 3]

[0, 1, 2]

[0, 1]

[0]

```

这种编码方式可以处理序列长度的变化,因为它只关注单词对之间的相对位置,而不是单词的绝对位置。

### 2.2 位置编码的数学原理

#### 2.2.1 正弦和余弦函数

Positional Encoding通常使用正弦和余弦函数来编码位置信息。正弦和余弦函数具有周期性,这使得它们非常适合于编码序列中的位置信息。

正弦和余弦函数的公式如下:

```

sin(x) = sin(2πx / P)

cos(x) = cos(2πx / P)

```

其中:

* x:位置

* P:序列的长度

#### 2.2.2 位置嵌入矩阵

位置嵌入矩阵是一个二维矩阵,其行数等于序列的长度,列数等于位置编码的维度。位置嵌入矩阵中的每个元素都是通过正弦和余弦函数计算得到的。

位置嵌入矩阵的公式如下:

```

PE(i, j) = sin(2πi / P^j)

```

其中:

* i:序列中的位置

* j:位置编码的维度

* P:序列的长度

# 3. Positional Encoding的实践实现

### 3.1 TensorFlow中的实现

#### 3.1.1 tf.positional_encoding函数

TensorFlow提供了`tf.positional_encoding`函数,用于生成位置编码矩阵。该函数接收以下参数:

- `position`: 一个整数,表示位置的索引。

- `d_model`: 一个整数,表示模型的维度。

- `max_len`: 一个整数,表示序列的最大长度。

该函数返回一个形状为`(max_len, d_model)`的位置编码矩阵。

```python

import tensorflow as tf

# 生成位置编码矩阵

position_encoding = tf.positional_encoding(max_len=100, d_model=512)

# 打印位置编码矩阵

print(position_encoding)

```

#### 3.1.2 自定义位置编码函数

也可以自定义位置编码函数,以实现更灵活的控制。以下是一个自定义函数的示例:

```python

import math

def positional_encoding(position, d_model):

"""

自定义位置编码函数

参数:

position: 一个整数,表示位置的索引。

d_model: 一个整数,表示模型的维度。

返回:

一个形状为`(1, d_model)`的位置编码向量。

"""

# 计算位置编码向量的每一维

encodings = [math.sin(position / 10000 ** (2 * i / d_model)) for i in range(d_model)]

# 将每一维编码转换为向量

encodings = tf.convert_to_tensor(encodings, dtype=tf.float32)

encodings = tf.reshape(encodings, (1, d_model))

return encodings

```

### 3.2 PyTorch中的实现

#### 3.2.1 torch.nn.TransformerEncoderLayer

PyTorch中的`torch.nn.TransformerEncoderLayer`模块包含了一个内置的位置编码层。该层使用正弦和余弦函数来生成位置编码矩阵。

```python

import torch

# 创建Transformer编码器层

encoder_layer = torch.nn.TransformerEncoderLayer(d_model=512, nhead=8)

# 生成位置编码矩阵

position_encoding = encoder_layer.get_position_encoding(max_len=100)

# 打印位置编码矩阵

print(position_encoding)

```

#### 3.2.2 自定义位置编码模块

也可以自定义位置编码模块,以实现更灵活的控制。以下是一个自定义模块的示例:

```python

import torch

class PositionalEncoding(torch.nn.Module):

"""

自定义位置编码模块

参数:

d_model: 一个整数,表示模型的维度。

返回:

一个形状为`(1, max_len, d_model)`的位置编码矩阵。

"""

def __init__(self, d_model):

super().__init__()

# 计算位置编码向量的每一维

encodings = [math.sin(position / 10000 ** (2 * i / d_model)) for i in range(d_model)]

# 将每一维编码转换为向量

encodings = torch.convert_to_tensor(encodings, dtype=torch.float32)

encodings = torch.reshape(encodings, (1, -1, d_model))

# 创建可学习的位置编码矩阵

self.register_buffer('position_encoding', encodings)

def forward(self, x):

"""

前向传播

参数:

x: 一个形状为`(batch_size, seq_len, d_model)`的输入序列。

返回:

一个形状为`(batch_size, seq_len, d_model)`的位置编码矩阵。

"""

# 将位置编码矩阵与输入序列相加

return x + self.position_encoding

```

# 4. Positional Encoding在Transformer模型中的应用

### 4.1 位置编码对注意力机制的影响

位置编码在Transformer模型中扮演着至关重要的角色,它通过向输入序列中的每个元素添加位置信息,使注意力机制能够捕捉到序列中元素之间的相对位置关系。这对于理解自然语言文本和时间序列数据等具有顺序结构的数据至关重要。

#### 4.1.1 提高注意力机制的精度

位置编码通过向注意力机制提供位置信息,帮助其更好地理解序列中元素之间的关系。这对于区分具有相似语义但出现在不同位置的单词或句子至关重要。例如,在机器翻译任务中,位置编码使注意力机制能够区分源语言句子中具有相同含义但出现在不同位置的单词。

#### 4.1.2 减少训练时间

位置编码还可以通过减少训练时间来提高注意力机制的效率。通过提供位置信息,位置编码使注意力机制能够更快地收敛到正确的权重,从而减少了训练所需的时间。这对于大型Transformer模型尤其重要,这些模型通常需要大量的训练数据和计算资源。

### 4.2 Positional Encoding在NLP任务中的效果

位置编码在自然语言处理(NLP)任务中表现出显著的效果,包括机器翻译和文本摘要。

#### 4.2.1 机器翻译

在机器翻译中,位置编码使注意力机制能够捕捉到源语言句子中单词之间的顺序关系。这对于生成语法正确且语义上连贯的翻译至关重要。例如,在将英语句子翻译成法语时,位置编码确保法语翻译中单词的顺序与英语句子中的单词顺序相对应。

#### 4.2.2 文本摘要

在文本摘要中,位置编码使注意力机制能够识别文本中最重要的句子和段落。这对于生成简洁且信息丰富的摘要至关重要。例如,在生成一篇新闻文章的摘要时,位置编码确保摘要包含文章中最重要的事件和信息,并按其出现的顺序排列。

# 5. Positional Encoding的优化和扩展

### 5.1 位置编码的变体

#### 5.1.1 Learned Positional Encoding

传统的位置编码是预先定义的,而Learned Positional Encoding允许模型学习位置编码。这可以通过在Transformer模型中添加一个额外的层来实现,该层将输入序列的位置作为输入,并输出位置编码。

#### 5.1.2 Rotary Positional Encoding

Rotary Positional Encoding是一种替代的位置编码方法,它使用复数而不是正弦和余弦函数。这使得位置编码更加高效,并且在某些任务中表现出更好的性能。

### 5.2 Positional Encoding在其他模型中的应用

Positional Encoding不仅限于Transformer模型,它还可以在其他模型中使用,例如:

#### 5.2.1 卷积神经网络

在卷积神经网络中,Positional Encoding可以用于对图像中的空间位置进行编码。这可以提高模型对图像中对象位置的鲁棒性。

#### 5.2.2 循环神经网络

在循环神经网络中,Positional Encoding可以用于对序列中的时间位置进行编码。这可以帮助模型学习序列中元素之间的顺序关系。

0

0