【R集成学习方法】: 及优化策略

发布时间: 2024-04-21 08:38:49 阅读量: 76 订阅数: 68

YOLO算法-城市电杆数据集-496张图像带标签-电杆.zip

# 1. 介绍R集成学习方法

集成学习是一种机器学习技术,通过结合多个模型的预测结果来改善整体的学习效果。在实际应用中,通过构建多个模型的组合,可以提高预测准确性和泛化能力,降低过拟合风险。R语言提供了丰富的集成学习方法,包括随机森林、极端梯度提升和自适应增强等,这些方法在各个领域都有广泛的应用。本章将介绍R集成学习方法的基本概念和优势,帮助读者了解如何利用集成学习提升模型性能。

# 2. 集成学习概述

集成学习作为机器学习领域中重要的技术手段,以其多模型组合的方式在解决复杂问题时展现出了强大的能力。本章将从集成学习的基本概念入手,介绍集成学习的原理、优势以及常见的分类算法。

## 2.1 什么是集成学习

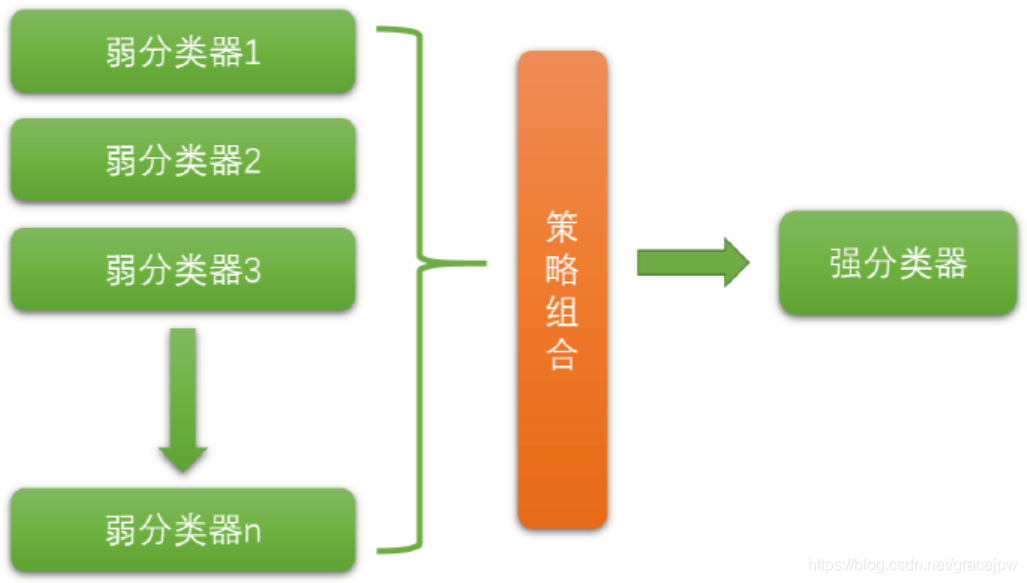

在机器学习中,集成学习是通过构建并结合多个模型来完成学习任务的一种方法。相比于单一模型,集成模型能够在一定程度上提升预测性能和泛化能力。

### 2.1.1 单一模型 VS 集成模型

- **单一模型**:传统的机器学习方法通常只构建一个单一的模型来完成学习任务,如逻辑回归、决策树等。

- **集成模型**:集成学习通过结合多个模型的预测结果,最终得到一个更加稳定和准确的整体预测结果。

### 2.1.2 集成学习原理概览

集成学习基于“三驾马车”理论,即**多样性(Diversity)**、**准确性(Accuracy)** 和**一致性(Robustness)**,通过合理构建模型之间的关联关系,使得集成模型在准确性和稳定性上都能有所提升。

### 2.1.3 集成学习的优势和应用领域

集成学习的优势主要体现在以下几个方面:

- 提升预测准确度

- 缓解过拟合

- 对抗噪声

- 适应不同的数据分布

在实际应用中,集成学习广泛应用于分类、回归、聚类等领域,取得了良好的效果。

## 2.2 集成学习分类

集成学习算法主要分为Bagging、Boosting和Stacking三大类,它们在模型构建和预测过程中有着各自独特的特点和方法。

### 2.2.1 Bagging算法

Bagging算法通过构建多个并行的基学习器,每个基学习器都独立地进行学习和预测,最后通过投票等方式汇总结果,如著名的随机森林算法。

### 2.2.2 Boosting算法

Boosting算法是一种串行的集成学习方式,每个基学习器是针对上一个学习器学习效果的样本进行调整,从而不断提升整体模型的性能,典型代表为XGBoost算法。

### 2.2.3 Stacking算法

Stacking算法则是将多个基学习器的预测结果作为新的训练集,构建一个新的模型来组合前面基学习器的结果,以获得更好的预测效果。

通过上述介绍,我们对集成学习的概念和常见分类有了初步了解,下一节将重点介绍R语言中的集成学习工具,深入探讨具体算法的原理和应用。

# 3. R语言中的集成学习工具

集成学习在机器学习领域一直备受关注,R语言提供了丰富的集成学习工具,本章将深入介绍R语言中几种常用的集成学习算法,包括RandomForest、XGBoost和AdaBoost,并解析它们的原理、应用方式以及参数调优技巧。

### 3.1 RandomForest随机森林算法

随机森林(RandomForest)是一种基于决策树构建的集成学习算法,其核心思想是通过构建大量决策树,然后综合考虑它们的结果来进行分类或回归预测。接下来分别深入了解随机森林的原理解析、在R中的使用方式以及参数调优策略。

#### 3.1.1 随机森林原理解析

随机森林通过引入随机性,包括随机选择特征和随机样本集,以降低过拟合的风险,提高泛化能力。它采用Bagging技术,即自助采样,从原始训练集中有放回地抽取样本,构建多棵树,最后通过投票或平均值确定最终结果。

```r

# 随机森林模型训练

library(randomForest)

model_rf <- randomForest(target ~ ., data = train_data, ntree = 500)

```

#### 3.1.2 RandomForest在R中的使用方式

在R中,我们可以使用`randomForest`包来构建随机森林模型。通过指定目标变量和特征变量,以及设置树的数量等参数,快速

0

0