Python网络请求库对决:urllib与requests深度比较

发布时间: 2024-12-12 20:47:25 阅读量: 8 订阅数: 8

# 1. Python网络请求库概述

在当今信息化时代,网络请求是进行数据交互、信息检索、自动化控制等操作的基础,而Python作为编程语言中的佼佼者,其网络请求库的丰富性和易用性吸引了众多开发者。Python的网络请求库主要分为标准库和第三方库,其中,urllib和requests是应用最为广泛的两个库。urllib作为Python的官方标准库,提供了一系列用于操作URL的功能,而requests库则是在urllib基础上的再封装,以其简洁直观的API和丰富的功能备受开发者青睐。

接下来,我们将深入探讨这两个库的理论基础、使用方法、高级技巧以及它们之间的对比分析,从而帮助开发者更好地选择和使用这些工具来满足其编程需求。在本章,我们将对urllib和requests库进行初步的了解,为后续的深入学习打下坚实的基础。

# 2. urllib库的理论与实践

### 2.1 urllib库的基本概念

#### 2.1.1 urllib的历史和设计理念

urllib是Python的标准库之一,用于处理URL相关的操作,其历史可以追溯到早期的Python版本。设计理念主要围绕方便、简洁、可扩展性进行,旨在简化网络请求操作的复杂度,让开发者更加专注于网络请求的目的和逻辑。

urllib提供了一个非常直观和易用的API,它可以用来:

- 发送网络请求

- 分析和管理URLs

- 编码和解码URLs

- 自定义用户代理和处理重定向

- 管理HTTP Cookie

#### 2.1.2 urllib的主要模块及其功能

urllib由多个模块组成,每个模块都有其特定的功能:

- **urllib.request**: 此模块用于打开和读取URLs。它可以用来发起网络请求、处理网络认证、处理重定向以及设置代理。

- **urllib.error**: 此模块包含由urllib.request模块引发的异常。

- **urllib.parse**: 此模块用于分析URLs,它能够将URL分解为其组成部分或重新组合URL的各个部分。

- **urllib.robotparser**: 此模块用于解析robots.txt文件,它规定了爬虫可以访问和不可以访问的网页。

这些模块共同工作,能够应对大部分与URL和网络请求相关的需求。

### 2.2 urllib库的使用方法

#### 2.2.1 urllib.request模块的使用

##### 2.2.1.1 发起网络请求

发起网络请求是urllib最基本的使用场景之一。我们可以通过以下代码段示例如何使用`urllib.request`模块发起一个简单的GET请求:

```python

import urllib.request

# 创建一个请求

req = urllib.request.Request('http://www.example.com')

# 发起请求并获取响应

response = urllib.request.urlopen(req)

# 读取响应内容

data = response.read()

```

在这段代码中,我们首先导入了`urllib.request`模块,创建了一个`Request`对象来指定我们想要请求的URL。然后使用`urlopen`函数发起请求,并读取返回的内容。

##### 2.2.1.2 处理URL编码

URL编码是处理网络请求中的一个重要环节。当URL中包含非ASCII字符或特殊字符时,需要进行编码。`urllib`库提供了一些方便的工具来处理编码问题。比如使用`urllib.parse.quote`函数可以将字符串进行URL编码:

```python

from urllib.parse import quote

# 假设我们需要对URL进行编码

url = 'http://www.example.com/path?query=中文'

encoded_url = quote(url)

```

在这段代码中,`quote`函数将中文字符转换为了URL编码形式,这样就可以保证URL的正确性和安全性。

#### 2.2.2 urllib.error模块的使用

##### 2.2.2.1 处理网络请求错误

网络请求可能因为各种原因失败,比如网络问题、服务器问题等。`urllib.error`模块定义了与请求错误相关的一些异常类,如`URLError`。了解如何处理这些错误对于编写健壮的网络请求代码非常重要。

```python

from urllib.request import urlopen

from urllib.error import URLError

try:

response = urlopen('http://www.example.com/nonexistent')

except URLError as e:

print(f"发生错误: {e.reason}")

```

在上述代码中,我们尝试打开一个不存在的URL。由于请求失败,会抛出`URLError`异常,我们通过异常处理来获取错误信息。

#### 2.2.3 urllib其他子模块简介

##### 2.2.3.1 urllib.parse和urllib.robotparser

`urllib.parse`是用于解析URL的工具模块,提供了`urlparse`、`urlencode`等函数,用于将URL分解为组成部分或将数据编码为URL编码格式。而`urllib.robotparser`用于解析robots.txt文件,规定了哪些网页可以被爬虫访问。

```python

from urllib.parse import urlparse, urlencode

from urllib.robotparser import RobotFileParser

# 解析URL

parsed_url = urlparse('http://www.example.com/path?query=1')

print(parsed_url.scheme, parsed_url.netloc, parsed_url.path, sep='\n')

# 编码URL参数

params = {'query': '1'}

encoded_params = urlencode(params)

print(encoded_params)

# 解析robots.txt

rp = RobotFileParser()

rp.set_url('http://www.example.com/robots.txt')

rp.read()

print(rp.can_fetch('*', 'http://www.example.com/path'))

```

在上述代码中,我们演示了`urlparse`函数的使用,将一个URL分解为各个组成部分,并展示了`urlencode`如何将字典编码为适合URL查询字符串的格式。随后,我们使用`RobotFileParser`来解析服务器上的robots.txt文件内容,以判断爬虫是否有权限访问特定资源。

### 2.3 urllib高级应用技巧

#### 2.3.1 自定义请求头和代理设置

在进行网络请求时,有时需要设置自定义的HTTP请求头,或者通过代理服务器发送请求。urllib提供了灵活的接口来完成这些需求。

```python

# 自定义请求头

req = urllib.request.Request('http://www.example.com', headers={'User-Agent': 'MyUserAgent'})

response = urllib.request.urlopen(req)

# 通过代理发送请求

proxy_handler = urllib.request.ProxyHandler({'http': 'http://proxy.example.com:3128'})

opener = urllib.request.build_opener(proxy_handler)

response = opener.open(req)

```

在上述代码中,我们通过传入一个包含请求头的字典到`Request`对象来设置自定义请求头。同时,我们创建了一个`ProxyHandler`并通过`build_opener`创建了一个opener对象来设置代理。

#### 2.3.2 爬虫中的cookie处理和会话保持

在进行网站爬取时,经常会涉及到会话维持的问题,例如登录验证后的会话保持。urllib通过其会话对象(session)来处理这些需求。

```python

# 使用会话保持cookie

session = urllib.request.HTTPCookieProcessor()

opener = urllib.request.build_opener(session)

response = opener.open('http://www.example.com/login')

# 再次发起请求,维持登录状态

response = opener.open('http://www.example.com/protected')

```

在这段代码中,我们首先创建了一个`HTTPCookieProcessor`的实例,它会自动处理cookie。然后我们使用这个处理对象来构建opener。在登录页面发起请求后,再次使用同一个opener对象来访问受保护页面时,会自动发送之前存储的cookie,从而维持会话状态。

这些高级应用技巧是urllib库强大的功能体现,它们为开发者提供了丰富的自定义能力,帮助处理复杂的网络请求场景。随着本章节的深入,您将了解如何在实际开发中运用urllib来解决各种网络编程问题。

# 3. requests库的理论与实践

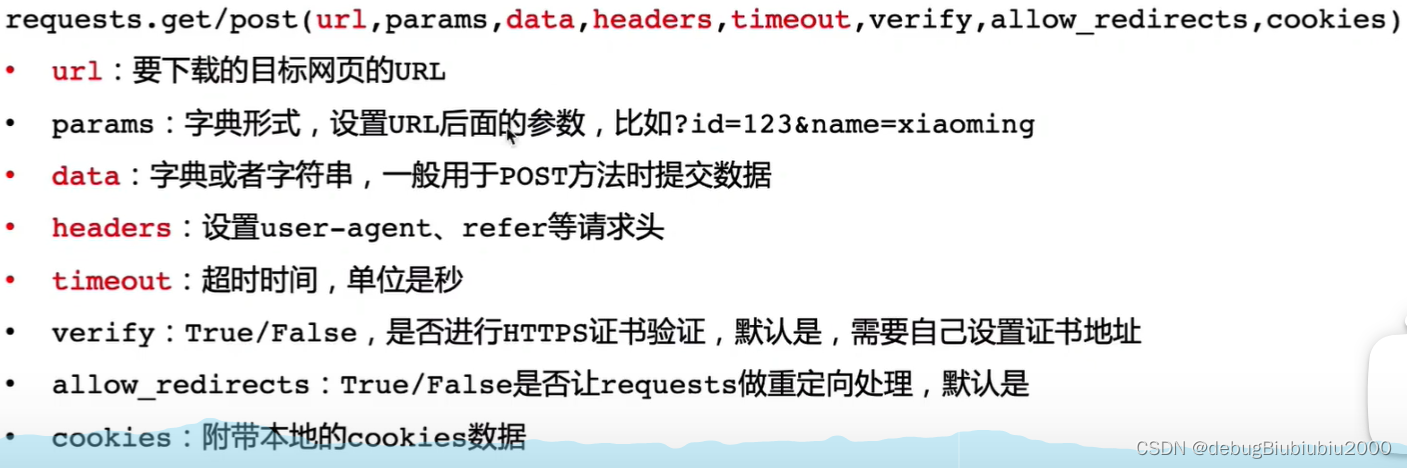

在现代Web开发和数据抓取领域,`requests`库已经成为Python开发者最青睐的工具之一。它的设计思想注重简洁和易用性,同时也支持高级功能如表单数据、文件上传、JSON处理等。这一章节将深入探讨`requests`库的基本概念、使用方法、以及如何进行自定义和扩展。

## 3.1 requests库的基本概念

### 3.1.1 requests的历史和设计理念

`requests`库是由Kenneth Reitz创建的一个第三方库,它的第一个版本发布于2011年。自那时起,requests就在社区中受到了极大的欢迎,并迅速成为处理HTTP请求的事实标准。

从设计理念上来看,requests库旨在为HTTP请求提供一个简单易用的API。它在urllib库的基础上进行了大量的简化和封装,使得开发者能够更加直观地发起请求和处理响应。其核心特点之一是它自动处理HTTP的头部信息,例如cookie和编码,极大地减少了开发者的负担。

### 3.1.2 requests的主要特点

- **易用性**:requests的API设计得非常直观,使用方法简单明了。

- **支持多协议**:除了HTTP,也支持安全HTTPS协议。

- **自动解码**:会自动处理响应内容的解码,支持多种编码。

- **国际化**:支持国际化域名和URLs。

- **持久的会话**:能够使用同一个Session对象维持参数的持久化。

- **错误处理**:内置了异常处理机制,方便开发者捕获和处理请求错误。

- **认证支持**:支持基本认证、摘要认证等多种认证方式。

## 3.2 requests库的使用方法

### 3.2.1 简单的网络请求与响应处理

#### 3.2.1.1 发起GET请求

一个简单的GET请求可以通过`requests.get()`方法发起。以下是一个基本的例子:

```python

import requests

response = requests.get('https://api.github.com')

print(response.status_code) # 输出响应的状态码

print(response.text) # 输出文本形式的响应内容

```

执行这段代码,会向指定的URL发送一个GET请求,并打印出响应的状态码和文本内容。`requests`库在内部处理了所有底层的细节,开发者可以专注于数据的处理。

#### 3.2.1.2 发起POST请求

当需要发送表单数据或JSON数据时,`requests`库同样提供了非常简洁的接口:

```python

import requests

data = {'key': 'value'}

response = requests.post('https://httpbin.org/post', data=data)

print(response.json()) # 打印JSON格式的响应内容

```

在这个例子中,我们使用`requests.post()`方法发送了一个POST请求,并传递了一个字典作为表单数据。同样地,`requests`库自动将字典编码为适合传输的格式,并处理响应内容的解码。

### 3.2.2 requests高级功能

#### 3.2.2.1 超时设置和异常处理

在使用requests库时,超时设置是一个重要的考虑因素。超时是指网络请求的最长等待时间,如果超过这个时间还没有收到响应,请求就会被中断。可以通过在`get`或`post`等方法中设置`timeout`参数来启用超时机制。

```python

response = requests.get('https://httpbin.org/get', timeout=3)

```

在这个例子中,我们设置了超时时间为3秒。如果请求没有在这段时间内完成,将会抛出一个`requests.exceptions.Timeout`异常。

`requests`还提供了一个异常层次结构,可以帮助我们捕获不同类型的请求错误:

```python

try:

response = requests.get('https://httpbin.org/get')

except requests.exceptions.ConnectionError:

print('连接错误')

except requests.exceptions.Timeout:

print('请求超时')

except requests.exceptions.HTTPError as errh:

print('错误的HTTP请求', errh)

except requests.exceptions.RequestException as e:

print('请求异常', e)

```

上面的代码展示了如何处理不同类型的异常。`ConnectionError`表示无法与服务器建立连接,`Timeout`表示请求超时,`HTTPError`表示服务器响应了错误状态码,而`RequestException`是所有请求相关异常的基类。

#### 3.2.2.2 请求体的编码与解码

在发送POST请求时,经常会涉及到请求体的编码。Requests库能自动对请求体进行JSON编码,从而简化了工作流程:

```python

import json

data = {'key': 'value'}

response = requests.post('https://httpbin.org/post', json=data)

print(response.json()) # 自动解析JSON格式的响应内容

```

在上面的代码中,我们通过`json`参数传递了一个Python字典,并将其自动转换为JSON格式发送。服务器响应的JSON数据也会被`requests`自动解析为Python字典。

## 3.3 requests库的自定义和扩展

### 3.3.1 适配器的使用和自定义

在某些情况下,可能需要对请求的发送方式进行更细致的控制。例如,可能需要修改请求头或者使用HTTP代理等。这时可以利用requests的适配器(Adapter)来实现。

```python

from requests.adapters import HTTPAdapter

from requests.packages.urllib3.util.retry import Retry

s = requests.Session()

retry = Retry(total=3, backoff_factor=1, status_forcelist=[502, 503, 504])

s.mount('http://', HTTPAdapter(max_retries=retry))

s.mount('https://', HTTPAdapter(max_retries=retry))

```

在上面的代码中,我们创建了一个会话(Session)对象,并为其安装了一个自定义的重试策略。这样,所有的请求都会遵循这个策略进行重试,直到达到最大重试次数。

### 3.3.2 插件系统的扩展应用

除了适配器之外,requests库还支持通过插件系统进行功能扩展。开发者可以创建自定义的中间件,以此来修改或增强请求和响应的过程。

```python

from requests.adapters import HTTPAdapter

class LoggingAdapter(HTTPAdapter):

"""记录每个请求和响应的日志的适配器"""

def send(self, request, **kwargs):

log_request(request)

response = super().send(request, **kwargs)

log_response(response)

return response

s = requests.Session()

s.mount('http://', LoggingAdapter())

s.mount('https://', LoggingAdapter())

response = s.get('https://httpbin.org/get')

```

在这段代码中,我们定义了一个`LoggingAdapter`类,它继承自`HTTPAdapter`。通过重写`send`方法,我们可以捕获到每次请求和响应,并进行日志记录。

自定义适配器和插件系统极大地增强了`requests`库的灵活性和可扩展性,使其成为进行复杂网络操作时不可或缺的工具。

以上是对`requests`库理论与实践的详细介绍。在后续章节中,我们将深入探讨与`urllib`库的对比,并通过具体的实战案例展示如何将这些知识应用到实际开发中。

# 4. urllib与requests的对比分析

### 4.1 性能对比

#### 4.1.1 网络请求速度的比较

在进行网络请求库的选择时,一个关键的考虑因素是请求的速度。`urllib` 和 `requests` 都支持HTTP协议,但它们在底层实现上有所区别。`urllib` 是 Python 标准库的一部分,采用较为传统的 API 设计,而 `requests` 则是一个第三方库,其 API 设计更加现代化和简洁。

为了进行性能比较,我们可以使用简单的基准测试代码。假设我们有以下 Python 脚本:

```python

import time

import urllib.request

import requests

# urllib 测试

start_time = time.time()

response = urllib.request.urlopen("http://www.example.com")

elapsed_time = time.time() - start_time

print("urllib elapsed time:", elapsed_time)

# requests 测试

start_time = time.time()

response = requests.get("http://www.example.com")

elapsed_time = time.time() - start_time

print("requests elapsed time:", elapsed_time)

```

这段代码分别使用 `urllib` 和 `requests` 向指定的网站发送请求,并记录响应时间。通过多次执行,我们可以得到两者的大致性能比较。

> 注意:实际的网络请求速度受多种因素影响,如网络环境、服务器响应速度、传输数据量大小等。上述测试结果只代表在特定条件下的相对性能。

#### 4.1.2 资源占用和内存消耗

除了响应速度之外,资源占用也是衡量一个网络库性能的重要指标。在处理大量网络请求时,较低的内存占用可以提高程序的效率和稳定性。

可以通过 `memory_profiler` 这样的库来监控 `urllib` 和 `requests` 在执行过程中的内存消耗。示例代码如下:

```python

from memory_profiler import memory_usage

import urllib.request

import requests

# urllib 内存消耗测试

mem_usage_urllib = memory_usage((urllib.request.urlopen, ("http://www.example.com",)))

print("urllib memory usage:", mem_usage_urllib)

# requests 内存消耗测试

mem_usage_requests = memory_usage((requests.get, ("http://www.example.com",)))

print("requests memory usage:", mem_usage_requests)

```

执行该代码将输出两个库在发送请求时的最大内存使用量。一般来说,`requests` 的内存占用会相对较少,这是因为它的代码更加现代,经过了优化。

> 提示:需要安装 `memory_profiler` 库才能运行上述内存测试代码。

### 4.2 功能对比

#### 4.2.1 功能齐全性和易用性评估

`urllib` 和 `requests` 在功能上各有千秋。`urllib` 作为标准库的一部分,提供了较为全面的功能,比如支持多种协议、编码处理、请求头自定义等,但其使用方法较为繁琐。

```python

import urllib.parse

import urllib.request

# urllib 功能使用示例

url = "http://www.example.com"

request = urllib.request.Request(url)

response = urllib.request.urlopen(request)

data = response.read()

```

而 `requests` 则以简洁的 API 著称。例如,使用 `requests` 发起一个 GET 请求,并处理响应内容,代码如下:

```python

import requests

# requests 功能使用示例

response = requests.get("http://www.example.com")

data = response.text

```

可以看出,`requests` 的易用性更高,对于大多数网络请求任务来说,代码更直观易懂。

#### 4.2.2 框架集成和社区支持

在框架集成方面,`requests` 由于其易用性和简洁性,被广泛集成到各种项目中。许多流行的 Python Web 框架,如 Django、Flask,都内置了对 `requests` 的支持。

> 提示:在 Flask 中,可以通过 `requests` 发起外部 HTTP 请求来集成外部 API 服务。

在社区支持方面,由于 `requests` 是一个活跃的第三方库,其维护者和用户社区反应迅速,有大量的文档和教程可以帮助用户解决遇到的问题。

### 4.3 扩展性对比

#### 4.3.1 第三方库和工具的兼容性

在扩展性方面,`requests` 有着丰富的第三方库和工具支持。例如,`requests_toolbelt` 库扩展了 `requests` 的能力,提供了多部分文件上传、流式请求等特性。而 `urllib` 作为标准库,其扩展性不如第三方库灵活。

例如,使用 `requests_toolbelt` 处理多部分文件上传的代码如下:

```python

from requests_toolbelt.multipart.encoder import MultipartEncoder

m = MultipartEncoder(

fields={

'field_name': 'value',

'field2': ('filename', open('file.jpg', 'rb'), 'image/jpeg')

}

)

r = requests.post('http://example.com/api/upload', data=m)

```

#### 4.3.2 自定义功能和扩展方法

无论是 `urllib` 还是 `requests`,都支持一定程度的自定义和扩展。但 `requests` 提供了更简单直接的接口来实现这些功能,比如自定义认证方式、会话管理等。

使用 `requests` 的会话管理功能,可以维持跨请求的参数,如cookie和headers,如下所示:

```python

with requests.Session() as session:

session.auth = ('user', 'pass')

session.headers.update({'x-test': 'true'})

# requests will use the same session instance

session.get('http://example.com')

session.post('http://example.com/post', data={'key':'value'})

```

通过上面的会话管理代码,我们可以看到 `requests` 如何在多个请求之间保持登录状态,这对于Web爬虫或API交互来说是非常有用的功能。

> 提示:`urllib` 的会话管理较为繁琐,通常需要通过 `Request` 类的子类化实现复杂的自定义。

以上为第四章的内容,涵盖了 `urllib` 和 `requests` 的性能对比、功能对比以及扩展性对比。通过逐点分析,我们可以更清楚地了解两种库在不同方面的优劣之处,从而为实际应用提供指导。

# 5. 实战案例分析

在本章中,我们将深入探讨实际项目中的案例分析,以展示如何应用urllib和requests库来实现网络数据抓取、网络API交互和Web自动化测试。我们将从多个案例出发,逐步剖析每个任务的实现步骤和关键点,以及如何解决实际操作中遇到的常见问题。

## 5.1 网络数据抓取

网络数据抓取是数据分析师、爬虫工程师或任何需要从网络获取数据的专业人士的日常工作之一。urllib和requests库都是实现网络数据抓取的强大工具。在本小节中,我们将以抓取一个网页的内容为例,演示如何使用这些库。

### 5.1.1 使用urllib和requests抓取网页内容

在实际应用中,我们常常需要从网页上抓取信息。无论是简单的文本信息,还是复杂的页面结构,我们都可以通过urllib和requests实现。

首先,我们来看如何使用urllib来抓取网页内容。以下是一个示例代码:

```python

import urllib.request

# 定义目标URL

url = 'http://example.com'

# 使用urllib.request打开URL

response = urllib.request.urlopen(url)

# 读取响应内容并解码

html_content = response.read().decode('utf-8')

# 打印网页内容

print(html_content)

```

在这段代码中,我们使用`urlopen`方法来发送一个GET请求,并获取响应。然后我们读取响应的内容并将其解码为UTF-8格式的字符串,以便于阅读和进一步处理。

同样的任务,使用requests库可以更简洁地完成:

```python

import requests

# 定义目标URL

url = 'http://example.com'

# 发起GET请求

response = requests.get(url)

# 打印网页内容

print(response.text)

```

这里我们调用`requests.get`方法直接发起GET请求,然后直接打印响应的内容。

### 5.1.2 分析抓取结果和数据清洗

获取网页内容后,接下来需要解析和清洗数据,以便于后续的数据分析和存储。

在使用urllib获取内容后,我们可以使用`BeautifulSoup`库来解析HTML并提取所需数据:

```python

from bs4 import BeautifulSoup

# 解析网页内容

soup = BeautifulSoup(html_content, 'html.parser')

# 提取所需数据,例如所有的段落内容

paragraphs = soup.find_all('p')

```

对于使用requests获取的内容,同样可以使用BeautifulSoup进行解析。

在实际的数据清洗过程中,可能还需要进行字符串处理、格式转换等操作。在这些方面,Python提供了强大的字符串处理能力,如`split`, `strip`, `replace`等方法。

## 5.2 网络API交互

随着Web 2.0的发展,许多Web应用都提供了RESTful API供外部调用。我们经常需要与这些API交互,例如获取或发送数据。urllib和requests都提供了解决方案。

### 5.2.1 构建RESTful API请求

以一个典型的RESTful API请求为例,我们将会演示如何使用urllib和requests构建请求:

使用urllib构建API请求的代码如下:

```python

import urllib.parse

import urllib.request

# API的基本URL

base_url = 'https://api.example.com/items'

# 参数字典

params = {'key1': 'value1', 'key2': 'value2'}

# 编码参数

encoded_params = urllib.parse.urlencode(params)

# 完整的API请求URL

url = base_url + '?' + encoded_params

# 发起GET请求

response = urllib.request.urlopen(url)

# 读取响应内容

api_response = response.read().decode('utf-8')

# 处理响应内容

print(api_response)

```

使用requests库,代码更加简洁:

```python

import requests

# API的基本URL

url = 'https://api.example.com/items'

# 参数字典

params = {'key1': 'value1', 'key2': 'value2'}

# 发起GET请求,并直接传递参数

response = requests.get(url, params=params)

# 打印响应内容

print(response.json()) # 假设API返回的是JSON格式的数据

```

### 5.2.2 处理API响应和错误

在与API交互时,我们必须能够妥善处理响应和潜在的错误。urllib和requests都提供了一系列的方式来处理这些情况。

对于urllib,我们可以检查响应状态码:

```python

# 检查响应状态码

if response.status == 200:

print('Success!')

else:

print('Failed:', response.status)

```

对于requests,我们更倾向于使用异常处理来捕获错误:

```python

try:

response = requests.get(url, params=params)

response.raise_for_status() # 如果响应状态码不是200,将引发HTTPError异常

# 成功获取响应,处理数据

except requests.exceptions.HTTPError as errh:

print ("Http Error:",errh)

except requests.exceptions.ConnectionError as errc:

print ("Error Connecting:",errc)

except requests.exceptions.Timeout as errt:

print ("Timeout Error:",errt)

except requests.exceptions.RequestException as err:

print ("OOps: Something Else",err)

```

## 5.3 Web自动化测试

自动化测试能够提高测试的效率和可靠性,特别是在Web应用开发中。requests库可以用来模拟浏览器行为,测试Web应用的网络功能。

### 5.3.1 使用requests模拟浏览器行为

使用requests模拟浏览器的POST请求,包括表单提交和文件上传:

```python

import requests

# 定义提交的表单数据

data = {

'username': 'testuser',

'password': 'testpass'

}

# 定义文件上传的文件路径和字段名

files = {

'file': open('example.txt', 'rb')

}

# 发起POST请求

response = requests.post('http://example.com/login', data=data, files=files)

# 打印响应内容

print(response.text)

```

### 5.3.2 验证Web应用的网络功能

验证Web应用是否按预期工作,比如检查API的响应数据:

```python

# 发起GET请求到API

api_response = requests.get('http://example.com/api/data')

# 断言响应数据是否正确

assert api_response.json()['status'] == 'success', "API返回错误的状态码"

```

以上代码段展示了如何使用requests进行API请求,并进行断言来验证返回的状态码是否符合预期。

通过本小节的案例分析,我们演示了urllib和requests库在实际网络请求中的应用,如何进行数据抓取、API交互以及自动化测试,并提供了代码示例和操作步骤。接下来的章节,我们将对urllib和requests库进行对比分析,以帮助读者更好地理解它们的优劣势,从而在项目中做出更合适的技术选择。

# 6. 总结与展望

在这一章中,我们将回顾urllib和requests库在Python网络编程中的地位和作用,分析它们各自的优劣势,并对其未来的发展趋势进行预测。最后,我们还将提供一些最佳实践建议和学习资源,帮助读者更深入地掌握和应用这两个强大的库。

## 6.1 总结urllib和requests的优劣势

urllib和requests作为Python中用于处理HTTP请求的两个库,它们各自拥有不同的特点和优势。

urllib:

- **优势**:

- 内置库:无需额外安装,直接使用Python自带的库。

- 功能全面:覆盖了网络请求、响应处理、编码处理等多个方面。

- 可扩展性:支持通过子模块如urllib.parse进行URL处理,urllib.robotparser处理robots.txt文件等。

- **劣势**:

- 使用相对繁琐:相较于requests,其API设计较为复杂,需要更多的代码来完成相同的任务。

- 缺少直观的异常处理:在错误处理方面不如requests直观易懂。

requests:

- **优势**:

- 简洁直观:提供了简洁易读的API,使得网络请求的代码更加直观和易于管理。

- 强大的异常处理:丰富的异常类型,方便快速定位和处理问题。

- 社区支持:拥有广泛的社区支持和丰富的第三方扩展。

- **劣势**:

- 需要安装:不像urllib是Python标准库的一部分,需要额外安装requests库。

- 性能开销:虽然对性能的影响不大,但在极少数情况下requests可能比urllib稍微慢一些。

## 6.2 未来发展方向和趋势预测

随着网络技术的不断发展,urllib和requests也在不断地更新和优化。

urllib可能会:

- 继续保持其标准库的地位,集成更多针对现代网络协议的支持。

- 改善用户体验,提供更加直观易用的接口。

requests可能会:

- 进一步优化性能,缩小与urllib在性能上的差距。

- 增加更多企业级特性,比如更完善的日志记录、更好的安全性支持等。

此外,随着Python语言本身的演进,两个库都可能会利用新的语言特性,进一步提升开发效率和代码的可读性。

## 6.3 推荐最佳实践和学习资源

### 最佳实践

- 对于初学者和简单的项目,推荐使用requests库,因为它更加简洁易用。

- 对于需要深度定制和扩展的场景,可以考虑urllib,或者结合requests的扩展能力使用。

- 在任何情况下,都要确保异常处理到位,以应对网络请求可能出现的各种异常情况。

### 学习资源

- 官方文档:[urllib官方文档](https://docs.python.org/3/library/urllib.html) 和 [requests官方文档](https://requests.readthedocs.io/en/latest/)

- 在线教程和课程:可以在Coursera、Udemy等在线教育平台搜索相关的课程。

- 社区和论坛:参与Stack Overflow、GitHub等社区的讨论,可以快速解决遇到的问题。

- 博客和书籍:许多技术博主和作者会分享他们使用urllib和requests的实战经验,这是一些非常宝贵的学习资源。

以上内容为本章的详细介绍,通过对比和分析,我们不仅理解了urllib和requests的优缺点,而且对于如何选择和使用这两个库有了更清晰的认识。同时,也对它们未来的发展方向和趋势有了大概的判断。此外,最佳实践和学习资源的推荐,为想要深入学习和应用这两个库的读者提供了指导。

0

0