爬虫的扩展模块开发:自定义爬虫组件构建的秘诀

发布时间: 2024-12-12 22:12:19 阅读量: 5 订阅数: 6

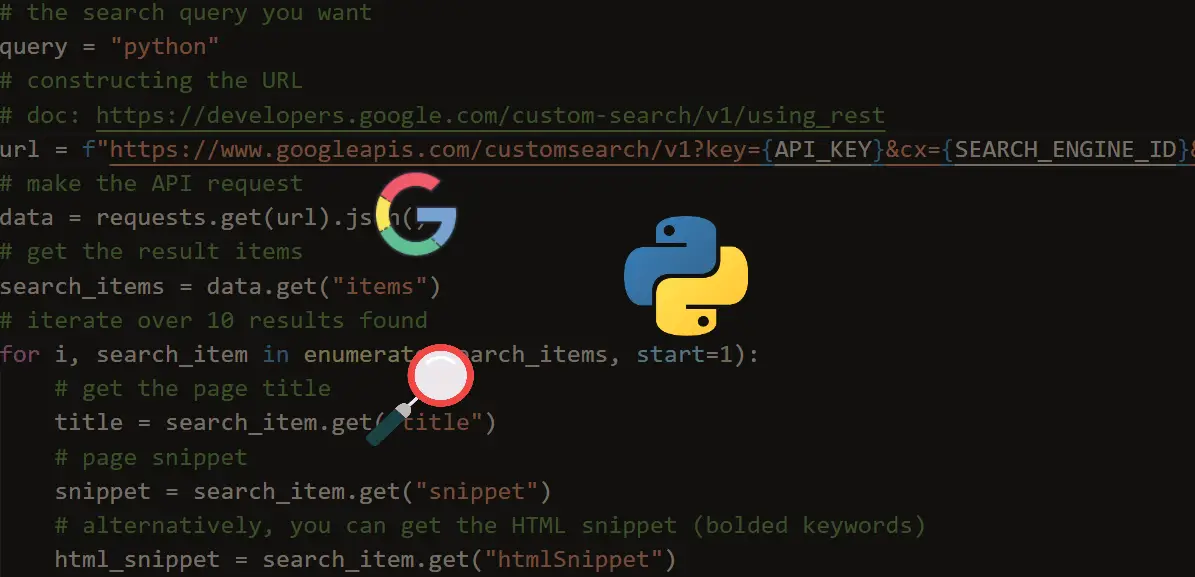

Python 爬虫开发资源指南: 基础教程与实践

# 1. 爬虫扩展模块的概述和作用

## 简介

爬虫技术是数据获取和信息抓取的关键手段,而扩展模块是其核心部分。扩展模块可以实现特定功能,提高爬虫效率和适用范围,实现复杂任务。

## 作用

爬虫扩展模块的作用主要体现在三个方面:首先,通过模块化设计可以提高代码的复用性和维护性;其次,它能够提升爬虫的性能,满足大规模数据处理需求;最后,扩展模块还可以增加爬虫的灵活性,使其能够适应不断变化的数据源和反爬策略。

## 扩展模块实例

举个例子,数据解析模块可以对网页的HTML结构进行深度解析,提取所需数据;数据存储模块则负责高效地处理和保存爬取的数据;数据请求模块则可以处理复杂的网络请求逻辑,包括重试策略和反反爬机制。

接下来的章节,我们将深入探讨爬虫扩展模块的理论基础,逐步揭示其背后的原理和设计思路。

# 2. 爬虫扩展模块的理论基础

## 2.1 爬虫扩展模块的分类

### 2.1.1 数据解析模块

数据解析模块是爬虫扩展模块中非常关键的一个部分,它的主要任务是处理从网页获取的HTML文档,提取出有用的数据,并将其转换成结构化的信息供后续使用。解析模块的实现通常依赖于特定的解析库,例如Python中的BeautifulSoup和lxml。

#### 解析库的选择和对比

BeautifulSoup是一个十分流行的解析库,以其易用性著称。它通过多种解析器的接口提供了统一的API,比如html.parser、lxml、html5lib等,使得开发者可以更加聚焦于数据的提取而不是文档的解析细节。

lxml库则以速度和灵活性著称,它是一个高性能的XML和HTML的解析库,使用C语言编写而成,因此在性能上相较纯Python实现的解析器有显著优势。

#### 实现自定义解析器的步骤和代码示例

以BeautifulSoup为例,我们可以先安装库:

```bash

pip install beautifulsoup4

```

接下来展示如何使用BeautifulSoup解析HTML并提取特定数据:

```python

from bs4 import BeautifulSoup

# HTML文档字符串

html_doc = """

<html><head><title>The Dormouse's story</title></head>

<p class="title"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

# 创建BeautifulSoup对象

soup = BeautifulSoup(html_doc, 'html.parser')

# 提取<p>标签中的文本

p_text = soup.p.text

# 使用查找器找到所有<a>标签

links = soup.find_all('a')

# 打印结果

print(p_text)

for link in links:

print(link.get('href'), link.text)

```

#### 高级数据解析技术的探索

对于复杂的网页结构,除了简单的解析标签和属性,有时候还需要处理JavaScript动态生成的内容。这时,可以使用Selenium和Pyppeteer等工具来模拟浏览器行为,获取最终渲染后的页面源代码。

## 2.2 爬虫扩展模块的理论框架

### 2.2.1 模块化设计的概念

模块化设计是指将系统分解为独立模块的过程。每个模块都有确定的输入和输出接口,且仅依赖于其接口。模块化设计的目标是降低系统复杂性,提高可维护性和可复用性。

### 2.2.2 模块间的协作机制

在爬虫系统中,模块间的协作机制十分关键。数据解析模块将解析后的数据传递给数据存储模块,而数据请求模块则负责获取新的数据源,它们相互协作以完成爬虫的工作。

### 2.2.3 模块的封装和接口设计

为了实现模块间的良好协作,每个模块都应该被封装成一个独立的实体,拥有清晰定义的接口。接口是模块间通信的桥梁,封装则是确保模块内部复杂性不溢出到外部的关键手段。

## 2.3 爬虫扩展模块的开发工具和环境

### 2.3.1 开发语言的选择和对比

在选择开发语言时,Python因其简洁的语法、强大的社区支持和丰富的库资源,成为爬虫开发的首选语言之一。然而,其他语言如JavaScript(Node.js)、Go和Rust也有各自的优势,可以根据项目需求选择合适的技术栈。

### 2.3.2 开发环境的搭建和配置

开发环境的搭建包括安装必要的软件和配置环境变量。对于Python项目,通常需要安装Python解释器、IDE(如PyCharm或VS Code),以及依赖管理工具(如pipenv或Poetry)。

### 2.3.3 版本控制和代码管理工具

代码管理工具如Git是现代软件开发不可或缺的一部分,它能够帮助开发者更好地管理项目版本,协作开发,并且在出现问题时进行回滚。GitHub、GitLab和Bitbucket是常见的代码托管平台。

在完成第二章的理论基础介绍后,下一章节将继续深入探讨爬虫扩展模块的开发实践,包括自定义模块的开发和实现、数据库解决方案的选择,以及HTTP请求库的使用和高级请求策略。

# 3. 爬虫扩展模块开发实践

## 3.1 自定义数据解析模块的开发

数据解析模块作为爬虫扩展模块的核心,负责从网页中提取出有用的数据。为了更好地适应不同的网站结构和数据格式,选择合适的解析库是至关重要的一步。

### 3.1.1 解析库的选择和对比

在众多解析库中,`BeautifulSoup`和`lxml`是Python中较为流行的两种选择。`BeautifulSoup`提供了简单易用的API,适合快速提取数据。而`lxml`则以性能高效著称,适用于大规模数据抓取。在选择时需要考虑项目的具体需求,例如速度和易用性之间的权衡。

```python

# 代码块:BeautifulSoup解析示例

from bs4 import BeautifulSoup

import requests

# 发送HTTP请求获取网页内容

response = requests.get('https://example.com')

response.encoding = response.apparent_encoding

# 使用BeautifulSoup解析HTML

soup = BeautifulSoup(response.text, 'html.parser')

# 提取网页中的所有链接

links = soup.find_all('a')

for link in links:

print(link.get('href'))

```

### 3.1.2 实现自定义解析器的步骤和代码示例

在某些情况下,标准的解析库可能无法满足特定的需求,这时我们可以自己实现一个解析器。

```python

# 代码块:自定义解析器示例

import re

class CustomParser:

def __init__(self, html):

self.html = html

self.parsed_data = []

def parse(self):

# 使用正则表达式匹配数据

pattern = re.compile(r'<div class="data">(.*?)</div>')

matches = pattern.findall(self.html)

return matches

# 使用自定义解析器

parser = CustomParser(response.text)

parsed_data = parser.parse()

```

### 3.1.3 高级数据解析技术的探索

随着网站结构的日益复杂,我们可能需要更高

0

0