大数据处理框架解析:Spark、Flink、Storm的特性与应用场景,满足不同数据处理需求

发布时间: 2024-05-24 18:05:43 阅读量: 72 订阅数: 39

# 1. 大数据处理框架概述

大数据处理框架是构建在分布式系统之上的软件平台,用于处理和分析海量数据。这些框架提供了一系列功能,包括数据摄取、数据存储、数据处理和数据分析。

大数据处理框架的主要优点包括:

- **可扩展性:** 框架可以轻松地扩展到处理大量数据,而无需进行重大修改。

- **并行处理:** 框架利用分布式系统的力量来并行处理数据,从而提高性能。

- **容错性:** 框架内置了容错机制,可以自动处理节点故障和数据丢失。

# 2. Spark框架解析

### 2.1 Spark架构与核心组件

**Spark架构**

Spark采用主从架构,由一个Driver程序和多个Executor进程组成。Driver负责作业调度和资源管理,Executor负责执行计算任务。

**核心组件**

* **SparkContext:**Spark应用程序的入口点,负责创建SparkContext对象,管理集群资源和任务调度。

* **RDD(弹性分布式数据集):**Spark中处理的数据抽象,表示分布在集群节点上的数据集。

* **Transformation:**RDD上的操作,用于创建新RDD或修改现有RDD。

* **Action:**RDD上的操作,用于触发计算并返回结果。

* **DAGScheduler:**调度作业的DAG(有向无环图),将作业分解为阶段并分配给Executor执行。

* **TaskScheduler:**分配任务给Executor并监控其执行。

### 2.2 Spark编程模型与API

**编程模型**

Spark提供两种编程模型:

* **RDD编程模型:**基于RDD,使用Transformation和Action操作进行数据处理。

* **DataFrame编程模型:**基于DataFrame,提供类似于SQL的查询和操作。

**API**

Spark提供丰富的API,包括:

* **Spark SQL:**SQL查询和数据分析API。

* **Spark Streaming:**流处理API。

* **Spark MLlib:**机器学习库。

* **Spark GraphX:**图计算库。

### 2.3 Spark生态系统与应用场景

**生态系统**

Spark拥有丰富的生态系统,包括:

* **Spark Streaming:**流处理引擎。

* **Spark SQL:**SQL查询和数据分析引擎。

* **Spark MLlib:**机器学习库。

* **Spark GraphX:**图计算库。

**应用场景**

Spark广泛应用于以下场景:

* **大数据分析:**批量处理大规模数据集。

* **流处理:**实时处理数据流。

* **机器学习:**训练和部署机器学习模型。

* **图计算:**分析和处理图数据。

**代码示例**

```scala

// 创建SparkContext

val sc = new SparkContext("local[*]", "Spark Example")

// 创建RDD

val numbers = sc.parallelize(1 to 10)

// 使用Transformation操作创建新RDD

val squaredNumbers = numbers.map(x => x * x)

// 使用Action操作触发计算并返回结果

squaredNumbers.collect().foreach(println)

```

**逻辑分析**

* `sc.parallelize`创建了一个RDD,将数据并行分布在集群节点上。

* `map`是一个Transformation操作,用于对每个RDD元素应用一个函数,生成一个新的RDD。

* `collect`是一个Action操作,用于将RDD中的数据收集到驱动程序中。

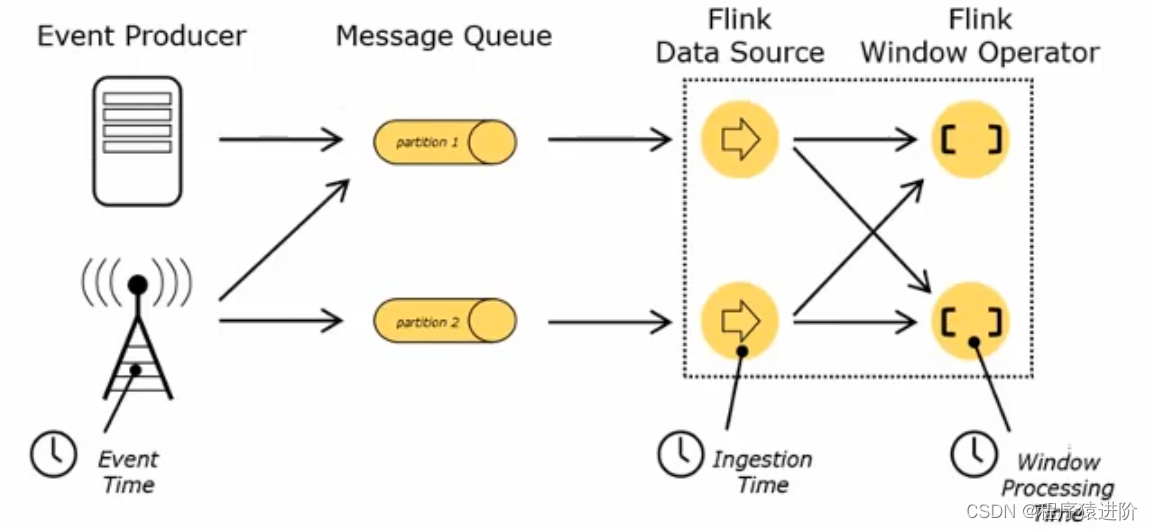

# 3.1 Flink流处理引擎

### 3.1.1 流处理概念

流处理是一种实时处理数据流的技术,与批处理不同,流处理以连续、无界的方式处理数据。数据流可以来自各种来源,如传感器、日志文件或社交媒体。流处理引擎负责实时处理这些数据流,并及时生成结果。

### 3.1.2 Flink流处理架构

Flink是一个分布式流处理

0

0