Origin线性拟合参数解析:掌握非线性数据处理的稀缺技巧

发布时间: 2024-12-03 11:52:23 阅读量: 26 订阅数: 21

数据处理非线性拟合的实践.pdf

参考资源链接:[Origin中线性拟合参数详解:截距、斜率与相关分析](https://wenku.csdn.net/doc/6m9qtgz3vd?spm=1055.2635.3001.10343)

# 1. Origin线性拟合的基本概念与应用

## 1.1 线性拟合简介

线性拟合是数据分析中的一项基础技术,它旨在找出两组变量之间的线性关系,即一条最佳拟合线。Origin软件提供了直观、便捷的线性拟合工具,使得复杂数据的线性关系可视化和量化分析变得简单高效。

## 1.2 线性拟合的应用背景

线性拟合广泛应用于科学、工程、经济学及其他领域,帮助研究者解析数据中潜在的线性规律,验证假设,或为后续的深入研究提供基础。例如,在生物化学实验中,通过线性拟合可以研究酶的活性与底物浓度之间的关系。

## 1.3 线性拟合的步骤概述

在Origin中进行线性拟合通常包含以下步骤:

1. 数据准备:在软件中导入实验数据。

2. 拟合操作:选择线性拟合工具,设置拟合参数。

3. 结果分析:查看并解读拟合结果,包括斜率、截距等关键信息。

Origin线性拟合的过程不仅简单,而且可以灵活地应用于各种数据处理与分析任务中。在后续章节中,我们将进一步深入探讨线性拟合的数学原理、在Origin中的具体操作,以及它的进阶应用和优化方法。

# 2. 理解线性拟合的数学原理

## 2.1 线性拟合的理论基础

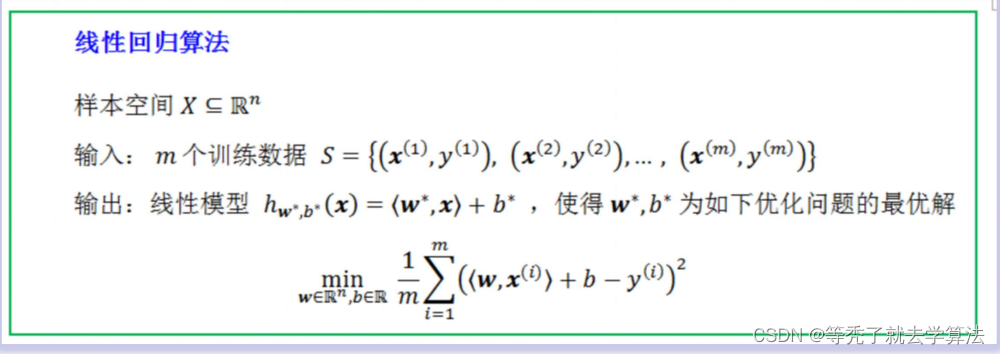

### 2.1.1 直线方程与最小二乘法

在线性拟合中,我们通常会遇到最基础的直线方程,表示为 `y = mx + b`,其中 `m` 是斜率,`b` 是截距。为了在一系列离散的数据点之间找到最佳拟合的直线,我们采用最小二乘法(Least Squares Method)。此方法旨在找到一条直线,使得所有数据点到直线的垂直距离(称为残差)的平方和达到最小。这个平方和可以表示为:

```

S = Σ(y_i - (mx_i + b))^2

```

其中,`Σ` 表示对所有数据点求和,`y_i` 和 `x_i` 分别是每个数据点的 y 值和 x 值。

最小化目标函数 `S` 能够通过求导数并设置等于零来解决,以获得 `m` 和 `b` 的最优值。解得:

```

m = (NΣ(xy) - ΣxΣy) / (NΣ(x^2) - (Σx)^2)

b = (Σy - mΣx) / N

```

其中,`N` 是数据点的数量。

### 2.1.2 参数估计与置信区间

线性拟合得到的参数 `m` 和 `b` 是数据的最佳线性无偏估计(BLUE)。为了了解参数的可靠性,我们还需要计算它们的置信区间。通过计算标准误差和 t 统计量,我们可以得到 `m` 和 `b` 的置信区间,从而判断这些估计是否在统计上显著。

**代码块分析:**

```python

import numpy as np

from scipy import stats

# 假设我们有一组 x 和 y 的数据点

x = np.array([...])

y = np.array([...])

# 使用线性回归拟合参数

slope, intercept, r_value, p_value, std_err = stats.linregress(x, y)

# 输出拟合参数和置信区间

print(f"Slope: {slope}, Intercept: {intercept}")

print(f"Confidence interval for slope: {slope + stats.t.ppf(1-0.025, len(x)-2) * std_err}")

print(f"Confidence interval for intercept: {intercept + stats.t.ppf(1-0.025, len(x)-2) * std_err}")

```

在这个代码段中,`linregress` 函数用于计算线性回归的斜率(slope)、截距(intercept)、相关系数(r_value)、p_value 和标准误差(std_err)。`ppf` 函数用于查找 t 分布的分位数,从而得到置信区间的边界。

## 2.2 线性拟合的数据准备

### 2.2.1 数据点的收集与整理

进行线性拟合之前,首先需要收集并整理数据点。这通常涉及确保数据的准确性、清除异常值,并可能需要转换数据以满足线性拟合的前提条件。数据收集完成后,还需要对数据进行可视化,以便直观地了解数据的分布和趋势。

### 2.2.2 异常值的识别与处理

在收集数据后,我们可能遇到异常值。异常值可能因为测量误差、数据录入错误等原因产生,它们会严重影响拟合结果的准确性。处理异常值通常有以下几种策略:

- 忽略异常值,如果它们对分析影响不大。

- 使用统计方法,比如 IQR(四分位距)或 z-score 来识别并去除异常值。

- 通过数据平滑技术,如移动平均或中值滤波器,减少异常值的影响。

**代码块分析:**

```python

# 使用四分位距(IQR)识别异常值

Q1 = np.percentile(x, 25)

Q3 = np.percentile(x, 75)

IQR = Q3 - Q1

# 定义异常值范围

lower_bound = Q1 - 1.5 * IQR

upper_bound = Q3 + 1.5 * IQR

# 标记异常值

outliers = np.where((x < lower_bound) | (x > upper_bound))[0]

# 移除异常值

cleaned_x = np.delete(x, outliers)

cleaned_y = np.delete(y, outliers)

```

在这段代码中,我们先计算了数据集 `x` 的四分位数和四分位距,然后基于 IQR 法则确定了异常值的界限,最后将异常值从数据集中移除。

## 2.3 线性模型的选择与评估

### 2.3.1 线性模型的假设检验

线性回归模型通常有四个基本假设:

1. 线性:数据与预测变量之间存在线性关系。

2. 独立性:数据点是独立收集的。

3. 同方差性:残差具有恒定的方差。

4. 正态性:残差呈正态分布。

为了检验这些假设是否成立,我们可以使用残差图、残差直方图、Q-Q图等工具。

### 2.3.2 拟合优度的判定标准

拟合优度是指拟合模型对观测数据的拟合程度。常用的判定标准包括决定系数(R²),它描述了数据变化中能被模型解释的比例。R² 值越接近1,模型的解释力越强。不过,R² 有时会误导人,特别是在模型中增加自变量时,因此有时会使用调整后的 R²(Adjusted R²)。

**代码块分析:**

```python

import matplotlib.pyplot as plt

from statsmodels.graphics.gofplots import qqplot

# 线性回归拟合

model = np.polyfit(x, y, 1)

model_predict = np.poly1d(model)(x)

# 残差分析

```

0

0