【深度学习框架一较高下】:TensorFlow vs PyTorch,谁更适合模型优化?

发布时间: 2024-12-07 07:08:07 阅读量: 25 订阅数: 16

# 1. 深度学习框架概览与比较

在当今高速发展的IT领域中,深度学习已经成为一种变革性的力量,而深度学习框架则是实现这一力量的关键工具。本章将简要概述几个当前最流行的深度学习框架,并对它们进行比较。

首先,我们将通过简单的定义和基本特性来介绍这些框架,比如TensorFlow,PyTorch,MXNet,和Keras。每个框架都有其独特的设计哲学和应用领域,例如TensorFlow的可扩展性和部署能力,PyTorch的动态图设计和易用性。

接下来,我们将讨论这些框架在性能、社区支持、学习曲线、部署和生态系统等方面的比较。例如,TensorFlow提供了强大的生产部署工具,而PyTorch则在研究社区中更为流行,主要是因为它的开发迭代速度和灵活性。

在此基础上,我们还将探讨不同的框架如何适应特定类型的应用,比如大规模企业级应用和需要快速原型设计的学术研究。我们将提供一个比较的视角,帮助读者根据自身需求和目标,为未来可能的项目选择最佳的深度学习框架。

通过阅读本章,你将获得一个全面了解现代深度学习框架的基础,为后续的深入学习和实践打下坚实的基础。

# 2. TensorFlow的理论基础与实践

## 2.1 TensorFlow的架构与设计理念

### 2.1.1 TensorFlow的计算图原理

TensorFlow 是一个开源的软件库,广泛用于数值计算,尤其是机器学习领域。其设计理念基于数据流图(DataFlow Graphs),即图中节点代表数学操作,而边则代表在节点间传递的多维数组(张量Tensor)。这种设计允许开发者将复杂算法表达为一个有向无环图(DAG),其中的节点可能分布在不同设备和机器上执行,从而实现高效的并行运算和分布式计算。

计算图的构建和执行分为两个阶段:图构建和会话运行。在图构建阶段,开发者定义了操作和张量,它们之间通过边相连接,但此时并没有进行计算。在会话(Session)中,通过调用 `run` 方法来执行计算,计算图会得到实际的计算资源并执行计算任务。

```python

import tensorflow as tf

# 构建计算图

a = tf.constant([1, 2])

b = tf.constant([3, 4])

c = tf.add(a, b)

# 创建一个Session来执行图

with tf.Session() as sess:

result = sess.run(c)

print(result) # 输出[4, 6]

```

在上述代码中,`tf.constant` 和 `tf.add` 定义了操作和张量,但这些节点并没有立即执行。只有当 `sess.run(c)` 被调用时,图中的计算才会被执行。

### 2.1.2 TensorFlow的编程范式

TensorFlow 提供了一种全新的编程范式。与传统的命令式编程(Imperative Programming)不同,TensorFlow 使用的是声明式编程(Declarative Programming),开发者只需声明应该做什么,而不是如何做。

这种方式有几个优点:首先,它可以轻松地在不同的设备上运行相同的计算图,无需修改代码;其次,计算图的优化和调整可以由 TensorFlow 自动完成,这减少了代码的复杂性和出错的可能性。

TensorFlow 的编程范式还支持静态图和动态图的使用。静态图在运行前构建,这有助于优化执行路径,但不便于调试。动态图(如在 TensorFlow 2.x 中使用 Eager Execution)则允许即时执行代码,类似于 Python 的命令式编程,便于调试和快速开发。

## 2.2 TensorFlow的核心组件

### 2.2.1 张量操作与数据流图

在 TensorFlow 中,几乎所有的数据都是以张量的形式表示。张量可以看作是多维数组,它具有数据类型和形状。数据流图中,张量通常作为操作的输入和输出。

张量操作是构建数据流图的基础。TensorFlow 提供了一系列函数来创建和操作张量,比如 `tf.add()`, `tf.matmul()`, `tf.placeholder()` 等。这些函数创建的操作节点,一旦被放置在数据流图中,便可以被 TensorFlow 的执行引擎所识别和执行。

```python

# 创建一个常量张量

t1 = tf.constant(4.0, shape=[1, 1], name="t1")

t2 = tf.constant(5.0, shape=[1, 1], name="t2")

# 创建一个张量操作

product = tf.matmul(t1, t2)

# 创建一个 Session 并执行张量操作

with tf.Session() as sess:

result = sess.run(product)

print(result) # 输出 [[20.0]]

```

### 2.2.2 TensorFlow的API层次结构

TensorFlow 提供了一套丰富多层的 API,使开发者能够以不同的粒度来控制计算过程。从低级 API 到高级 API,TensorFlow 的 API 层次结构主要包括以下三个层次:

- Core API:这是 TensorFlow 的底层接口,包括创建和操作张量、变量的函数,以及构建和运行计算图的核心操作。它允许开发者进行详细的控制,但使用起来较为繁琐。

- Keras API:TensorFlow 提供了一个高级API,即 Keras,它是一个高层神经网络 API,可以用来快速构建和训练模型。Keras 旨在允许深度学习模型的快速迭代。

- Estimator API:它提供了一组高级封装好的模型,可以直接进行训练和评估,非常适合机器学习工作流,无需深入了解底层细节。

### 2.2.3 变量管理和作用域

在 TensorFlow 中,变量是用于存储和更新参数的特殊类型张量。它们在图的执行过程中可以被修改,这对于训练神经网络是至关重要的。变量需要初始化,并且在模型训练过程中保持状态。

TensorFlow 提供了 `tf.Variable` 来创建变量,并且引入了作用域(Scope)来帮助管理和重用变量。通过作用域可以将变量的名称空间化,从而管理命名冲突,并允许变量在图的不同部分共享。

```python

import tensorflow as tf

# 定义一个变量,初始值为0,类型为浮点型,名称为 "counter"

counter = tf.Variable(0.0, dtype=tf.float32, name="counter")

# 创建一个变量作用域

with tf.variable_scope("root"):

# 在作用域内创建另一个变量

inner_var = tf.Variable(0.0, dtype=tf.float32, name="inner")

# 创建一个 Session 并运行操作

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

print(sess.run(counter)) # 输出 0.0

```

## 2.3 TensorFlow在模型优化中的应用

### 2.3.1 梯度下降和优化器选择

在机器学习和深度学习中,梯度下降是一种常用的优化算法,用于最小化损失函数。TensorFlow 提供了多种梯度下降的变体,如梯度下降、动量优化、Adam优化器等。每种优化器都有其特定的使用场景和参数,可以有效地帮助模型在训练过程中快速收敛。

```python

# 定义一个简单的损失函数

loss = tf.reduce_mean(tf.square(y - tf.matmul(X, weights)))

# 定义一个优化器,这里使用Adam优化器

optimizer = tf.train.AdamOptimizer(learning_rate=0.01).minimize(loss)

```

### 2.3.2 高级优化技术与策略

在进行深度学习模型训练时,除了使用不同的优化器,还可以采用一些高级技术与策略来优化模型性能,如正则化、学习率衰减、批量归一化等。

正则化技术可以防止模型过拟合,例如通过在损失函数中添加L1或L2正则化项。学习率衰减是一种学习率调度策略,随训练进程逐渐减小学习率,帮助模型稳定收敛。批量归一化(Batch Normalization)可以加速模型训练并减少对初始化的依赖。

### 2.3.3 模型保存、恢复和部署

模型训练完成后,通常需要保存模型的参数和结构,以便将来进行预测或者继续训练。TensorFlow 提供了 `tf.train.Saver` 类来保存和恢复模型。

```python

# 创建一个 Saver 对象来保存和恢复所有变量

saver = tf.train.Saver()

# 在训练完成后保存模型

with tf.Session() as sess:

# ... (训练过程)

save_path = saver.save(sess, "model.ckpt")

print("模型保存在文件:%s" % save_path)

```

保存后的模型可以使用 `Saver.restore()` 方法恢复到一个会话中:

```python

# 创建一个新的会话

with tf.Session() as sess:

saver.restore(sess, "model.ckpt")

print("模型已恢复")

```

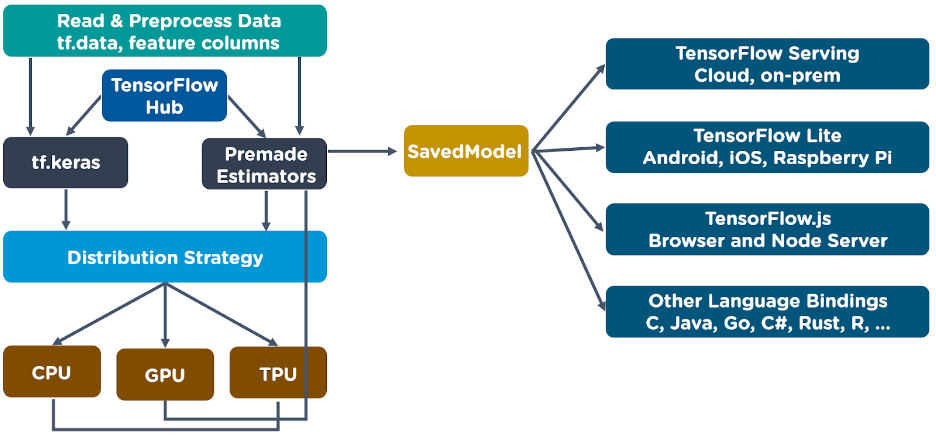

模型部署通常涉及将训练好的模型导出为某种标准格式(如 SavedModel),然后部署到生产环境中以供推理使用。TensorFlow 提供了灵活的工具来处理这个过程,从而实现模型的高效部署。

# 3. PyTorch的理论基础与实践

## 3.1 PyTorch的动态计算图原理

### 3.1.1 PyTorch的自动求导机制

PyTorch采用了动态计算图(也称为即时(Just-In-Time,JIT)编译),意味着图的构建与执行是同时进行的。这一设计哲学使得PyTorch在模型开发和调试阶段更加灵活。PyT

0

0