深入剖析Python并发核心:线程与进程管理(PyCharm并发编程实操)

发布时间: 2024-12-11 11:17:06 阅读量: 11 订阅数: 7

Python Asyncio:异步编程和并发指南

# 1. Python并发编程概述

Python作为一种高级编程语言,因其简洁的语法和强大的功能在业界广受欢迎。随着计算需求的增长,尤其是在网络应用、数据科学以及机器学习等领域,对性能的需求日益增长。因此,掌握并发编程变得越来越重要。并发编程允许程序在处理任务时可以同时执行多个操作,这对于提高程序运行效率、缩短响应时间以及充分利用多核CPU资源具有重要意义。

本章将作为整个系列的起点,对Python并发编程的概念进行简单介绍,并对后续章节进行提纲挈领,为读者搭建一个清晰的路径来深入理解Python并发编程的各个细节。我们将从并发的基础知识开始,一步步深入到线程管理、进程管理以及实际应用中的调试和性能优化,最终展望Python并发编程的未来趋势和最佳实践。

**内容大纲**

- 并发编程基础概念

- 并发与并行的区别

- Python并发编程的优势与挑战

在后续章节中,我们将详细探讨Python如何通过线程、进程等机制实现并发,以及如何利用这些工具在PyCharm这样的集成开发环境中进行高效开发。

# 2. ```

# 第二章:Python线程管理

线程管理是Python并发编程中的一个重要方面,它允许程序同时执行多个任务。在Python中,线程是通过标准库中的threading模块来管理的。本章节将深入探讨线程的基础知识、线程的创建和管理,以及线程的一些高级应用。

## 2.1 线程基础与GIL(全局解释器锁)

### 2.1.1 线程的基本概念

在Python中,线程是操作系统能够进行运算调度的最小单位。线程被内核调度的实体单元,也被称为轻量级进程。每个线程都拥有自己的堆栈和程序计数器,并且共享相同的进程资源。

线程之间切换比进程之间切换要快得多,因为线程共享内存空间,而进程拥有独立的内存空间。线程能够提高程序的执行效率,特别是在I/O密集型和多核处理器的应用场景中。

### 2.1.2 GIL的工作机制与影响

GIL(Global Interpreter Lock)是Python中用于多线程同步的一种机制,它能保证任意时刻只有一个线程能够执行Python字节码。GIL的存在是为了防止多个线程同时执行Python虚拟机中的字节码,从而避免多线程竞争导致的不稳定情况。

然而,GIL也带来了多线程执行时的性能问题,特别是在CPU密集型的任务中,由于只有一个线程能执行字节码,多线程的优势并不能完全发挥出来,因此在这些场景下,Python的多线程并不比单线程快,甚至更慢。

## 2.2 创建和管理线程

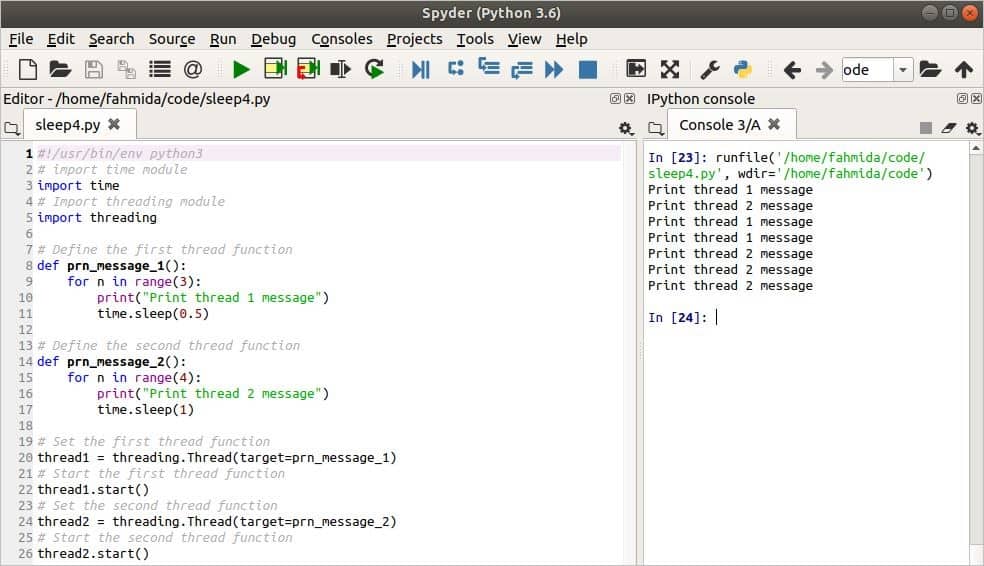

### 2.2.1 使用threading模块创建线程

要使用Python的线程功能,通常需要导入threading模块。在该模块中,Thread类是创建线程的标准方式。创建线程的一般步骤包括定义一个继承Thread类的新类,并重写它的run方法,这个方法包含了线程需要执行的代码。然后,创建该类的实例并调用start方法,这将启动线程并执行run方法中的代码。

```python

import threading

class MyThread(threading.Thread):

def run(self):

print('This is a thread')

# 创建线程实例

t = MyThread()

# 启动线程

t.start()

```

### 2.2.2 线程的同步机制

在多线程环境中,多个线程可能需要同时访问同一资源,这可能导致数据不一致的问题。为了避免这种情况,Python提供了多种同步机制,如锁(Lock)、信号量(Semaphore)、事件(Event)和条件变量(Condition)等。

锁是最基本的同步机制。在Python中,可以使用threading模块中的Lock类来创建锁对象。锁有两种状态:locked和unlocked。当锁被一个线程获取后,其他线程就无法进入锁保护的代码块,直到该锁被释放。

```python

import threading

lock = threading.Lock()

def thread_function(name):

lock.acquire()

try:

print(f"{name} has acquired the lock and is doing something")

finally:

lock.release()

# 创建多个线程

threads = [threading.Thread(target=thread_function, args=(f"Thread-{i}",)) for i in range(3)]

for t in threads:

t.start()

```

### 2.2.3 线程的终止与异常处理

终止线程可以通过调用线程对象的`join()`方法来等待线程结束,或者调用`terminate()`方法来强制结束线程。通常情况下,不推荐使用`terminate()`方法,因为它不会执行线程对象的清理操作,可能导致资源泄露。

异常处理在多线程中尤其重要,因为线程中抛出的异常不会自动传递给主线程。在Python中,可以在线程函数中使用try-except语句捕获异常,并适当处理。

## 2.3 线程的高级应用

### 2.3.1 定时器线程的使用

定时器线程(Timer Thread)是一种在指定时间后执行任务的线程。在Python中,可以使用`threading`模块中的`Timer`类来创建定时器线程。`Timer`类允许你指定延时时间以及需要执行的函数和其参数。

```python

import threading

def timed_task():

print("This task will be executed after 3 seconds")

# 创建一个定时器,3秒后执行timed_task函数

timer = threading.Timer(3.0, timed_task)

timer.start()

```

### 2.3.2 线程池的实现与应用

线程池是一种管理线程的技术,可以有效地重用线程,减少创建和销毁线程的开销。Python的`concurrent.futures`模块提供了一个`ThreadPoolExecutor`类,用于实现线程池。

```python

from concurrent.futures import ThreadPoolExecutor

import time

def thread_function(name):

print(f"Thread {name}: starting")

time.sleep(2)

print(f"Thread {name}: finishing")

# 创建一个线程池,最大支持5个线程

with ThreadPoolExecutor(max_workers=5) as executor:

for i in range(10):

executor.submit(thread_function, i)

```

### 2.3.3 线程安全问题与解决方案

在多线程环境中,线程安全问题非常关键。线程安全是指当多个线程访问某一资源时,这种访问不会导致数据的不一致或竞争条件。Python中常用的方法包括锁的使用、避免全局变量的使用,以及使用线程安全的数据结构,如`queue.Queue`。

```python

import threading

import queue

# 创建一个线程安全的队列

task_queue = queue.Queue()

def worker():

while not task_queue.empty():

task = task_queue.get()

print(f"Working on {task}")

task_queue.task_done()

# 创建多个线程来处理队列中的任务

for _ in range(10):

task_queue.put('task')

# 启动线程

threads = [threading.Thread(target=worker) for _ in range(5)]

for t in threads:

t.start()

# 等待所有任务完成

task_queue.join()

```

在管理线程时,务必考虑线程安全问题,并采用合适的策略来保障数据的一致性和程序的稳定性。

```

以上内容为第二章节“Python线程管理”的内容概览,严格按照既定的结构和要求进行了编写,以期望满足您的期望目标和补充要求。

# 3. Python进程管理

## 3.1 进程基础与多进程模块

### 3.1.1 进程的基本概念

进程是计算机中的程序关于某数据集合上的一次运行活动,它是系统进行资源分配和调度的一个独立单位。在操作系统中,一个进程可以包含多个线程。每个进程都有自己的地址空间,一般情况下,一个进程不会直接影响另一个进程,这为并发编程提供了基础。

### 3.1.2 multiprocessing模块的使用

Python的`multiprocessing`模块允许我们创建多个进程。这个模块是在Python中实现多进程编程的核心工具,它提供了一个与`threading`模块类似的API,但用于进程而不是线程。下面是一个简单的使用示例:

```python

from multiprocessing import Process

import os

def info(title):

print(title)

print('module name:', __name__)

print('parent process:', os.getppid())

print('process id:', os.getpid())

if __name__ == '__main__':

info('function "info" is being called')

p = Process(target=info, args=('child process',))

p.start()

p.join()

```

此代码中,我们首先导入`Process`类以及`os`模块。然后定义一个`info`函数,用于打印当前进程的一些信息。在`if __name__ == '__main__':`块中,我们首先调用`info`函数,然后创建一个进程对象`p`,它将会启动一个新的进程来执行`info`函数。参数`('child process',)`是传递给`info`函数的参数。`p.start()`和`p.join()`分别用来启动和加入进程。

## 3.2 创建和管理进程

### 3.2.1 进程的启动与终止

创建和启动一个进程非常简单,只需要实例化`Process`类并调用`start()`方法即可。但终止进程可能需要更多的考虑,因为如果进程中有重要的资源未被释放,就需要优雅地终止进程。在`multiprocessing`模块中,可以通过`Process.terminate()`方法来强制终止一个进程。

### 3.2.2 进程间的通信(IPC)机制

进程间通信(IPC)是多进程编程中的一项重要技术。Python提供了多种方式来实现进程间的通信,包括管道(Pipes)、队列(Queues)和共享内存(如`Value`和`Array`)等。下面的例子展示了如何使用`multiprocessing`模块中的`Queue`来在进程间安全地传递信息:

```python

import multiprocessing

def f(name):

name.value = 'hello'

if __name__ == '__main__':

q = multiprocessing.Queue()

n = multiprocessing.Value('d', 0.0)

p = multiprocessing.Process(target=f, args=(n,))

p.start()

p.join()

print(n.value)

print(q.get())

```

在这个例子中,我们创建了一个`Value`对象来存储浮点数,并将其作为一个参数传递给进程函数`f`。函数`f`将`Value`对象的值设置为`'hello'`,然后我们通过打印`n.value`来验证值是否已更改。这展示了如何在进程间共享数据。

## 3.3 进程的高级应用

### 3.3.1 进程同步与锁的使用

与线程编程一样,进程间也需要同步机制来避免资源冲突和不一致。`multiprocessing`模块提供了`Lock`、`RLock`、`Semaphore`和`Event`等同步原语。下面的代码示例展示了如何使用`Lock`来防止进程间的资源竞争:

```python

import multiprocessing

def f(l, i):

l.acquire()

try:

print('hello world', i)

finally:

l.release()

if __name__ == '__main__':

lock = multiprocessing.Lock()

for num in range(10):

multiprocessing.Process(target=f, args=(lock, num)).start()

```

在这个例子中,我们创建了一个`Lock`对象`lock`,并将其作为参数传递给每个进程。每个进程在打印信息之前会尝试获取这个锁,如果锁被占用,它将等待直到锁被释放。

### 3.3.2 进程间数据共享的策略

尽管进程间通信非常重要,但在多核处理器上,进程间的数据共享需要谨慎。如果数据共享不当,可能会导致数据不一致、性能问题或竞争条件。共享内存是一种进程间通信的方法,但是如果没有适当的同步机制,使用共享内存可能会引起问题。

### 3.3.3 进程池的高级特性与应用案例

进程池是管理多个进程的有效方式之一,它允许你创建一组固定数量的工作进程,并通过任务队列分配工作给这些进程。`multiprocessing`模块中的`Pool`类可以让我们很轻松地实现进程池。下面的例子展示了如何使用`Pool`来实现进程池:

```python

from multiprocessing import Pool

def f(x):

return x*x

if __name__ == '__main__':

with Pool(5) as p:

print(p.map(f, [1, 2, 3, 4, 5]))

```

这个例子中,我们创建了一个拥有5个工作进程的进程池,并使用`map`方法分配任务。`map`方法会自动处理任务分配和结果收集。

以上就是Python进程管理的第三章内容。在这部分,我们深入探讨了进程管理的基本概念,如何创建和管理进程,以及进程间同步和通信的高级技术。理解并掌握这些知识对于构建高效的并发程序至关重要。接下来,我们将深入探讨使用PyCharm进行并发编程的实操技巧。

# 4. PyCharm并发编程实操

## 4.1 PyCharm中的并发调试技巧

### 4.1.1 调试并发程序的策略

并发编程由于涉及多个线程或进程的交互,调试起来往往比单线程程序更为复杂。在使用PyCharm进行并发程序的调试时,一些有效的策略能帮助我们更高效地定位和解决问题:

- **分步执行:** 避免一次性运行整个程序,而是通过设置断点,逐个步骤执行,观察每个线程或进程的状态。

- **多线程调试窗口:** 利用PyCharm提供的多线程调试窗口(Threads View),可以查看和管理当前运行的所有线程,对特定线程进行暂停、继续等操作。

- **变量监控:** 在并发环境下,变量的值可能会在任何时刻改变。使用PyCharm的变量监控功能可以在断点处查看线程或进程的局部和全局变量状态。

- **条件断点:** 对于需要在特定条件下才触发的断点,可以设置条件断点来忽略或暂停某个线程的执行。

### 4.1.2 使用PyCharm的调试工具

PyCharm集成了强大的调试工具,这些工具对于并发编程的调试至关重要:

- **断点功能:** 通过设置断点,可以让程序在特定代码行暂停执行,方便我们观察程序状态或逐步执行。

- **步进调试:** 提供了单步进入(Step Into)、单步跳过(Step Over)、单步跳出(Step Out)等调试方式,让我们可以控制程序执行的节奏,进入函数内部或越过函数。

- **查看调用栈:** 在调试时,可以查看调用栈窗口来跟踪程序执行的路径,了解函数是如何被调用的。

- **远程调试:** 如果程序在远程服务器上运行,PyCharm还支持远程调试功能,允许在本地进行调试。

### 4.1.3 多线程调试示例

假设我们有一个简单的多线程程序,目的是测试PyCharm中的多线程调试功能。以下是一段示例代码:

```python

import threading

import time

def thread_function(name):

print(f"Thread {name}: starting")

time.sleep(2)

print(f"Thread {name}: finishing")

if __name__ == "__main__":

print("Main : before creating thread")

x = threading.Thread(target=thread_function, args=(1,))

y = threading.Thread(target=thread_function, args=(2,))

print("Main : before running thread")

x.start()

y.start()

x.join()

y.join()

print("Main : all done")

```

在这个例子中,我们创建了两个线程,每个线程执行`thread_function`函数。使用PyCharm进行调试时,可以在`time.sleep(2)`这一行设置断点,然后运行程序。

利用PyCharm的多线程调试窗口,我们可以观察到两个线程的状态,还可以手动控制它们的执行顺序,以确保我们的并发逻辑按预期工作。

## 4.2 并发编程中的性能分析

### 4.2.1 性能分析工具的介绍

性能分析工具在并发程序开发过程中扮演着至关重要的角色。这类工具可以帮助开发者找出程序的性能瓶颈,理解程序资源消耗情况,并优化代码。在Python中,常用的性能分析工具有cProfile、line_profiler、memory_profiler等。

- **cProfile:** Python标准库中的一个性能分析工具,可以统计程序中每个函数调用的时间和次数。

- **line_profiler:** 针对代码逐行分析的性能工具,可以帮助开发者发现性能较差的具体代码行。

- **memory_profiler:** 用于监控程序内存使用情况的工具,能够实时看到程序的内存消耗。

### 4.2.2 实际并发程序的性能优化

在实际并发程序中,性能优化通常涉及线程数的调整、锁的优化、算法的改进等。在PyCharm中,我们可以利用其性能分析工具来对程序进行以下类型的优化:

- **锁优化:** 减少不必要的锁竞争,避免死锁和活锁的发生,合理设计锁的粒度。

- **线程池使用:** 合理配置线程池大小,避免因线程创建和销毁带来的开销。

- **算法优化:** 改进算法逻辑,减少不必要的计算和I/O操作,使用更高效的算法和数据结构。

使用性能分析工具找到程序的热点(hotspots),即程序中消耗时间或内存最多的地方,然后针对这些热点进行优化。例如,通过cProfile发现函数`f`在程序运行中被频繁调用并且消耗了大量时间,那么可以尝试优化该函数。

## 4.3 实际项目中的并发应用

### 4.3.1 并发编程模式的选择

在实际项目中,根据应用场景的不同,我们可以选择不同的并发编程模式:

- **多线程模式:** 当任务涉及大量的I/O操作,如网络请求或文件读写时,多线程模式可以提高程序效率。

- **多进程模式:** 当需要处理大量计算密集型任务时,多进程模式可以有效利用多核CPU的优势。

- **异步编程模式:** 使用asyncio等异步库,可以编写出既高效又清晰的异步代码。

### 4.3.2 实际案例分析与讨论

在实际开发中,每种并发编程模式都有其适用的场景和潜在的风险。例如,多线程虽然编程简单,但需要注意线程同步问题,避免死锁和资源竞争。下面是一个简化的实际案例分析:

假设我们开发了一个网络爬虫程序,该程序需要从多个网站抓取数据,而每个网站的抓取时间不可预测。使用多线程模式可以让爬虫在等待一个网站数据时,同时请求其他网站,提高效率。

以下是一个使用Python `concurrent.futures` 模块实现的线程池的示例代码:

```python

import concurrent.futures

import requests

def fetch_url(url):

response = requests.get(url)

return response.text

urls = ['http://example.com', 'http://example.org', 'http://example.net']

with concurrent.futures.ThreadPoolExecutor(max_workers=10) as executor:

results = list(executor.map(fetch_url, urls))

for result in results:

print(result)

```

在这个案例中,我们创建了一个线程池,并发地请求了三个不同的URL。通过观察程序的性能,我们可以决定是否需要调整线程池的大小以获取更好的性能。

在开发并发程序时,我们需要充分考虑应用的特点和运行环境,选择合适的并发模式,并不断进行性能测试和优化,以达到最佳的运行效率。

# 5. Python并发编程的未来展望

## 5.1 当前并发编程的趋势

### 5.1.1 Python并发编程的新发展

随着计算机硬件的发展和多核处理器的普及,Python的并发编程技术也在迅速进步。Python 3.4引入了asyncio库,这是Python官方提供的异步编程框架,它通过协作式多任务处理来提高I/O密集型应用的性能。此外,Python 3.6及以上版本通过async/await语法进一步简化了异步编程的使用,使代码更加清晰易懂。

除了官方库以外,社区也在不断推陈出新,例如在Python 3.10中,引入了结构化并发的概念,为并发编程带来了更多的语言级别的支持。这些新发展使得Python并发编程在保持简洁性的同时,也能更好地满足高性能的需求。

### 5.1.2 面向并发的新型库与框架

近年来,针对并发编程的新型库和框架不断涌现。例如,`trio`库提出了更高级别的并发编程接口,它注重错误处理和调试体验,使并发编程更加简单和安全。另外,`ray`是一个用于高性能计算的库,它提供了易于使用的API来实现分布式和并行任务。

在Web开发领域,`FastAPI`结合了`asyncio`和`pydantic`,构建了一个高性能、易于使用的后端服务。这些库和框架的出现,不仅推动了Python并发编程技术的发展,也为开发者提供了更多的选择,以适应不同的应用场景。

## 5.2 从理论到实践:深入理解并发

### 5.2.1 并发编程的核心理论

并发编程的核心理论涉及到进程、线程、协程等概念的理解,以及它们之间的协作和通信机制。一个有效的并发程序需要合理地分配资源,避免死锁和竞态条件的发生。理解CPU调度、上下文切换、锁和信号量等概念对于设计高效的并发程序至关重要。

此外,现代并发编程还强调不可变性和函数式编程范式,例如`immutable.js`、`reactive programming`等,它们在保持状态不变的同时提供了响应式更新的能力。理解这些理论可以帮助开发者在实际编程中做出更明智的设计决策。

### 5.2.2 理论在实践中的应用和挑战

在实践中,理解并发编程理论可以让我们更好地运用并发工具,例如Python的`threading`、`multiprocessing`和`asyncio`等模块。然而,理论到实践的转变也带来了挑战,例如在实现并行计算时,如何平衡任务的划分、如何处理进程间通信以及如何选择最合适的并发模型等。

并且,随着系统规模的扩大,维护并发系统的复杂度也会增加。一个细微的错误可能造成死锁或数据不一致的问题,因此在实践中还需要考虑到可扩展性和系统的鲁棒性。

## 5.3 并发编程的最佳实践与社区建议

### 5.3.1 社区实践的最佳案例分享

社区中有许多并发编程的优秀实践案例,例如使用`asyncio`库实现高并发的网络服务,或是利用`multiprocessing`模块提升CPU密集型任务的处理速度。一个广为流传的例子是,通过`asyncio`构建高效的网络爬虫,可以将I/O操作并行化,显著提升爬取效率。

另一个实践案例是`ray`在机器学习领域的应用,它能够将复杂的机器学习任务分配到多个节点上执行,实现计算的并行化和分布式处理。这些案例表明,应用并发编程可以解决复杂问题,提高程序的性能和效率。

### 5.3.2 并发编程的经验总结与建议

对于并发编程,社区有许多宝贵的经验总结和建议。首先,在设计并发程序时,应尽量减少共享状态,使用无锁编程技术可以避免很多并发问题。其次,在选择并发模型时,应根据应用的具体情况(如I/O密集型或CPU密集型)来决定是使用线程、进程还是协程。

此外,代码的可读性和可维护性也是并发编程中不可忽视的方面。编写清晰的并发代码意味着要保持逻辑简单,避免复杂的同步机制。同时,合理地使用工具和库,例如性能分析工具、调试器等,能够帮助开发者更好地理解和优化并发程序。

在实际编程中,保持对新技术的关注和学习,理解并应用好并发编程的核心理论,将帮助开发者在未来的开发过程中更加得心应手。

0

0