【深度学习中的损失函数】:深入理解与Python实现,掌握AI模型训练的核心

发布时间: 2024-12-12 02:53:52 阅读量: 13 订阅数: 15

# 1. 深度学习损失函数概述

在深度学习领域,损失函数是模型训练中不可或缺的一环,它评估了模型预测值与真实值之间的差异,为模型提供了学习的依据。简单来说,损失函数可以看作是模型性能的衡量标准,它在优化过程中起到了指导的作用,告诉模型需要在哪些方面进行改进。

损失函数不只是个评价指标,它还直接关联到算法的优化方法,比如梯度下降法。通过最小化损失函数,我们能够调整模型的权重和偏置,从而提高模型的预测准确性。不同的问题类型、不同的应用场景会采用不同的损失函数,因此,选择合适的损失函数对于提升模型性能至关重要。接下来的章节将详细探讨损失函数的理论基础、实现方法、实际应用和未来趋势。

# 2. 损失函数的理论基础

## 2.1 损失函数的定义与作用

损失函数是衡量机器学习模型预测值与真实值差异的重要工具。它在模型优化中起着关键作用,因为它直接关联到模型参数更新的指导。在模型训练过程中,损失函数提供了一种评价标准,用来评估模型对训练数据的拟合程度。

### 2.1.1 损失函数在模型优化中的角色

损失函数是优化算法调整模型参数的核心依据。通过最小化损失函数,可以使模型逐渐向真实数据分布靠拢,提高模型的预测准确性。优化过程中,通常会通过计算损失函数关于模型参数的梯度来决定参数更新的方向与幅度。这一步骤是训练深度学习模型不可或缺的,因为损失函数提供了一个量化的指标,使得模型的改进得以实施。

### 2.1.2 常见损失函数类别

在机器学习中,根据不同的任务类型,会选用不同的损失函数。对于回归问题,通常使用均方误差(MSE)作为损失函数。而分类问题中,则常用交叉熵损失函数。除了这些基础损失函数之外,还有如Hinge损失函数、对数似然损失函数等更为复杂和专业的损失函数存在。每种损失函数都有其独特的数学定义和适用场景。

## 2.2 损失函数的数学原理

### 2.2.1 代价函数与损失函数的区别

在深入讨论损失函数之前,首先需要了解它与代价函数之间的关系。在机器学习中,代价函数(Cost Function)和损失函数(Loss Function)常常被交替使用,但在严格意义上,两者是不同的。损失函数通常是指单个样本的预测值与真实值之间差异的度量,而代价函数则是整个训练数据集上损失函数的平均值。在优化过程中,我们通常关心的是减少整个数据集的平均损失,因此代价函数才是优化算法直接作用的目标。

### 2.2.2 损失函数的凸优化性质

一个优秀的损失函数应当具备凸性质,即函数具有全局最小值,并且在最小值点处的二阶导数大于零。这一性质可以确保优化算法能够找到全局最优解,而不是陷入局部最小值。在数学上,凸函数具有很好的数学性质,使得梯度下降等优化方法能够有效地收敛。然而,并非所有损失函数都是凸的。例如,交叉熵损失函数在分类问题中是凸的,但对于神经网络中的某些非线性激活函数,损失函数可能就不是凸的。

### 2.2.3 损失函数的梯度计算

梯度计算是深度学习损失函数优化中不可或缺的部分。梯度是指损失函数在参数空间中的变化率,它指明了损失函数在参数空间中的下降最快的方向。在数学上,梯度是一个向量,它表示了损失函数在各个参数方向上的偏导数。通过计算损失函数对参数的梯度,我们可以更新参数,以便逐渐减小损失值。梯度计算通常通过链式法则来完成,对于复杂的神经网络结构,这个过程涉及到大量的矩阵运算和自动微分技术。

## 2.3 损失函数的选择与适用场景

### 2.3.1 回归问题的损失函数选择

对于回归问题,最常用的损失函数是均方误差(MSE),它测量了预测值与真实值差值的平方的平均值。MSE对异常值敏感,因为它对大的误差进行了更严厉的惩罚。然而,在某些情况下,如果对异常值不是那么敏感,可以选择平均绝对误差(MAE)作为损失函数。MAE不会对大的误差进行平方放大,因此在处理含有异常值的数据集时可能更合适。

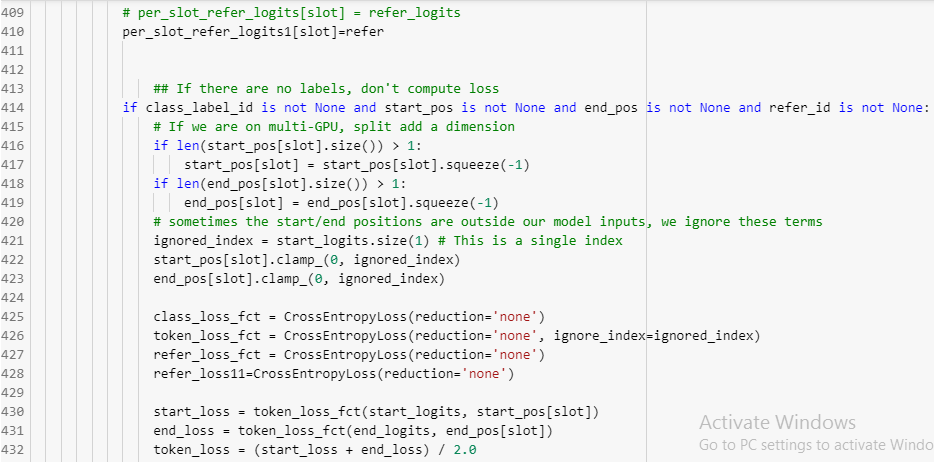

### 2.3.2 分类问题的损失函数选择

分类问题中,交叉熵损失函数是最常见的选择,尤其是在多分类问题中。交叉熵衡量的是两个概率分布之间的差异,因此它在分类问题中能很好地引导模型学习区分不同类别的概率。对于二分类问题,交叉熵损失函数可以直接应用于两类的输出概率。对于多分类问题,可以将交叉熵推广为多类交叉熵损失函数。

### 2.3.3 其他特定问题的损失函数选择

除了回归和分类这两种常见问题之外,还有其他复杂的问题需要特定设计的损失函数。例如,在图像分割问题中,可能会使用像素级别的交叉熵损失函数或Dice损失函数;在强化学习中,可能会使用贝尔曼误差(Bellman Error)作为损失函数。每种损失函数的选择都应该基于问题的特点和需求来进行。因此,设计合适的损失函数是模型优化过程中的一个重要环节。

## 结语

损失函数是深度学习模型优化中的关键组件,它不仅影响着模型的学习过程,还决定了最终模型的性能。理解损失函数的理论基础对于构建高效的模型至关重要。本章内容从损失函数的定义与作用开始,深入讲解了损失函数的数学原理以及如何根据不同的问题选择和应用损失函数。接下来,我们将探讨损失函数在Python中的具体实现方法。

# 3. 损失函数的Python实现

## 3.1 基础损失函数的代码实现

### 3.1.1 均方误差(MSE)的实现

均方误差(Mean Squared Error,MSE)是最常用的回归损失函数之一。其计算公式为所有样本误差平方的平均值,它惩罚预测值和真实值之间较大差异的预测。

```python

import numpy as np

def mean_s

```

0

0