【Pandas绝密技巧】:5个你不知道的数据处理杀手锏

发布时间: 2024-09-29 19:16:57 阅读量: 66 订阅数: 31

# 1. Pandas入门与数据结构概述

在这个科技不断进步的时代,数据已成为推动社会前进的核心力量。Pandas作为一个强大的Python数据分析库,广泛应用于数据整理、清洗、探索和可视化等领域。在本章中,我们将首先带领读者快速入门Pandas库,并对其核心数据结构—Series和DataFrame进行细致的介绍。这将为后续章节中数据清洗、数据透视、时间序列处理等更高级的数据处理技巧打下坚实的基础。

## 1.1 Pandas简介

Pandas是一个开源的Python数据分析库,它提供了高性能、易用的数据结构和数据分析工具。Pandas的名称来源于"Panel Data",即面板数据,这种数据结构非常适合处理金融和经济中的时间序列数据。Pandas的两大核心数据结构为Series和DataFrame,它们可以存储一维和二维的数据结构,并提供了丰富的函数来进行数据操作和分析。

## 1.2 Series数据结构

Series是Pandas中用于存储一维数据的一种数据结构。在Series中,数据被保存为一个有序的键值对集合,其中键对应于索引(index),而值则是数据本身。Series类似于Python中的字典,但它支持整数索引,并且其长度是固定的。

```python

import pandas as pd

# 创建一个简单的Series示例

s = pd.Series([1, 2, 3, 4, 5], index=['a', 'b', 'c', 'd', 'e'])

print(s)

```

输出结果会显示索引和对应的数据值,这为快速访问和操作数据提供了便利。

## 1.3 DataFrame数据结构

DataFrame是Pandas库中最重要也是最强大的数据结构,它是一个二维的、大小可变的、潜在异质性的表格型数据结构。它具有行索引(row index)和列索引(column index),每列数据类型可以不同,但每一列的数据类型必须相同。DataFrame可以看作是由Series对象组成的字典,每个Series作为一列。

```python

data = {'Name': ['John', 'Anna', 'Peter', 'Linda'],

'Location': ['New York', 'Paris', 'London', 'Tokyo'],

'Age': [24, 13, 33, 44]}

df = pd.DataFrame(data)

print(df)

```

上述代码创建了一个包含三列的DataFrame,列名分别是"Name", "Location"和"Age"。DataFrame非常适合用来处理表格数据,是数据分析过程中最常用的结构之一。

通过学习本章,读者将能够对Pandas有一个全面的认识,并为以后的数据处理打下坚实的基础。

# 2. Pandas数据清洗技巧

数据清洗是数据分析和机器学习项目中不可或缺的一部分。在本章节中,我们将深入探讨Pandas库在数据清洗方面的高级技巧,并通过实际案例来演示这些技巧的应用。数据清洗不仅涉及去除无用数据,还涉及到数据格式化、错误纠正和一致性维护等多方面内容。

## 2.1 数据清洗基础

### 2.1.1 缺失值处理

在处理现实世界的数据时,我们常常会遇到缺失值(NaN或None)的情况。这些缺失值可能由多种原因造成,比如数据录入错误、传感器故障或信息未被记录。Pandas提供了多种处理缺失值的方法,以便于我们构建干净、准确的数据集。

处理缺失值的基本策略包括:

- 删除含有缺失值的记录

- 填充缺失值(填充特定值或者使用统计方法)

以下是一个简单的示例,展示如何使用Pandas进行缺失值处理:

```python

import pandas as pd

import numpy as np

# 创建一个示例DataFrame

df = pd.DataFrame({

'A': [1, 2, np.nan, 4],

'B': [5, np.nan, np.nan, 8],

'C': [9, 10, 11, 12]

})

# 删除含有缺失值的行

df_dropped = df.dropna()

# 填充缺失值为0

df_filled = df.fillna(0)

```

在执行逻辑分析时,我们注意到`dropna()`方法默认会删除包含任何NaN值的行。如果只想删除完全缺失的行(即所有列都是NaN),可以设置`how='all'`参数。此外,`fillna()`方法则提供了灵活的填充策略,可以指定单个值也可以使用`method`参数进行插值。

### 2.1.2 数据类型转换

数据类型转换是数据清洗过程中的另一个关键步骤。Pandas支持多种数据类型,包括整数、浮点数、字符串、布尔值和日期时间等。有时,数据类型会因为多种原因不正确,导致在数据分析中出现问题。

例如,日期时间格式的数据可能被错误地解析为字符串,或者数值数据可能因格式错误而无法进行数学计算。Pandas的`astype()`方法可以将数据转换为指定的类型,而`pd.to_datetime()`可以专门用于转换日期时间格式。

```python

# 将列'A'转换为浮点数类型

df['A'] = df['A'].astype(float)

# 将字符串列转换为日期时间格式

df['Date'] = pd.to_datetime(df['Date'], format='%Y-%m-%d')

```

逻辑分析表明,当使用`astype()`方法进行转换时,如果转换失败(比如,尝试将包含非数字字符的字符串转换为数值),Pandas将抛出错误。为了避免这种错误,应事先检查数据确保其适合转换。使用`to_datetime()`时,如日期时间格式字符串不正确,方法也会抛出错误,因此正确的日期格式字符串是必要的。

## 2.2 数据筛选和过滤

### 2.2.1 条件筛选

条件筛选是数据分析和清洗中常见的操作,Pandas通过其强大的索引系统支持复杂的条件筛选。我们可以使用`loc[]`、`iloc[]`或者`query()`方法来进行条件筛选。

以下是一个使用`loc[]`方法进行条件筛选的示例:

```python

# 筛选出列'A'大于2的行

filtered_df = df.loc[df['A'] > 2]

```

在这个逻辑分析中,`loc[]`允许我们根据行标签和列名进行筛选。此代码段中,`df['A'] > 2`是一个条件表达式,它返回一个布尔数组,`loc[]`根据这个布尔数组来选择满足条件的行。

### 2.2.2 多条件组合筛选

在实际应用中,我们通常需要根据多个条件进行筛选。Pandas提供了几种方法来实现多条件筛选,最常用的是`query()`方法和`loc[]`方法结合`&`和`|`运算符。

示例代码展示使用`query()`方法进行多条件筛选:

```python

# 使用query()方法筛选出'A'大于2且'B'小于8的行

filtered_query = df.query('A > 2 & B < 8')

```

逻辑分析显示,`query()`方法在语义上更加直观,使得多条件筛选的代码更加易读。需要注意的是,使用`query()`时,列名不应使用引号,而变量则需要。

## 2.3 数据去重和分组

### 2.3.1 去除重复数据

在收集数据时,重复记录是一个常见的问题。这些重复记录可能是由于数据录入错误或数据合并时未处理好导致的。Pandas提供了`duplicated()`和`drop_duplicates()`方法来识别和删除重复数据。

```python

# 识别DataFrame中的重复行

df_duplicates = df.duplicated()

# 删除重复行

df_unique = df.drop_duplicates()

```

执行逻辑分析时,`duplicated()`方法返回一个布尔序列,标记每行数据是否是重复的。默认情况下,`drop_duplicates()`保留第一次出现的记录,后续重复的记录会被删除。如果需要根据特定列来识别重复记录,可以传递列名列表给`subset`参数。

### 2.3.2 数据分组聚合操作

数据分组是数据分析中不可或缺的一部分,Pandas的`groupby()`方法允许我们根据一个或多个列来将数据分组。分组后,我们可以应用聚合函数,如`mean()`、`sum()`、`count()`等,来对每个组内的数据执行统计操作。

```python

# 按照列'A'的值分组,并计算每组的平均值

grouped_df = df.groupby('A').mean()

```

分析逻辑表明,使用`groupby()`方法后,我们得到的是一个分组对象,它允许我们对每个分组应用聚合函数。在这个示例中,聚合函数是`mean()`,它计算每个组内数值列的平均值。此外,还可以对多个列进行分组,并对每个组应用不同的聚合函数。

通过以上章节内容的深入探讨,我们已经了解了Pandas数据清洗的许多基本和高级技巧。通过实际代码的执行和逻辑分析,我们能够更好地理解Pandas在数据预处理过程中的重要角色。在下一章节中,我们将进一步探索Pandas在数据处理上的高级技巧,继续扩展我们对数据清洗的认识。

# 3. Pandas高级数据处理

### 3.1 数据透视和重塑

#### 3.1.1 数据透视表的创建

数据透视表是Pandas中一种强大的数据聚合工具,它可以根据一个或多个键对数据进行分组,并对分组后的数据执行某种形式的聚合操作。在数据分析中,数据透视表可以快速对数据进行汇总和转换,以获取所需的洞察。

```python

import pandas as pd

# 创建一个简单的DataFrame作为例子

df = pd.DataFrame({

'日期': pd.date_range('***', periods=10),

'产品': ['A', 'B', 'C', 'A', 'B', 'C', 'A', 'B', 'C', 'A'],

'销售额': [100, 120, 130, 105, 125, 135, 110, 130, 140, 115],

'成本': [80, 90, 95, 85, 95, 100, 88, 98, 102, 90]

})

# 使用pivot_table创建数据透视表

pivot_table = pd.pivot_table(df, values='销售额', index='日期', columns='产品', aggfunc='sum')

print(pivot_table)

```

在上述代码中,我们首先导入了`pandas`库,并创建了一个包含日期、产品、销售额和成本的`DataFrame`。然后,使用`pivot_table`函数创建了一个数据透视表,其中`values`参数指定了我们想要聚合的数据列,`index`参数定义了数据透视表的行索引,`columns`参数定义了数据透视表的列索引,而`aggfunc`参数定义了聚合函数。

#### 3.1.2 重塑数据集

数据重塑是Pandas处理数据的关键步骤之一。Pandas提供了几种工具来实现数据的重塑,例如`melt`、`pivot`和`stack/unstack`方法。它们允许用户根据需要将数据从宽格式转换为长格式,或者反之。

```python

# 将数据集从宽格式转换为长格式

long_df = pd.melt(df, id_vars='日期', value_vars=['销售额', '成本'], var_name='指标', value_name='数值')

print(long_df)

```

在上述代码中,我们使用`melt`函数将数据集从宽格式转换为长格式。`id_vars`参数定义了在转换过程中保持不变的列,`value_vars`参数指定了我们想要“融化”成行的列。`var_name`和`value_name`参数分别定义了新***ame中的列名。

### 3.2 时间序列数据处理

#### 3.2.1 时间序列的构建和索引

处理时间序列数据是Pandas的一个强项。Pandas提供了专门的时间序列工具,例如`Timestamp`、`Period`和`DatetimeIndex`,这些工具能够方便地进行时间相关的数据操作。

```python

# 创建一个时间序列索引

dates = pd.to_datetime(['2023-01-01', '2023-01-02', '2023-01-03'])

ts_index = pd.DatetimeIndex(dates)

# 使用时间序列索引创建时间序列DataFrame

ts_df = pd.DataFrame({'数值': [10, 15, 20]}, index=ts_index)

print(ts_df)

```

在这段代码中,我们首先使用`pd.to_datetime`将字符串日期转换为Pandas的`Timestamp`对象,然后创建了一个`DatetimeIndex`,最后利用该时间索引创建了一个`DataFrame`,其中包含一个数值列和对应的时间索引。

#### 3.2.2 时间序列的常用操作

Pandas还提供了许多用于时间序列分析的便捷方法,如时间重采样(`resample`)、时间差分(`diff`)、滚动窗口统计(`rolling`)等。

```python

# 计算每日销售总额的时间序列数据

ts_sales_sum = ts_df.resample('D').sum()

# 计算每日销售总额的变化

ts_sales_diff = ts_df.diff().fillna(0)

print(ts_sales_sum)

print(ts_sales_diff)

```

在上述示例中,我们首先使用`resample`方法对时间序列数据按照天进行重采样,并计算每天的销售总额。接着,我们使用`diff`方法计算销售总额的每日变化,使用`fillna`方法填充任何因时间差异导致的缺失值。

### 3.3 多级索引(MultiIndex)

#### 3.3.1 创建和使用多级索引

多级索引(也称为分层索引)允许我们同时在行和列上具有多个(两个以上)索引级别。这是处理具有不同层次结构的数据集的有效方式。

```python

# 创建一个多级索引DataFrame

index = pd.MultiIndex.from_tuples([('A', 'X'), ('A', 'Y'), ('B', 'X'), ('B', 'Y')])

multi_index_df = pd.DataFrame({'数值': [1, 2, 3, 4]}, index=index)

print(multi_index_df)

```

在上述代码中,我们首先使用`MultiIndex.from_tuples`方法创建了一个包含两级索引的`MultiIndex`对象。然后,我们使用该多级索引创建了一个`DataFrame`,其中包含一个数值列。

#### 3.3.2 多级索引的数据操作

有了多级索引后,我们可以使用`.loc`和`.iloc`方法来进行基于索引标签和位置的复杂选择和操作。

```python

# 选择多级索引中的特定数据

selected_data = multi_index_df.loc['A', 'X']

print(selected_data)

```

在这段代码中,我们使用`.loc`方法通过多级索引的标签来选择数据。`loc`方法非常适合用于访问多级索引的数据,因为它允许我们指定索引的每一层。

以上是第三章关于Pandas高级数据处理的内容,详细介绍了数据透视和重塑、时间序列数据处理以及多级索引的创建和使用。这些高级功能是进行复杂数据分析的必要工具,能够帮助数据科学家和分析师高效地组织和分析数据集。接下来的章节将继续深入探讨Pandas在数据可视化和实际项目应用中的高级应用。

# 4. Pandas与数据可视化

## 4.1 绘图基础

在数据分析的流程中,数据可视化是沟通信息的关键环节。Pandas拥有紧密集成的可视化工具,能够快速将数据转换成直观的图表,便于分析和传达。Pandas的绘图功能基于matplotlib,但更加简化和便捷。

### 4.1.1 线性图与柱状图的绘制

线性图和柱状图是数据可视化中最基础也是最常用的两种图表。Pandas的`plot`方法提供了快速绘制这些图表的能力。

以一组股票价格数据为例,以下是如何使用Pandas绘制线性图和柱状图:

```python

import pandas as pd

# 假设df是一个包含日期和股票价格的DataFrame

df = pd.DataFrame({

'Date': pd.date_range(start='2021-01-01', periods=100, freq='D'),

'Stock_Price': pd.Series(np.random.randn(100).cumsum())

})

# 绘制线性图

df.set_index('Date')['Stock_Price'].plot()

plt.title('Stock Price over Time')

plt.xlabel('Date')

plt.ylabel('Price')

plt.show()

# 绘制柱状图

df.set_index('Date')['Stock_Price'].plot(kind='bar')

plt.title('Daily Stock Price')

plt.xlabel('Date')

plt.ylabel('Price')

plt.show()

```

### 4.1.2 饼图与散点图的实现

当需要展示数据的构成比例时,饼图是一个很好的选择。而散点图则在探索两个变量之间的关系时非常有用。

使用Pandas绘制饼图和散点图的代码示例如下:

```python

# 绘制饼图

df['Stock_Price'].value_counts().head(5).plot(kind='pie', autopct='%1.1f%%')

plt.title('Top 5 Stock Price Distribution')

plt.ylabel('') # 隐藏Y轴标签

plt.show()

# 绘制散点图

df.plot(kind='scatter', x='Stock_Price', y='Date')

plt.title('Stock Price Scatter Plot')

plt.xlabel('Stock Price')

plt.ylabel('Date')

plt.show()

```

## 4.2 高级绘图技巧

随着数据分析需求的复杂化,Pandas提供了更多高级绘图功能来满足特定场景的需求,这包括自定义图表样式、颜色以及生成更复杂的统计图表。

### 4.2.1 配置图表样式与颜色

Pandas的绘图接口允许用户通过参数调整图表的样式和颜色,以符合个人喜好或满足报告的标准。

```python

import matplotlib.pyplot as plt

import seaborn as sns

# 设置图表样式

sns.set()

# 绘制柱状图并自定义颜色

df['Stock_Price'].plot(kind='bar', color='skyblue')

plt.title('Daily Stock Price')

plt.xlabel('Date')

plt.ylabel('Price')

plt.show()

```

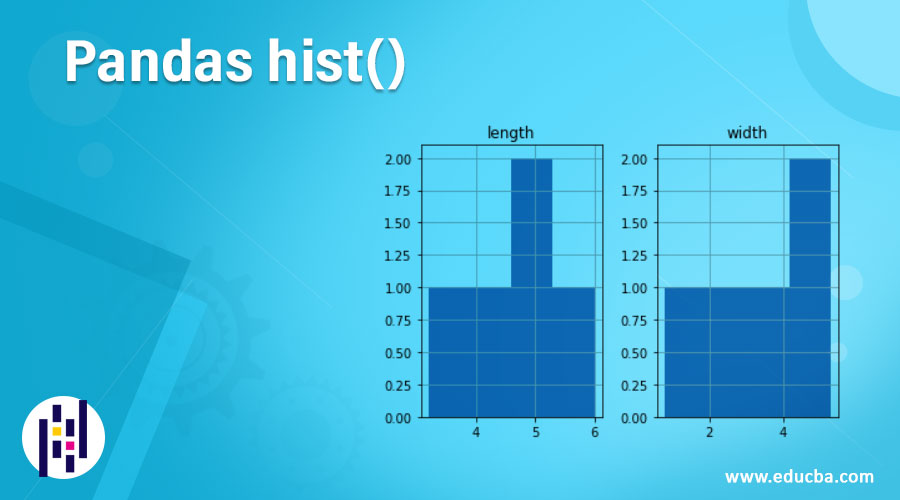

### 4.2.2 直方图与箱形图的深入应用

直方图和箱形图是探索数据分布的重要工具。Pandas通过简单的接口即可生成这些图表。

```python

# 绘制直方图

df['Stock_Price'].plot(kind='hist', bins=10)

plt.title('Stock Price Distribution')

plt.xlabel('Price')

plt.ylabel('Frequency')

plt.show()

# 绘制箱形图

df['Stock_Price'].plot(kind='box')

plt.title('Stock Price Box Plot')

plt.ylabel('Price')

plt.show()

```

## 4.3 交互式数据可视化

现代数据科学环境中,静态图表已不足以满足所有需求。Pandas可以与更先进的库如Plotly和Bokeh结合,生成交互式图表。

### 4.3.1 使用Plotly进行动态图表

Plotly库支持创建交互式图表,这些图表可以在Web浏览器中直接操作。

```python

import plotly.express as px

# 使用Plotly绘制散点图

fig = px.scatter(df, x='Date', y='Stock_Price', title='Stock Price Interactive Scatter Plot')

fig.show()

```

### 4.3.2 Bokeh与Pandas的整合

Bokeh库同样提供了丰富的交互式可视化功能。整合Bokeh与Pandas可以制作出复杂、动态的数据图表。

```python

from bokeh.plotting import figure, show, output_file

from bokeh.models import ColumnDataSource

# 准备数据

source = ColumnDataSource(df)

# 创建图表

p = figure(x_axis_type='datetime', title='Stock Price Bokeh Chart')

p.line('Date', 'Stock_Price', source=source)

# 显示图表

show(p)

```

通过以上内容,我们可以看出Pandas在数据可视化方面的巨大潜力。无论是在创建基础图表还是与交互式图表库的整合方面,Pandas都提供了丰富的工具和接口来满足各种数据可视化需求。

# 5. Pandas在实际项目中的应用

随着数据科学的日益发展,Pandas 作为一个强大的数据处理和分析库,在实际项目中的应用变得至关重要。无论是大数据预处理,还是为机器学习准备数据集,Pandas 都提供了丰富的工具和方法,以简化数据处理流程。

## 5.1 大数据预处理

处理大规模数据集是数据分析领域的一项重要任务。Pandas 虽然在处理非常大的数据集时可能会遇到性能瓶颈,但通过一些策略和优化手段,我们依然可以利用它来处理 TB 级的数据。

### 5.1.1 处理大规模数据集的策略

在处理大规模数据集时,一些常见的策略包括:

- **分块处理(Chunking)**: 将数据分块加载,逐块进行处理,最后再整合结果。

- **数据类型优化**: 将数据列的数据类型调整为最合适的数据类型以节省内存。

- **内存映射文件**: 使用 `pd.read_csv` 和 `pd.HDFStore` 可以将数据保存为硬盘存储格式,以减少内存占用。

### 5.1.2 分块处理与优化

分块处理是大数据预处理中常用的方法之一。通过合理地设置块的大小,可以平衡内存的使用和性能表现。

```python

import pandas as pd

# 定义分块的大小

chunksize = 10000

# 读取数据集并分块处理

for chunk in pd.read_csv('large_dataset.csv', chunksize=chunksize):

# 在这里处理每个数据块

# 例如:筛选、清洗和转换数据

processed_chunk = chunk.dropna() # 示例:去除缺失值

# 可以保存每个块的处理结果,减少内存使用

processed_chunk.to_csv(f'processed_chunk_{chunknumber}.csv', index=False)

chunknumber += 1

```

## 5.2 机器学习数据准备

在机器学习领域,Pandas 通常用于特征工程、数据集的拆分和重采样等预处理步骤。

### 5.2.1 特征工程的基础应用

特征工程是机器学习中的一个关键步骤,它涉及创建新特征或修改现有特征来提高模型性能。

```python

import pandas as pd

# 加载数据集

df = pd.read_csv('machine_learning_data.csv')

# 特征工程

# 示例:创建新特征

df['age_squared'] = df['age'] ** 2

# 示例:特征筛选

features_to_use = ['age', 'age_squared', 'income']

X = df[features_to_use]

# 示例:标签编码

y = df['target'].astype('category').cat.codes

```

### 5.2.2 数据集的拆分与重采样

在准备数据时,通常需要将数据集拆分为训练集和测试集,并且在不平衡数据集中可能需要进行重采样。

```python

from sklearn.model_selection import train_test_split

from imblearn.over_sampling import SMOTE

# 拆分数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 重采样

smote = SMOTE(random_state=42)

X_train_resampled, y_train_resampled = smote.fit_resample(X_train, y_train)

```

## 5.3 综合案例分析

接下来,我们将通过一个简化的综合案例分析,进一步理解如何利用Pandas来解决实际问题。

### 5.3.1 数据处理项目概述

假设我们有一个销售数据集,需要进行如下处理:

- 清洗数据,包括填充缺失值和转换数据类型。

- 分析和转换日期时间格式,提取有用信息。

- 特征工程,包括构造新特征和编码分类数据。

### 5.3.2 从问题定义到数据解决方案

```python

# 加载数据集

df = pd.read_csv('sales_data.csv')

# 数据清洗

df['date'] = pd.to_datetime(df['date'], format='%Y-%m-%d') # 转换日期格式

df['product_category'] = df['product_category'].astype('category') # 转换为分类数据类型

# 特征工程

df['month'] = df['date'].dt.month # 提取月份作为新特征

df['year'] = df['date'].dt.year # 提取年份作为新特征

# 输出处理后的数据集的头部

print(df.head(10))

```

在上述步骤中,我们首先加载了数据集,并执行了数据清洗。随后,我们进行了日期格式转换,并构造了新的时间特征。最后,我们输出了处理后的数据集的头部,展示了数据处理的结果。

在处理实际项目时,以上所述的操作步骤和方法将作为数据预处理的基础。通过对数据进行适当的预处理,我们可以确保机器学习模型能够从数据中获取更多的有价值信息,提高模型的准确性和性能。

0

0