Pandas数据分类与编码:从入门到高级应用全方位解析

发布时间: 2024-11-22 06:10:50 阅读量: 41 订阅数: 30

Python数据分析入门:Pandas库详细教程与应用

# 1. Pandas数据分类与编码简介

数据分类与编码是数据预处理过程中的重要步骤,它们影响着后续数据分析和机器学习模型的性能。在使用Pandas进行数据处理时,正确地理解数据分类与编码的机制,可以帮助我们更好地准备数据,为分析工作打下坚实的基础。

## 1.1 数据分类与编码的重要性

数据分类是将数据的特征划分为不同类别或标签的过程,其目的是为了更有效地进行数据的分析、组织和存储。在机器学习中,分类问题广泛存在,如文本分类、图像分类等。数据编码则是将分类数据转换成机器可理解的数值形式的过程。在Pandas中,这通常涉及到标签编码(Label Encoding)、独热编码(One-Hot Encoding)等方法。

## 1.2 Pandas在数据分类与编码中的应用

Pandas为数据科学家提供了丰富的数据处理工具,其中就包括数据分类与编码的功能。利用Pandas中的`LabelEncoder`和`OneHotEncoder`等工具,我们可以方便地对数据进行转换。Pandas还提供了灵活的数据处理接口,例如`pd.get_dummies()`,能够一键实现独热编码,极大地简化了数据处理流程。

```python

from sklearn.preprocessing import LabelEncoder, OneHotEncoder

# 示例:使用LabelEncoder进行标签编码

le = LabelEncoder()

encoded_labels = le.fit_transform(['cat', 'dog', 'dog', 'cat'])

# 示例:使用OneHotEncoder进行独热编码

ohe = OneHotEncoder(sparse=False)

encoded_ohe = ohe.fit_transform([[1, 0, 3], [0, 1, 0], [1, 0, 3]])

print(encoded_labels) # 输出: array([1, 2, 2, 1])

print(encoded_ohe) # 输出: [[1. 0. 0. 0. 0. 1.], [0. 1. 0. 1. 0. 0.], [1. 0. 0. 0. 0. 1.]]

```

## 1.3 应用场景与实践

在实际工作中,数据分类与编码的应用场景广泛,不仅限于数据预处理,还可能涉及到数据仓库、数据报表生成以及进一步的数据分析等。例如,在构建推荐系统时,对用户的行为进行分类并编码,可以帮助我们更好地理解用户偏好,进而为用户推荐合适的内容。

```python

# 示例:构建推荐系统中的简单场景

# 假设有一个用户与商品交互的数据集,我们需要对其进行分类编码以便分析

# 用户行为数据

user_behaviors = [

{"user_id": 1, "product_id": 101, "action": "click"},

{"user_id": 1, "product_id": 102, "action": "purchase"},

{"user_id": 2, "product_id": 101, "action": "add_to_cart"},

# ... 更多行为数据

]

# 将行为动作转换为数值标签

behavior_labels = LabelEncoder()

user_behaviors_encoded = [

{"user_id": user['user_id'], "product_id": user['product_id'], "action_encoded": behavior_labels.fit_transform([user['action']])[0]}

for user in user_behaviors

]

print(user_behaviors_encoded)

```

通过上述示例,我们不仅看到了Pandas在数据分类与编码中的应用,还应该意识到合理的数据分类和编码能够为后续的数据分析工作带来便利。在下一章中,我们将深入学习Pandas的基础操作和数据类型,为深入理解数据分类与编码打下更坚实的基础。

# 2. Pandas基础操作与数据类型

## 2.1 Pandas的数据结构

### 2.1.1 Series对象的基本操作

Pandas的Series对象是基础的数据结构之一,可以看作是一维数组,具有索引和数据两个部分。理解Series的基本操作是深入Pandas世界的第一步。

#### 创建Series对象

首先,我们可以从NumPy数组、Python列表或者Python字典创建Series对象。下面的代码展示了如何创建一个简单的Series对象:

```python

import pandas as pd

import numpy as np

# 从列表创建Series

series_from_list = pd.Series(['a', 'b', 'c', 'd'])

# 从NumPy数组创建Series

series_from_array = pd.Series(np.array([1, 2, 3, 4]))

# 从字典创建Series

series_from_dict = pd.Series({'A': 100, 'B': 200, 'C': 300})

```

#### 访问Series中的数据

Series对象支持通过索引的方式访问数据,索引包括位置索引和标签索引。位置索引基于数据的位置,而标签索引基于创建Series时指定的索引。

```python

# 通过位置索引访问

print(series_from_list[0]) # 输出 'a'

# 通过标签索引访问

print(series_from_dict['A']) # 输出 100

```

#### 基本的Series操作

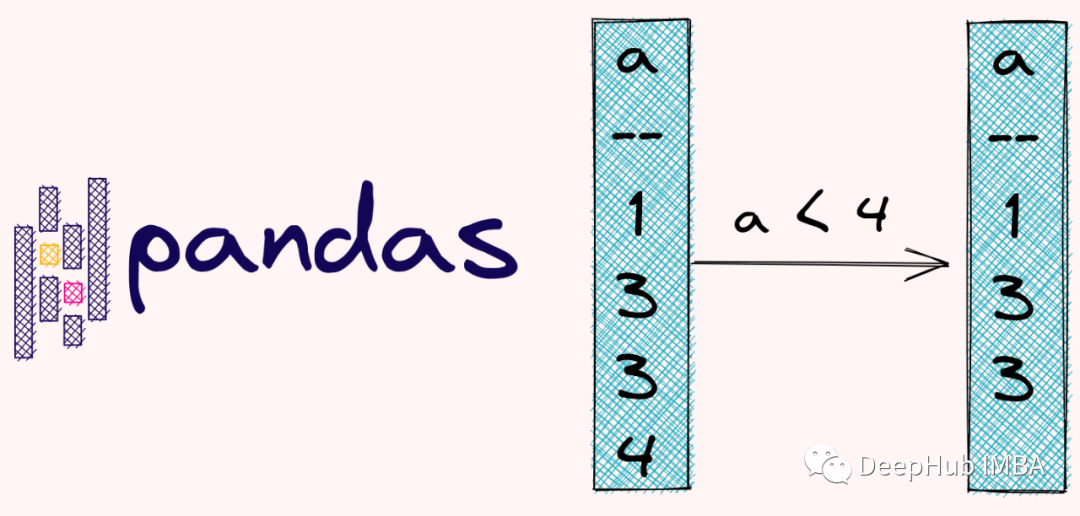

Pandas提供了大量对Series进行操作的方法,例如算术运算、数据过滤、排序等。

```python

# 算术运算示例

print(series_from_list + series_from_array) # 对应位置元素相加

# 数据过滤示例

print(series_from_list[series_from_list > 'b']) # 筛选出大于 'b' 的元素

# 排序示例

print(series_from_dict.sort_values()) # 对Series的值进行排序

```

### 2.1.2 DataFrame对象的结构与使用

DataFrame对象是Pandas中功能最为强大的数据结构,其可以被看作是一个表格,具有行和列的概念。DataFrame的每一列都是一个Series对象。

#### 创建DataFrame对象

与Series类似,DataFrame可以从多种类型的数据创建,包括字典、Series列表、NumPy数组等。

```python

# 从字典列表创建DataFrame

data = {'A': [1, 2, 3], 'B': [4, 5, 6]}

df_from_dict = pd.DataFrame(data)

# 从Series列表创建DataFrame

series_list = [pd.Series([1, 4]), pd.Series([2, 5]), pd.Series([3, 6])]

df_from_series = pd.DataFrame(series_list)

```

#### 访问DataFrame中的数据

DataFrame中的数据可以通过列名或列的位置索引来访问。使用列名时,可以通过点符号或通过方括号来访问。

```python

# 通过列名访问

print(df_from_dict['A']) # 输出 Series 对象

# 通过位置索引访问

print(df_from_dict.iloc[:, 0]) # 输出第0列的所有数据

```

#### DataFrame的基本操作

DataFrame提供了大量的方法来对数据进行操作,包括数据选择、排序、分组、数据合并等。

```python

# 选择操作示例

print(df_from_dict.loc[:, 'A']) # 通过行和列标签选择数据

# 排序示例

print(df_from_dict.sort_values(by='A')) # 按照'A'列的数据排序

# 分组示例

print(df_from_dict.groupby('A').sum()) # 按'A'列进行分组并求和

# 数据合并示例

print(pd.concat([df_from_dict, df_from_series], axis=1)) # 按列合并

```

## 2.2 Pandas数据类型详解

### 2.2.1 数据类型转换与处理

Pandas允许用户对数据进行转换,可以将数据从一种类型转换到另一种类型。这是因为数据类型决定了数据的存储方式和可进行的操作。

#### 类型转换的基本方法

Pandas提供了`astype()`方法用于数据类型转换。可以将数据类型转换为数值型、字符串类型等。

```python

# 将数值型数据转换为字符串类型

df_from_dict['A'] = df_from_dict['A'].astype(str)

```

#### 类型转换的高级功能

Pandas还支持更复杂的类型转换,如使用`pd.to_datetime()`方法将时间字符串转换为日期时间对象,或使用`pd.to_numeric()`方法转换文本为数值类型。

```python

# 将字符串转换为日期时间类型

df_from_dict['date'] = pd.to_datetime(df_from_dict['date'], format='%Y-%m-%d')

# 将文本转换为数值类型

df_from_dict['B'] = pd.to_numeric(df_from_dict['B'], errors='coerce')

```

### 2.2.2 数据缺失值的处理策略

数据缺失是数据分析过程中经常遇到的问题,Pandas提供了多种方法来处理缺失值。

#### 理解缺失值

在Pandas中,缺失值通常用`NaN`表示。`isnull()`和`notnull()`方法可以用来检测数据中的缺失值。

```python

# 检测缺失值

print(df_from_dict.isnull())

```

#### 处理缺失值

处理缺失值的常用方法包括删除含有缺失值的行或列,使用众数、均值、中位数等填充缺失值。

```python

# 删除含有缺失值的行

df_from_dict.dropna(inplace=True)

# 使用列的均值填充缺失值

df_from_dict.fillna(df_from_dict.mean(), inplace=True)

```

## 2.3 Pandas数据读写与预览

### 2.3.1 数据读取:CSV、Excel及数据库

Pandas能够读取多种格式的数据,如CSV、Excel、JSON、HTML、SQL数据库等。这些功能让数据分析师能从各种来源获取数据。

#### 从CSV读取数据

`read_csv()`函数是Pandas中用于读取CSV文件的方法。它支持多种参数来定制读取过程。

```python

# 从CSV文件读取数据

df_csv = pd.read_csv('data.csv')

```

#### 从Excel读取数据

`read_excel()`函数用于读取Excel文件。Pandas支持读取.xlsx和.xls格式的文件,并可以指定读取的sheet和行列范围。

```python

# 从Excel文件读取数据

df_excel = pd.read_excel('data.xlsx', sheet_name='Sheet1')

```

### 2.3.2 数据写入:导出到不同格式

将DataFrame写入到不同的文件格式也是Pandas的基本功能。它不仅能够保存为本地文件,还可以导出到数据库或者云端服务。

#### 将DataFrame写入CSV

使用`to_csv()`方法可以将DataFrame数据导出为CSV文件。该方法可以设置分隔符、编码方式等参数。

```python

# 将DataFrame导出到CSV文件

df_from_dict.to_csv('output.csv', index=False)

```

#### 将DataFrame写入Excel

与读取类似,`to_excel()`方法将DataFrame数据导出为Excel文件。该方法同样支持设置多个参数来满足不同需求。

```python

# 将DataFrame导出到Excel文件

df_from_dict.to_excel('output.xlsx', sheet_name='New Sheet')

```

Pandas的这些基础操作为数据处理和分析提供了强大的支持,无论是数据的读取、转换、导出还是缺失值的处理,都是数据分析人员需要熟练掌握的技能。在后续章节中,我们将进一步探讨数据分类技术和编码方法,以及如何将这些技术应用在机器学习和数据预处理中。

# 3. 数据分类技术基础

## 3.1 数据分类的理论基础

### 3.1.1 分类问题定义

数据分类是机器学习中的一种监督学习技术,目的在于将数据集中的样本分配到已知类别中的某一个。它通常被用于有明确类别标签的数据集,通过训练一个模型来识别数据集中的模式,并基于这些模式预测新样本的类别。

在定义分类问题时,我们首先需要明确两个基本概念:

- **特征(Features)**:数据集中用于区分不同样本的属性或变量。

- **标签(Labels

0

0