深度学习中的Dropout技术:过拟合的救星?

发布时间: 2024-11-23 09:30:44 阅读量: 22 订阅数: 30

# 1. 深度学习中的过拟合问题

过拟合是深度学习领域一个常见而又棘手的问题。在这一章节中,我们将首先探讨过拟合的定义,识别方法以及其对深度学习模型性能可能产生的负面影响。简单来说,过拟合发生时,模型在训练数据上表现得过于“完美”,以至于它开始记忆训练数据的特定特征,而不是学习如何推广到未见过的数据上。这种现象在处理高度复杂的模型和有限的训练样本时尤其常见。

## 过拟合现象及其影响

### 过拟合的定义与识别

过拟合是指模型在训练数据上预测能力很强,但是在新的、未见过的数据上表现不佳的情况。它通常发生在模型过于复杂或者训练数据不够丰富时。从技术上讲,过拟合意味着模型在训练集上的误差极低,但是在验证集或测试集上的误差显著增加。识别过拟合的一个简单方法是观察训练和验证误差随时间的变化曲线。如果验证误差开始随训练误差的降低而上升,这可能意味着模型开始过拟合。

### 过拟合对模型性能的危害

模型过拟合会严重影响其在实际应用中的性能,特别是在面对新数据时。过拟合导致模型在训练数据上可能达到了非常高的准确率,但是由于模型过度学习了训练数据的噪声而非其潜在模式,因此在新的数据集上泛化能力差。这限制了模型在现实世界问题中的可用性,如图像识别、自然语言处理等任务中的应用效果大大降低。

在下一章节中,我们将深入了解Dropout技术,这是一种有效的正则化手段,用于缓解过拟合问题,提高模型的泛化能力。

# 2. 理解Dropout技术的基本原理

### 2.1 过拟合现象及其影响

#### 2.1.1 过拟合的定义与识别

过拟合(Overfitting)是指模型在训练数据上表现得过于优秀,以至于它开始捕捉到数据中的噪声和异常值,而不是数据的潜在分布。这导致模型在训练集上的准确率非常高,但在未见过的验证集或测试集上表现显著下降。在深度学习中,过拟合通常表现在训练损失持续下降,而验证损失不再下降甚至开始上升。

过拟合的识别可以通过以下方法:

- **观察训练与验证的损失曲线**:如果验证损失开始上升而训练损失继续下降,可能出现了过拟合。

- **使用正则化技术后的效果改善**:在模型中引入Dropout等正则化技术后,如果模型性能有显著提升,可能是之前存在过拟合。

- **模型复杂度与数据量的比较**:当模型的复杂度远远超出数据量时,过拟合的风险会大大增加。

#### 2.1.2 过拟合对模型性能的危害

过拟合严重损害了模型的泛化能力,即模型在新的数据上的表现能力。这会导致以下几点危害:

- **在实际应用中的准确率降低**:过拟合模型在真实世界的数据上表现不佳,无法达到预期的应用效果。

- **模型的稳定性差**:过拟合模型对输入数据的微小变化非常敏感,容易产生大的输出误差。

- **计算资源浪费**:由于过拟合的模型实际上学习了噪声而非真正信号,因此之前的训练过程实际上是资源的浪费。

### 2.2 Dropout技术的核心思想

#### 2.2.1 Dropout的起源与发展

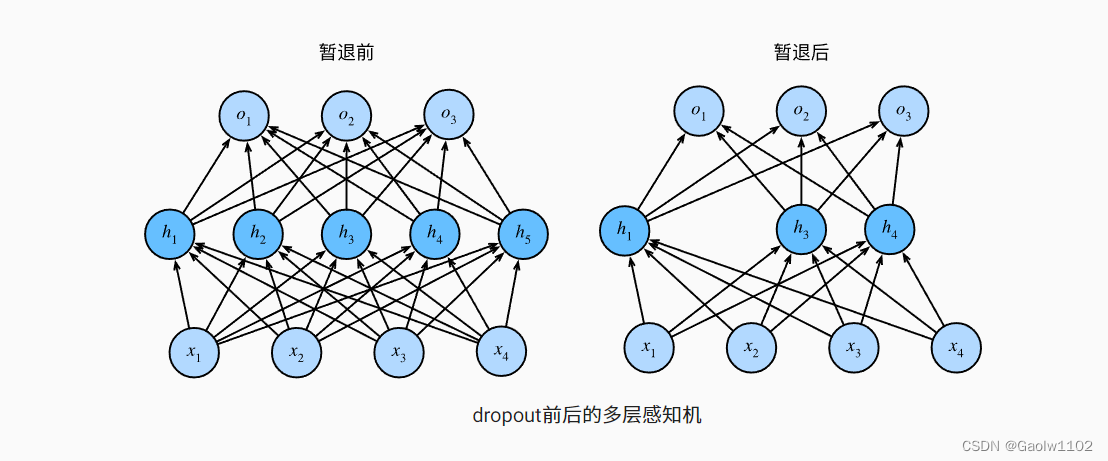

Dropout技术由Hinton等人在2012年提出,并广泛应用于神经网络的训练中,以减少过拟合现象。Dropout是一种正则化技术,通过在训练过程中随机“丢弃”(即临时移除)一部分神经元,强制模型在不依赖于任何一个神经元的情况下进行学习。这种方法使得网络在学习中变得更加鲁棒,提高模型在未知数据上的表现能力。

自从提出后,Dropout技术经历了多次改进和发展:

- **标准Dropout**:最基本的Dropout方法,随机关闭神经元的激活。

- **Inverted Dropout**:在训练中使用,通过调整保持激活的神经元的输出值,以保证训练和测试的期望输出一致。

- **DropConnect**:与标准Dropout类似,但随机关闭的是神经元之间的连接而不是神经元本身。

#### 2.2.2 Dropout的工作机制概述

Dropout在训练时的工作机制可以概括为以下步骤:

1. **随机性移除神经元**:在每个训练批次中,以一定的概率随机关闭部分神经元,关闭神经元的输出设置为0。

2. **缩放剩余神经元的输出**:为了保持输出层的激活值的总和不变,未被关闭的神经元的输出需要乘以概率值的倒数(例如,如果Dropout概率是0.5,则未被关闭的神经元的输出乘以2)。

3. **反向传播与权重更新**:关闭神经元的随机性和在反向传播过程中的不参与,导致模型参数学习到更加鲁棒的特征表示。

### 2.3 Dropout与其他正则化方法的比较

#### 2.3.1 Dropout与L1/L2正则化

L1和L2正则化是另一种常见的减少过拟合的技术,它们通过在损失函数中添加与权重相关的惩罚项来控制模型复杂度。L1正则化倾向于生成稀疏的权重矩阵,有助于特征选择;而L2正则化则倾向于使权重值接近于零但不完全为零。

Dropout与L1/L2正则化的不同点在于:

- **随机性**:Dropout在训练过程中引入了随机性,强制网络在部分信息缺失的情况下进行学习,而L1/L2正则化是通过权重的约束来影响网络学习。

- **网络内部协作性**:Dropout通过随机关闭神经元,迫使剩余的神经元学会相互协作;而L1/L2正则化则直接作用于权重上,不直接促进内部神经元的协作。

#### 2.3.2 Dropout与数据增强

数据增强是通过对训练数据进行各种变换(如旋转、翻转、缩放等)来增加数据多样性,以此来减少过拟合。数据增强与Dropout有相似的动机,都是增加模型的泛化能力。

两者的主要区别在于:

- **数据层面与模型层面**:数据增强在数据输入层面上增加变化,而Dropout在模型结构层面上进行操作。

- **计算资源需求**:数据增强可能会增加数据预处理的计算负担,而Dropout只需要在训练过程中进行简单的随机操作。

通过上述的分析,我们可以看到,Dropout技术的引入对提高模型泛化能力、解决过拟合问题提供了新的思路和方法。在接下来的章节中,我们将进一步探讨Dropout技术在实践操作中的应用以及它在现代深度学习中的新发展。

# 3. ```markdown

# 第三章:Dropout技术的实践操作

## 3.1 Dropout在不同深度学习框架中的实现

### 3.1.1 TensorFlow中的Dropout实现

在TensorFlow框架中,Dropout是一种广泛使用的技术,用于防止神经网络在训练数据上过拟合。在TensorFlow 2.x版本中,实现Dropout非常简单。以下是一个简单的示例代码,演示如何在TensorFlow的`Sequential`模型中添加Dropout层。

```python

import tensorflow as tf

from tensorflow.keras.layers import Dropout, Dense

from tensorflow.keras.models import Sequential

# 构建一个简单的全连接神经网络模型

model = Sequential([

Dense(512, activation='relu', input_shape=(input_size,)),

Dropout(0.5), # 在此层中应用Dropout

Dense(256, activation='relu'),

Dense(num_classes, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])

# 使用模型进行训练

model.fit(x_train, y_train, epochs=10)

```

在上述代码中,`Dropout(0.5)`表示在训练过程中,每个ep

```

0

0