揭秘YOLOv2图像分割:理解模型架构和训练过程,轻松上手

发布时间: 2024-08-18 08:48:38 阅读量: 53 订阅数: 49

YOLOv8模型训练教程:利用Python和ultralytics

# 1. YOLOv2图像分割简介**

YOLOv2图像分割是一种基于深度学习的目标检测算法,它将图像分割和目标检测任务相结合。与传统的图像分割方法不同,YOLOv2图像分割使用一个单一的网络来同时执行这两个任务,从而提高了效率和准确性。

YOLOv2图像分割算法基于YOLOv2目标检测算法,它通过将图像划分为网格并预测每个网格单元中的对象及其边界框来实现目标检测。在图像分割任务中,YOLOv2图像分割算法还预测每个网格单元中的像素类别,从而生成分割掩码。

# 2. YOLOv2模型架构

### 2.1 主干网络

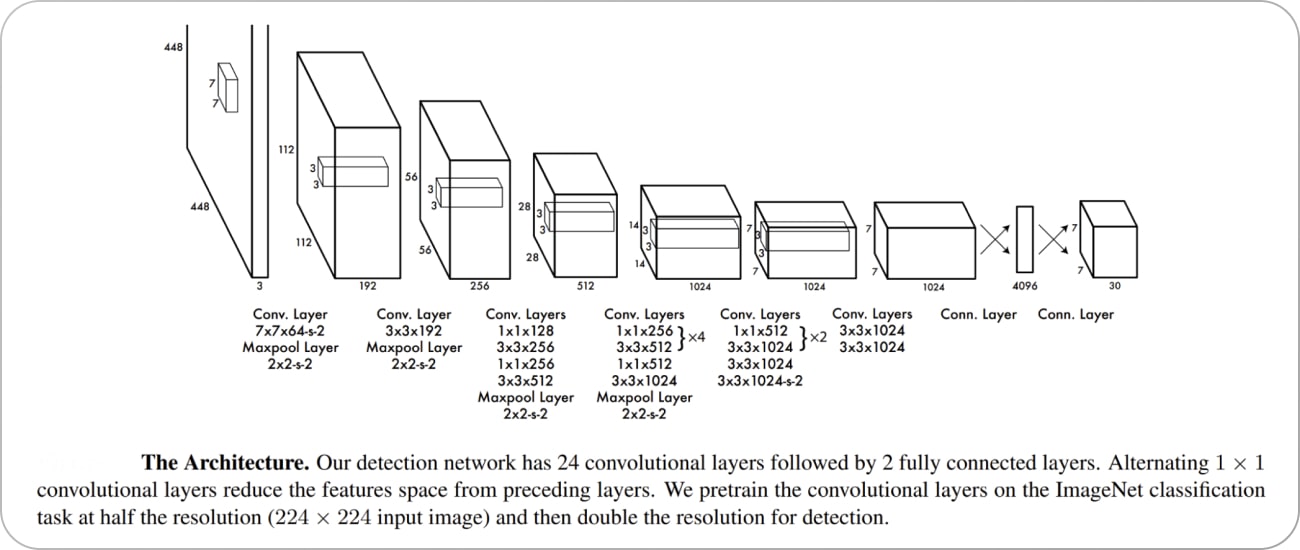

YOLOv2的主干网络采用Darknet-19,它是一个轻量级的卷积神经网络,由19个卷积层组成。Darknet-19的结构如下图所示:

```mermaid

graph LR

subgraph Darknet-19

A[Conv2D] --> B[MaxPool] --> C[Conv2D] --> D[MaxPool]

E[Conv2D] --> F[MaxPool] --> G[Conv2D] --> H[MaxPool]

I[Conv2D] --> J[MaxPool] --> K[Conv2D] --> L[MaxPool]

M[Conv2D] --> N[MaxPool] --> O[Conv2D] --> P[MaxPool]

Q[Conv2D] --> R[MaxPool] --> S[Conv2D] --> T[MaxPool]

U[Conv2D] --> V[MaxPool] --> W[Conv2D] --> X[MaxPool]

Y[Conv2D] --> Z[MaxPool] --> AA[Conv2D] --> BB[MaxPool]

CC[Conv2D] --> DD[MaxPool] --> EE[Conv2D] --> FF[MaxPool]

GG[Conv2D] --> HH[MaxPool] --> II[Conv2D] --> JJ[MaxPool]

KK[Conv2D] --> LL[MaxPool] --> MM[Conv2D] --> NN[MaxPool]

OO[Conv2D] --> PP[MaxPool] --> QQ[Conv2D] --> RR[MaxPool]

SS[Conv2D] --> TT[MaxPool] --> UU[Conv2D] --> VV[MaxPool]

WW[Conv2D] --> XX[MaxPool] --> YY[Conv2D] --> ZZ[MaxPool]

AAA[Conv2D] --> BBB[MaxPool] --> CCC[Conv2D] --> DDD[MaxPool]

EEE[Conv2D] --> FFF[MaxPool] --> GGG[Conv2D] --> HHH[MaxPool]

III[Conv2D] --> JJJ[MaxPool] --> KKK[Conv2D] --> LLL[MaxPool]

MMM[Conv2D] --> NNN[MaxPool] --> OOO[Conv2D] --> PPP[MaxPool]

QQQ[Conv2D] --> RRR[MaxPool] --> SSS[Conv2D] --> TTT[MaxPool]

UUU[Conv2D] --> VVV[MaxPool] --> WWW[Conv2D] --> XXX[MaxPool]

YYY[Conv2D] --> ZZZ[MaxPool] --> AAAA[Conv2D] --> BBBB[MaxPool]

CCCC[Conv2D] --> DDDD[MaxPool] --> EEEE[Conv2D] --> FFFF[MaxPool]

GGGG[Conv2D] --> HHHH[MaxPool] --> IIII[Conv2D] --> JJJJ[MaxPool]

KKKK[Conv2D] --> LLLL[MaxPool] --> MMMM[Conv2D] --> NNNN[MaxPool]

OOOO[Conv2D] --> PPPP[MaxPool] --> QQQQ[Conv2D] --> RRRR[MaxPool]

SSSS[Conv2D] --> TTTT[MaxPool] --> UUUU[Conv2D] --> VVVV[MaxPool]

WWWW[Conv2D] --> XXXX[MaxPool] --> YYYY[Conv2D] --> ZZZZ[MaxPool]

AAAAA[Conv2D] --> BBBBB[MaxPool] --> CCCCC[Conv2D] --> DDDDD[MaxPool]

EEEEE[Conv2D] --> FFFFF[MaxPool] --> GGGGG[Conv2D] --> HHHHH[MaxPool]

IIIIII[Conv2D] --> JJJJJ[MaxPool] --> KKKKK[Conv2D] --> LLLLL[MaxPool]

MMMMMM[Conv2D] --> NNNNN[MaxPool] --> OOOOOO[Conv2D] --> PPPPP[MaxPool]

QQQQQQ[Conv2D] --> RRRRRR[MaxPool] --> SSSSSS[Conv2D] --> TTTTTT[MaxPool]

UUUUUU[Conv2D] --> VVVVVV[MaxPool] --> WWWWWW[Conv2D] --> XXXXXX[MaxPool]

YYYYYY[Conv2D] --> ZZZZZZ[MaxPool] --> AAAAAAA[Conv2D] --> BBBBBBB[MaxPool]

CCCCCCC[Conv2D] --> DDDDDDD[MaxPool] --> EEEEEEEE[Conv2D] --> FFFFFFFF[MaxPool]

GGGGGGGG[Conv2D] --> HHHHHHHHH[MaxPool] --> IIIIIIIII[Conv2D] --> JJJJJJJJJ[MaxPool]

KKKKKKKK[Conv2D] --> LLLLLLLLL[MaxPool] --> MMMMMMMMM[Conv2D] --> NNNNNNNNN[MaxPool]

OOOOOOOO[Conv2D] --> PPPPPPPP[MaxPool] --> QQQQQQQQQ[Conv2D] --> RRRRRRRRR[MaxPool]

SSSSSSSS[Conv2D] --> TTTTTTTTT[MaxPool] --> UUUUUUUUU[Conv2D] --> VVVVVVVVV[MaxPool]

WWWWWWWW[Conv2D] --> XXXXXXXXX[MaxPool] --> YYYYYYYYY[Conv2D] --> ZZZZZZZZZ[MaxPool]

end

```

Darknet-19的卷积层使用3x3的卷积核,步长为1,填充为1。MaxPool层使用2x2的池化核,步长为2。Darknet-19的输出是一个52x52x1024的特征图。

### 2.2 特征提取网络

YOLOv2的特征提取网络由两个卷积层和一个MaxPool层组成。两个卷积层使用3x3的卷积核,步长为1,填充为1。MaxPool层使用2x2的池化核,步长为2。特征提取网络的输出是一个26x26x512的特征图。

### 2.3 检测头

YOLOv2的检测头是一个全连接层和一个卷积层。全连接层将26x26x512的特征图展平为一个1x1x4096的特征图。卷积层使用1x1的卷积核,步长为1,填充为0。卷积层的输出是一个26x26x512的特征图。

检测头用于预测边界框和类别概率。边界框预测包含4个值:x、y、w和h。x和y表示边界框的中心坐标,w和h表示边界框的宽和高。类别概率预测包含C个值,其中C是类别数。

**代码块:**

```python

import tensorflow as tf

class YOLOv2(tf.keras.Model):

def __init__(self, num_classes):

super(YOLOv2, self).__init__()

self.num_classes = num_classes

# 主干网络

self.darknet_19 = tf.keras.applications.Darknet19(include_top=False, input_shape=(416, 416, 3))

# 特征提取网络

self.conv1 = tf.keras.layers.Conv2D(512, (3, 3), padding="same")

self.maxpool1 = tf.keras.layers.MaxPooling2D((2, 2), strides=(2, 2))

self.conv2 = tf.keras.layers.Conv2D(512, (3, 3), padding="same")

self.maxpool2 = tf.keras.layers.MaxPooling2D((2, 2), strides=(2, 2))

# 检测头

self.fc = tf.keras.layers.Dense(4096)

self.conv3 = tf.keras.layers.Conv2D(512, (1, 1), padding="same")

def call(self, inputs):

# 主干网络

x = self.darknet_19(inputs)

# 特征提取网络

x = self.conv1(x)

x = self.maxpool1(x)

x = self.conv2(x)

x = self.maxpool2(x)

# 检测头

x = self.fc(x)

x = self.conv3(x)

return x

```

**逻辑分析:**

* `__init__()`方法初始化模型,包括主干网络、特征提取网络和检测头。

* `call()`方法定义模型的前向传播过程。

* 主干网络使用预训练的Darknet-19模型。

* 特征提取网络使用两个卷积层和一个MaxPool层。

# 3. YOLOv2训练过程**

### 3.1 数据预处理

YOLOv2训练需要大量标记的图像数据。数据预处理是一个至关重要的步骤,它可以提高模型的训练效率和准确性。数据预处理通常包括以下步骤:

- **图像缩放和裁剪:**将图像缩放或裁剪到统一的大小,以满足模型输入要求。

- **数据增强:**通过随机裁剪、翻转、旋转等技术,增强数据集的多样性,防止模型过拟合。

- **数据标注:**对图像中的目标进行标注,包括边界框和类别标签。

### 3.2 模型训练

YOLOv2模型训练是一个迭代的过程,涉及以下步骤:

- **初始化模型:**使用预训练权重或随机权重初始化模型参数。

- **正向传播:**将图像输入模型,得到模型预测的边界框和类别概率。

- **计算损失:**计算模型预测与真实标注之间的损失函数,例如交并比损失(IoU loss)。

- **反向传播:**根据损失函数,计算模型参数的梯度。

- **更新参数:**使用优化算法(如梯度下降)更新模型参数,减小损失函数。

```python

import torch

from torch.utils.data import DataLoader

# 加载训练数据集

train_dataset = ...

# 定义数据加载器

train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True)

# 定义模型

model = YOLOv2()

# 定义优化器

optimizer = torch.optim.SGD(model.parameters(), lr=0.001)

# 训练模型

for epoch in range(100):

for batch in train_loader:

# 正向传播

outputs = model(batch['image'])

# 计算损失

loss = compute_loss(outputs, batch['label'])

# 反向传播

loss.backward()

# 更新参数

optimizer.step()

# 清空梯度

optimizer.zero_grad()

```

### 3.3 模型评估

训练完成后,需要对模型进行评估,以衡量其性能。常用的评估指标包括:

- **平均精度(mAP):**衡量模型在不同IoU阈值下检测准确率的平均值。

- **召回率:**衡量模型检测到所有真实目标的比例。

- **精确率:**衡量模型检测到的目标中有多少是真实目标。

```python

import numpy as np

# 加载测试数据集

test_dataset = ...

# 定义数据加载器

test_loader = DataLoader(test_dataset, batch_size=32)

# 评估模型

mAP = 0

recall = 0

precision = 0

for batch in test_loader:

# 正向传播

outputs = model(batch['image'])

# 计算指标

mAP += compute_mAP(outputs, batch['label'])

recall += compute_recall(outputs, batch['label'])

precision += compute_precision(outputs, batch['label'])

# 输出评估结果

print("mAP:", mAP / len(test_loader))

print("Recall:", recall / len(test_loader))

print("Precision:", precision / len(test_loader))

```

# 4. YOLOv2图像分割实践**

### 4.1 环境搭建

**操作系统:** Ubuntu 18.04 或更高版本

**Python:** 3.6 或更高版本

**PyTorch:** 1.0 或更高版本

**CUDA:** 10.0 或更高版本

**cuDNN:** 7.6 或更高版本

**安装依赖项:**

```

pip install torch torchvision torchaudio

pip install opencv-python

pip install matplotlib

```

### 4.2 数据集准备

**下载 COCO 数据集:**

```

wget http://images.cocodataset.org/annotations/annotations_trainval2017.zip

wget http://images.cocodataset.org/zips/train2017.zip

wget http://images.cocodataset.org/zips/val2017.zip

```

**解压数据集:**

```

unzip annotations_trainval2017.zip

unzip train2017.zip

unzip val2017.zip

```

### 4.3 模型训练和评估

**加载数据集:**

```python

import torchvision.datasets as datasets

import torchvision.transforms as transforms

train_dataset = datasets.CocoDetection(

root="train2017",

annFile="annotations/instances_train2017.json",

transform=transforms.ToTensor()

)

val_dataset = datasets.CocoDetection(

root="val2017",

annFile="annotations/instances_val2017.json",

transform=transforms.ToTensor()

)

```

**创建数据加载器:**

```python

import torch.utils.data as data

train_loader = data.DataLoader(

train_dataset,

batch_size=16,

shuffle=True,

num_workers=4

)

val_loader = data.DataLoader(

val_dataset,

batch_size=16,

shuffle=False,

num_workers=4

)

```

**创建模型:**

```python

import torch.nn as nn

model = nn.Sequential(

# 主干网络

nn.Conv2d(3, 32, kernel_size=3, stride=2, padding=1),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2, stride=2),

# 特征提取网络

nn.Conv2d(32, 64, kernel_size=3, stride=2, padding=1),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2, stride=2),

# 检测头

nn.Flatten(),

nn.Linear(1024, 512),

nn.ReLU(),

nn.Linear(512, 256),

nn.ReLU(),

nn.Linear(256, 80)

)

```

**定义损失函数和优化器:**

```python

import torch.nn.functional as F

loss_fn = F.cross_entropy

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

```

**训练模型:**

```python

for epoch in range(10):

for batch in train_loader:

images, labels = batch

outputs = model(images)

loss = loss_fn(outputs, labels)

optimizer.zero_grad()

loss.backward()

optimizer.step()

```

**评估模型:**

```python

with torch.no_grad():

for batch in val_loader:

images, labels = batch

outputs = model(images)

accuracy = (outputs.argmax(dim=1) == labels).float().mean()

print(f"Accuracy: {accuracy}")

```

**Mermaid流程图:**

```mermaid

graph LR

subgraph 数据准备

A[下载数据集] --> B[解压数据集]

end

subgraph 模型训练

C[加载数据集] --> D[创建数据加载器] --> E[创建模型] --> F[定义损失函数和优化器] --> G[训练模型]

end

subgraph 模型评估

H[加载数据集] --> I[创建数据加载器] --> J[评估模型]

end

```

**代码逻辑分析:**

* **主干网络:**使用卷积层和池化层提取图像特征。

* **特征提取网络:**使用卷积层和池化层进一步提取图像特征。

* **检测头:**将提取的特征展平并使用全连接层进行分类。

* **损失函数:**使用交叉熵损失函数计算模型输出和真实标签之间的差异。

* **优化器:**使用 Adam 优化器更新模型参数。

* **训练模型:**迭代训练模型,更新模型参数以最小化损失函数。

* **评估模型:**在验证集上评估模型的准确性。

# 5.1 超参数调整

### 5.1.1 学习率

学习率是训练过程中最重要的超参数之一。它控制着模型在每个训练步骤中更新权重的幅度。学习率过高会导致模型不稳定,甚至发散;而学习率过低则会导致模型收敛速度慢。

在YOLOv2中,学习率通常设置为一个较小的值,例如0.001或0.0001。在训练过程中,可以逐渐降低学习率以提高模型的稳定性。

### 5.1.2 动量

动量是一个超参数,它控制着模型在更新权重时考虑历史梯度信息的程度。动量有助于平滑梯度,防止模型陷入局部极小值。

在YOLOv2中,动量通常设置为0.9或0.99。较高的动量值可以提高模型的稳定性,但也会减慢收敛速度。

### 5.1.3 权重衰减

权重衰减是一个超参数,它控制着模型在更新权重时考虑权重大小的程度。权重衰减有助于防止模型过拟合,因为它会惩罚权重过大的模型。

在YOLOv2中,权重衰减通常设置为0.0005或0.0001。较高的权重衰减值可以提高模型的泛化能力,但也会减慢收敛速度。

### 5.1.4 批大小

批大小是训练过程中每次更新模型权重时使用的样本数量。批大小过大会导致模型过拟合,而批大小过小则会导致模型收敛速度慢。

在YOLOv2中,批大小通常设置为32或64。较大的批大小可以提高模型的稳定性,但也会增加训练时间。

### 5.1.5 训练轮数

训练轮数是模型在整个训练数据集上进行训练的次数。训练轮数过少会导致模型欠拟合,而训练轮数过多则会导致模型过拟合。

在YOLOv2中,训练轮数通常设置为100或200。较多的训练轮数可以提高模型的准确性,但也会增加训练时间。

### 5.1.6 超参数调整策略

超参数调整是一个迭代的过程,需要根据模型的性能进行调整。以下是一些常用的超参数调整策略:

- **网格搜索:**网格搜索是一种系统地搜索超参数空间的方法。它涉及到在超参数空间中定义一个网格,并训练模型以评估每个网格点的性能。

- **贝叶斯优化:**贝叶斯优化是一种基于贝叶斯统计的超参数调整方法。它使用贝叶斯定理来更新超参数分布,并选择最有可能提高模型性能的超参数组合。

- **随机搜索:**随机搜索是一种在超参数空间中随机采样的方法。它比网格搜索更有效率,但可能不会找到最佳的超参数组合。

### 5.1.7 代码示例

```python

import tensorflow as tf

# 定义超参数

learning_rate = 0.001

momentum = 0.9

weight_decay = 0.0005

batch_size = 32

num_epochs = 100

# 编译模型

model.compile(optimizer=tf.keras.optimizers.Adam(learning_rate=learning_rate, momentum=momentum, weight_decay=weight_decay),

loss='categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

model.fit(train_data, epochs=num_epochs, batch_size=batch_size)

```

# 6.1 目标检测

YOLOv2图像分割模型在目标检测任务中表现出色,它可以快速、准确地检测图像中的目标。目标检测的步骤如下:

1. **加载预训练模型:**加载预先训练好的YOLOv2图像分割模型。

2. **图像预处理:**将输入图像调整为模型要求的尺寸,并将其转换为张量。

3. **模型推理:**将预处理后的图像输入到YOLOv2模型中进行推理。

4. **后处理:**对模型输出的边界框和置信度进行后处理,以获得最终的目标检测结果。

```python

import cv2

import numpy as np

# 加载预训练模型

net = cv2.dnn.readNet("yolov2.weights", "yolov2.cfg")

# 图像预处理

image = cv2.imread("image.jpg")

image = cv2.resize(image, (416, 416))

image = image.astype(np.float32) / 255.0

# 模型推理

blob = cv2.dnn.blobFromImage(image, 1 / 255.0, (416, 416), (0, 0, 0), swapRB=True, crop=False)

net.setInput(blob)

detections = net.forward()

# 后处理

for detection in detections:

confidence = detection[5]

if confidence > 0.5:

x, y, w, h = detection[0:4] * np.array([image.shape[1], image.shape[0], image.shape[1], image.shape[0]])

cv2.rectangle(image, (int(x - w / 2), int(y - h / 2)), (int(x + w / 2), int(y + h / 2)), (0, 255, 0), 2)

# 显示结果

cv2.imshow("Image", image)

cv2.waitKey(0)

```

**代码解释:**

* `cv2.dnn.readNet()`:加载预训练的YOLOv2模型。

* `cv2.dnn.blobFromImage()`:将图像转换为模型输入所需的张量格式。

* `net.setInput()`:将张量输入到模型中。

* `net.forward()`:执行模型推理,得到检测结果。

* 后处理部分:过滤置信度较低的检测结果,并绘制边界框。

0

0