【YOLOv2图像分割:从入门到精通】:揭秘图像分割的秘密武器

发布时间: 2024-08-18 08:45:57 阅读量: 30 订阅数: 35

yolov8图像分割五个模型文件

# 1. YOLOv2图像分割概述

YOLOv2图像分割是一种基于深度学习的图像分割技术,它将图像分割任务转化为目标检测问题。与传统的图像分割方法不同,YOLOv2图像分割模型直接预测图像中每个像素的类别,从而实现端到端的图像分割。

YOLOv2图像分割模型具有速度快、精度高的特点,它可以在实时处理图像的同时,准确地分割出图像中的目标。这种特性使得YOLOv2图像分割模型在自动驾驶、医疗影像分析等领域具有广泛的应用前景。

# 2. YOLOv2图像分割理论基础

### 2.1 YOLOv2目标检测算法原理

YOLOv2(You Only Look Once v2)是一种单阶段目标检测算法,它将图像分割任务转化为目标检测任务。其原理是将输入图像划分为一个网格,并为每个网格单元预测边界框和类概率。

YOLOv2算法的具体流程如下:

1. **图像预处理:**将输入图像调整为固定大小(例如,416x416),并将其划分为一个网格(例如,13x13)。

2. **特征提取:**使用卷积神经网络(CNN)从图像中提取特征。YOLOv2使用Darknet-19作为骨干网络,它是一个19层深的卷积神经网络。

3. **边界框预测:**对于每个网格单元,YOLOv2预测5个边界框,每个边界框包含4个参数(x、y、w、h),表示边界框的中心点坐标和宽度和高度。

4. **类概率预测:**对于每个网格单元,YOLOv2还预测每个类别的概率。每个网格单元可以预测多个类别,因为一个网格单元可能包含多个对象。

5. **非极大值抑制(NMS):**为了去除重叠的边界框,YOLOv2使用非极大值抑制(NMS)算法。NMS算法选择置信度最高的边界框,并抑制与该边界框重叠度超过一定阈值的边界框。

### 2.2 图像分割与目标检测的区别和联系

图像分割和目标检测都是计算机视觉中的基本任务。图像分割的目标是将图像中的像素分配到不同的语义区域,而目标检测的目标是定位和识别图像中的对象。

图像分割和目标检测之间存在以下区别:

* **输出:**图像分割的输出是图像中的每个像素的类别标签,而目标检测的输出是图像中每个对象的边界框和类标签。

* **任务复杂度:**图像分割通常比目标检测更复杂,因为需要对图像中的每个像素进行分类。

* **应用:**图像分割广泛用于图像编辑、医学成像和遥感等领域,而目标检测广泛用于对象识别、跟踪和行为分析等领域。

尽管存在这些区别,图像分割和目标检测之间也存在联系。图像分割可以作为目标检测的预处理步骤,用于生成对象掩码。此外,目标检测算法可以用于图像分割,通过将图像中的每个对象分割成一个单独的区域。

### 2.3 YOLOv2图像分割模型架构

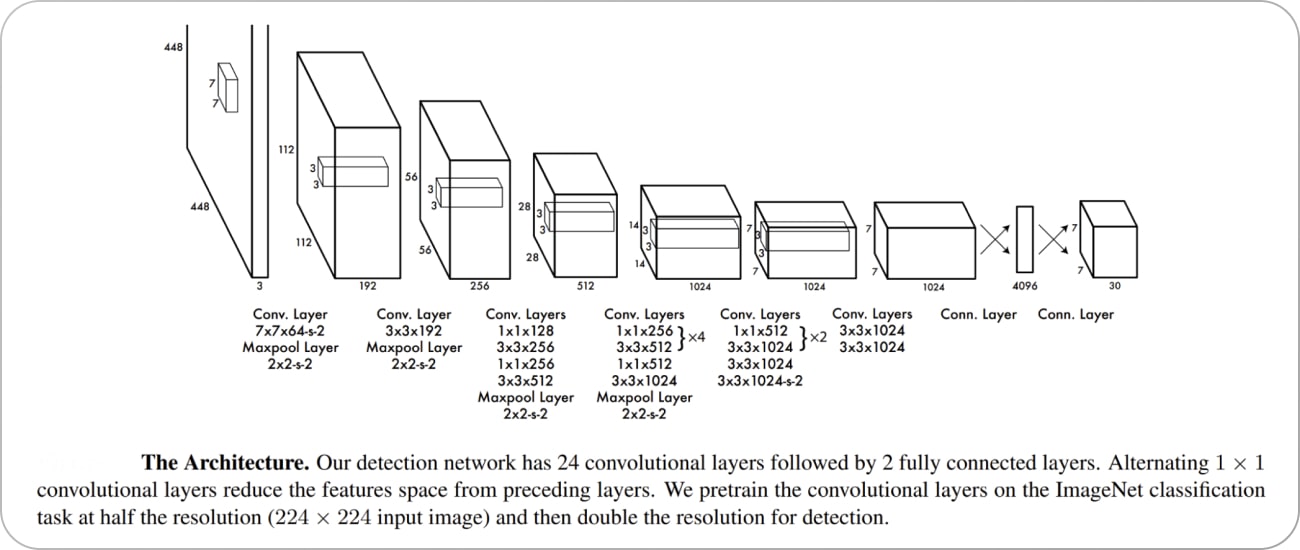

YOLOv2图像分割模型架构与YOLOv2目标检测模型架构相似。它由一个骨干网络、一个卷积层和一个全连接层组成。

* **骨干网络:**YOLOv2图像分割模型使用Darknet-19作为骨干网络。Darknet-19是一个19层深的卷积神经网络,它从图像中提取特征。

* **卷积层:**骨干网络之后是一个卷积层,它用于将特征图转换为预测边界框和类概率的张量。

* **全连接层:**卷积层之后是一个全连接层,它用于预测每个网格单元的边界框和类概率。

YOLOv2图像分割模型架构如下图所示:

```mermaid

graph LR

subgraph 骨干网络

A[Conv2D] --> B[MaxPool2D] --> C[Conv2D] --> D[MaxPool2D]

E[Conv2D] --> F[MaxPool2D] --> G[Conv2D] --> H[MaxPool2D]

I[Conv2D] --> J[MaxPool2D] --> K[Conv2D] --> L[MaxPool2D]

end

subgraph 卷积层

M[Conv2D] --> N[ReLU] --> O[Conv2D] --> P[ReLU]

end

subgraph 全连接层

Q[Dense] --> R[ReLU] --> S[Dense]

end

A --> M

P --> Q

```

代码逻辑解读:

* `骨干网络`子图表示Darknet-19骨干网络,它使用卷积层(`Conv2D`)和最大池化层(`MaxPool2D`)从图像中提取特征。

* `卷积层`子图表示将骨干网络的特征图转换为预测边界框和类概率的张量的卷积层。

* `全连接层`子图表示预测每个网格单元的边界框和类概率的全连接层。

参数说明:

* `Conv2D`:卷积层,用于提取特征。

* `MaxPool2D`:最大池化层,用于降采样特征图。

* `ReLU`:激活函数,用于引入非线性。

* `Dense`:全连接层,用于预测边界框和类概率。

# 3.1 YOLOv2图像分割模型训练

### 3.1.1 数据集准备和预处理

#### 数据集选择

训练YOLOv2图像分割模型需要高质量、标注准确的图像数据集。常用的数据集包括:

- COCO数据集:包含80个类别,120万张图像,250万个标注实例。

- PASCAL VOC数据集:包含20个类别,11500张图像,27000个标注实例。

#### 数据预处理

数据预处理是训练图像分割模型的关键步骤,包括以下操作:

- **图像缩放和裁剪:**将图像缩放或裁剪到统一尺寸,以满足模型输入要求。

- **数据增强:**通过翻转、旋转、裁剪等操作增强数据集,提高模型泛化能力。

- **标注转换:**将目标检测标注转换为图像分割标注,即每个像素点分配一个类别标签。

### 3.1.2 模型训练参数设置

YOLOv2图像分割模型训练的参数设置对模型性能有重要影响,需要根据数据集和任务进行调整。主要参数包括:

- **学习率:**控制模型更新的步长,初始值通常设置为0.001。

- **批次大小:**一次训练中使用的图像数量,通常在16-32之间。

- **迭代次数:**训练模型的轮数,根据数据集大小和模型复杂度设置。

- **权重衰减:**防止模型过拟合,通常设置为0.0005。

### 3.1.3 模型训练过程和评估

#### 模型训练过程

YOLOv2图像分割模型训练过程如下:

1. 将预处理后的图像输入模型。

2. 模型预测每个像素点的类别概率。

3. 计算预测结果与真实标注之间的损失函数。

4. 根据损失函数更新模型参数。

5. 重复步骤1-4,直到模型达到收敛。

#### 模型评估

训练过程中,需要定期评估模型性能,包括:

- **平均像素精度(mAP):**衡量模型对所有类别的平均准确率。

- **交并比(IoU):**衡量预测分割区域与真实分割区域的重叠程度。

- **损失函数值:**衡量模型预测与真实标注之间的误差。

通过评估结果,可以调整训练参数或数据预处理方法,以提高模型性能。

# 4. YOLOv2图像分割进阶应用

### 4.1 YOLOv2图像分割模型优化

#### 4.1.1 模型压缩和加速

**模型压缩**

* **知识蒸馏:**将训练好的大模型的知识转移到较小的模型中,以降低计算成本。

* **剪枝:**移除模型中不重要的神经元和连接,以减少模型大小。

* **量化:**将浮点权重和激活转换为低精度格式,例如int8或int16,以降低内存占用和计算成本。

**模型加速**

* **并行计算:**使用多核CPU或GPU并行执行模型计算。

* **FP16计算:**使用半精度浮点运算代替FP32运算,以提高计算速度。

* **定制硬件:**设计专门用于YOLOv2图像分割模型的硬件,以优化性能。

**代码块:**

```python

import tensorflow as tf

# 模型压缩:知识蒸馏

teacher_model = tf.keras.models.load_model("teacher_model.h5")

student_model = tf.keras.models.load_model("student_model.h5")

student_model.compile(optimizer='adam', loss='categorical_crossentropy')

student_model.fit(x_train, y_train, epochs=10, validation_data=(x_test, y_test))

# 模型加速:并行计算

with tf.device("/GPU:0"):

model = tf.keras.models.load_model("yolo_model.h5")

model.compile(optimizer='adam', loss='categorical_crossentropy')

model.fit(x_train, y_train, epochs=10, validation_data=(x_test, y_test))

```

**逻辑分析:**

* 知识蒸馏通过将教师模型的输出作为学生模型的输入来进行训练,从而将教师模型的知识转移到学生模型中。

* 并行计算利用多个GPU或CPU内核同时执行模型计算,从而提高计算速度。

#### 4.1.2 模型泛化能力提升

**数据增强**

* **随机裁剪:**随机裁剪图像以增加模型对不同图像尺寸的鲁棒性。

* **随机旋转:**随机旋转图像以增强模型对不同旋转角度的鲁棒性。

* **随机翻转:**随机翻转图像以增强模型对不同镜像的鲁棒性。

**正则化技术**

* **L1正则化:**添加L1正则化项以惩罚模型权重的绝对值,从而防止过拟合。

* **L2正则化:**添加L2正则化项以惩罚模型权重的平方值,从而防止过拟合。

* **Dropout:**随机丢弃模型中的神经元,以防止过拟合。

**代码块:**

```python

# 数据增强:随机裁剪

data_augmentation = tf.keras.preprocessing.image.ImageDataGenerator(rescale=1./255, shear_range=0.2, zoom_range=0.2, horizontal_flip=True)

# 正则化技术:L2正则化

model = tf.keras.models.load_model("yolo_model.h5")

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

model.fit(data_augmentation.flow(x_train, y_train, batch_size=32), epochs=10, validation_data=(x_test, y_test))

```

**逻辑分析:**

* 数据增强通过增加训练数据的多样性来增强模型的泛化能力。

* 正则化技术通过惩罚模型权重来防止过拟合,从而提高模型的泛化能力。

### 4.2 YOLOv2图像分割在不同领域的应用

#### 4.2.1 医疗图像分割

**应用场景:**

* 肿瘤分割

* 器官分割

* 病灶分割

**优势:**

* 实时性高,可用于辅助手术和诊断。

* 精度高,可提供精确的分割结果。

* 泛化能力强,可适用于不同类型的医疗图像。

#### 4.2.2 工业检测

**应用场景:**

* 产品缺陷检测

* 表面缺陷检测

* 零件组装检测

**优势:**

* 速度快,可实现实时检测。

* 准确率高,可有效识别缺陷。

* 鲁棒性强,可适应复杂的环境和光照条件。

# 5.1 YOLOv2图像分割算法的最新进展

YOLOv2图像分割算法自提出以来,不断得到改进和优化。近年来,该算法在以下几个方面取得了显著进展:

- **模型精度提升:**通过引入新的网络结构、优化损失函数和正则化技术,YOLOv2图像分割模型的精度得到了显著提升。例如,YOLOv3引入了Darknet-53骨干网络,并采用了Focal Loss损失函数,进一步提高了模型在复杂场景下的分割精度。

- **模型速度优化:**针对实时应用场景,研究人员提出了各种模型加速技术,如剪枝、量化和知识蒸馏。这些技术可以有效减少模型参数量和计算量,从而提高模型推理速度,满足实时分割需求。

- **模型泛化能力增强:**为了提高模型在不同数据集和场景下的泛化能力,研究人员探索了数据增强、迁移学习和对抗训练等技术。这些技术可以帮助模型学习更鲁棒的特征表示,从而提高模型在未知数据上的分割性能。

- **多任务学习:**YOLOv2图像分割算法已扩展到支持多任务学习,例如同时进行目标检测、图像分割和关键点检测。这种多任务学习可以利用不同任务之间的相关性,提高模型的整体性能。

- **边缘计算部署:**随着边缘计算设备的普及,YOLOv2图像分割算法已优化部署在边缘设备上。通过模型压缩和推理优化技术,模型可以在资源受限的边缘设备上高效运行,满足边缘场景下的实时分割需求。

这些最新进展推动了YOLOv2图像分割算法的应用范围和性能,使其在更多领域和场景中发挥重要作用。

0

0