【R语言实战秘籍】:构建个人数据分析工作流(全程演练)

发布时间: 2024-11-06 15:52:41 阅读量: 30 订阅数: 42

无需编写任何代码即可创建应用程序:Deepseek-R1 和 RooCode AI 编码代理.pdf

# 1. R语言简介与安装配置

## R语言简介

R语言是一种用于统计分析、图形表示和报告的编程语言和软件环境。它特别擅长于数据挖掘和统计建模,广泛应用于生物信息学、金融分析、社会科学等多个领域。R语言的核心竞争力在于其丰富的第三方包,这些包由全球的统计学家和数据科学家贡献,极大地扩展了R语言的功能。

## 安装R语言

要在计算机上安装R语言,你需要访问官方网站[The Comprehensive R Archive Network (CRAN)](***。选择与你的操作系统相匹配的安装包下载并执行安装程序。安装过程通常简单直接,只需要按照提示操作即可完成。

## 配置R语言环境

安装完成后,为了更好地使用R语言,还需要安装一个图形用户界面(GUI),如RStudio。RStudio为R语言提供了一个更加友好的开发环境,支持代码高亮、代码自动补全、版本控制等多种功能。你可以通过RStudio官方网站下载并安装适合你操作系统的版本。完成安装后,打开RStudio,进行一些基本配置,如设置包管理器镜像站点以加速包的安装过程,这样你就可以开始你的R语言之旅了。

```r

# 在RStudio中设置镜像站点的示例代码

options(repos = c(CRAN = "***"))

```

以上代码块展示了如何在R语言中设置CRAN镜像站点的示例,这样做可以加速R包的下载和更新。在后续章节中,我们将深入了解R语言的基础语法和数据结构,为你构建坚实的数据科学基础。

# 2. R语言基础语法与数据结构

### 2.1 基本数据类型与操作

在R语言中,基本数据类型包括了向量、矩阵、数组以及数据框(Data Frame)。这些数据结构是数据操作的基础。本节将通过具体的代码示例和详细分析,帮助读者理解和掌握这些基本数据类型的创建、操作及其应用场景。

#### 2.1.1 向量、矩阵、数组的创建与操作

向量是最简单的数据结构,它是一维的、同质的数据序列。矩阵(Matrix)是二维的,而数组(Array)可以是多维的。下面是创建和操作这些数据类型的基本方法。

```r

# 创建向量

vector <- c(1, 2, 3, 4, 5)

print(vector)

# 创建矩阵

matrix <- matrix(1:20, nrow = 4, ncol = 5)

print(matrix)

# 创建数组

array <- array(1:24, dim = c(2, 3, 4))

print(array)

```

上述代码段创建了一个简单的数值向量、一个4行5列的矩阵以及一个具有2个行、3个列和4个深度的数组。这些基本操作是R语言数据处理的基础。

向量和矩阵提供了多种操作函数,如`colSums()`, `rowMeans()`, `apply()`等,这些都是数据分析中常用的操作。

```r

# 计算矩阵每列的和

column_sums <- colSums(matrix)

print(column_sums)

# 计算数组第一页的行平均值

page_1_row_means <- rowMeans(array[,,1])

print(page_1_row_means)

```

为了进一步深入理解,我们通过实际案例来操作和分析这些数据结构。例如,在进行统计分析时,我们可能需要先将数据转换为矩阵或数组形式。

#### 2.1.2 数据框(Data Frame)的处理技巧

数据框(Data Frame)是R中用于存储表格型数据的最为重要的数据结构之一,它是一种特殊的列表(List),每列可以是不同的数据类型。

```r

# 创建数据框

data_frame <- data.frame(

name = c("Alice", "Bob", "Charlie"),

age = c(25, 30, 35),

gender = c("Female", "Male", "Male")

)

print(data_frame)

```

数据框的处理涵盖了数据筛选、合并、排序等操作。以下是一些基本操作示例:

```r

# 筛选特定行

selected_rows <- data_frame[data_frame$age > 30,]

print(selected_rows)

# 添加新列

data_frame$income <- c(50000, 60000, 65000)

print(data_frame)

# 数据框合并

new_data <- data.frame(

name = c("Dave", "Eve"),

age = c(28, 40),

gender = c("Male", "Female")

)

merged_data <- rbind(data_frame, new_data)

print(merged_data)

```

数据框处理技巧的学习是深入数据挖掘和统计分析不可或缺的一部分。通过熟练掌握数据框的操作,您可以更加灵活地处理复杂的数据集。

### 2.2 R语言中的函数应用

#### 2.2.1 函数的定义与调用

在R中,函数是一种将输入转化为输出的代码块。定义函数允许用户创建自定义操作,以封装重复使用的代码逻辑。

```r

# 定义函数

add_two_numbers <- function(num1, num2) {

return(num1 + num2)

}

# 调用函数

result <- add_two_numbers(5, 7)

print(result)

```

这段代码定义了一个简单的函数`add_two_numbers`,它接受两个参数并返回它们的和。之后,我们通过调用该函数,并传入具体的参数值,得到了结果。

函数的设计和使用,在编写复杂程序时非常重要,它帮助我们遵循DRY(Don't Repeat Yourself)原则,提高代码的可维护性和可读性。

#### 2.2.2 函数与作用域

作用域是决定哪些变量可以被访问的规则。在R中,变量的作用域由它们的创建位置决定。了解作用域对于理解函数如何处理变量至关重要。

```r

x <- 10

f <- function() {

x <- 20

return(x)

}

g <- function() {

return(x)

}

# 在函数f中创建的局部变量x遮蔽了全局变量x

print(f()) # 输出 20

# 函数g试图访问全局变量x

print(g()) # 输出 10

```

在这个示例中,函数`f`中创建了一个局部变量`x`,它遮蔽了全局变量`x`。而函数`g`则访问了全局作用域中的变量`x`。理解这种行为对于编写无冲突的函数和调试代码至关重要。

### 2.3 数据的导入与导出

#### 2.3.1 读取不同格式的数据文件

R语言支持多种文件格式的数据导入导出,如CSV、Excel、JSON等。使用恰当的函数读取数据是数据分析的首要步骤。

```r

# 读取CSV文件

csv_data <- read.csv("data.csv")

print(head(csv_data))

# 读取Excel文件

library(readxl)

excel_data <- read_excel("data.xlsx")

print(head(excel_data))

# 读取JSON文件

library(jsonlite)

json_data <- fromJSON("data.json")

print(json_data)

```

读取数据时,需要考虑数据文件的编码、缺失值的处理等问题。以上代码块展示了如何使用基础函数及加载了额外包的函数读取不同格式的数据文件。

#### 2.3.2 数据的导出与保存

数据处理分析完成后,需要将结果导出保存。R提供了相应的函数,可以将数据框导出为多种格式。

```r

# 将数据框导出为CSV文件

write.csv(csv_data, "processed_data.csv", row.names = FALSE)

# 将数据框导出为Excel文件

library(writexl)

write_xlsx(csv_data, "processed_data.xlsx")

# 将数据框导出为JSON文件

toJSON(csv_data, pretty = TRUE, file = "processed_data.json")

```

在导出数据时,我们可以指定不同的参数来控制输出格式、是否包含行名等。这些操作在将分析结果分享或进一步使用时非常重要。

以上便是第二章的内容,涵盖了R语言的基础语法和数据结构。通过实例代码和逻辑分析,本章为读者提供了对R语言基本操作的全面理解,为后续更高级的分析和数据处理奠定了坚实的基础。

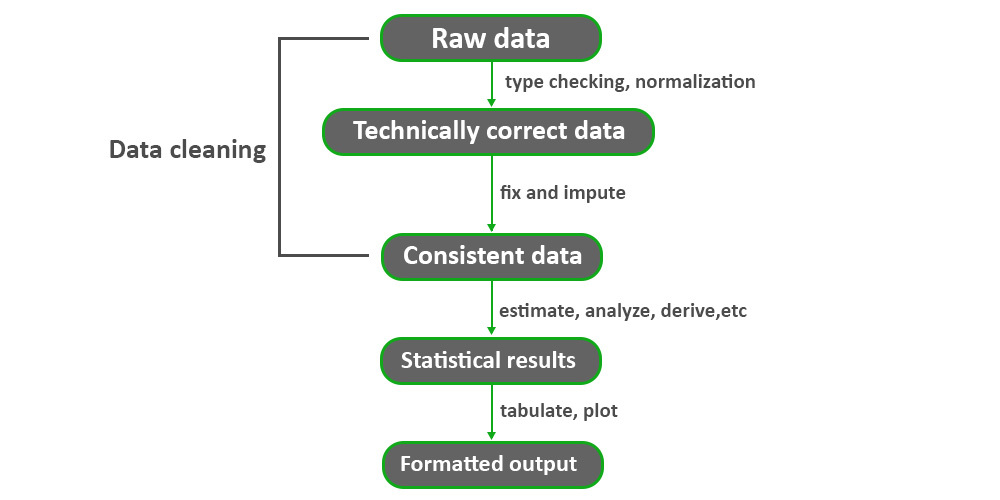

# 3. R语言数据清洗与预处理

数据清洗与预处理是数据分析过程中至关重要的一步,它确保了后续分析的质量和准确性。在这一章节中,我们将深入探讨如何在R语言中处理各种数据问题,包括缺失值和异常值,数据转换与整合,以及数据分组与汇总分析。

## 3.1 缺失值和异常值处理

### 3.1.1 识别和处理缺失数据

在现实世界的数据集中,缺失数据几乎是不可避免的。R语言提供了多种工具和方法来识别和处理缺失数据。

首先,要识别数据集中的缺失值,可以使用`is.na()`函数。此函数会返回一个与原数据集大小相同的逻辑矩阵,其中的`TRUE`值表示相应位置是缺失值。

```r

# 创建一个向量示例数据

data <- c(1, 2, NA, 4, 5)

# 检测缺失值

missing_values <- is.na(data)

print(missing_values)

```

在这个简单的例子中,我们创建了一个包含一个缺失值(`NA`)的向量,并使用`is.na()`函数检测到它。为了处理这些缺失值,常用的策略有删除含有缺失值的行、用平均值/中位数/众数填补、或者使用模型预测缺失值。

### 3.1.2 检测和处理异常值

异常值可以破坏数据的分布,对数据分析的结果产生重大影响。通常,检测异常值的方法依赖于数据的统计特性,例如标准差、四分位距(IQR)等。

异常值的处理方法包括删除、修正或者保留。R语言中可以使用箱型图(Boxplot)来直观识别异常值。

```r

# 创建一个包含异常值的示例数据集

data_set <- data.frame(

values = c(10, 11, 12, 13, 14, 15, 100)

)

# 绘制箱型图

boxplot(data_set$values, main="Boxplot of Data Set")

```

通过上述代码,我们绘制了一个包含单个异常值的数据集的箱型图。识别出异常值后,可以选择将其删除,或者根据数据集的特性进行适当处理,例如使用众数或中位数替换异常值。

## 3.2 数据转换与整合

### 3.2.1 数据重塑与聚合操作

在进行数据分析时,常常需要将数据从宽格式(wide format)转换为长格式(long format),或者相反。R语言的`reshape2`包和`tidyverse`包中的`tidyr`包提供了强大的数据重塑工具。

使用`melt()`函数将宽格式数据转换为长格式数据是一个常见的操作:

```r

library(reshape2)

# 宽格式数据转换为长格式数据

wide_data <- data.frame(

id = c(1, 2, 3),

var1 = c(2.5, 3.2, 2.1),

var2 = c(3.5, 2.9, 1.7)

)

long_data <- melt(wide_data, id.vars = "id")

print(long_data)

```

### 3.2.2 数据的合并与拆分

合并数据通常涉及到连接(join)操作,而拆分数据则涉及到将数据集分解为更小的部分。R语言中,`dplyr`包中的`join()`函数系列提供了多种连接数据的方法,例如内连接、左连接、右连接、全连接等。

```r

library(dplyr)

# 拆分数据为两部分

data_split <- split(wide_data, f = wide_data$id)

# 合并数据集

data_join <- left_join(data_split[[1]], data_split[[2]], by = "id")

```

通过上述代码,我们首先使用`split()`函数拆分了一个数据集为多个部分,然后使用`left_join()`函数将其按照id进行左连接合并。

## 3.3 数据分组与汇总分析

### 3.3.1 分组操作的实现

R语言中,`dplyr`包提供了非常方便的分组操作函数`group_by()`,这使得对数据集中的子集进行操作成为可能。

```r

# 分组并计算均值

grouped_data <- group_by(wide_data, id) %>%

summarise_at(vars(var1, var2), mean)

print(grouped_data)

```

以上代码展示了如何使用`group_by()`函数对数据集进行分组,并使用`summarise_at()`函数对每个分组计算均值。

### 3.3.2 汇总函数的使用与自定义

除了分组之外,汇总统计也是数据分析中不可或缺的一部分。在R语言中,`summarise()`函数能够创建新的汇总列,而自定义函数则可以提供更大的灵活性。

```r

# 自定义函数计算中位数

median_func <- function(x) {

median(x, na.rm = TRUE)

}

# 应用自定义函数计算分组数据的中位数

grouped_median <- group_by(wide_data, id) %>%

summarise_at(vars(var1, var2), median_func)

print(grouped_median)

```

在上述代码中,我们首先定义了一个计算中位数的自定义函数`median_func`,然后使用`summarise_at()`函数将其应用于每个分组的特定列。

通过R语言的数据清洗与预处理技术,我们可以有效地准备数据,为数据分析提供坚实的基础。随着数据分析复杂性的增加,这些技术变得越发关键。在下一章节中,我们将介绍R语言的统计分析与可视化技术,它们将帮助我们更好地解释和理解数据。

# 4. R语言统计分析与可视化

## 4.1 基础统计分析方法

### 4.1.1 描述性统计分析

描述性统计分析是数据科学的基础,它提供了数据集的快速概览,包括中心趋势和分散程度的度量。在R语言中,我们可以使用内置函数如 `summary()`, `mean()`, `median()`, `sd()`, `var()` 等来进行描述性统计。

```r

# 示例数据集

data <- iris

# 描述性统计分析

summary(data)

mean(data$Sepal.Length)

median(data$Sepal.Length)

sd(data$Sepal.Length)

var(data$Sepal.Length)

```

在上述代码中,我们首先加载了内置的 `iris` 数据集,然后使用 `summary()` 函数获取了整个数据集的统计摘要。接着,分别计算了鸢尾花的花萼长度的均值、中位数、标准差和方差。这样的分析帮助我们理解数据集的主要特征。

描述性统计分析是后续所有复杂统计分析的起点,它帮助我们评估数据的质量,以及是否需要进行进一步的数据清洗和处理。

### 4.1.2 常见统计测试

在执行描述性统计之后,我们可能需要进行更进一步的统计推断,这通常涉及到假设检验。在R中,执行统计测试非常简单,比如我们可以使用 `t.test()` 来进行t检验,或者使用 `chisq.test()` 来执行卡方检验。

```r

# 两独立样本t检验

t.test(data$Sepal.Length ~ data$Species)

# 卡方检验

table(data$Species, data$Petal.Width)

chisq.test(table(data$Species, data$Petal.Width))

```

在这些示例代码中,我们用 `t.test()` 函数比较了不同鸢尾花品种间花萼长度的差异。此外,我们使用了 `table()` 和 `chisq.test()` 对花的品种与花瓣宽度之间的关系进行了卡方检验。这些测试可以帮助我们理解变量之间的关系,从而为数据驱动的决策提供统计依据。

## 4.2 高级统计分析与模型构建

### 4.2.1 线性回归与逻辑回归分析

R语言提供了广泛的统计模型构建工具。最常用的线性回归模型可以通过 `lm()` 函数来拟合:

```r

# 线性回归模型

lm_model <- lm(Sepal.Length ~ Petal.Length + Species, data = iris)

# 查看模型摘要

summary(lm_model)

```

在这个例子中,我们拟合了一个线性模型来预测鸢尾花的花萼长度,使用了花瓣长度和物种作为自变量。通过 `summary()` 函数,我们可以查看模型的详细统计摘要,评估各个变量的显著性和模型的整体拟合度。

逻辑回归通常用于二分类问题,可以使用 `glm()` 函数来构建:

```r

# 逻辑回归模型

glm_model <- glm(Species ~ Sepal.Length + Sepal.Width, data = iris, family = binomial)

# 查看模型摘要

summary(glm_model)

```

这里我们尝试建立一个模型来预测鸢尾花的物种(二分类变量),以花萼长度和宽度为预测变量。同样,我们使用 `summary()` 函数来获取模型的相关信息。

### 4.2.2 时间序列分析基础

时间序列分析是分析时间顺序数据点的统计方法。在R中,我们可以使用 `ts()` 函数创建时间序列对象,并用 `forecast` 包来进行时间序列预测。

```r

# 安装forecast包(如果尚未安装)

install.packages("forecast")

# 加载forecast包

library(forecast)

# 创建时间序列对象

ts_data <- ts(airquality$Ozone, frequency = 12, start = c(1973, 5))

# 进行时间序列预测

fc <- forecast(ts_data, h = 12)

# 绘制预测图

plot(fc)

```

在这段代码中,我们使用 `ts()` 函数创建了一个时间序列对象 `ts_data`,它代表了 `airquality` 数据集中的臭氧含量数据。然后,我们使用 `forecast()` 函数对该时间序列进行预测,并通过 `plot()` 函数绘制了预测结果的图形。时间序列分析可以帮助我们预测未来的数据趋势,对于金融市场、天气预报、库存管理等领域至关重要。

## 4.3 数据可视化技术

### 4.3.1 基本图形的创建与定制

R语言中内置了强大的绘图功能,通过基础图形函数 `plot()`, `hist()`, `boxplot()` 等可以创建多种基本图形。

```r

# 绘制散点图

plot(iris$Sepal.Length, iris$Sepal.Width)

# 绘制直方图

hist(iris$Sepal.Length)

# 绘制箱型图

boxplot(iris$Sepal.Length ~ iris$Species)

```

在上述代码中,我们分别创建了鸢尾花花萼长度与宽度的散点图,花萼长度的直方图,以及按物种分类的花萼长度箱型图。这些基础图形帮助我们直观地了解数据分布和变量间的关系。

为了增强图形的可读性和美观性,我们还可以对图形进行定制,比如添加标题、轴标签、改变颜色和形状等:

```r

# 定制散点图

plot(iris$Sepal.Length, iris$Sepal.Width, main = "Sepal Dimensions",

xlab = "Sepal Length", ylab = "Sepal Width",

pch = 19, col = "blue")

# 添加图例

legend("topright", legend = levels(iris$Species), pch = 19, col = c("red", "green3", "blue"))

```

在定制后的散点图中,我们增加了主标题、轴标签,并指定了数据点的形状和颜色。另外,我们还通过 `legend()` 函数在图形的右上角添加了图例,方便识别不同物种的数据点。

### 4.3.2 高级图表与交互式图形

除了基础图形,R语言还有各种高级图表库,如 `ggplot2`,以及交互式图形的库如 `plotly` 和 `shiny`,它们让可视化变得更为强大和吸引人。

```r

# 安装ggplot2包(如果尚未安装)

install.packages("ggplot2")

# 加载ggplot2包

library(ggplot2)

# 使用ggplot2创建散点图

ggplot(iris, aes(x = Sepal.Length, y = Sepal.Width, color = Species)) +

geom_point() +

labs(title = "Sepal Dimensions by Species",

x = "Sepal Length",

y = "Sepal Width") +

theme_minimal()

```

在这个例子中,我们使用了 `ggplot2` 包来绘制鸢尾花花萼长度与宽度的散点图,并根据物种进行了颜色分类。`ggplot2` 提供了丰富的定制选项和美观的默认主题。

对于交互式图形,我们可以使用 `plotly` 来创建:

```r

# 安装plotly包(如果尚未安装)

install.packages("plotly")

# 加载plotly包

library(plotly)

# 使用plotly创建交互式散点图

plotly::ggplotly(ggplot(iris, aes(x = Sepal.Length, y = Sepal.Width, color = Species)) +

geom_point() +

labs(title = "Interactive Sepal Dimensions by Species",

x = "Sepal Length",

y = "Sepal Width"))

```

这段代码使用了 `plotly::ggplotly()` 函数将 `ggplot2` 创建的静态散点图转换为交互式图形。用户可以通过悬停在数据点上来查看具体的数据值,并且可以缩放和平移图形,以便探索数据的更多细节。

通过这些高级图表与交互式图形,我们可以创建更加吸引人、更具互动性的数据可视化作品,这对于数据分析报告、演示和数据探索非常有帮助。

# 5. R语言在个人数据分析中的应用

在这一章节中,我们将深入了解R语言如何在多个数据分析领域发挥作用。从社交媒体数据分析、金融数据分析到生物统计与健康数据分析,我们将展示R语言如何帮助个人用户和数据分析专家利用强大的统计和可视化工具来挖掘数据的深层次价值。

## 5.1 社交媒体数据分析

社交媒体平台如Facebook、Twitter和Instagram产生了海量的数据,其中包含了用户行为、情感倾向和市场趋势的宝贵信息。R语言可以有效地用来从这些数据中提取洞见,实现情感分析和文本挖掘。

### 5.1.1 网络数据爬取技术

为了分析社交媒体数据,首先需要收集数据。R语言提供了多个包,比如`rvest`和`httr`,用于数据爬取。

```r

# 安装所需的包

install.packages("rvest")

install.packages("httr")

# 加载包

library(rvest)

library(httr)

# 示例代码:从网页中提取信息

# 假设我们要从一个示例网页获取标题

url <- "***"

response <- GET(url)

content <- content(response, as = "text", encoding = "UTF-8")

parsed_html <- htmlParse(content)

title <- xpathSApply(parsed_html, "//title", xmlValue)

print(title)

```

这个示例展示了如何通过HTTP请求获取网页内容,并使用XML解析技术提取网页标题。实际应用中,爬虫会根据具体的HTML结构和需求进行更复杂的操作。

### 5.1.2 情感分析与文本挖掘

收集数据后,下一步通常是理解数据所表达的情感或主题。R语言中的`tidytext`包非常适合于这类任务。

```r

# 安装并加载tidytext包

install.packages("tidytext")

library(tidytext)

# 假设我们有一个包含文本数据的数据框text_df

text_df <- data.frame(text = c("I love using R for data analysis!", "R is powerful but sometimes complex."))

# 分词处理并使用AFINN词典进行情感分析

words <- text_df %>%

unnest_tokens(word, text) %>%

inner_join(get_sentiments("afinn"))

# 分析并显示每个单词的情感得分

sentiment_score <- words %>%

group_by(word) %>%

summarize(sentiment_score = sum(value))

print(sentiment_score)

```

这里使用了`tidytext`包提供的函数,以整洁的方式处理文本数据,然后与AFINN情感词典结合进行情感分析。

## 5.2 金融数据分析

金融数据分析师可以利用R语言强大的统计功能和金融包如`quantmod`来进行市场趋势分析和风险评估。

### 5.2.1 金融时间序列分析

时间序列分析是金融数据分析的核心部分。R语言的`xts`和`zoo`包提供了时间序列数据结构和一系列分析工具。

```r

# 安装并加载所需的包

install.packages("quantmod")

install.packages("xts")

install.packages("zoo")

library(quantmod)

library(xts)

library(zoo)

# 获取股票价格数据作为示例

getSymbols("AAPL")

apple_prices <- Cl(AAPL)

# 计算移动平均线

ma_apple <- SMA(apple_prices, n = 20)

# 可视化股票价格和移动平均线

plot(apple_prices, main="Apple Stock Price with 20-Day Moving Average", xlab="Date", ylab="Price")

lines(ma_apple, col="blue")

```

在这个示例中,我们使用`quantmod`包下载苹果公司股票的历史价格,并计算并绘制了20天的移动平均线。

## 5.3 生物统计与健康数据分析

R语言在生物统计和健康数据分析领域也显示出了巨大的潜力。R语言的一些专业包,如`Bioconductor`,专门为生命科学和生物统计设计。

### 5.3.1 基因表达数据分析

生物数据分析师经常需要分析基因表达数据。`Bioconductor`为这类分析提供了许多有用的工具。

```r

# 安装Bioconductor

if (!requireNamespace("BiocManager", quietly = TRUE))

install.packages("BiocManager")

BiocManager::install()

# 加载所需的包

library(BiocManager)

library(edgeR)

# 假设我们有一个基因表达矩阵gene_count_matrix和样本信息矩阵sample_info

# 进行差异表达分析

dge <- DGEList(counts=gene_count_matrix, group=sample_info$group)

dge <- calcNormFactors(dge)

design <- model.matrix(~ sample_info$factor)

dge <- estimateDisp(dge, design)

et <- exactTest(dge)

# 排序并选择显著差异表达的基因

topTags(et)

```

这段代码展示了使用`edgeR`包进行基因表达差异分析的基本步骤,从创建DGEList对象开始,计算标准化因子,估计离散度,进行精确测试,最后输出显著性排序的结果。

总结来说,R语言在个人数据分析中展现了它的多功能性与灵活性。无论是社交媒体数据分析、金融数据分析还是生物统计与健康数据分析,R语言均能提供强大的工具和方法,帮助分析师处理复杂的数据问题,挖掘数据背后的价值。在实际应用中,R语言的这些功能为个人用户提供了深入研究和理解数据世界的强大能力。

# 6. R语言项目实战与优化

## 6.1 开发个人数据分析工作流

在个人数据分析工作中,开发一个高效且易于维护的工作流至关重要。这不仅能提高分析效率,还能确保工作过程的可重复性。

### 6.1.1 理解工作流与自动化

工作流是一系列有序的任务集合,每个任务在特定条件下触发,并且完成后将结果传递到下一个任务。在R语言中,工作流可以通过脚本自动化,利用函数或流程控制结构(如for循环、if条件语句)来实现。

例如,如果你要进行一个常规的数据清洗、分析和报告生成的过程,你可以编写一个R脚本:

```r

# 数据清洗

clean_data <- function(raw_data) {

# 执行数据清洗操作

}

# 数据分析

analyze_data <- function(cleaned_data) {

# 执行统计分析

}

# 报告生成

generate_report <- function(analyzed_data) {

# 生成报告

}

# 自动化工作流

process_data <- function(raw_data) {

cleaned_data <- clean_data(raw_data)

analyzed_data <- analyze_data(cleaned_data)

generate_report(analyzed_data)

}

# 假设raw_data是你的原始数据

raw_data <- read.csv("data.csv")

process_data(raw_data)

```

### 6.1.2 工作流的构建与案例演练

构建工作流的第一步是理解项目需求。一旦需求明确,你可以开始设计工作流的各个阶段。

以社交媒体数据分析为例,工作流可能包括以下步骤:

1. 爬取社交媒体数据。

2. 清洗数据。

3. 进行情感分析。

4. 导出分析结果。

你可以使用`httr`包来爬取数据,`dplyr`包来清洗数据,`tidytext`包来进行文本挖掘,最后用`ggplot2`包创建可视化图表。

```r

library(httr)

library(dplyr)

library(tidytext)

library(ggplot2)

# 步骤1:爬取社交媒体数据

social_media_data <- GET("***")

# 步骤2:数据清洗

cleaned_data <- raw_data %>%

filter(...) %>%

mutate(...)

# 步骤3:情感分析

sentiment_scores <- cleaned_data %>%

inner_join(get_sentiments("afinn"), by = "word") %>%

group_by(...) %>%

summarize(sentiment = sum(value))

# 步骤4:数据可视化

ggplot(sentiment_scores, aes(x = group, y = sentiment)) +

geom_bar(stat = "identity") +

theme_minimal()

```

这些代码块仅是示例,具体实现时你需要根据实际数据和需求进行调整。工作流构建是一个迭代的过程,通常需要多次测试和优化。

## 6.2 R语言性能优化与调试

随着项目复杂性的增加,性能优化和调试变得越来越重要。在R中,优化意味着提高代码的执行效率,而调试是找到并修复代码中的错误。

### 6.2.1 代码性能分析与优化技巧

R提供了一些工具来分析代码性能,比如`microbenchmark`包可以用来测试代码执行的时间:

```r

library(microbenchmark)

# 测试函数执行时间

microbenchmark(

sum(1:1000),

sum(seq(1, 1000)),

times = 100

)

```

优化技巧包括:

- 避免使用循环,转而使用向量化操作。

- 使用高效的数据结构,比如`data.table`代替`data.frame`。

- 避免重复计算,使用`cache = TRUE`或者将结果存储在变量中。

- 使用适当的R包,这些包通常是针对性能优化编写的。

### 6.2.2 调试方法与调试工具

R的调试工具包括`browser()`函数、`traceback()`函数和RStudio内置的调试器。

- `browser()`可以在代码中的特定点插入一个断点,程序运行到这里会暂停,允许你查看变量的值和程序状态。

- `traceback()`函数用于显示错误发生的调用栈。

```r

f <- function(x) {

if (!is.numeric(x)) stop("Argument must be numeric")

sum(x)

}

g <- function(x) {

f(x)

}

h <- function(x) {

g(x)

}

h("a") # 将会触发错误

traceback() # 显示错误发生的调用栈

```

RStudio的调试器提供了一个图形界面,可以让你逐步执行代码,检查变量的值,这是非常强大的功能。

## 6.3 R包与社区资源利用

R语言的生态系统非常丰富,大量的R包和活跃的社区资源可以极大地方便我们的工作。

### 6.3.1 学习和利用CRAN上的R包

CRAN(The Comprehensive R Archive Network)提供了成千上万的R包。学习如何找到、安装和使用这些包是R语言学习者的重要技能。

使用`install.packages()`来安装包,使用`library()`来加载包。例如:

```r

install.packages("ggplot2")

library(ggplot2)

```

### 6.3.2 参与R社区交流与贡献

R社区的交流与贡献可以帮助你扩展知识面和技能,同时也可以提升你在社区中的影响力。你可以通过以下方式参与:

- 论坛:Stack Overflow、RStudio Community等。

- 邮件列表:R-help、R-package-devel等。

- 会议:R会议、使用R进行数据科学会议(rstudio::conf)等。

- 博客:撰写和阅读有关R的博客文章。

- 开源贡献:为R或R包提交PR(Pull Request)或Issue。

参与社区不仅能帮助你解决问题,还能让你了解到最新的R语言发展动态。

0

0