YOLO训练时间优化:GPU并行加速技术详解

发布时间: 2024-08-17 11:27:18 阅读量: 75 订阅数: 28

# 1. YOLO训练简介

YOLO(You Only Look Once)是一种先进的物体检测算法,因其实时性和准确性而闻名。YOLO算法的训练过程至关重要,因为它影响着模型的性能和效率。本章将概述YOLO训练的基本概念,为后续章节中深入探讨GPU并行加速奠定基础。

YOLO训练过程涉及到将大量图像和标签数据馈送到神经网络,以调整网络权重并最小化损失函数。训练过程通常分为以下几个阶段:

- **数据预处理:**将图像和标签数据预处理为神经网络可以理解的格式,包括调整大小、归一化和数据增强。

- **模型训练:**使用随机梯度下降(SGD)或其变体等优化算法,通过反向传播更新网络权重。

- **模型评估:**使用验证集评估训练模型的性能,并根据需要调整训练超参数。

# 2. GPU并行加速理论基础

### 2.1 GPU并行计算原理

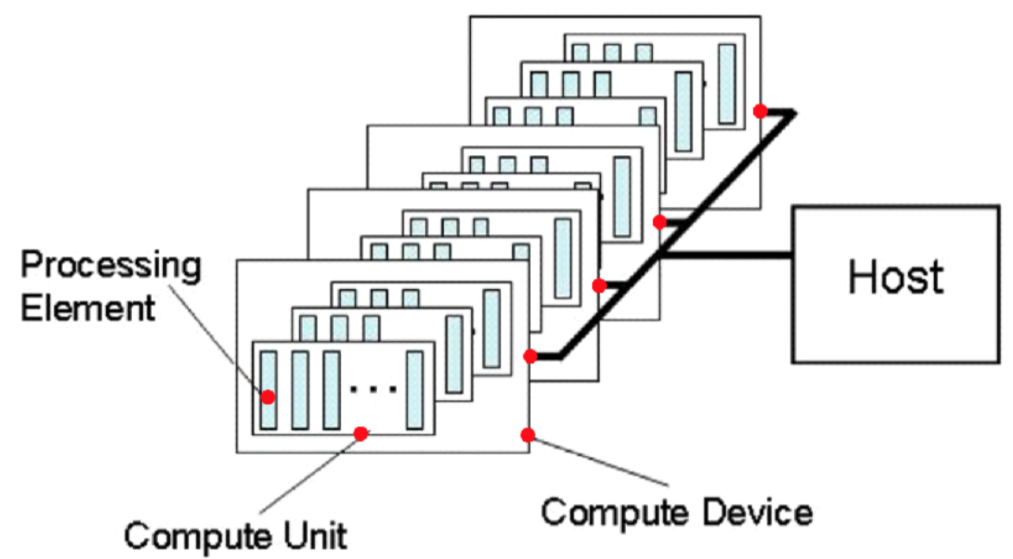

#### 2.1.1 GPU架构与并行计算模型

GPU(Graphics Processing Unit),即图形处理器,最初用于处理图形渲染任务。与CPU(Central Processing Unit)不同,GPU拥有大量并行计算单元,称为流处理器(Stream Processor)。这些流处理器可以同时处理多个线程,从而实现并行计算。

GPU的架构通常采用SIMT(Single Instruction Multiple Threads)模型,即单指令多线程。在SIMT模型中,所有流处理器执行相同的指令,但操作不同的数据。这种模型可以有效利用GPU的并行计算能力,提高计算效率。

#### 2.1.2 GPU并行计算的优势

GPU并行计算具有以下优势:

- **高并行度:** GPU拥有大量流处理器,可以同时执行大量线程,实现高并行度计算。

- **高吞吐量:** GPU的流处理器可以同时处理多个数据流,提高数据处理吞吐量。

- **低延迟:** GPU的流处理器之间通信延迟低,可以快速完成数据处理任务。

- **能效比高:** GPU的功耗相对较低,在处理大量数据时具有较高的能效比。

### 2.2 深度学习并行加速算法

深度学习模型训练通常需要处理海量数据,因此并行加速算法至关重要。深度学习并行加速算法主要有以下三种类型:

#### 2.2.1 数据并行

数据并行是一种最简单的并行加速算法。它将训练数据划分为多个子集,并将其分配给不同的GPU。每个GPU负责训练自己的数据子集,然后将训练结果汇总到主GPU。

```python

import torch

import torch.nn as nn

import torch.optim as optim

import torch.distributed as dist

# 初始化分布式环境

dist.init_process_group(backend='nccl')

# 创建模型

model = nn.Linear(100, 10)

# 划分数据

data = torch.randn(1000, 100)

target = torch.randn(1000, 10)

# 将数据分配给GPU

data = data.to(dist.get_rank())

target = target.to(dist.get_rank())

# 创建优化器

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 训练模型

for epoch in range(10):

# 前向传播

output = model(data)

loss = nn.MSELoss()(output, target)

# 反向传播

optimizer.zero_grad()

loss.backward()

# 汇总梯度

dist.all_reduce(loss)

dist.all_reduce(model.grad)

# 更新权重

optimizer.step()

```

**参数说明:**

- `dist.init_process_group(backend='nccl')`:初始化分布式环境,使用NCCL后端。

- `model = nn.Linear(100, 10)`:创建线性回归模型。

- `data = torch.randn(1000, 100)`:生成随机训练数据。

- `target = torch.randn(1000, 10)`:生成随机目标数据。

- `data = data.to(dist.get_rank())`:将数据分配给当前GPU。

- `target = target.to(dist.get_rank())`:将目标分配给当前GPU。

- `optimizer = optim.SGD(model.parameters(), lr=0.01)`:创建优化器。

- `for epoch in range(10)`:训练模型10个epoch。

- `output = model(data)`:前向传播。

- `loss = nn.MSELoss()(output, target)`:计算损失函数。

- `optimizer.zero_grad()`:将梯度清零。

- `loss.backward()`:反向传播。

- `dist.all_reduce(loss)`:汇总损失函数。

- `dist.all_reduce(model.grad)`:汇总模型梯度。

- `optimizer.step()`:更新权重。

**逻辑分析:**

该代码实现了数据并行训练。首先,它初始化分布式环境,然后创建模型、划分数据并将其分配给GPU。接下来,它创建优

0

0