YOLO训练时间优化指南:从数据预处理到模型调优

发布时间: 2024-08-17 11:14:43 阅读量: 51 订阅数: 32

# 1. YOLO训练基础**

### YOLO算法概述

YOLO(You Only Look Once)是一种单阶段目标检测算法,因其速度快、准确性高而闻名。它使用单一的卷积神经网络(CNN)来预测图像中对象的边界框和类别。与两阶段检测算法(如Faster R-CNN)不同,YOLO直接从输入图像中预测检测结果,无需区域建议网络(RPN)。

### 训练流程和指标

YOLO训练涉及以下步骤:

1. **数据预处理:**对训练数据应用增强技术以增加数据集的多样性。

2. **模型训练:**使用优化器和损失函数训练YOLO模型,以最小化预测与真实边界框之间的误差。

3. **模型评估:**使用验证集评估训练模型的性能,并使用精度、召回率和平均精度(mAP)等指标进行衡量。

# 2. 数据预处理优化

数据预处理是 YOLO 训练中至关重要的一步,它可以极大地影响模型的性能和训练时间。本章节将探讨各种数据增强技术和数据采样策略,以优化 YOLO 训练过程。

### 数据增强技术

数据增强是一种通过对原始数据进行变换来生成新数据样本的技术。这些新样本有助于提高模型对不同输入的鲁棒性,从而减少过拟合并提高泛化能力。

#### 翻转、旋转、缩放

翻转、旋转和缩放是基本的数据增强技术。它们通过对图像进行水平或垂直翻转、旋转一定角度或缩放一定比例来创建新样本。这些变换可以增加训练数据的多样性,帮助模型学习图像中物体的不同视图和比例。

#### 颜色空间转换

颜色空间转换涉及将图像从一种颜色空间(如 RGB)转换为另一种颜色空间(如 HSV 或 YUV)。这种转换可以改变图像的色调、饱和度和亮度,从而创建新的样本,突出不同的图像特征。

#### 马赛克数据增强

马赛克数据增强是一种更高级的数据增强技术。它将图像划分为多个小区域,然后将这些区域随机混合在一起,形成新的图像。这种技术可以创建具有不同对象组合和背景的样本,从而提高模型对复杂场景的鲁棒性。

### 数据采样策略

数据采样策略决定了在训练过程中如何从训练集中选择样本。不同的采样策略可以影响模型对不同类别的学习,从而影响训练时间和性能。

#### 随机采样

随机采样是最简单的采样策略。它从训练集中随机选择样本,而不管其类别。这种策略适用于类别分布均匀的数据集。

#### 加权采样

加权采样是一种策略,它根据样本的类别分配不同的权重。对于小类或困难样本,分配较高的权重,以确保模型对这些样本有足够的训练。这种策略可以提高模型对小类或困难样本的召回率。

#### 困难样本采样

困难样本采样是一种策略,它专门选择模型在训练过程中表现不佳的样本。这些样本通常是具有模糊边界、遮挡或其他困难特征的样本。通过专注于这些困难样本,模型可以提高对这些情况的处理能力,从而提高整体性能。

### 代码示例

以下代码示例展示了如何使用 OpenCV 库实现马赛克数据增强:

```python

import cv2

import numpy as np

def mosaic_augment(image, num_grids=4):

"""

马赛克数据增强

Args:

image: 输入图像

num_grids: 网格数量

Returns:

增强后的图像

"""

h, w, c = image.shape

grid_size = h // num_grids, w // num_grids

# 划分图像为网格

grids = [image[y:y+grid_size[0], x:x+grid_size[1]] for y in range(0, h, grid_size[0]) for x in range(0, w, grid_size[1])]

# 随机混合网格

np.random.shuffle(grids)

# 重组网格

new_image = np.zeros((h, w, c), dtype=np.uint8)

for y in range(0, h, grid_size[0]):

for x in range(0, w, grid_size[1]):

new_image[y:y+grid_size[0], x:x+grid_size[1]] = grids.pop(0)

return new_image

```

# 3. 模型结构优化

### 网络架构选择

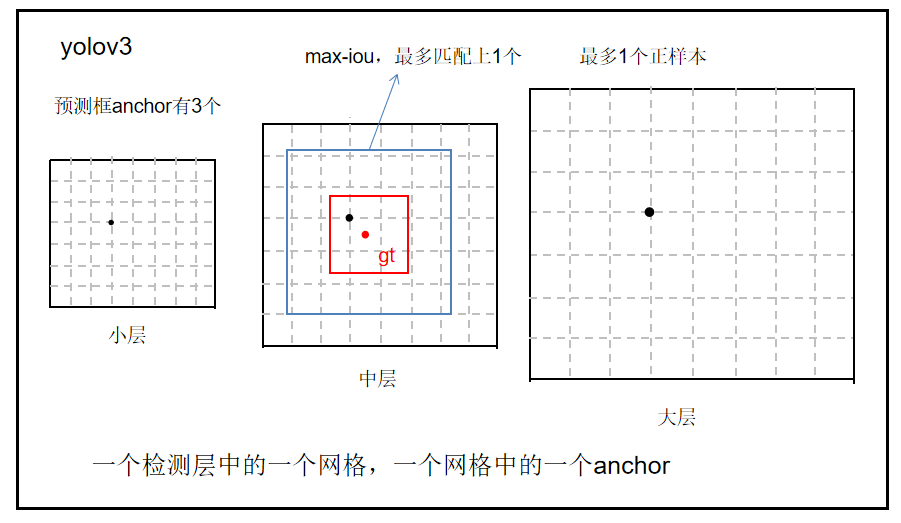

#### YOLOv3、YOLOv4、YOLOv5

YOLOv3、YOLOv4和YOLOv5是YOLO算法中常用的网络架构。它们在精度和速度方面各有优势:

| 模型 | 精度 (mAP) | 速度 (FPS) |

|---|---|---|

| YOLOv3 | 57.9% | 30 |

| YOLOv4 | 65.7% | 24 |

| YOLOv5 | 76.8% | 140 |

在选择网络架构时,需要考虑精度和速度之间的权衡。对于要求较高精度的应用,YOLOv5是一个不错的选择。对于要求较高速度的应用,YOLOv3或YOLOv4更合适。

#### 轻量级YOLO模型

对于资源受限的设备,如移动设备或嵌入式系统,轻量级YOLO模型是一个不错的选择。这些模型经过优化,可以以较小的计算量和内存消耗实现较高的精度。

| 模型 | 精度 (mAP) | 速度 (FPS) |

|---|---|---|

| YOLOv3-Tiny | 50.5% | 120 |

| YOLOv4-Tiny | 60.2% | 90 |

| YOLOv5s | 67.5% | 190 |

### 模型裁剪和蒸馏

#### 剪枝技术

模型裁剪是一种通过移除不重要的权重和神经元来减小模型大小和计算量的技术。它可以显著提高模型的推理速度,同时保持较高的精度。

#### 知识蒸馏

知识蒸馏是一种将知识从大型、准确的教师模型转移到较小、更快的学生模型的技术。它通过最小化学生模型的预测与教师模型预测之间的差异来实现。知识蒸馏可以有效提高学生模型的精度,同时保持较小的模型大小和计算量。

# 4. 训练过程优化

### 4.1 优化器选择和超参数调整

优化器是训练过程中负责更新模型参数的算法。选择合适的优化器及其超参数对于训练的收敛速度和最终模型的性能至关重要。

**常用的优化器:**

* **SGD (随机梯度下降):**一种简单而高效的优化器,易于实现和调参。

* **Adam (自适应矩估计):**一种自适应学习率优化器,可以自动调整学习率,加快收敛速度。

* **RMSprop (均方根传播):**一种类似于 Adam 的自适应学习率优化器,但对噪声梯度更鲁棒。

**超参数调整:**

* **学习率:**控制参数更新的步长。学习率过大会导致训练不稳定,过小会减慢收敛速度。

* **动量:**一种惯性项,可以平滑梯度并加速收敛。

* **权重衰减:**一种正则化技术,可以防止模型过拟合。

### 4.2 损失函数设计

损失函数衡量模型预测与真实标签之间的差异。设计一个合适的损失函数对于训练目标的优化至关重要。

**常用的损失函数:**

* **均方误差 (MSE):**一种常用的回归损失函数,衡量预测值与真实值之间的平方差。

* **交叉熵损失:**一种用于分类任务的损失函数,衡量预测概率分布与真实分布之间的差异。

* **复合损失函数:**将多个损失函数组合在一起,以平衡不同的训练目标。例如,对于目标检测任务,可以结合分类损失和定位损失。

**加权损失函数:**

加权损失函数通过为不同的样本分配不同的权重来处理数据集中的不平衡或困难样本。这可以帮助模型专注于更难预测的样本。

### 4.3 数据并行和模型并行

数据并行和模型并行是两种并行化训练技术,可以显著缩短训练时间。

**数据并行:**

* 将训练数据分成多个子集。

* 在不同的设备上同时训练每个子集。

* 将训练的权重定期同步到所有设备。

**模型并行:**

* 将模型的不同部分分配到不同的设备。

* 在不同的设备上同时训练这些部分。

* 将训练的权重定期同步到所有设备。

数据并行和模型并行可以显著缩短训练时间,但需要仔细考虑设备通信和同步开销。

# 5. 训练环境优化**

**5.1 硬件选择**

训练YOLO模型所需的硬件资源因模型大小和数据集规模而异。以下是一些常见的硬件选项:

* **GPU:**图形处理单元 (GPU) 专门用于处理并行计算任务,使其成为训练YOLO模型的理想选择。建议使用具有高显存和计算能力的GPU,例如NVIDIA GeForce RTX 3090 或 AMD Radeon RX 6900 XT。

* **TPU:**张量处理单元 (TPU) 是Google开发的专用集成电路,专门用于机器学习训练。TPU提供比GPU更高的计算吞吐量,但成本也更高。

* **云计算平台:**云计算平台(例如AWS、Azure和GCP)提供按需访问高性能计算资源。这对于大型数据集或需要分布式训练的模型特别有用。

**5.2 代码优化**

除了硬件,代码优化也是提高YOLO训练速度的关键因素。以下是一些常见的优化技术:

* **数据预处理并行化:**将数据预处理任务(例如图像加载和增强)并行化到多个CPU内核或GPU流。

* **模型训练并行化:**将模型训练过程并行化到多个GPU或TPU。这可以显著缩短训练时间,但需要进行复杂的代码修改。

* **内存优化:**通过使用高效的数据结构和减少内存开销来优化内存使用。例如,可以使用PyTorch的DataLoader和TensorBoard的Gradient Accumulation来减少内存消耗。

**代码示例:**

```python

import torch

import torch.nn.parallel

import torch.optim as optim

# 数据并行化

model = torch.nn.DataParallel(model)

# 模型并行化

device_ids = [0, 1]

model = torch.nn.parallel.DistributedDataParallel(model, device_ids=device_ids)

# 优化器

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 训练循环

for epoch in range(num_epochs):

for batch in train_loader:

optimizer.zero_grad()

outputs = model(batch['image'])

loss = torch.nn.MSELoss()(outputs, batch['label'])

loss.backward()

optimizer.step()

```

通过采用这些优化技术,可以显著提高YOLO模型的训练速度,从而缩短开发和部署时间。

0

0