自动化运维工具链:构建高效自动化运维流程的实战攻略

发布时间: 2024-12-21 05:13:35 阅读量: 8 订阅数: 7

# 摘要

随着信息技术的快速发展,自动化运维工具链成为了现代IT管理不可或缺的一部分。本文首先概述了自动化运维工具链的概念,随后探讨了自动化工具的选择与集成的重要性、自动化流程设计的最佳实践以及部署流程的自动化。文中还分析了基础设施即代码、灾难恢复与备份策略自动化和日志管理与分析自动化的实践案例。最后,本文展望了自动化运维的未来趋势,包括新兴技术的应用、安全性挑战和持续学习的重要性,提供了相应的风险管理与应对策略,以帮助IT专业人员适应日新月异的技术环境,提高运维效率和质量。

# 关键字

自动化运维;工具链;集成策略;流程设计;持续集成/持续部署;基础设施即代码

参考资源链接:[阿特拉斯空压机GA37+至GA75用户手册:安全与操作指南](https://wenku.csdn.net/doc/6412b703be7fbd1778d48c5e?spm=1055.2635.3001.10343)

# 1. 自动化运维工具链概述

在数字化转型的时代背景下,运维工作正面临前所未有的挑战。企业需确保系统的稳定性、可扩展性和安全性,同时还需要不断提升效率、降低成本。这一切都指向一个解决方案——自动化运维。自动化运维工具链是指利用一套集成化的工具和流程来实现日常运维任务的自动化,这不仅包括基础设施的配置和管理,也包括应用的部署、监控、优化等。

自动化运维工具链的核心在于将重复性、机械性的运维活动转化为自动执行的流程,通过编程化的方式实现运维的标准化和规模化。这种做法可以大幅减少人为失误,提升工作效率,还能为运维团队带来更深层次的洞察和分析能力。在后续章节中,我们将深入探讨如何选择合适的自动化工具,如何将它们集成到现有的运维流程中,并讨论设计自动化流程的最佳实践。

# 2. 自动化工具的选择与集成

## 2.1 自动化工具市场概览

### 2.1.1 常见的自动化运维工具分类

自动化运维工具在当今 IT 管理中扮演着至关重要的角色。根据其功能和应用场景,我们可以将这些工具分为几大类:

- **配置管理工具**:这类工具专注于服务器配置和状态的管理,例如 Puppet、Chef 和 Ansible。它们允许系统管理员通过声明性语言定义系统应有的状态,并自动调整现有状态以符合期望配置。

- **持续集成/持续部署(CI/CD)工具**:这类工具推动了软件开发的自动化流程,从代码的自动构建、测试到部署。Jenkins、GitLab CI 和 CircleCI 是一些流行的选择。

- **监控和告警工具**:监控工具如 Nagios、Prometheus、以及 Zabbix 被用来跟踪系统的性能和健康状况,并通过告警系统通知管理员出现的问题。这些工具通常与仪表板结合,提供实时视图。

- **代码管理工具**:这类工具用于跟踪代码的变更,使得团队成员之间的协作变得简单高效。GitHub、GitLab 和 Bitbucket 是三个广泛使用的服务。

- **容器编排工具**:容器技术的兴起带来了容器编排工具,比如 Kubernetes 和 Docker Swarm,它们用于自动化容器的部署、管理和扩展。

- **云管理平台**:云环境中的自动化,例如 AWS CloudFormation、Azure Resource Manager 和 Google Cloud Deployment Manager,它们通过模板自动化创建和管理资源。

了解这些分类对于选择合适工具以适应组织的具体需求至关重要。

### 2.1.2 工具选型的关键因素

在选择自动化工具时,必须考虑以下几个关键因素以确保工具能满足业务需求:

- **兼容性**:考虑该工具与现有系统的兼容性,是否支持所需的平台和语言。

- **功能性**:评估工具是否具备所需的所有功能,并检查是否有扩展的能力。

- **易用性**:考虑工具的学习曲线,以及其提供的文档和社区支持。

- **社区和企业支持**:活跃的社区和高质量的商业支持是解决技术难题的关键。

- **安全性**:自动化工具必须符合公司的安全标准,并提供安全审计的能力。

- **成本**:评估使用该工具的总成本,包括许可证费、培训费用和维护成本。

- **伸缩性**:了解工具是否能够随着组织的成长而扩展。

综合以上因素,可以有目的地筛选出最适合的自动化工具。

## 2.2 自动化工具集成策略

### 2.2.1 集成工具前的准备和规划

为了确保自动化工具集成成功,必须先进行彻底的准备和规划。这一过程包括:

- **需求分析**:明确组织的业务目标和自动化工具需要满足的具体需求。

- **技术评估**:评估现有系统架构,确保所选工具与之兼容,并能与现有工具良好集成。

- **预算评估**:为项目设立明确的预算,并评估长期运营成本。

- **人员培训**:确定所需技能缺口,并为相关人员安排适当的培训。

- **实施计划**:创建详细的实施时间表,包含每一个步骤和预期的里程碑。

### 2.2.2 集成流程的构建与实施

构建和实施自动化工具的集成流程包括以下步骤:

- **环境搭建**:建立用于集成和测试的环境,避免对生产环境造成影响。

- **代码编写**:编写集成脚本或配置,确保代码的可读性和可维护性。

- **测试验证**:在集成过程中进行彻底的测试,验证自动化流程的正确性。

- **文档编制**:编写详细的实施文档,为后续的维护和故障排查提供支持。

- **发布实施**:选择合适的时间窗口,按照计划逐步推广集成的自动化工具。

### 2.2.3 集成后的测试与优化

集成完成后,关键的步骤是测试和优化以确保系统稳定性和性能。

- **性能测试**:执行性能测试以确保集成后系统性能达到预期目标。

- **问题定位与修复**:收集反馈,定位问题,并及时修复。

- **持续优化**:利用监控工具持续监控系统性能,定期进行优化。

- **反馈循环**:建立反馈机制,持续收集用户反馈,并根据反馈进行调整。

## 2.3 自动化工具链的性能监控

### 2.3.1 监控系统的搭建

搭建一个有效的监控系统是保证自动化工具链性能的关键。步骤包括:

- **监控需求分析**:分析组织的监控需求,确定要监控的关键指标。

- **选择监控工具**:根据需求选择合适的监控工具。

- **配置监控系统**:配置监控工具,设置警报规则和阈值。

- **数据聚合和分析**:将监控数据聚合,并利用可视化工具进行分析。

- **报告和审计**:生成定期报告,便于进行审计和性能评估。

### 2.3.2 监控指标与告警机制

选择合适的监控指标和设置有效的告警机制对于及时响应问题至关重要。

- **选择关键指标**:例如系统负载、响应时间、错误率、资源使用率等。

- **告警策略**:制定告警策略,明确什么情况下触发告警以及告警通知的对象和方式。

- **告警级别**:定义不同级别的告警,比如通知、警告和紧急。

- **告警通知**:通过邮件、短信、即时消息等不同渠道发送告警通知。

- **告警响应**:建立快速响应机制,确保当告警发生时可以立即采取行动。

监控系统与告警机制的建立,不仅能够保证自动化工具链的稳定运行,也能够为未来的优化提供数据支持。

# 3. 自动化流程设计与实践

## 3.1 自动化流程设计原则

### 3.1.1 设计模式与最佳实践

在设计自动化流程时,采用正确的设计模式至关重要。设计模式不仅可以提升流程的可维护性,还能保证流程的可扩展性和可靠性。一种常用的设计模式是“管道与过滤器”模式,它允许数据在一个线性序列的过滤器之间流动,每个过滤器执行一项特定的任务。这种模式特别适合于数据处理和分析流程。

例如,在自动化部署流程中,我们可以使用此模式将代码检查、构建、测试、部署等操作串联起来,每个步骤作为一个过滤器,它们之间通过管道传输构建产物。此外,应该遵循一些最佳实践,比如“DRY(Don't Repeat Yourself)”原则,避免重复编写相同逻辑的代码,提高效率。还有“单一职责”原则,确保每个组件、模块或函数只负责一个功能,易于理解和维护。

### 3.1.2 流程编排与任务依赖

在复杂的自动化流程中,任务之间可能存在依赖关系。例如,在持续部署的流程中,单元测试必须在代码合并之前完成。正确的任务依赖管理是流程成功的关键。流程编排工具如 Apache Airflow 或 Kubernetes 的工作流可以帮助定义和管理这些复杂的依赖关系。

任务依赖可以细分为顺序依赖和条件依赖。顺序依赖关系指任务必须按特定顺序执行,而条件依赖关系则意味着任务的执行取决于前一个或多个任务的执行结果。合理地使用这些依赖关系能够保证自动化流程的正确执行。使用任务依赖关系,我们可以通过定义任务的前置条件和后置条件来编排复杂的工作流。

```yaml

# 示例代码:定义任务依赖关系

- name: taskA

command: 'echo "Starting task A"'

- name: taskB

command: 'echo "Starting task B"'

upstreams: [taskA]

- name: taskC

command: 'echo "Starting task C"'

upstreams: [taskB]

```

在上述YAML格式的任务定义中,taskB 依赖于 taskA 的完成,taskC 依赖于 taskB 的完成。这样就能保证任务按照 taskA -> taskB -> taskC 的顺序执行。

## 3.2 代码管理与版本控制

### 3.2.1 版本控制系统的选择

版本控制系统是现代软件开发的核心基础设施,它可以跟踪代码变更历史,协作开发,以及管理代码的不同版本。在众多的版本控制系统中,Git 凭借其分布式特性、灵活性和强大的功能而脱颖而出,成为了现代软件开发的首选工具。

选择版本控制系统时应考虑项目需求、团队规模和成员技能。Git 需要搭建中央仓库(如使用 GitHub、GitLab 或 Bitbucket)来管理代码,而 Subversion(SVN)则是另一种集中式版本控制的选项,适合对分支和合并要求不高的项目。

### 3.2.2 代码分支策略与合并

在多成员协作开发中,正确管理代码分支是提高开发效率和代码质量的关键。常用的分支策略有 GitFlow 和 GitHub Flow。GitFlow 强调通过多个长期分支(如 develop 和 master)来管理开发过程和产品发布。GitHub Flow 更为简单,只使用一个长期分支 master,将特性开发在临时分支上进行,并通过 Pull Request 形式合并到 master。

合理的分支合并策略可以避免代码冲突和集成问题,尤其是当团队成员同时在多个分支上工作时。通常建议,开发者在创建新分支之前,先从 master 分支拉取最新的代码并进行合并,确保本地代码是最新的。完成开发后,通过 Pull Request 请求合并,等待代码审查和自动化测试通过后,才可以合并到主分支。

```mermaid

graph LR

A[开始] --> B[创建特性分支]

B --> C[进行开发]

C --> D[推送分支到远程仓库]

D --> E[发起 Pull Request]

E --> F[进行代码审查]

F --> G[自动化测试]

G --> H{是否通过}

H -->|是| I[合并到 master]

H -->|否| J[修复问题]

J --> C

I --> K[结束]

```

在上述流程图中,我们可以看到从创建特性分支到合并的完整流程。值得注意的是,在合并前的自动化测试和代码审查是关键步骤,以确保代码质量。

## 3.3 部署流程自动化

### 3.3.1 持续集成(CI)的实现

持续集成是一种软件开发实践,开发人员频繁地(通常是每天多次)将代码集成到共享仓库中。每次集成都通过自动化构建(包括编译、运行测试)来验证,以便尽快发现集成错误。实施CI的关键在于搭建高效的自动化构建环境,常见的工具包括 Jenkins、Travis CI 和 CircleCI。

实施CI的步骤一般包括:

1. 设置自动化构建环境。

2. 配置版本控制系统以触发自动构建。

3. 编写自动化测试以确保代码质量。

4. 通过构建报告和测试结果提供反馈。

```yaml

# 示例代码:Jenkinsfile 配置

pipeline {

agent any

stages {

stage('Build') {

steps {

sh 'mvn clean package'

}

}

stage('Test') {

steps {

sh 'mvn test'

}

}

stage('Deploy') {

steps {

sh './deploy.sh'

}

}

}

}

```

在上述Jenkinsfile配置中,我们定义了一个典型的CI流程,包括构建、测试和部署三个阶段。

### 3.3.2 持续部署(CD)的策略

持续部署是持续集成的下一步,它自动化了代码从仓库到生产环境的过程。实施CD之前,需要确保有可靠的自动化测试和良好的代码质量。CD的关键在于将部署过程中的环境配置和部署流程自动化,常见的工具包括 Ansible、Kubernetes 和 AWS CodeDeploy。

持续部署的策略可以分为:

1. 手动部署:每次部署都需要人工确认。

2. 自动部署:代码通过测试后自动部署到生产环境。

3. 蓝绿部署:并行运行两套环境,新版本在蓝环境测试部署,不影响绿环境的运行。

4. 滚动更新:逐步替换旧版本实例,减少部署风险。

```mermaid

graph LR

A[开始部署] --> B[代码通过CI]

B --> C{选择部署策略}

C -->|手动部署| D[人工确认]

C -->|自动部署| E[自动部署到生产]

C -->|蓝绿部署| F[部署到蓝环境测试]

C -->|滚动更新| G[逐步替换旧版本实例]

D --> H[结束]

E --> H

F --> H

G --> H

```

在上述流程图中,我们可以看到不同部署策略的决策过程。每种策略都有其适用场景,选择合适的策略对于优化部署流程至关重要。

以上是第三章“自动化流程设计与实践”的全部内容,我们探讨了自动化流程设计的原则,版本控制系统的最佳实践,以及CI和CD的具体实现和策略。通过深入分析这些关键实践,我们能够构建出更加高效、稳定且可扩展的自动化运维流程。

# 4. 自动化运维实践案例分析

## 4.1 基础设施即代码(IaC)实践

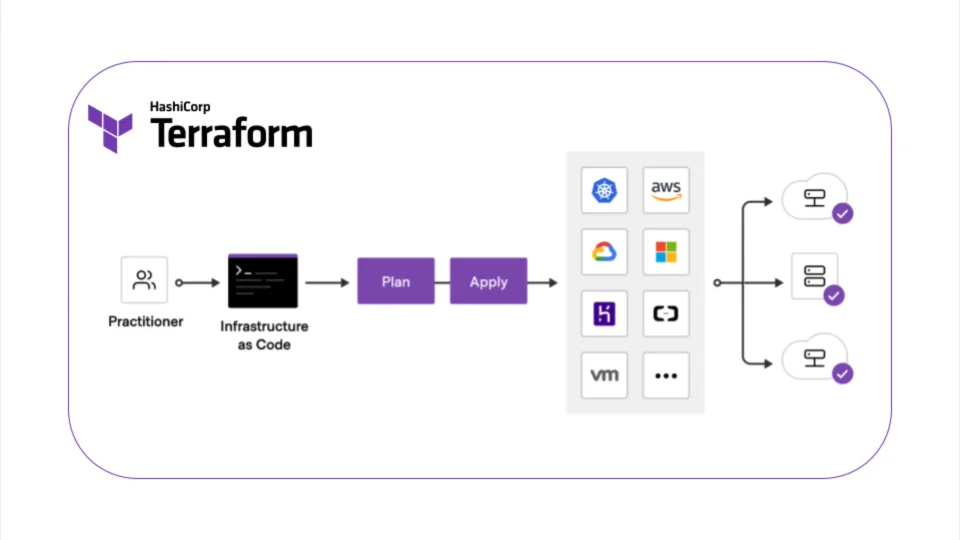

基础设施即代码(Infrastructure as Code, IaC)是自动化运维中的一个核心概念,它指的是通过代码来管理、配置和编排IT基础设施。这个实践使得IT环境的创建和改变可以被自动化和版本控制,从而提高了效率和一致性,同时减少了人为错误。

### 4.1.1 IaC工具的应用场景

IaC可以应用在多种场景中,包括但不限于:

- **云环境部署**:无论是公有云、私有云还是混合云,IaC工具可以帮助快速部署整个云环境。

- **多环境复制**:在开发、测试和生产等不同环境之间,能够快速复制和部署相同配置的基础设施。

- **合规与审计**:确保配置管理与安全策略保持一致,方便进行合规审计。

- **版本控制和变更管理**:所有的基础设施变更都可以通过版本控制系统追踪,便于问题回溯和变更管理。

### 4.1.2 代码化配置管理实例

在实际操作中,Terraform是一个非常流行的IaC工具,它允许用户以声明式的方式定义和部署基础设施。下面是一个Terraform的基本使用示例,用于创建一个AWS EC2实例:

```hcl

provider "aws" {

region = "us-west-2"

}

resource "aws_instance" "example" {

ami = "ami-0c55b159cbfafe1f0"

instance_type = "t2.micro"

tags = {

Name = "ExampleInstance"

}

}

```

**逻辑分析:**

- `provider "aws"` 声明了我们正在使用的AWS云服务提供商,并指定了区域。

- `resource "aws_instance" "example"` 定义了一个AWS实例资源,并通过 `ami` 和 `instance_type` 属性定义了具体的规格。

- `tags` 则用于设置实例的标签,这里为实例添加了一个名称标签。

Terraform会根据上述代码创建一个AWS EC2实例。在实际环境中,还需要考虑网络设置、安全组配置、存储卷管理等多个方面,Terraform都支持通过代码进行配置。

通过IaC工具的使用,IT团队可以更加高效、一致且可重复地管理基础设施,它也构成了现代DevOps实践的一个基石。

## 4.2 灾难恢复与备份策略自动化

在数据爆炸的今天,灾难恢复(Disaster Recovery, DR)和备份策略对于企业来说至关重要。自动化备份与灾难恢复可以显著减少因数据丢失、系统故障而带来的风险。

### 4.2.1 自动化备份解决方案

实现自动化备份可以减少人工操作错误,并且确保数据按照预定的时间间隔和策略被备份。自动化备份解决方案通常包括以下几个关键点:

- **备份工具的选择**:需要选择支持自动化操作的备份工具,如Veeam、Nutanix、AWS Backup等。

- **备份策略**:包括全备份、增量备份或差异备份等,以及备份频率、保留周期等。

- **自动化脚本编写**:利用脚本语言(如Python、Bash)编写自动化备份脚本,并与备份工具相结合。

以Python脚本调用Veeam备份为例:

```python

import subprocess

# Veeam命令行工具的路径

veeam_path = '/opt/veeam/BackupCmd.exe'

# 备份任务的配置参数

backup_task_name = 'DailyBackup'

vm_name = 'ProductionVM'

backup_repo = 'BackupRepository'

# 备份执行命令

cmd = [

veeam_path,

'backup', 'start',

'-name "{}"'.format(backup_task_name),

'-vm "{}"'.format(vm_name),

'-repo "{}"'.format(backup_repo)

]

# 执行备份命令

subprocess.run(cmd)

```

**逻辑分析:**

- 该脚本通过调用Veeam的命令行工具来启动一个备份任务,指定了备份任务名称、虚拟机名称和备份存储库。

- `subprocess.run()` 函数用来执行命令行操作,启动备份任务。

通过执行这样的脚本,IT运维人员可以定时(例如使用cron)运行备份,从而实现备份操作的自动化。

### 4.2.2 灾难恢复计划的自动化执行

自动化灾难恢复(DR)计划涉及到在发生灾难时自动启动备份的恢复过程。这通常包括以下步骤:

- **故障检测**:通过监控系统实时检测到故障发生。

- **故障通知**:将故障信息通知给运维团队或自动触发恢复流程。

- **恢复执行**:自动执行恢复计划,包括启动备用服务器、数据同步、网络重定向等。

## 4.3 日志管理与分析自动化

日志管理是系统运维的重要组成部分,它能够帮助IT团队实时监控系统状态、诊断问题、提供安全审计的证据。自动化日志管理与分析能够提升日志数据的利用效率,快速响应潜在的系统问题。

### 4.3.1 日志收集与存储

在自动化环境中,日志收集与存储通常会通过日志管理工具来完成,如ELK Stack(Elasticsearch, Logstash, Kibana)或者Loki等。ELK Stack是一个非常流行的日志分析平台,它的组件组合功能如下:

- **Elasticsearch**:负责存储日志数据,并提供全文搜索功能。

- **Logstash**:用于日志数据的收集、解析和过滤。

- **Kibana**:提供可视化界面,用于展示日志数据。

下面是一个使用Logstash配置文件进行日志收集的简单示例:

```conf

input {

file {

path => "/var/log/*.log"

start_position => "beginning"

}

}

filter {

grok {

match => { "message" => "%{COMBINEDAPACHELOG}" }

}

}

output {

elasticsearch {

hosts => ["localhost:9200"]

}

}

```

**逻辑分析:**

- `input` 部分指定了日志文件的路径和读取位置,这里是 `/var/log/*.log`。

- `filter` 部分使用了grok插件来解析原始日志数据,`%{COMBINEDAPACHELOG}` 是一个预定义的正则表达式模式,用于匹配Apache Web服务器的日志格式。

- `output` 部分将解析后的日志数据发送到Elasticsearch实例上,这里指定的是本地的Elasticsearch服务。

### 4.3.2 日志分析与告警策略

日志收集后,分析和告警策略是确保及时发现问题和采取措施的关键。ELK平台中Kibana可以设置仪表板进行实时日志分析,并且可以设置告警规则。

设置告警的示例配置如下:

```yaml

actions:

- action_id: "my_action_id"

action_type_id: "elasticsearch"

body: >

{

"error": {

"email": {

"to": ["ops-team@example.com"],

"subject": "System Error Detected",

"body": "An error was detected in the system at {{ctx.timerService.timeAsString}}: {{ctx.payload.hits.total}} error(s) found."

}

}

}

```

**逻辑分析:**

- 这个配置段定义了一个告警动作,告警ID为 `my_action_id`,告警类型为Elasticsearch。

- `body` 部分定义了告警内容,当检测到错误时,会向指定的邮箱发送包含错误详情的通知邮件。

通过这样的告警策略,运维团队可以对系统中出现的问题迅速做出反应,保障业务的稳定运行。

# 5. 未来趋势与挑战

在当今这个快速发展的IT行业中,自动化运维已经成为了提升效率、降低风险的关键因素。未来的技术趋势将如何影响自动化运维的发展?企业又将如何应对这些挑战?本章将深入探讨自动化运维的新兴技术、应对挑战与风险管理,以及持续学习与技能提升的必要性。

## 5.1 自动化运维的新兴技术

随着科技的不断进步,新兴技术层出不穷,自动化运维领域同样迎来了一系列的变革。

### 5.1.1 AI在运维自动化中的应用

人工智能(AI)技术已经开始被集成到自动化运维的多个环节中,它能够帮助实现更加智能的问题诊断、预测维护和自动化决策支持。

#### AI在运维中的应用实例:

- **故障预测与分析:** 使用机器学习算法对历史故障数据进行分析,识别潜在的风险和模式,预测设备或服务可能发生的故障。

- **自动化问题解决:** AI系统可以基于已有的知识库,自动解决一些常见问题,减少人力介入。

- **性能优化:** AI可以实时监控系统性能,并自动进行资源分配和负载均衡。

```python

# 示例:使用Python的scikit-learn库进行简单故障预测

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

from sklearn.metrics import accuracy_score

# 假设我们有一些故障数据和特征

X = [[0.4, 0.7, 0.8], [0.2, 0.4, 0.1], ...]

y = ['正常', '故障', ...]

# 分割数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

# 建立随机森林分类器模型

model = RandomForestClassifier()

model.fit(X_train, y_train)

# 进行预测并计算准确率

predictions = model.predict(X_test)

print(accuracy_score(y_test, predictions))

```

### 5.1.2 云计算与微服务架构的影响

云计算和微服务架构的兴起,为自动化运维带来了新的变革。资源的弹性扩展、服务的细粒度管理和容器化部署,都使得自动化运维更加灵活和高效。

#### 微服务架构的优势:

- **更高的灵活性:** 微服务可以独立部署、扩展和更新。

- **更佳的容错能力:** 单个微服务的故障不会影响整个应用。

- **更高效的资源利用:** 通过容器化技术,可以实现资源的高效利用和动态管理。

## 5.2 应对挑战与风险管理

自动化运维为IT管理带来了便利,但同时也带来了新的风险和挑战。安全性和风险管理成为了自动化运维中的关键要素。

### 5.2.1 安全性在自动化中的重要性

随着自动化程度的提高,系统的安全边界也在不断变化,安全控制必须与自动化流程紧密集成,确保安全防护措施能够及时更新和响应。

#### 安全性提升措施:

- **持续的安全监控:** 集成安全监控工具,实现对网络和系统的实时监控。

- **权限最小化原则:** 对自动化任务执行者实行严格的权限控制,确保仅授予必要的权限。

- **自动化安全合规检查:** 使用自动化工具定期进行安全合规性检查,确保符合相关法规要求。

### 5.2.2 风险评估与应对策略

为了应对自动化运维中的潜在风险,建立一套完善的风险评估和应对机制至关重要。

#### 风险评估流程:

- **识别潜在风险:** 通过调研和分析,识别自动化运维过程中可能遇到的风险点。

- **评估风险影响:** 对识别的风险进行影响评估,了解风险发生的可能性和潜在的损失。

- **制定应对措施:** 根据风险评估的结果,制定相应的应对措施和预案。

## 5.3 持续学习与技能提升

自动化运维领域不断涌现新技术和新工具,IT从业者必须持续学习,提升自己的技能以跟上时代的步伐。

### 5.3.1 自动化相关技能要求

在自动化运维领域,从业者需要具备以下技能:

- **编程能力:** 掌握一种或多种编程语言,如Python、Ruby等。

- **了解自动化工具:** 熟悉Jenkins、Ansible等自动化工具的使用和原理。

- **云服务知识:** 理解云计算服务的工作原理,如AWS、Azure等。

### 5.3.2 建立持续学习与改进的文化

建立一个持续学习和改进的企业文化,对于保持竞争力至关重要。

#### 推广学习文化的方法:

- **定期培训与分享:** 组织定期的培训和技术分享会议。

- **鼓励个人发展:** 提供学习资源和时间,鼓励员工进行个人技能提升。

- **绩效与学习挂钩:** 将学习成果和职业发展、绩效考核相结合。

通过上述内容的探讨,我们可以看到未来自动化运维技术的迅猛发展及企业如何适应这些变化。不断地学习新技能并应对新挑战,将是每个IT从业者和企业持续成功的关键所在。

0

0