数据可视化工具深度对比:Tableau vs. Power BI vs. Qlik Sense

发布时间: 2024-09-07 23:36:20 阅读量: 106 订阅数: 46

数据可视化有哪些实用工具或者网站?

# 1. 数据可视化工具概述

数据可视化是将数据转化为图形或图表形式,以便更直观地理解信息和洞察数据趋势。随着大数据时代的到来,数据可视化工具成为了分析师和决策者不可或缺的助手。这些工具不仅帮助人们从海量数据中提取有价值的信息,而且通过图形化的方式使复杂的数据变得易于理解。

本章将概述当前市场上的主流数据可视化工具,并介绍它们的基本功能和用途。我们会了解到,像Tableau、Power BI和Qlik Sense等工具,各自拥有独特的特点和应用场景,为不同行业的数据处理和决策提供了强有力的支持。

在接下来的章节中,我们将深入探讨这些工具的核心功能,以及它们在实际工作中的应用案例和效益,以帮助读者更有效地选择和利用这些工具进行数据分析和可视化。

# 2. Tableau的核心功能与实践应用

### 2.1 Tableau的数据分析能力

Tableau是数据可视化领域的佼佼者,它将复杂的数据分析过程简化为直观的操作和拖放界面,使得非技术用户也能洞察数据的深度价值。

#### 2.1.1 数据连接与整合

Tableau可以连接到多种数据源,无论是简单的Excel文件还是复杂的数据库系统。它通过数据提取、连接和整合的处理能力,让用户能够将分散在不同位置的数据汇总、清洗并分析。数据整合过程可以自动进行,也可以由用户自定义。

```mermaid

graph LR

A[开始] --> B{选择数据源}

B --> |Excel| C[Excel文件]

B --> |数据库| D[数据库系统]

B --> |云服务| E[云数据服务]

C --> F[提取数据]

D --> F

E --> F

F --> G[数据整合]

G --> H[清洗数据]

H --> I[数据准备就绪]

```

#### 2.1.2 高级分析功能解析

Tableau提供了强大的数据分析功能,包括预测分析、趋势线分析、参数功能以及集成功能。预测分析允许用户对数据集进行趋势预测,生成预测图,而趋势线分析则可用于检测数据集中的相关性。参数功能使用户能够创建自定义字段,以模拟不同的业务情况,而集成功能可以将多个视图组合成一个完整的分析框架。

```markdown

- **预测分析**: 预测未来趋势,辅助决策。

- **趋势线分析**: 检测变量之间的相关性。

- **参数功能**: 动态调整数据视图。

- **集成功能**: 组合多个视图为单一分析。

```

### 2.2 Tableau的可视化特性

Tableau不仅仅是一个数据分析工具,它的数据可视化特性也十分突出,尤其在图表和仪表板设计方面。

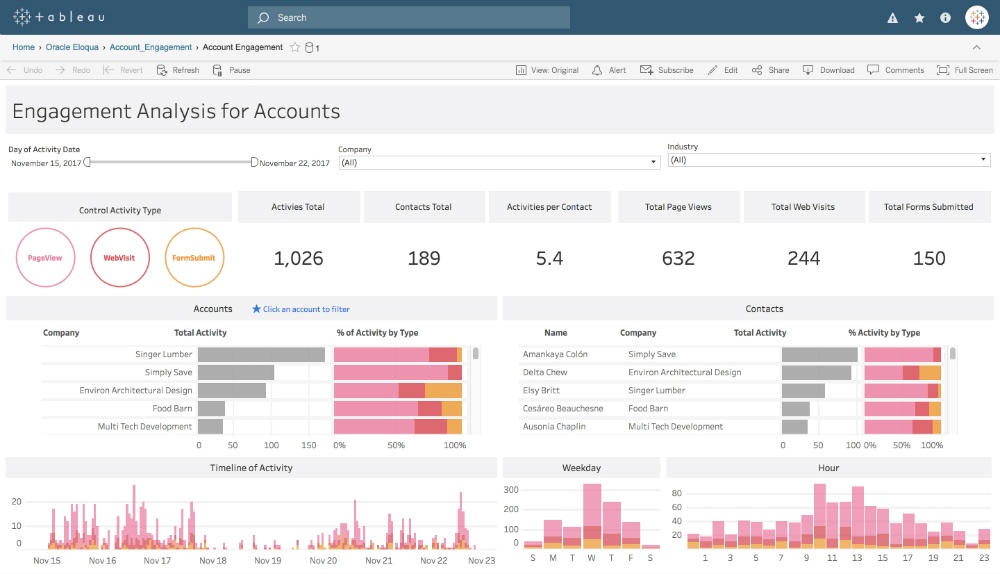

#### 2.2.1 图表和仪表板设计

Tableau提供了丰富的图表类型,用户可以根据需要选择合适的图表来展示数据。更重要的是,Tableau的图表可以动态变化,用户可以通过交互式筛选器来动态地改变图表所展示的数据,实现真正的探索性分析。

#### 2.2.2 交互式故事叙述

故事叙述是Tableau的一项创新功能,它允许用户创建一系列有序的视图,这些视图可以以故事的方式串联起来,引导观众一步步地了解数据背后的故事和洞察。故事叙述可以包括文字说明、数据视图和自定义的页面布局。

### 2.3 Tableau在行业中的应用案例

#### 2.3.1 商业智能(BI)解决方案

Tableau在商业智能领域的应用非常广泛。它能够帮助企业管理层快速理解业务情况,为销售、市场、财务等领域提供实时的数据分析和报告。例如,零售商可以使用Tableau来监控销售数据,分析销售趋势,以及时调整市场策略。

#### 2.3.2 企业级部署和管理

对于大型企业来说,Tableau提供企业级部署方案,支持多种认证方式,确保数据的安全。管理员可以轻松管理用户权限,控制数据访问,并且可以集中部署和管理软件,以适应复杂的IT环境。Tableau Server和Tableau Online是企业级部署的两个主要选项。

在本章节中,我们介绍了Tableau的核心功能,包括数据分析和可视化特性,并通过实际案例展示了它在商业智能和企业级应用中的价值。Tableau不仅仅是一个工具,它是企业数据驱动决策和战略规划的重要伙伴。随着数据量的日益增长和企业对数据可视化的需求不断增加,Tableau在未来数据可视化领域的地位将更加稳固。

# 3. Power BI的核心功能与实践应用

## 3.1 Power BI的数据处理

### 3.1.1 数据导入和转换

在当今以数据驱动决策的商业环境中,有效地将数据导入并转换成可分析的格式是构建任何报告的第一步。Power BI作为一个强大的商业智能工具,提供了多种数据导入选项,如从本地文件、数据库以及在线服务导入数据。

在导入数据时,Power BI会自动检测数据类型和数据关系。然而,为了进行深入分析,用户往往需要对数据进行转换和清洗。Power BI中的“查询编辑器”提供了丰富的数据转换功能,包括合并查询、追加查询、分组和聚合、添加自定义列以及处理错误等。

#### 示例代码块

```powershell

# 将数据从CSV文件导入Power BI,并进行基本转换

let

// 从CSV文件导入数据

Source = Csv.Document(File.Contents("C:\path\to\your\file.csv"),[Delimiter=",", Columns=12, Encoding=1252, QuoteStyle=QuoteStyle.None]),

// 定义每列数据类型

Data = Table.TransformColumnTypes(Source,{{"Column1", Int64.Type}, {"Column2", Text.Type}, ...}),

// 更多转换步骤

ChangedType = Table.TransformColumnTypes(Data,{{"Column1", type text}}),

// 添加自定义列来计算新字段

AddedCustom = Table.AddColumn(ChangedType, "NewField", each [Column1] + [Column2])

in

AddedCustom

```

#### 参数说明

- `Csv.Document`: 用于从CSV文件加载数据的函数。

- `File.Contents`: 用于获取文件内容的函数。

- `Table.TransformColumnTypes`: 用于转换列数据类型的函数。

- `Table.AddColumn`: 用于添加自定义列的函数。

通过上述代码块,我们可以加载并转换CSV文件中的数据。每个步骤都是数据处理流程中的关键,确保了数据的准确性和可用性,为后续分析打下坚实基础。

### 3.1.2 数据建模和分析

一旦数据被导入和清洗,下一步就是数据建模。在Power BI中,数据建模是指创建数据关系、计算列、度量值、快速表等过程。这些都对分析和报告的构建至关重要。

在数据建模中,Power BI使用DAX(数据分析表达式)来定义计算列和度量值。DAX是一种功能强大的公式语言,允许我们创建自定义的计算字段和计算表。

#### 示例代码块

```powersh

```

0

0